- nginx的历史

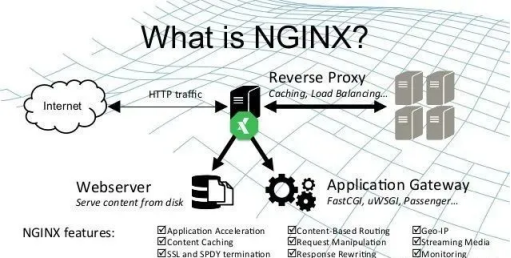

- nginx的功能特性

- 常见功能介绍

- 特点:高效、可靠、开源

- 作用

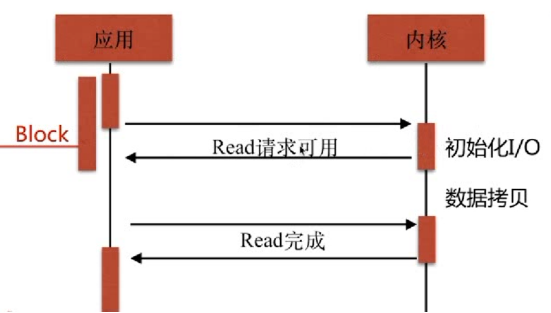

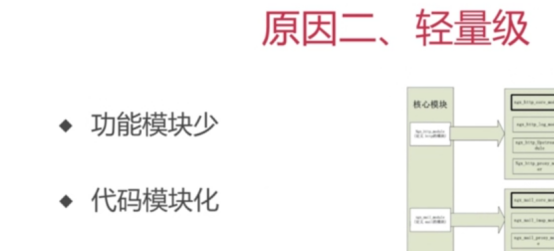

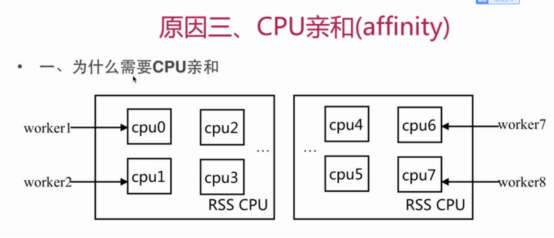

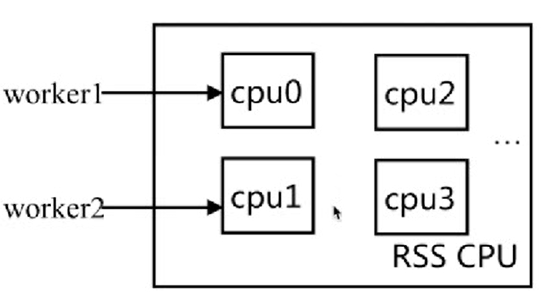

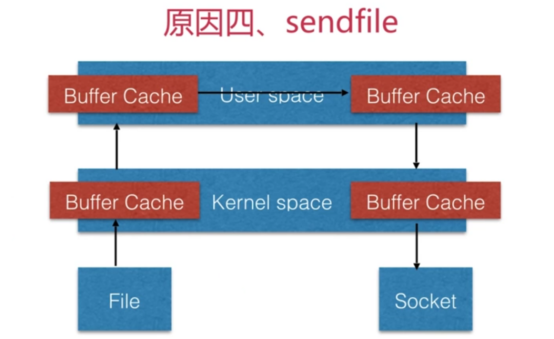

- 技术(4个主要技术)

- 学习环境

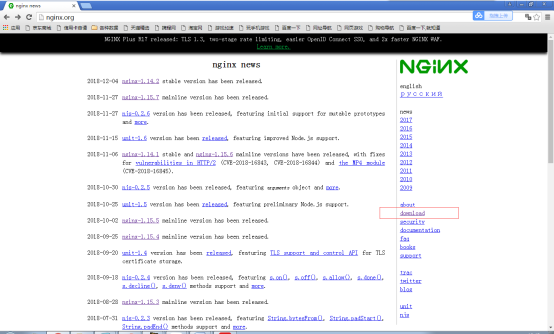

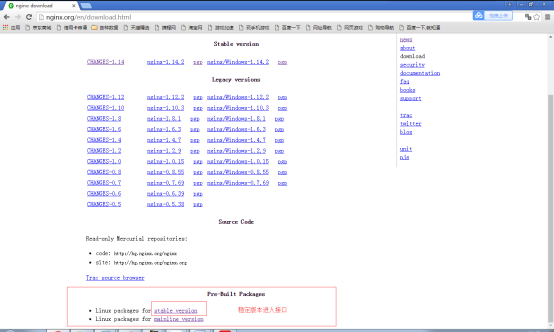

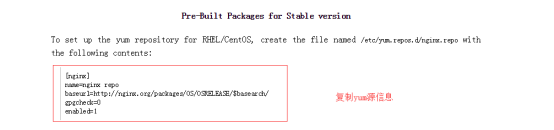

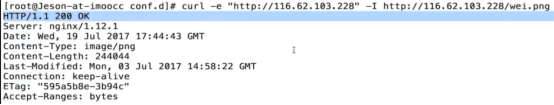

- 安装Nginx(yum安装)

- 安装nginx(rpm安装)

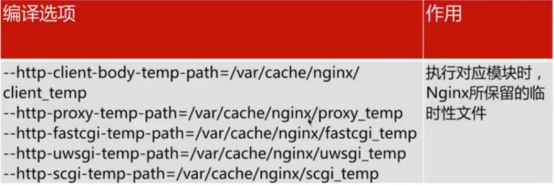

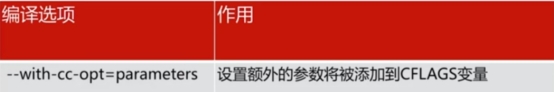

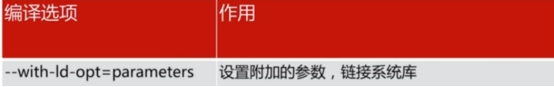

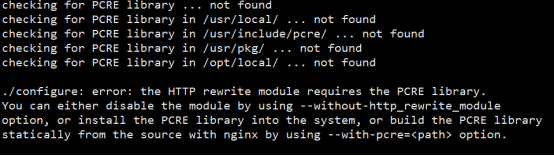

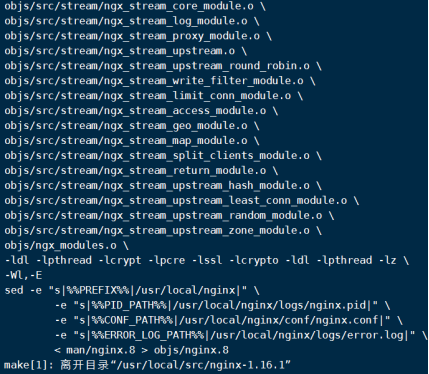

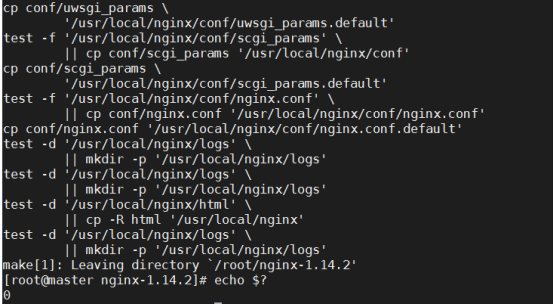

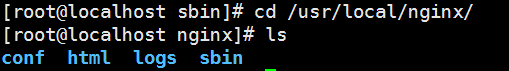

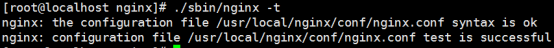

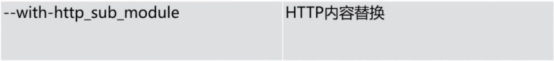

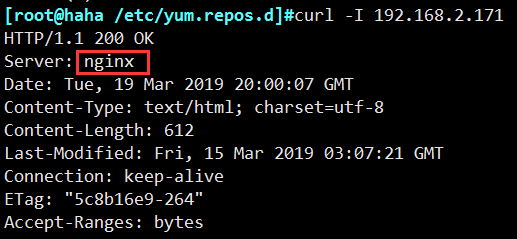

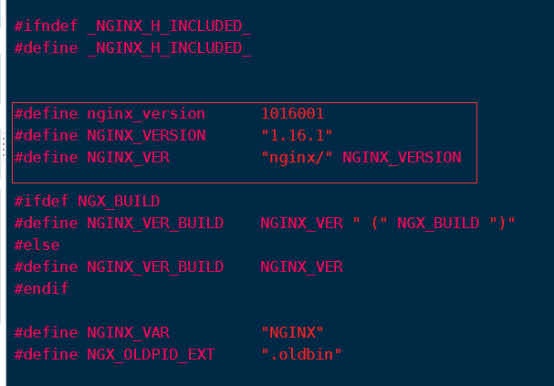

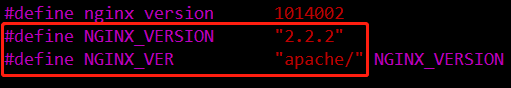

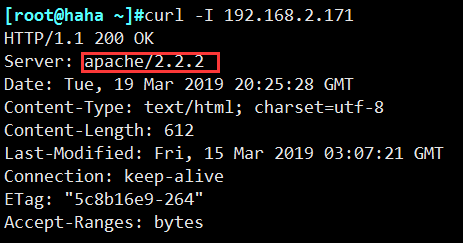

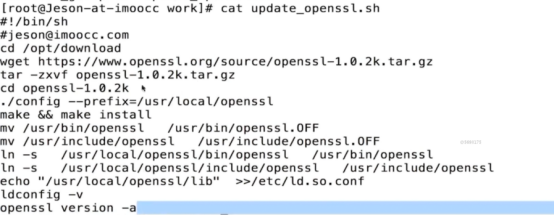

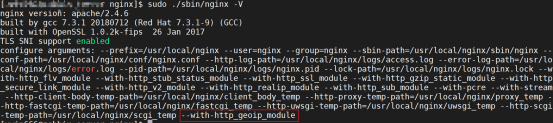

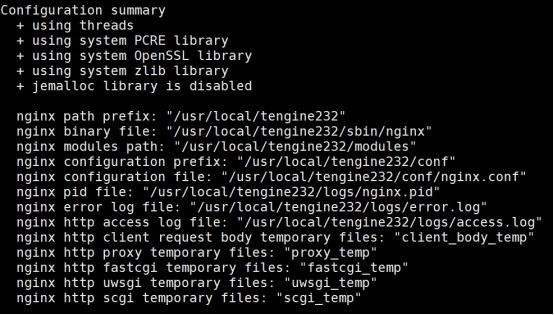

- 安装Nginx(源码包安装1.14)

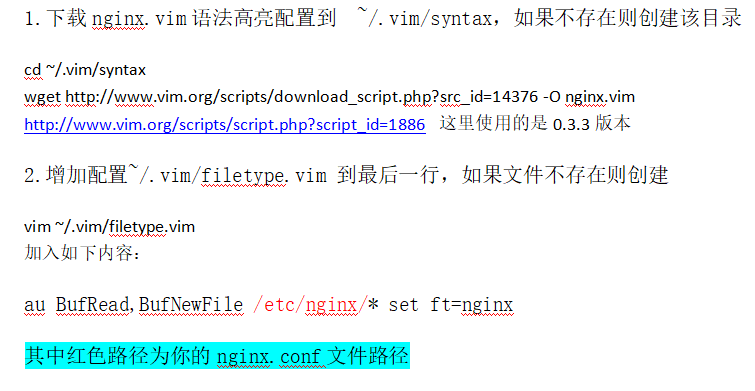

- 对nginx的配置文件语法高亮设置

- Nginx基本配置指令(重点)

- conf目录中内容

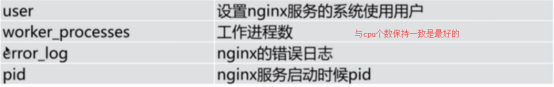

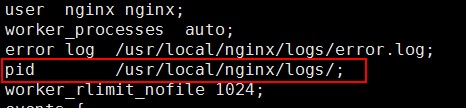

- A、全局块配置

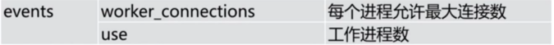

- B、events块配置 ->I/O事件配置

- C、http块配置

- D、server块

- E、location指令

- 配置运行nginx服务器用户、用户组

- 配置允许生成的worker process数

- 配置nginx主进程pid存放路径

- 配置错误日志的存放路径

- 配置文件的引入

- 设置网络连接的序列化

- 设置是否允许同时接收多个网络连接

- 事件驱动模型选择

- 配置最大连接数

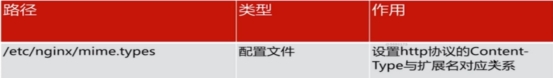

- 定义MIME-type

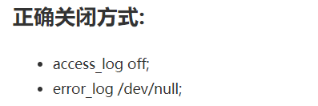

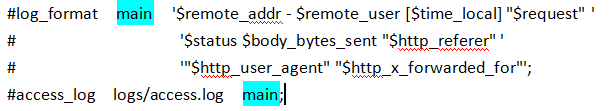

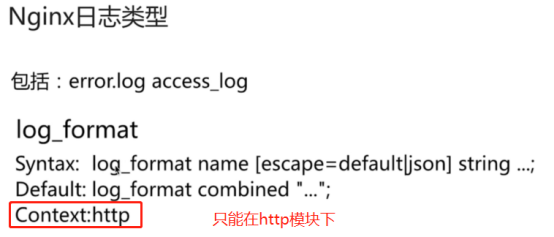

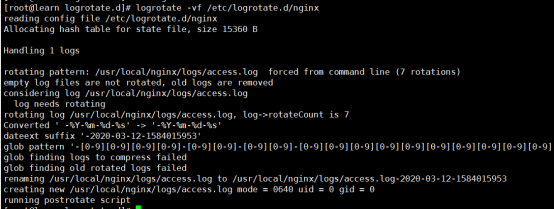

- 自定义服务日志

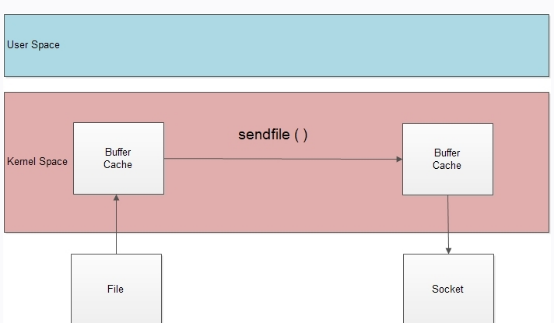

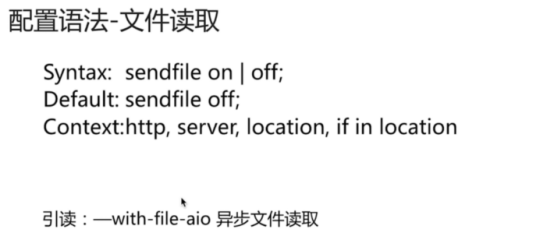

- 配置允许sendfile方式传输文件

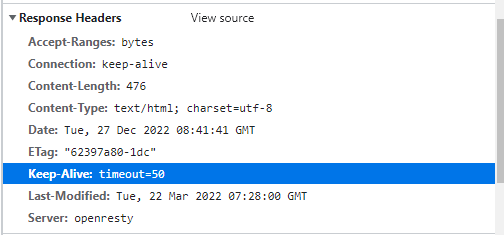

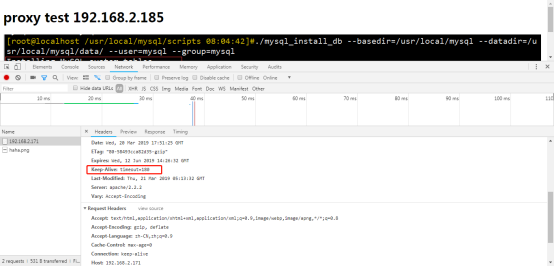

- 配置连接超时时间

- 单连接请求上限

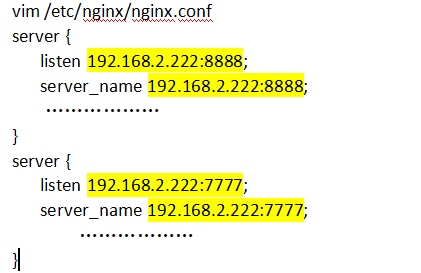

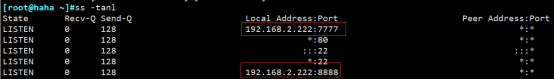

- 配置网络监听

- 配置主机名称

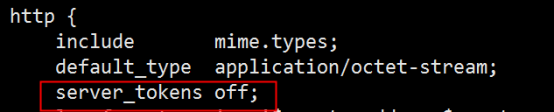

- http完整配置-1及详解

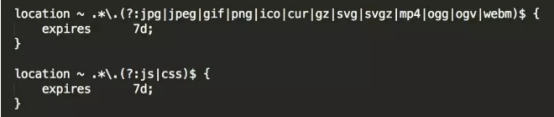

- http完整配置-2及详解

- nginx.conf

- nginx一键生成配置文件

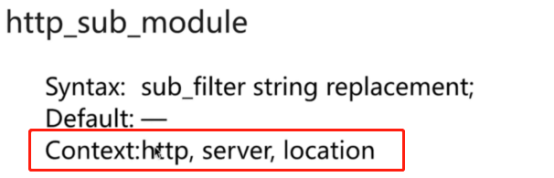

- Nginx模块(面试必问)

- Nginx内置绑定变量

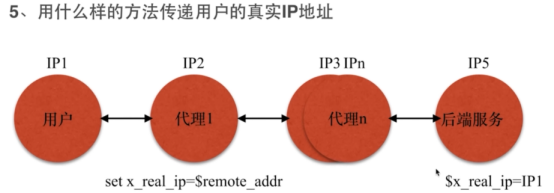

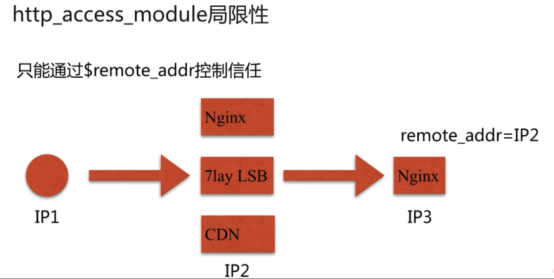

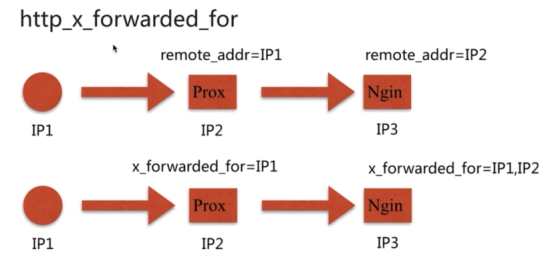

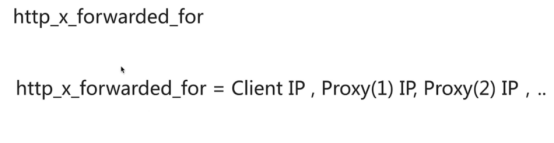

- 如何获取用户真实IP地址信息

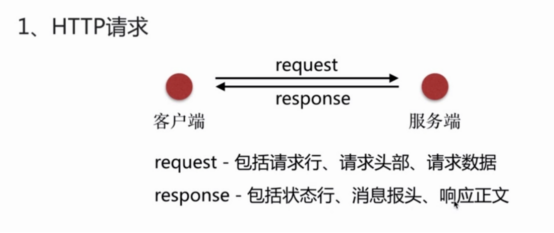

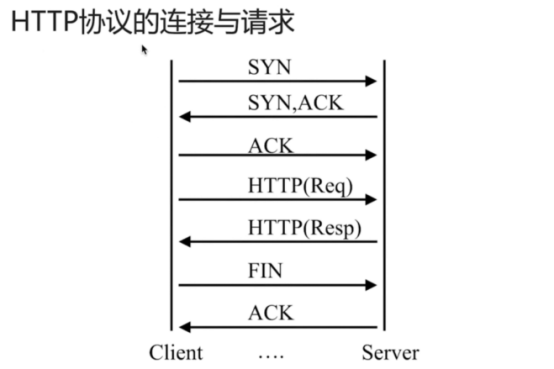

- HTTP请求

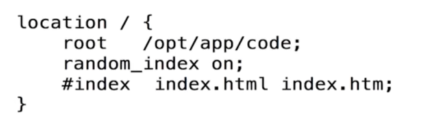

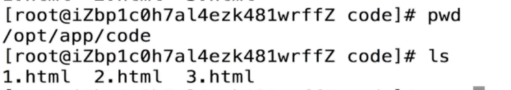

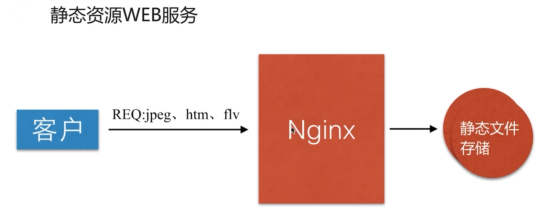

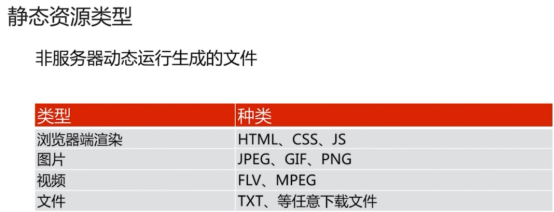

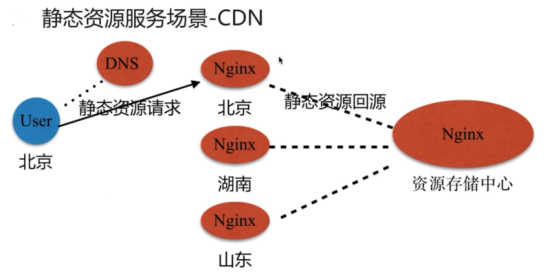

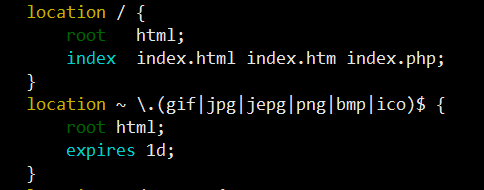

- 静态资源web服务

- nginx服务器的web请求机制

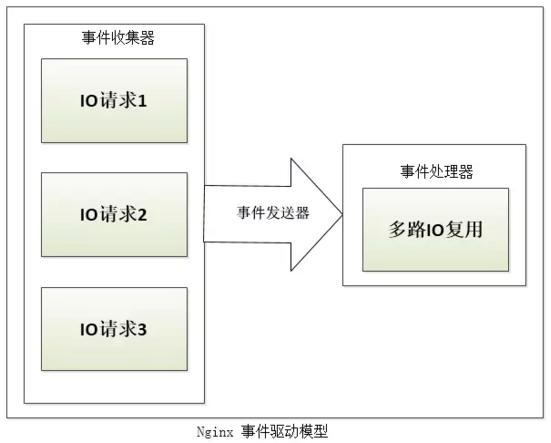

- nginx服务器的事件处理机制

- nginx服务器架构

- nginx服务器的进程

- nginx服务器的高级配置

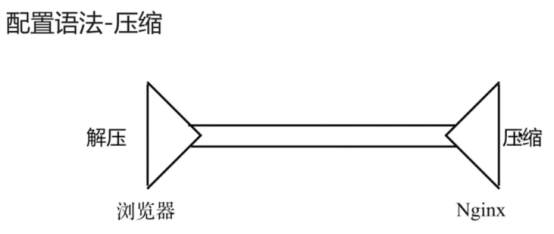

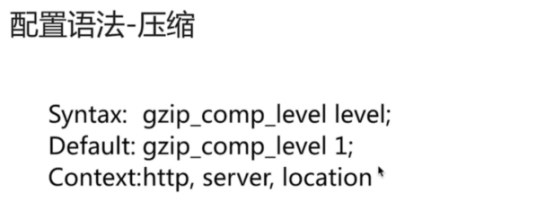

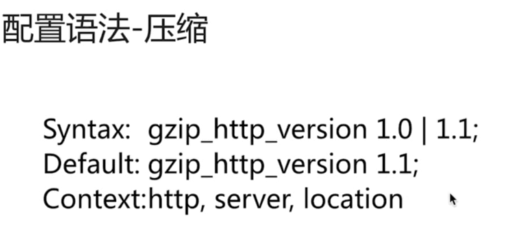

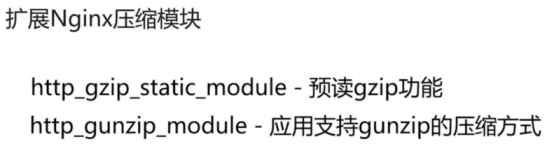

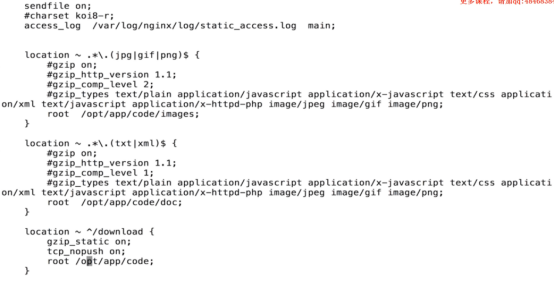

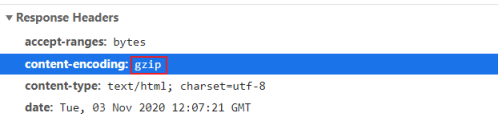

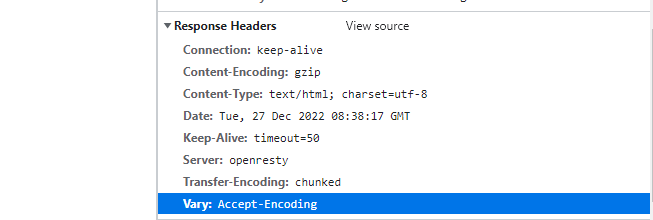

- nginx服务器的Gzip压缩

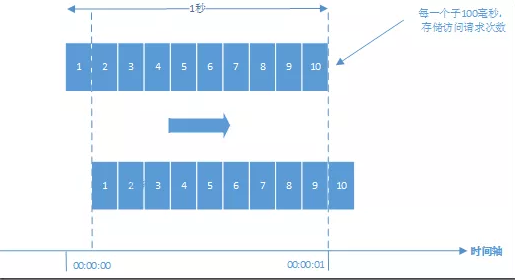

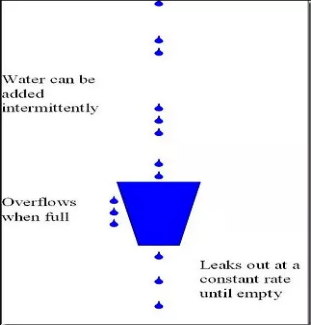

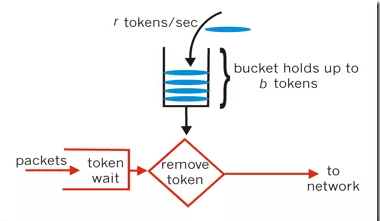

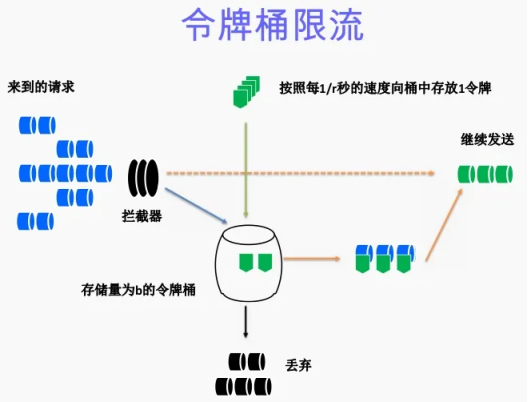

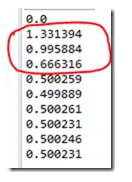

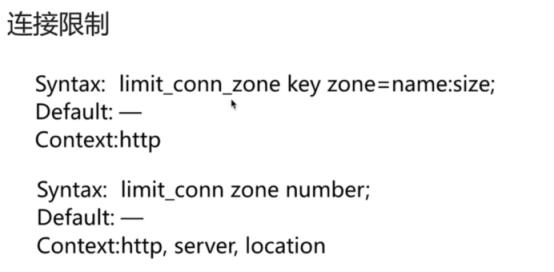

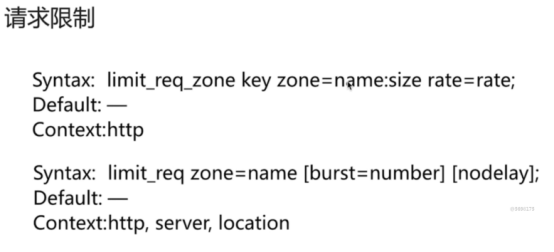

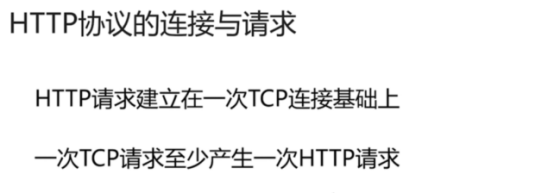

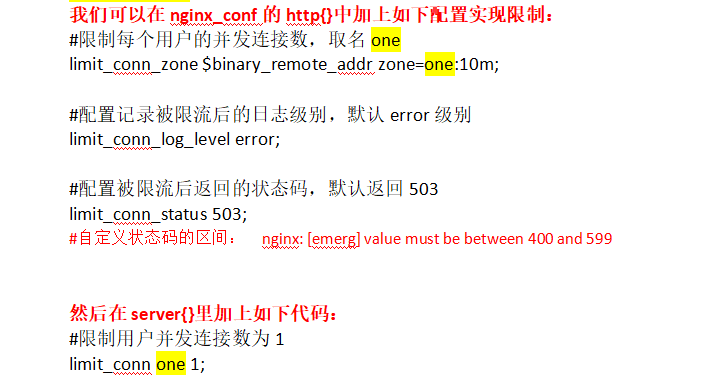

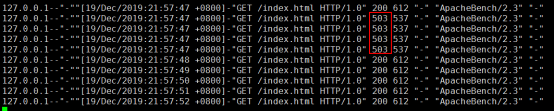

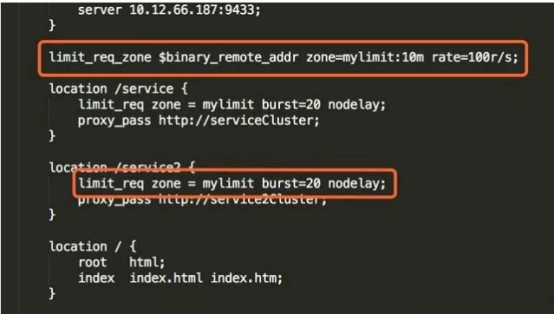

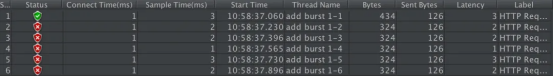

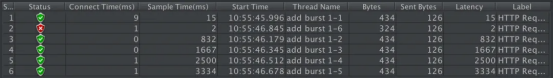

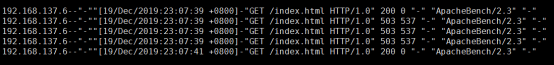

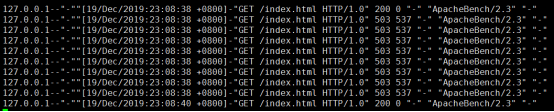

- Nginx的请求限制(高并发系统是如何做限流的?)

- If指令

- break指令

- set指令

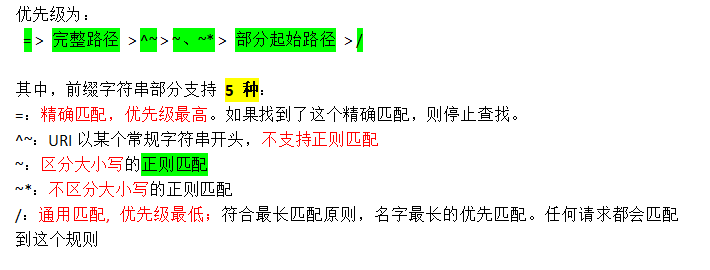

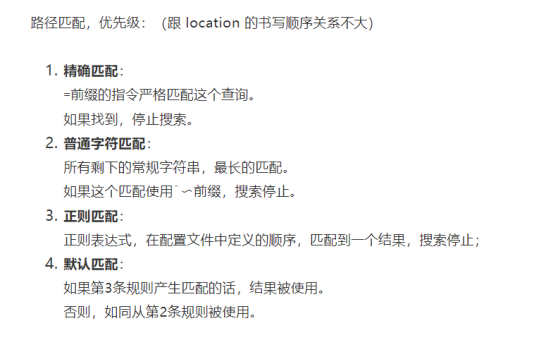

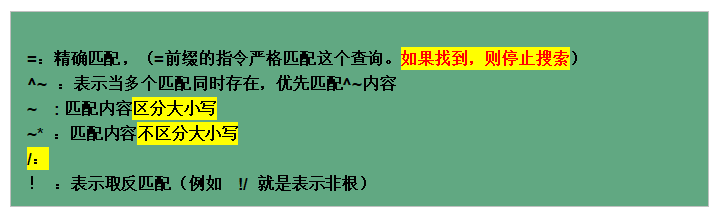

- nginx的location作用

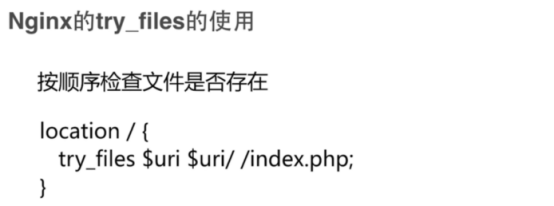

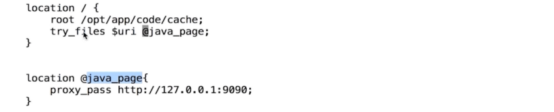

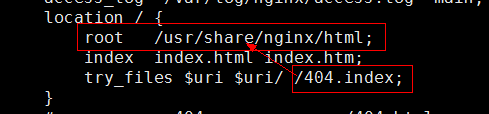

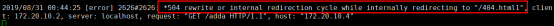

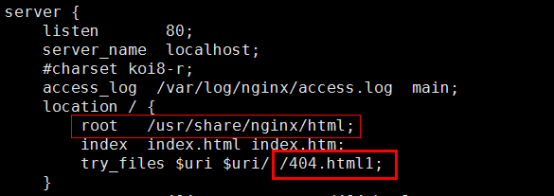

- try_files指令说明->按照顺序检查文件是否存在

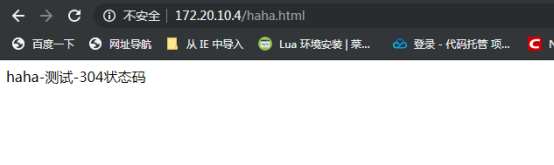

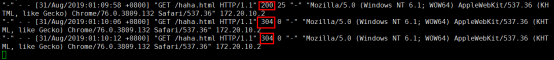

- return的配置说明->跳转

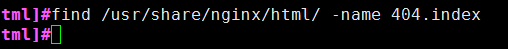

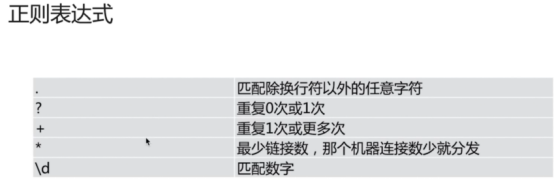

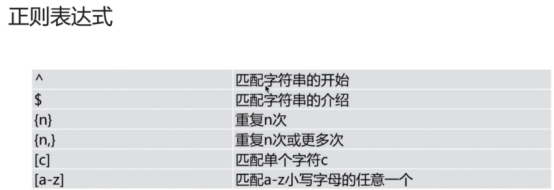

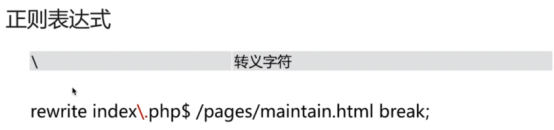

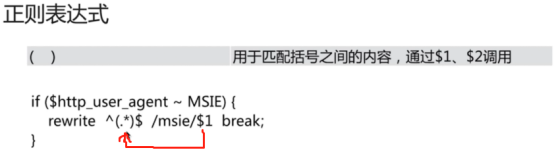

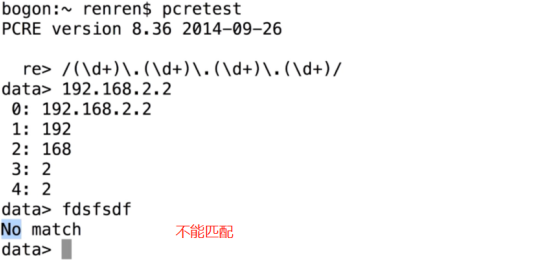

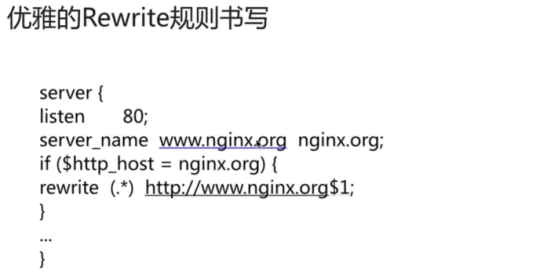

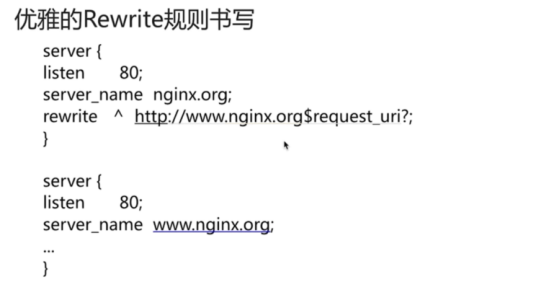

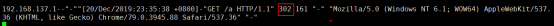

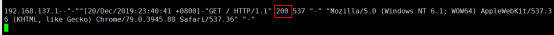

- rewrite规则->跳转

- 跳转3种方式

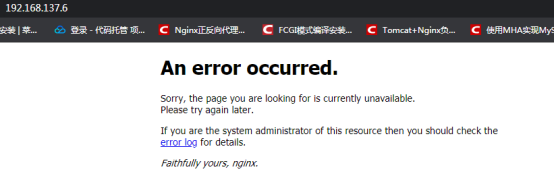

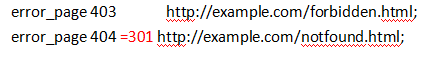

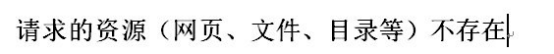

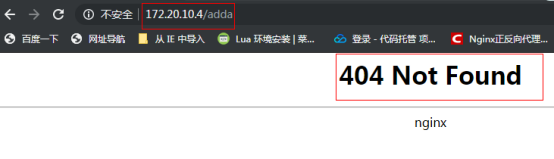

- error-page

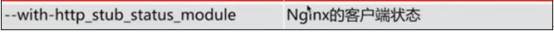

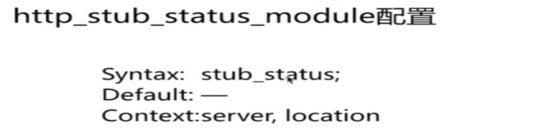

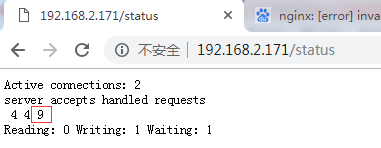

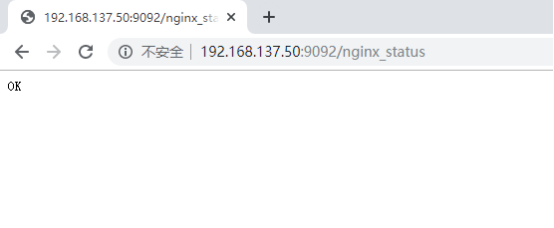

- Nginx访问状态监控

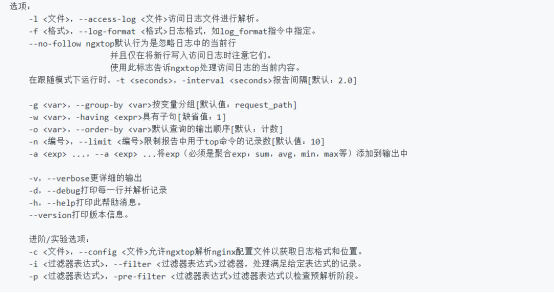

- 一个小工具帮你搞定实时监控Nginx服务器

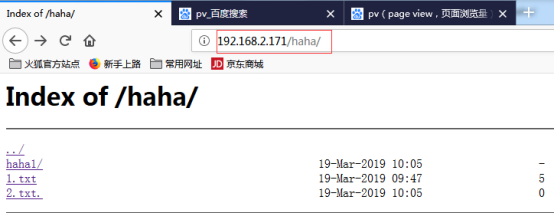

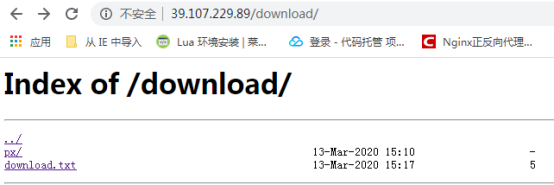

- Nginx共享文件web页面(download)

- nginx+fancyindex漂亮目录浏览带搜索功能

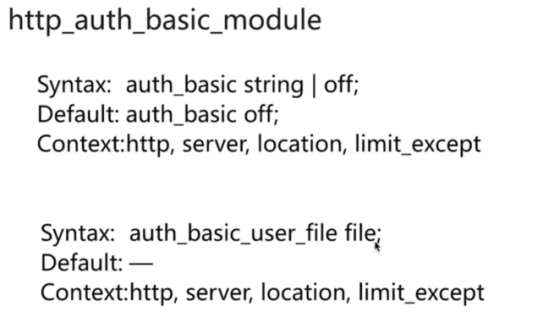

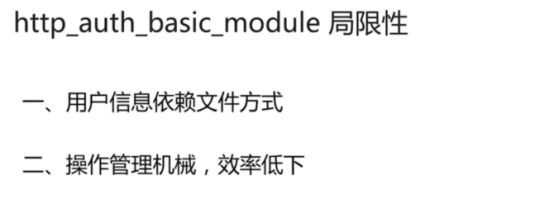

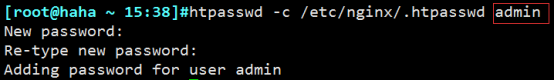

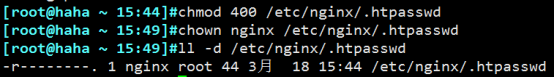

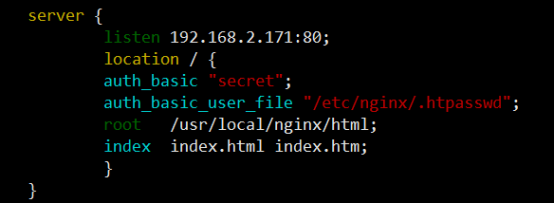

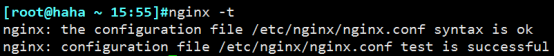

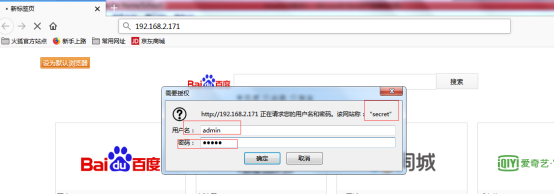

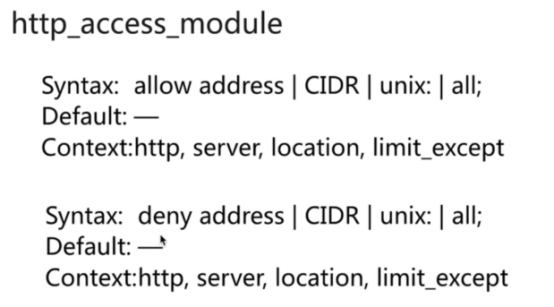

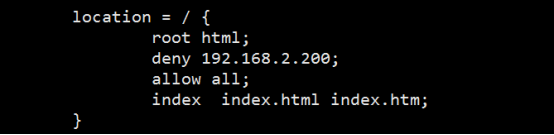

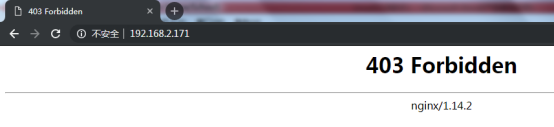

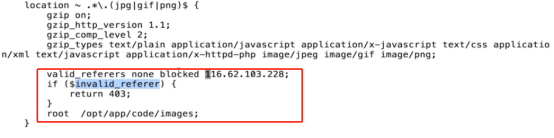

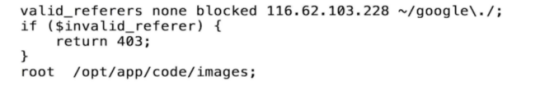

- 访问控制

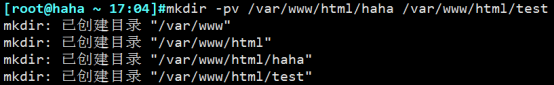

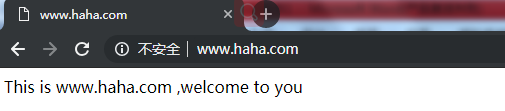

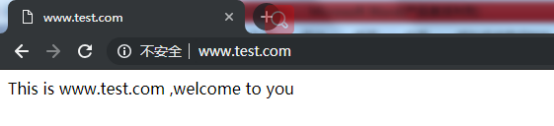

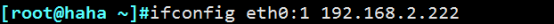

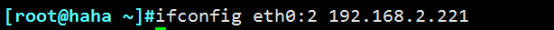

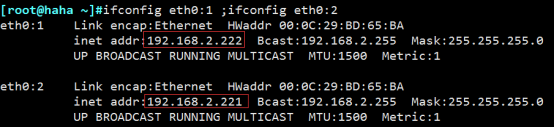

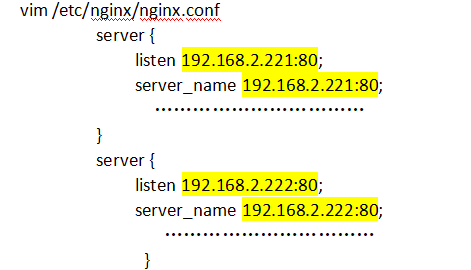

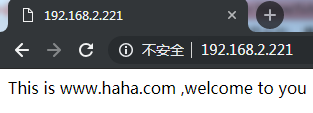

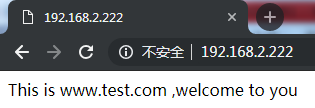

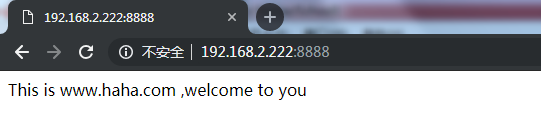

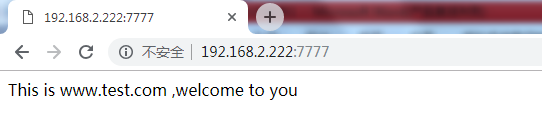

- nginx虚拟主机

- Nginx的alias和root的区别->虚拟目录

- Nginx优化(重点)

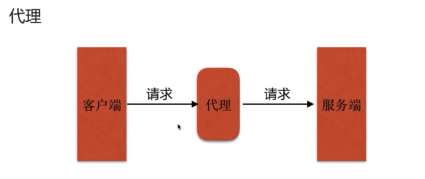

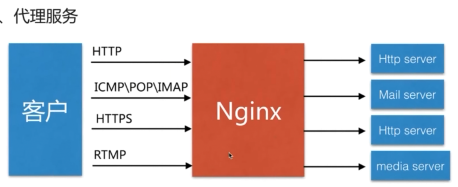

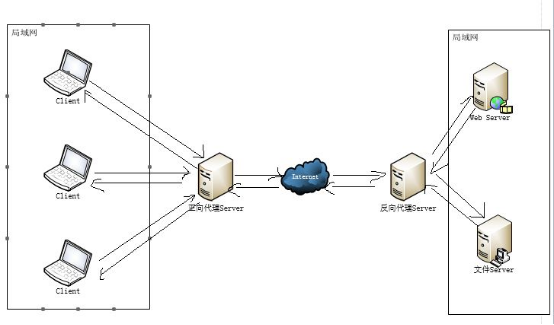

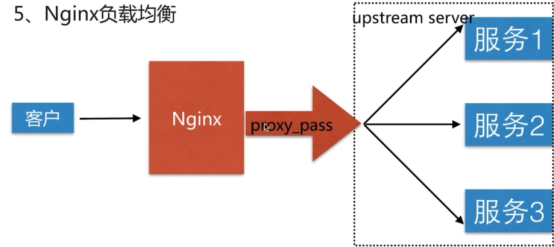

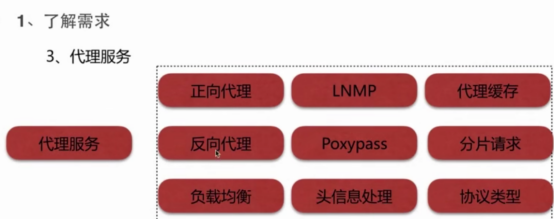

- 代理服务(重点)

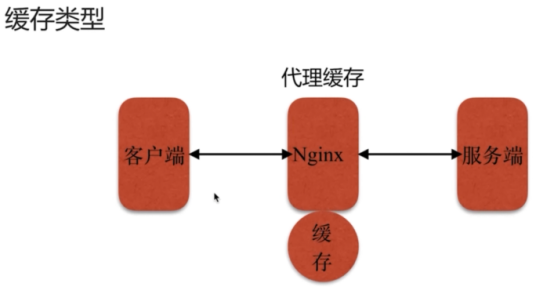

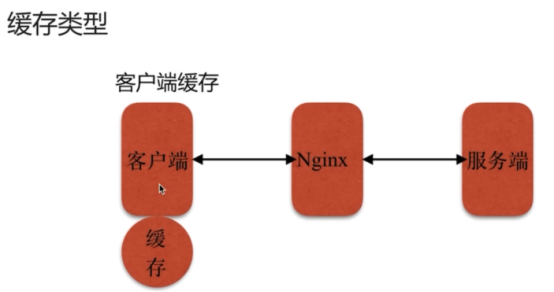

- 代理类型

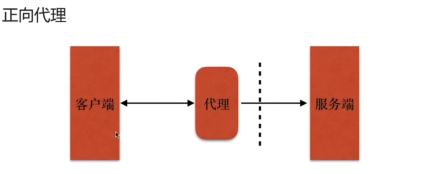

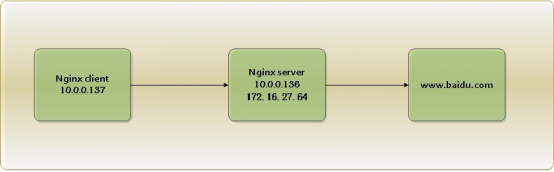

- 正向代理

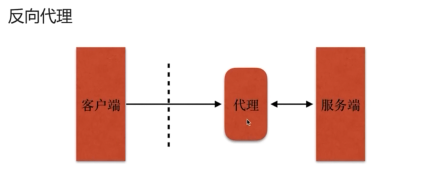

- 反向代理

- 概述

- 反向代理的基本设置的21个相关指令

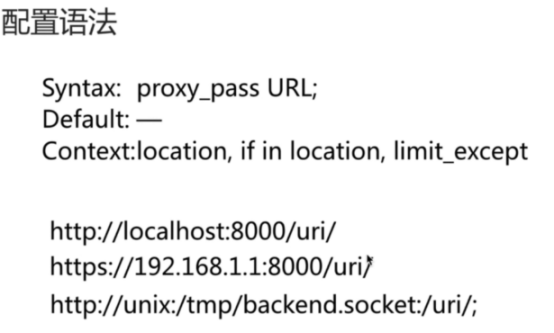

- proxy_pass指令

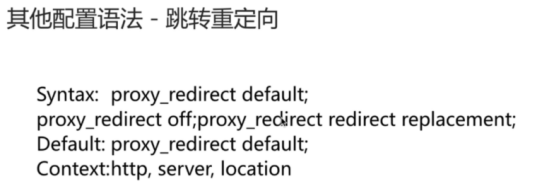

- proxy_redirect指令

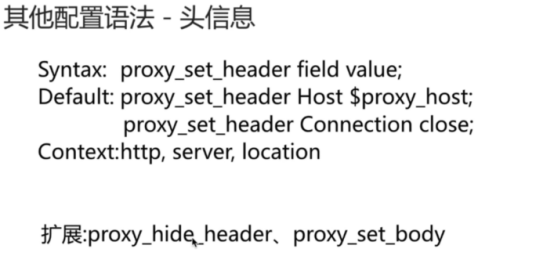

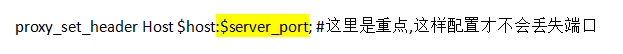

- proxy_set_header指令

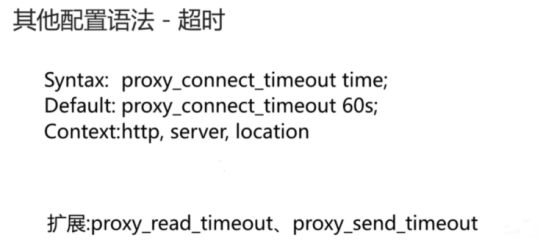

- proxy_send_timeout指令

- proxy_read_timeout指令

- proxy_connect_timeout指令

- proxy_intercept_errors指令

- proxy_headers_hash_max_size指令

- proxy_headers_hash_bucket_size

- proxy_next_upstream指令

- proxy_ssl_session_reuse

- proxy_pass_header指令

- proxy_hide_header指令

- proxy_pass_request_body指令

- proxy_set_body指令

- proxy_bind指令

- proxy_http_version指令

- proxy_method指令

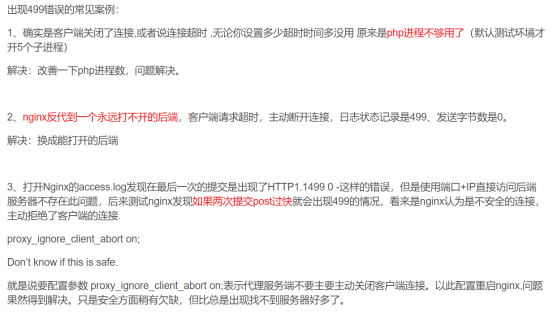

- proxy_ignore_client_abort指令

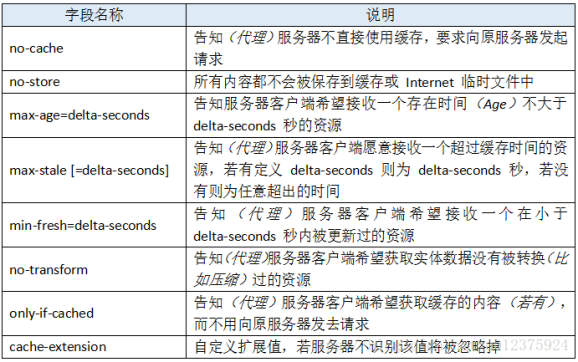

- proxy_ignore_headers指令

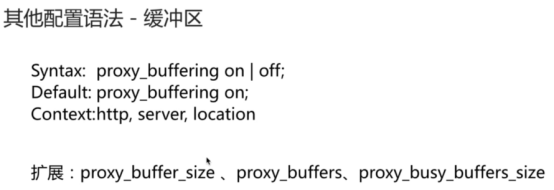

- proxy buffer的配置的7个指令

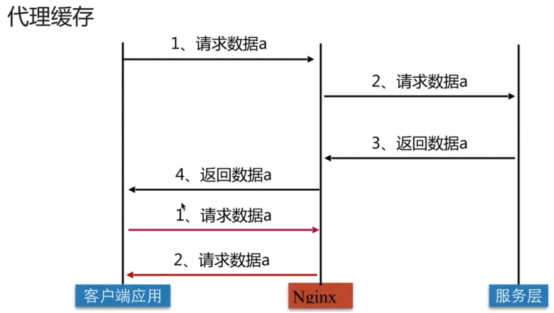

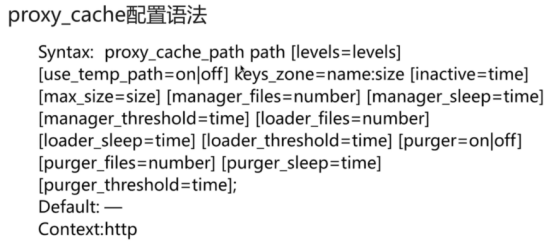

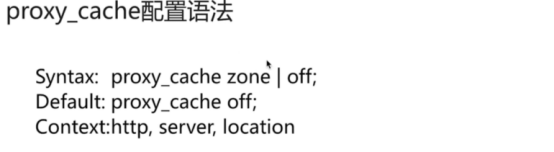

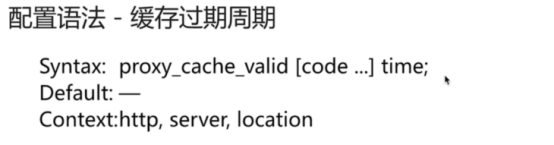

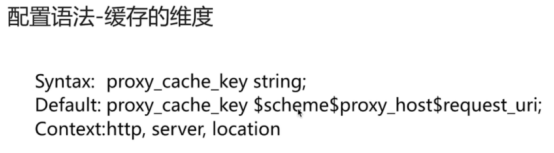

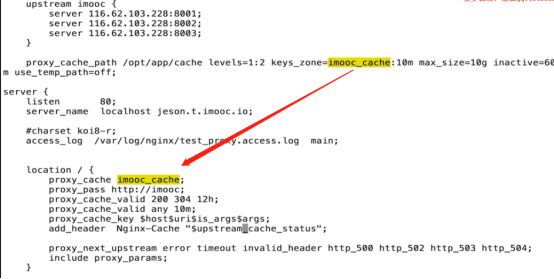

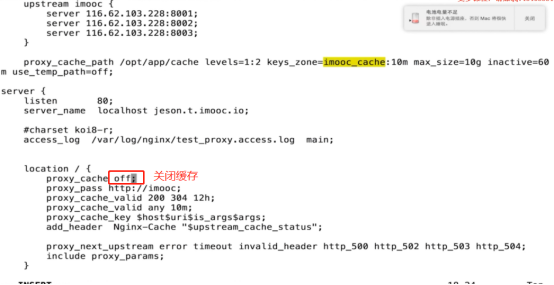

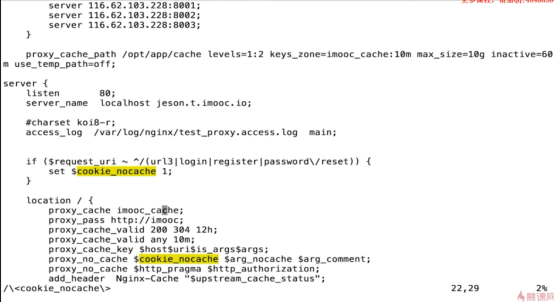

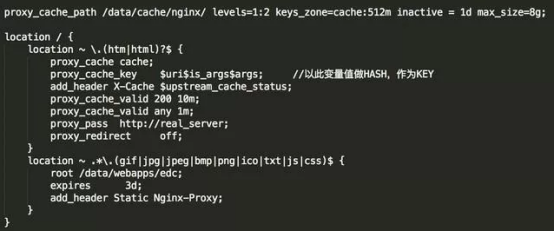

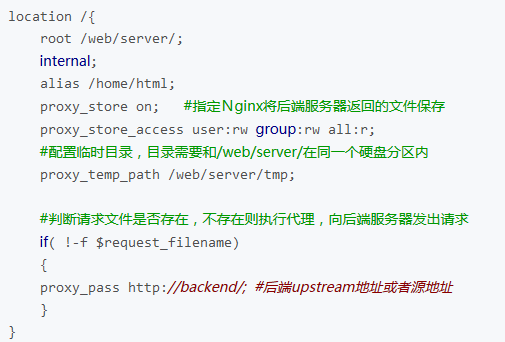

- proxy Cache的配置的12个指令

- nginx 反向代理时丢失端口的解决方案

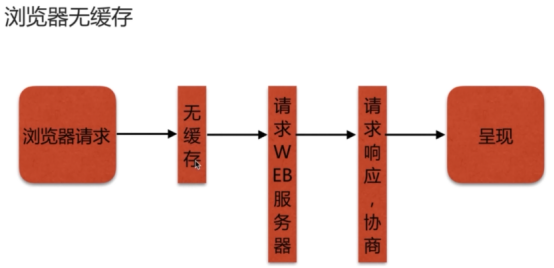

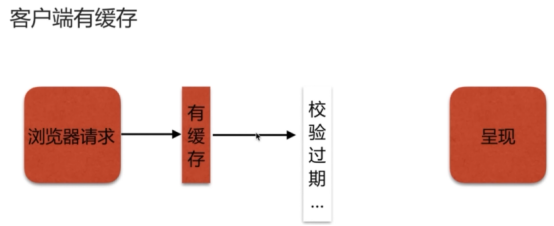

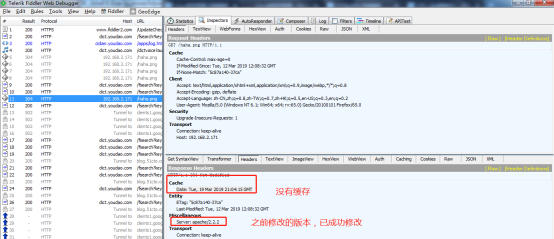

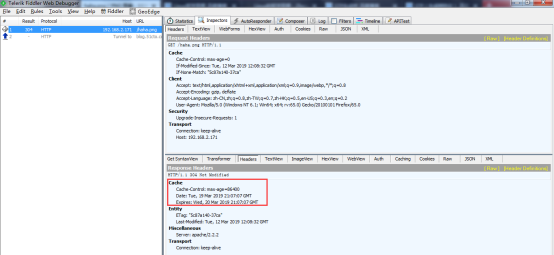

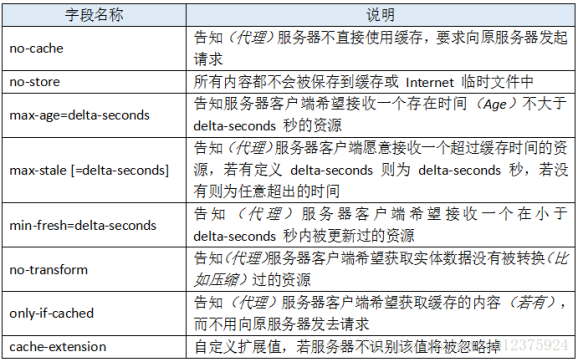

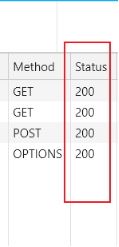

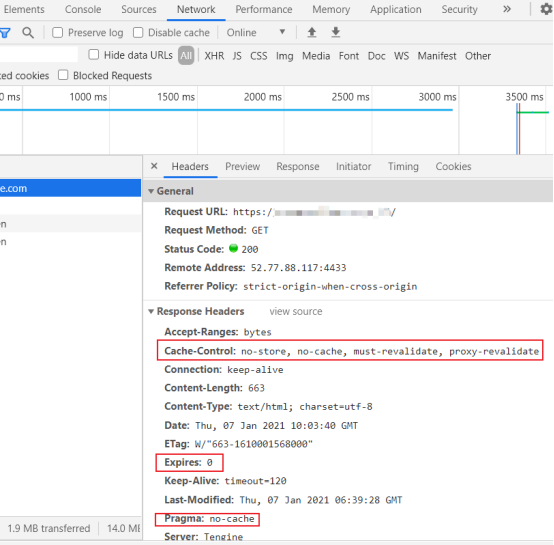

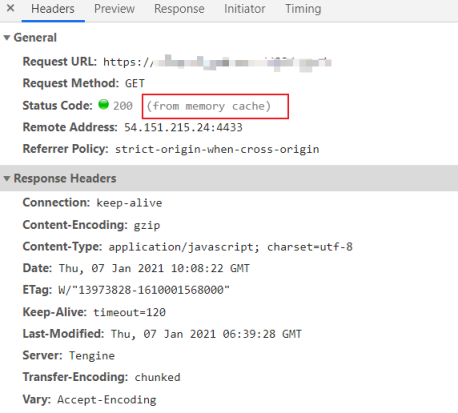

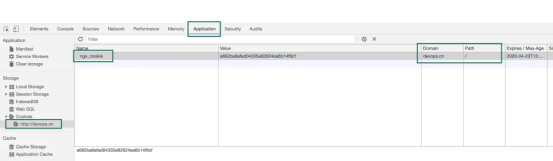

- nginx 浏览器的缓存问题(不缓存add_header Cache-Control )

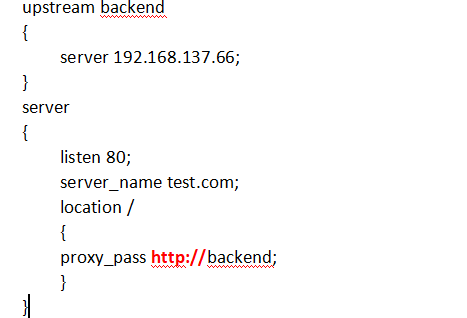

- 实例

- 实例

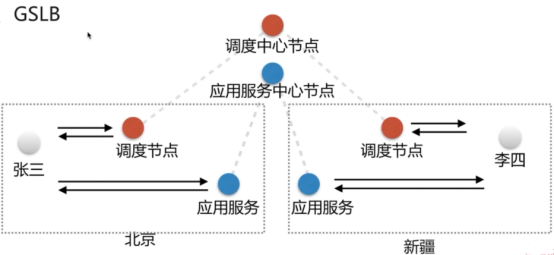

- 实例:反向代理负载均衡的应用架构

- 正、反向代理的区别

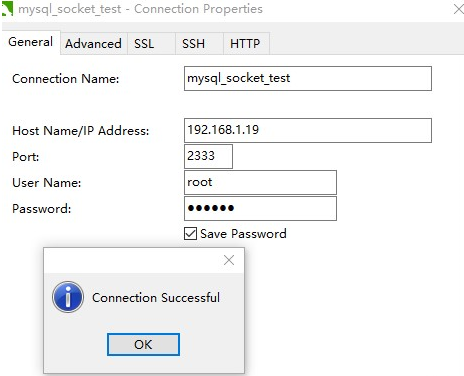

- nginx stream模块-->基于4层(tcp)代理

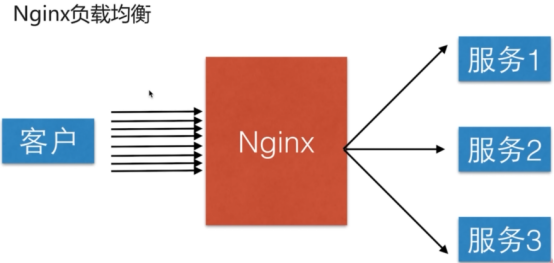

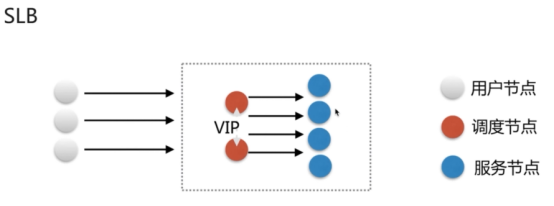

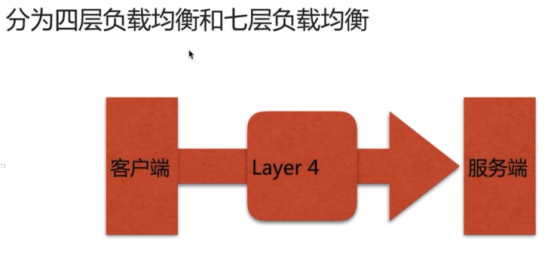

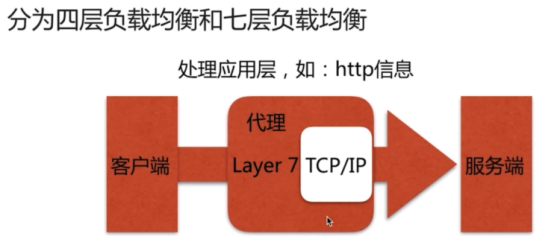

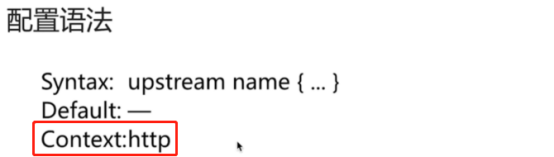

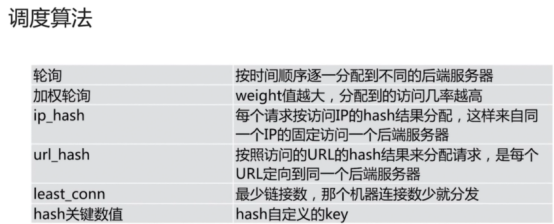

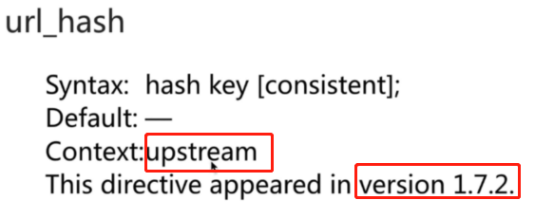

- 负载均衡(重点)基于OSI的7层负载

- Nginx 基于nginx-sticky-module模块进行会话保持

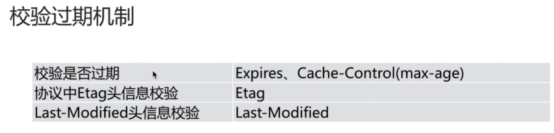

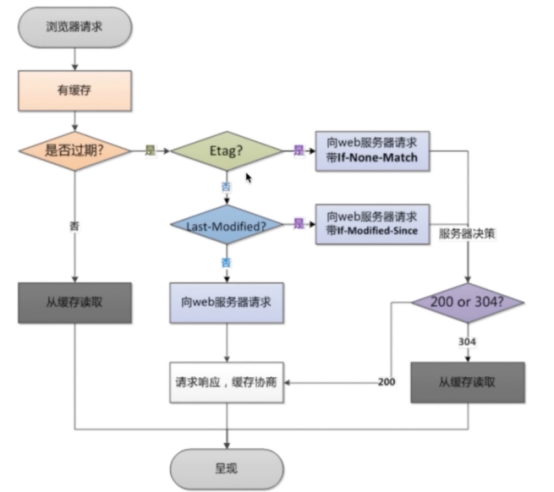

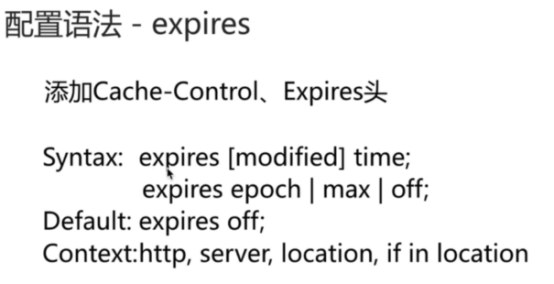

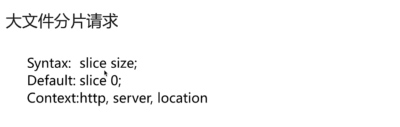

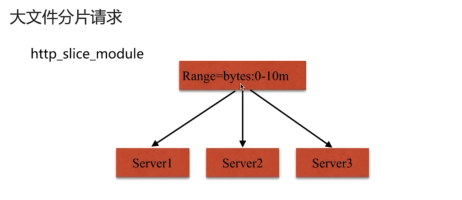

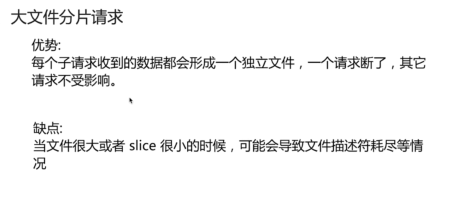

- 缓存服务(重点)

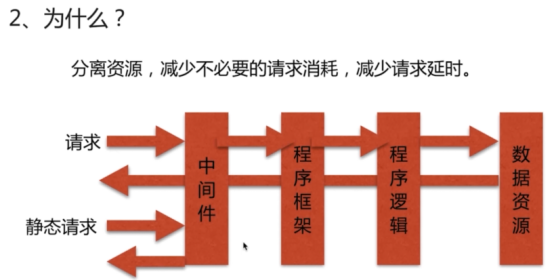

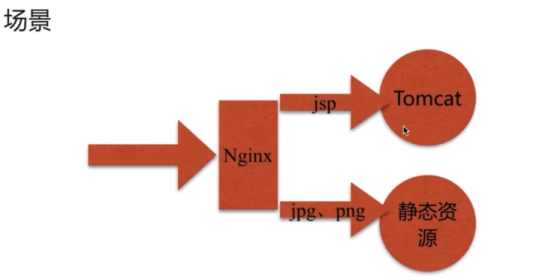

- 动静分离(重点)

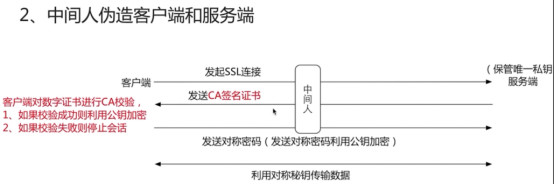

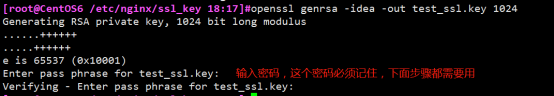

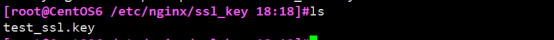

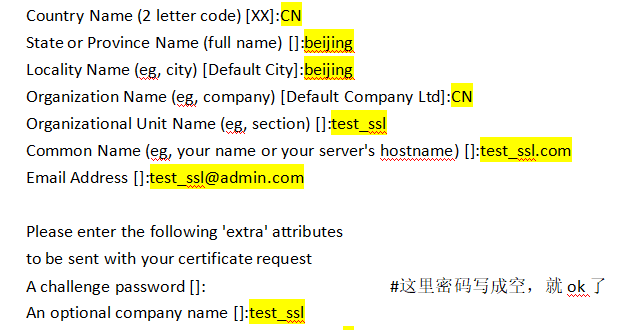

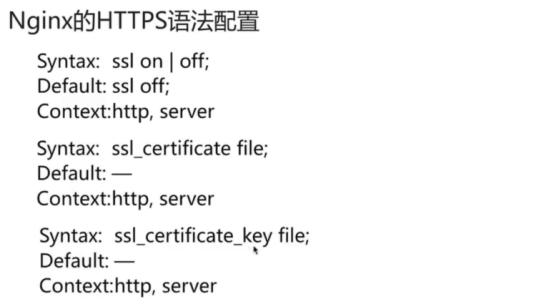

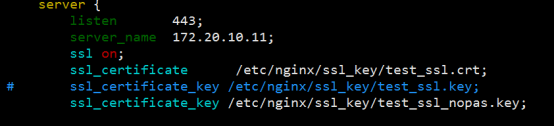

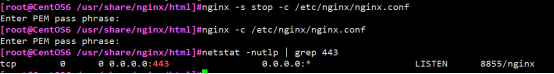

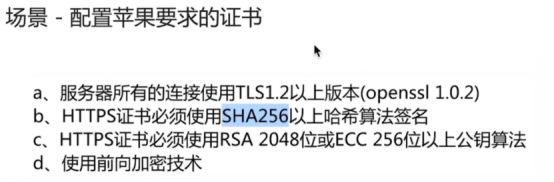

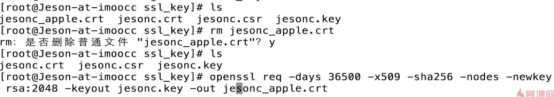

- https服务

- 如何在根 CA 下生成服务器和客户端证书

- 阿里云的个人博客添加免费的HTTPS证书

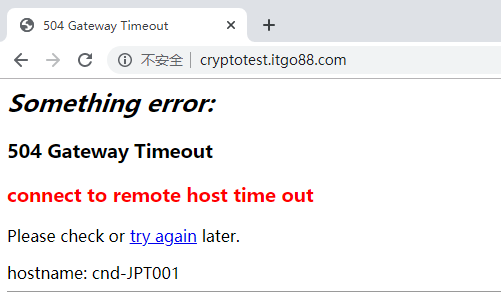

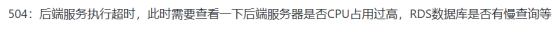

- HTTP状态码(HTTP Status Code)

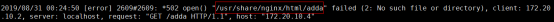

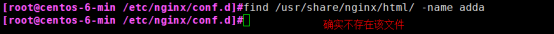

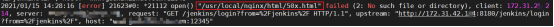

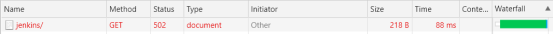

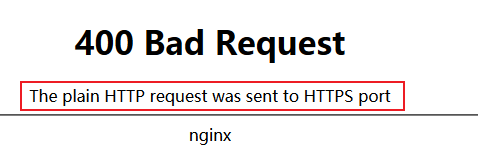

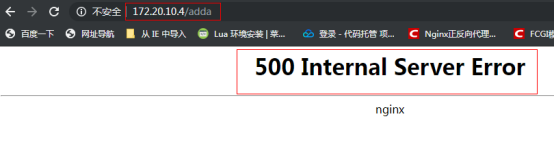

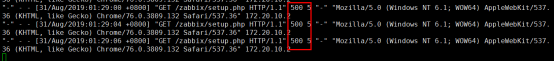

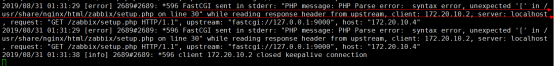

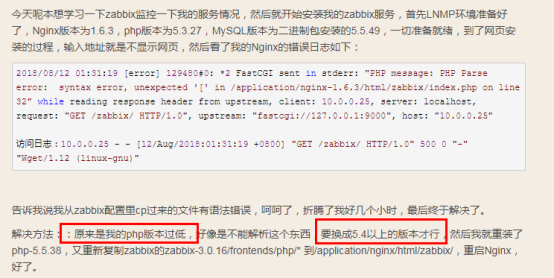

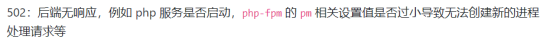

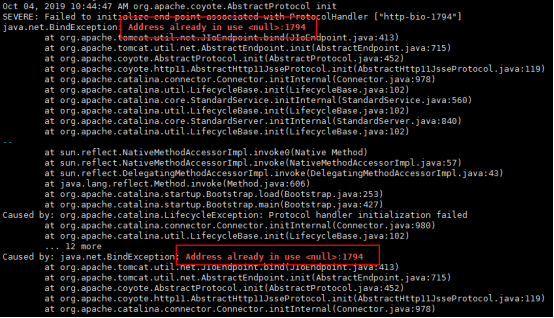

- 陷进和常见错误

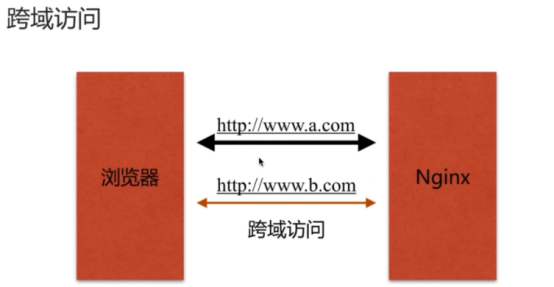

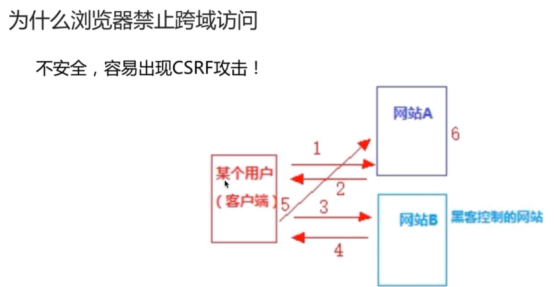

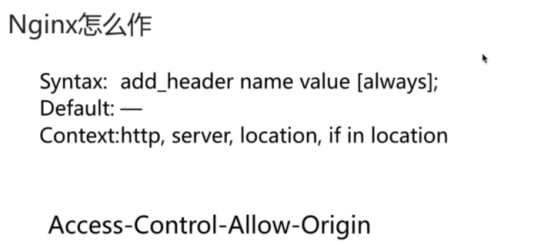

- 跨域访问

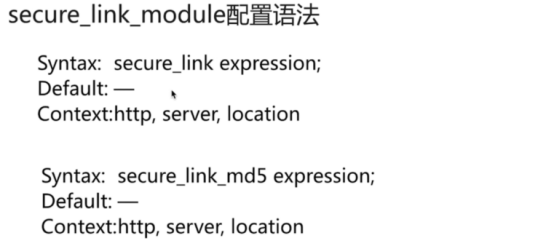

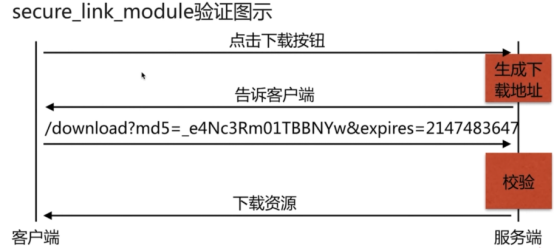

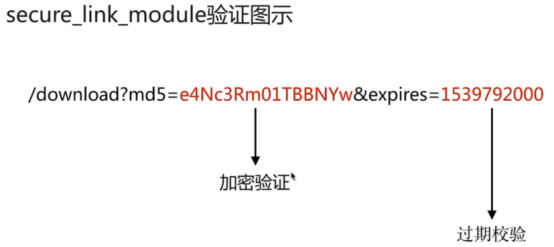

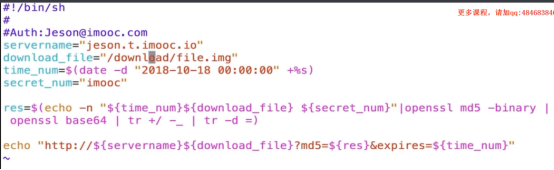

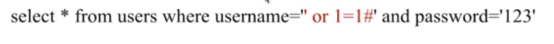

- 高级模块

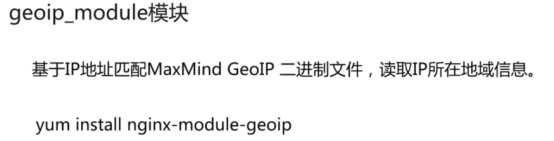

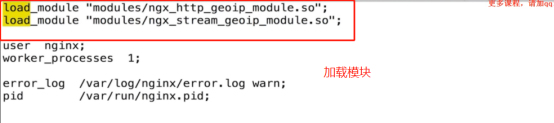

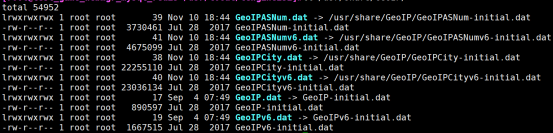

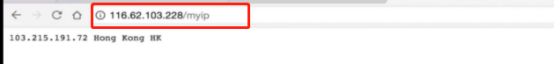

- 读取地域信息模块geoip

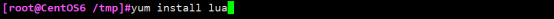

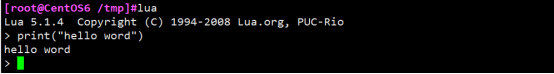

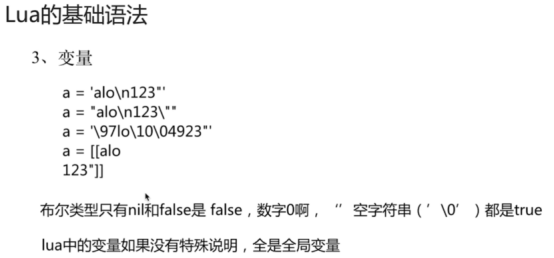

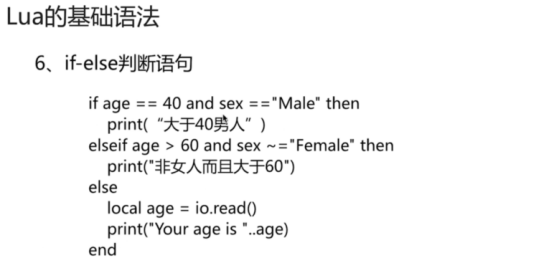

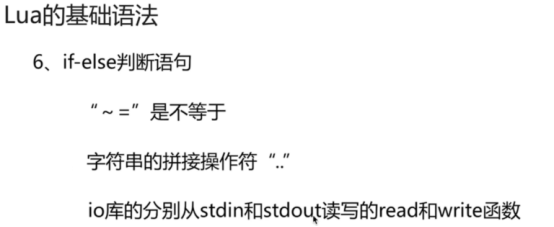

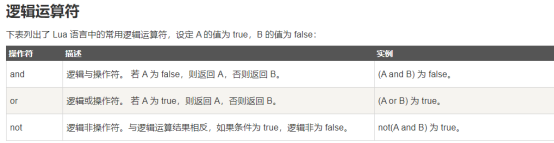

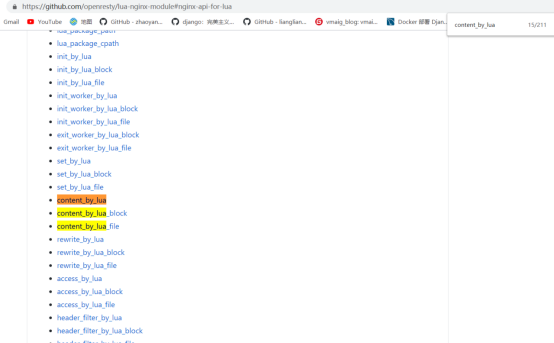

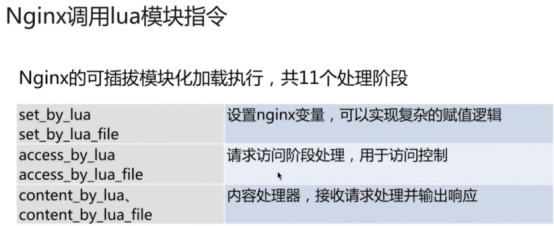

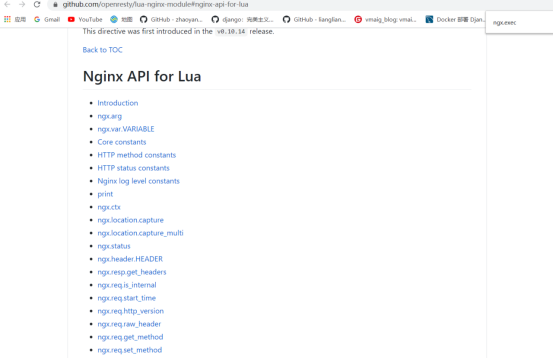

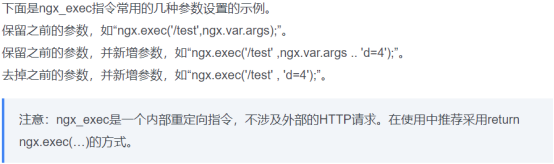

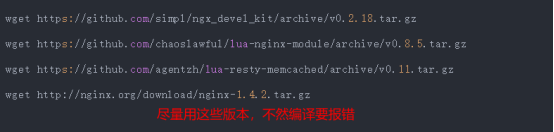

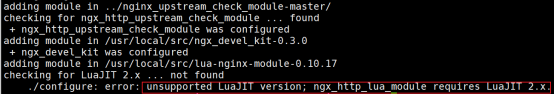

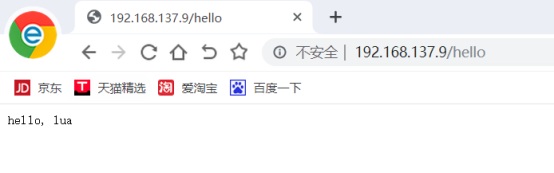

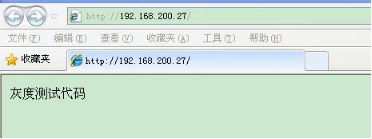

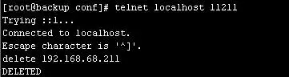

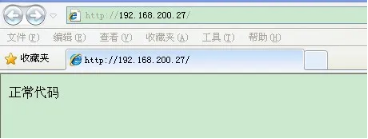

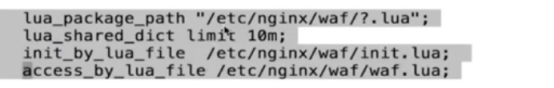

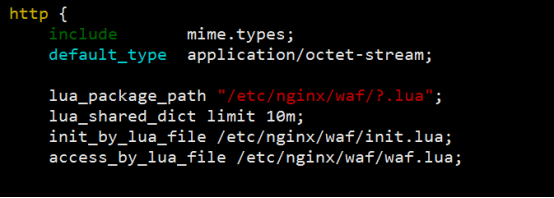

- nginx与Lua(鲁瓦)的开发(实现代码的灰度发布)

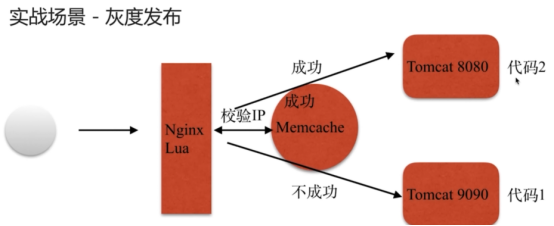

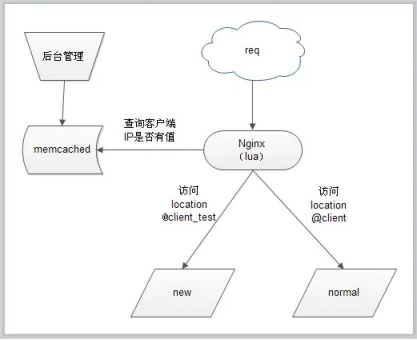

- 基于 Nginx+lua+Memcache企业场景->实现灰度发布

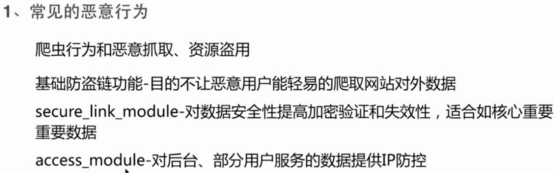

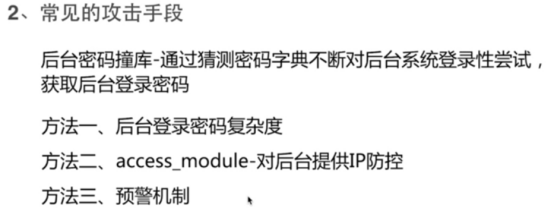

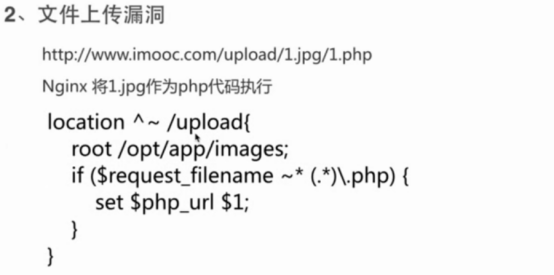

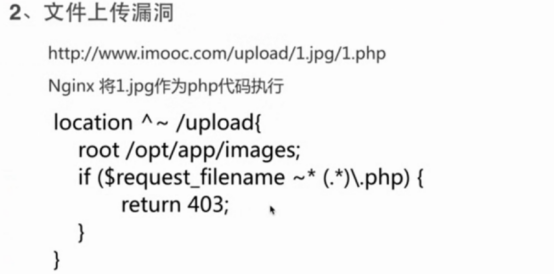

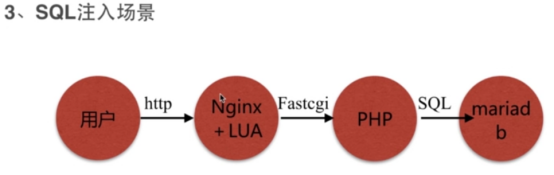

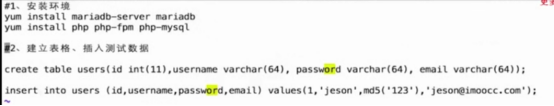

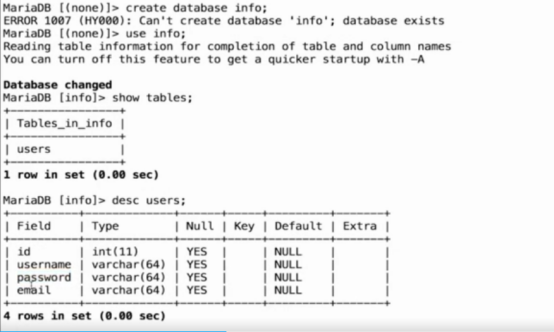

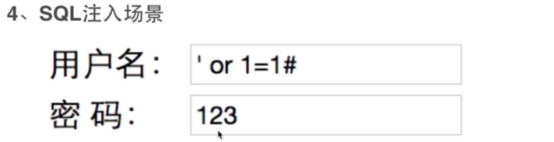

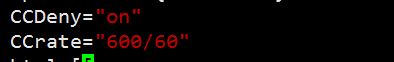

- Nginx架构的安全(sql注入)

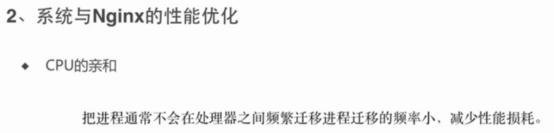

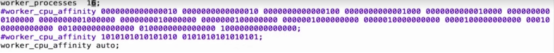

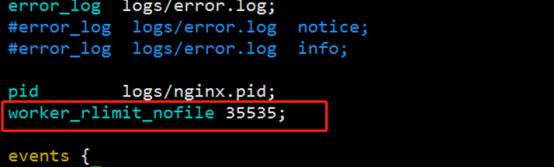

- 系统与Nginx的性能优化

- 性能优化

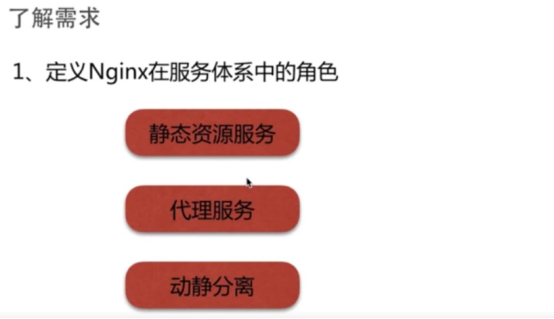

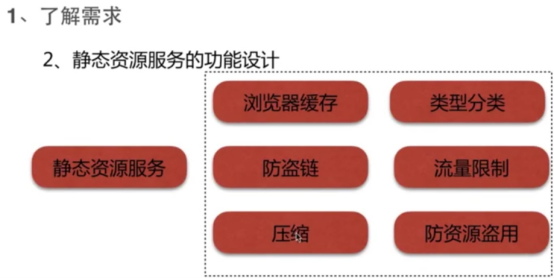

- Nginx静态资源服务的功能设计

- Nginx作为代理服务器的需求

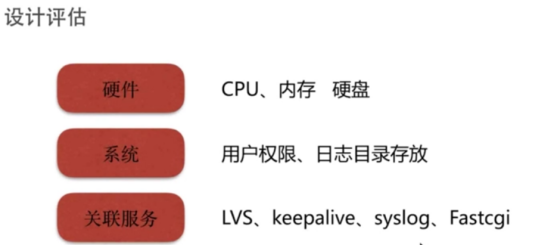

- 需求设计评估

http://nginx.org/

https://github.com/dunwu/nginx-tutorial

nginx的历史

Netcraft公司,1994年在英国成立,官方网址为http://uptime.netcraft.com,该公司为互联网市场以及在线安全方面提供咨询服务,同时针对网站服务器、域名解析、主机提供商以及SSL市场进行客观严谨的分析研究。

nginx的官方网站http://www.nginx.org,同时wiki为nginx开设了专门的介绍页面,链接为http://wiki.nginx.org/Main

nginx服务器是轻量级web服务器,2002年第一个版本发布,是开源的高性能httd服务器及反向代理服务器(reverse proxy)产品,同时,它还可以提供IMAP/POP3代理服务器等功能。在实际的使用中,nginx还可以提供更多更丰富的功能。

Nginx ("engine x") 是一个高性能的 HTTP 和 反向代理 服务器,也是一个 IMAP/POP3/SMTP 代理服务器。 Nginx 是由 Igor Sysoev 为俄罗斯访问量第二的 Rambler.ru 站点开发的,第一个公开版本0.1.0发布于2004年10月4日。其将源代码以类BSD许可证的形式发布,因它的稳定性、丰富的功能集、示例配置文件和低系统资源的消耗而闻名。2011年6月1日,nginx 1.0.4发布

nginx的功能特性

nginx既可以作为http服务器,也可以作为方向代理服务器或者邮件服务器,能够快速响应静态页面(HTML)的请求,支持fastcgi、ssl、virtual host、URL rewrite、http basic auth、gzip等大量使用功能,并且支持更多的第三方功能模块的扩展

-

nginx提供基本http服务,可以作为http代理服务器和方向代理服务器,支持通过缓存加速访问,可以完成简单的负载均衡和容错,支持包括过滤功能,支持ssl等

-

nginx提供高级http服务,可以进行自定义配置,支持虚拟主机,支持URL重定向,支持网络监控,支持流媒体传输

-

nginx作为邮件代理服务器是最早开发这个产品的目的之一,它支持IMAP/pop3代理服务功能,支持内部smtp代理服务功能

基本http服务

-

处理静态文件(如HTML静态网页及请求),处理索引文件及支持自动索引

-

打开并自行管理文件描述符缓存

-

提供反向代理服务,并且可以使用缓存加速反向代理,同时完成简单的负载均衡及容错

-

提供远程fastcgi服务的缓存机制,加速访问,同时完成简单的负载均衡以及容错

-

使用nginx的模块化特性提供过滤器功能。nginx基本过滤包括gzip压缩、ranges支持、chunked响应、xslt、ssl以及图像缩放等。其中,针对包含多个ssi的页面,经由fastcgi或方向代理,ssi过滤可以进行处理

-

支持http下的安全套接层安全协议ssl

高级http服务

-

支持基于域名和ip及端口的虚拟主机设置

-

支持http/1.0中的keep-alive模式和管线(pipelined)模型连接

-

支持重新加载配置以及在线升级时,无须中断正在处理的请求

-

自定义访问日志格式、带缓存的日志写操作以及快速日志轮询

-

提供3xxx-5xxx错误代码重定向功能。

-

支持重写rewrite模块功能

-

支持http dav模块,从而为http webdav提供put、delet、mkcol、copy以及move方法

-

支持flv流很热MP4流传输

-

支持网络监控,包括基于客户端ip地址、http基本认证机制的访问控制、速度限制、来自同一地址的同时连接数或者请求数限制等

-

支持嵌入perl语言

邮件代理服务

-

支持使用外部http认证服务器重定向用户到IMAP/POP3后端,并支持IMAP认证方式(LOGIN、AUTH LOGIN/PLAIN/CRAM-MD5)和POP3认证方式(USER/PASS、APOP、AUTH LOGIN/PLAIN/CRAM-MD5)

-

支持使用外部http认证服务器认证用户后重定向连接到内部SMTP后端,并支持SMTP认证方式(AUTH LOGIN/PLAIN/CRAM-MD5)

-

支持邮件代理服务下的安全套接层安全协议ssl

-

支持纯文本通信协议的扩展协议starttls

常见功能介绍

http代理和方向代理

代理服务及反向代理服务是nginx服务器作为web服务器的主要功能之一,尤其是反向代理服务,是应用十分广泛的功能

在提供反向代理服务方面,nginx服务器转发前端请求性能稳定,并且后端转发与业务配置相互分离,配置相当灵活。在进行nginx服务器配置时,配置后端转发请求完全不用关心网络环境如何,可以指定任意的ip地址和端口号,或者其他类型连接、请求等

它支持判断表达式。通过使用正则表达式进行相关配置、可以实现根据不同表达式、采取不同的转发策略。它对后端返回情况进行异常判断,如果返回结果不正常,则重新请求另一台主机(即将前端请求转向另一后端ip),并且自动剔除返回异常的主机。它还支持错误页面跳转功能

负载均衡

负载均衡一般包含两方面的含义。一方面:将单一的重负载分担到多个网络节点上做并行处理,每个节点处理结束后将结果汇总返回给用户,这样可以大幅度提高网络系统的处理能力;第二个方面:将大量的前端并发访问或者数据流量分担到多个后端网络节点上分别处理,这样就可以减少前端用户等待响应的时间。 web服务器、ftp服务器、企业关键应用服务器等网络应用方面谈到的负载均衡问题,基本隶属于后一方面的含义。因此,nginx服务器的负载均衡主要是针对大量前端访问和流量进行分流,以保证前端用户访问效率。可以说,在绝大数nginx应用中,都会或多或少涉及它的负载均衡服务

nginx服务器的负载均衡策略可以分两大类:即内置策略和扩展策略。内置策略主要包含轮询、加权轮询和IP hash三种;扩展策略主要通过第三方模块实现,种类比较丰富,常见的有url hash、fair等

在默认情况下,内置策略会被编译进nginx内核,使用时只需在nginx服务器配置中设置相关参数即可。扩展策略不会编译到nginx内核,需要手动将第三方模块编译到nginx内核

几种负载策略的实现原理

- 轮询策略,比较简单,就是讲每个前端的请求顺序(时间顺序或者排列次序)逐一分配到不同的后端节点上,对于出现问题的后端节点自动排除。

- 加权轮询策略,顾名思义,就是在基本的轮询策略上考虑各后盾节点接受请求的权重,指定各个后端节点被轮询的几率。加权轮询主要是用于后端节点性能不均的情况。根据后端节点性能的实际情况,我们可以在nginx服务器的配置文件中进行权值的调整,使得整个网络对前端请求达到最佳的响应能力

-

ip hash策略,是将前端的访问ip进行hash操作,然后根据hash结果将请求分配给不同的后端节点。事实上,这种策略可以看做是一种特殊的轮询策略。通过nginx的实现,每个前端访问ip会固定访问一个后端节点。这样做的好处是避免考虑前端用户的session在后端多个节点上共享的问题

-

扩展策略中的url hash在形式上和ip hash相近,不同之在于,ip hash策略是对前端访问ip进行了hash操作,而url hash策略是对 前端请求额url进行了hash操作。url hash策略的优点在于,如果后端有缓存服务器,它能够提供缓存效率,同时也也解决session的问题,但是其缺点是,如果后端出现异常,他不能自动排除异常,不能自动排除节点。在实际使用过程中发现,后端节点出现异常会导致nginx服务器返回503错误。

-

扩展的第三方模块fair,是从另一角度来实现nginx服务器负载均衡策略的。该模块将前端请求转发到一个最近负载最小的后端节点。那么,负载最小怎么判断呢?nginx通过后端节点对请求的响应时间来判断负载情况。响应时间短的节点负载相对就轻。得出结果后,nginx就将前端请求转发到选中的负载最轻的节点

web缓存

相信不少读者对squid有所了解。它在web服务器领域中是一款相当流行的开源代理服务器和web缓存服务器。作为网页的服务器的前置缓存服务器,在很多优秀的站点中,它被用以缓存前端请求,从而提高web服务器的性能;而且,他还可以缓存万维网、域名系统或者其他网络搜索,为一个整体提供网络资源共享服务

nginx在0.7.48版本开始,也支持了和squid类型的缓存功能。

nginx服务器的web缓存服务主要由proxy_cache相关指令集和fastcgi_cache相关指令集构成。其中,proxy_cache主要用于在nginx服务器提供方向代理服务时,对后端资源服务器的返回内容进行url缓存。fgastcgi_cache主要用于对fastcgi的动态程序进行缓存。另外还有一款常用的第三方模块ngx_cache_purge也是nginx服务器web缓存功能中经常用到的,它主要用于清除nginx服务器上的指定的url缓存

到nginx08.32版本后,proxy_cache和fastcgi_cache两部分的功能已经比较完善,再配合第三方的ngx_cache_purge模块,nginx服务器已具备了squid所有拥有的web缓存加速功能和清除指定url缓存功能;同时nginx服务器对多核CPU的调度比squid更胜一筹,性能高于squid,而在反向代理、负载均衡等其他方面,nginx也 不逊于squid。这使得nginx服务器可以同时作为负载均衡服务器和web缓存服务器来使用,基本可以取代squid

特点:高效、可靠、开源

高效:支持海量的并发请求

可靠:稳定性好、运行可靠

开源:

-

支持高并发:能支持几万并发连接(特别是静态小文件业务环境)

-

资源消耗少:在3万并发连接下,开启10个Nginx线程消耗的内存不到200MB

-

可以做HTTP反向代理及加速缓存、即负载均衡功能,内置对RS节点服务器健康检查功能,这相当于专业的Haproxy软件或LVS的功能。

-

具备Squid等专业缓存软件等的缓存功能。

-

支持异步网络I/O事件模型epoll(Linux 2.6+)(绘图说明同步和异步)

大并发写操作;先写内存,再将内存数据存储到硬盘中---保证访问效率

大并发读操作;先写磁盘,再将磁盘数据存储到内存中---保证数据安全

总结:高并发-->资源消耗少-->功能多样(web服务/负载均衡/支持缓存)-->通讯模型先进(epoll)

作用

解决c10k问题->https://moonbingbing.gitbooks.io/openresty-best-practices/web/c10k.html

实现反向代理及电子邮件(IMAP/POP3)代理服务器

实现缓存功能

实现负载均衡

技术(4个主要技术)

IO多路复用:

多个描述符的I/O操作都能在一个线程内并发交替的顺序完成,这就叫I/O多路复用,这里的"复用"指的是复用同一个线程。

举例:由A学生报备自己做完的情况,然后在由老师来解答这个学校的疑惑,因为A学生比较优秀,其他的同学还没有做完,等做完了,老师也解答完了,然后在给下个做完的同学解答

epoll模型:

3、IO多路复用epoll

IO多路复用的实现方式有:select、poll、epoll

select方式缺点:

-

能够监视文件描述符的数量存在最大限制

-

线性扫描效率低下

select方式优点:

- Windows、linux都支持

epoll方式优点:

-

没有最大并发连接的限制

-

效率提升,不是轮询的方式,不会随着FD数目的增加效率下降

轻量级

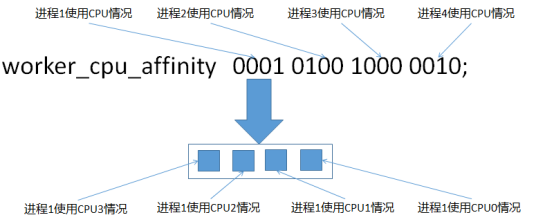

cpu亲和

CPU亲和是一种把CPU核心和Nginx工作进程绑定方式,把每个worker进程固定在一个CPU上执行,减少切换CPU的cache miss,获得更好的性能。

sendfile

这个模式针对静态文件处理速度非常之快。

学习环境

nginx软件包总共不到20M的磁盘空间,实际情况可能因为编译设置不同会有所不同,但是至少保证有20M以上的空间吧

# yum -y install gcc gcc-c++ autoconf pcre pcre-devle make automake httpd-tools

安装Nginx(yum安装)

进入官网下载yum源:http://nginx.org/

进入稳定版本下载链接地址:

把官网的yum源复制到服务器上面,并修改一下信息

修改如下(修改原因:我们用的是centos,并且是7版本的系统)

查看yum源是否可用,如果可用-->然后进行安装Nginx

[root@test-7 ~]# yum list | grep nginx

[root@test-7 ~]# yum install nginx -y

在次查看版本信息,如果出现下面内容,说明安装成功

[root@test-7 ~]# nginx -v

nginx version: nginx/1.14.2

[root@test-7 ~]# nginx -V

nginx version: nginx/1.14.2

built by gcc 4.8.5 20150623 (Red Hat 4.8.5-28) (GCC)

built with OpenSSL 1.0.2k-fips 26 Jan 2017

TLS SNI support enabled

configure arguments: --prefix=/etc/nginx --sbin-path=/usr/sbin/nginx --modules-path=/usr/lib64/nginx/modules --conf-path=/etc/nginx/nginx.conf --error-log-path=/var/log/nginx/error.log --http-log-path=/var/log/nginx/access.log ……………………--with-stream_realip_module --with-stream_ssl_module --with-stream_ssl_preread_module --with-cc-opt='-O2 -g -pipe -Wall -Wp,-D_FORTIFY_SOURCE=2 -fexceptions -fstack-protector-strong --param=ssp-buffer-size=4 -grecord-gcc-switches -m64 -mtune=generic -fPIC' --with-ld-opt='-Wl,-z,relro -Wl,-z,now -pie'

Nginx的安装目录详解

查看软件安装的位置:

[root@test-7 ~]# rpm -ql nginx

etc下面主要放置Nginx的主要配置

安装nginx(rpm安装)

下载地址:我们是centos7 x86_64系统

https://nginx.org/packages/centos/7/x86_64/RPMS/nginx-1.20.2-1.el7.ngx.x86_64.rpm

rpm -ivh --test nginx-1.20.2-1.el7.ngx.x86_64.rpm

rpm -ivh nginx-1.20.2-1.el7.ngx.x86_64.rpm

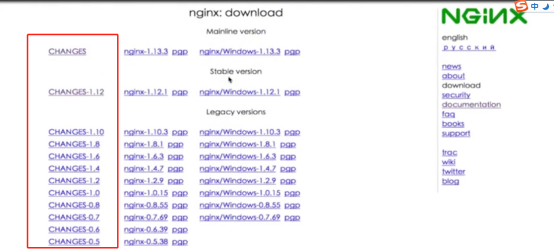

安装Nginx(源码包安装1.14)

nginx服务器版本包括Windows和linux,在官网就能找到对应的下载链接。

网页上提供了nginx服务器三种版本的下载,分别是开发版本(Development version)、稳定版本(Stable version)和过期版本(Legacy version)。其中,开发版本主要用于nginx软件项目的研发(其中,开发版本同时也是nginx全部版本中最新的版本),稳定版本即可以作为web服务器投入使用

下载链接各部分的含义:

- CHANGES-x.xx链接,记录的是对应版本的功能变更日志。包括新增功能,功能的优化和功能缺陷的修复。

- nginx-x.x.x链接,是nginx服务器linux版本下载链接,下载后的文件后缀名以.tar.gz结尾

- pgp链接,记录的是提供下载的版本使用pgp加密自由软件GunPG计算后的签。GPG可以解释为Pretty Good Privacy,是PGP公司的加密或者签名工具套件。点击链接进入相关页面,可以查看GunPG针对下载版本的签名,已经执行本次计算的GunPGP软件版本号。这些数据可以用于下载文件的校验

- nginx/Windows-x.xx.x链接,是nginx服务器的Windows版本下载链接,下载后得到的文件后缀名是以.zip结尾的

准备编译环境

在安装Nginx之前,需确保系统已经安装了gcc openssl openssl-devel pcre-devel和zlib-devel软件库。

编译nginx源代码,需要标准的GCC编译器。GCC的全称为GUNCompiler Collection,其有GUN开发,并以GPL及LGPL许可证发行,是自由的类UNIX及苹果电脑Mac OS X 操作系统的标准编译器。因为GCC原本只能处理C语言,所有原名为GUN C语言编译器,后来得到快速发展,可处理C++、Fortran、Pascal、Objective-C、java以及Ada等其他语言

除此之外,我们还需要Automake工具,已完成自动创建Makefile文件的工作

由于nginx的一些模块需要依赖其他第三方库,通常有pcre库(支持rewrite模块)、zlib库(支持gzip模块)和openssl库(支持ssl模块)等

yum groupinstall 'Development Tools' -y #组包里面基本基本包含了一下软件包,可以直接安装这个组包就行了

yum install -y gcc gcc-c++ automake make autoconf pcre pcre-devel zlib zlib-devel openssl openssl-devel

(gzip模块需要 zlib 库,rewrite模块需要 pcre 库,ssl 功能需要openssl库)

注意的是,我们可以不需要安装autoconf工具。nginx软件的自动脚本不是用autoconf工具生成的,而是作者手工编写的。

创建系统用户

[root@test]# groupadd -r nginx

[root@test]# useradd -r -g nginx -s /sbin/nologin -M -c "create-time is `date +%Y/%m/%d` ;is web service" nginx

下载源码包并了解源码包的结构

[root@test nginx]# wget http://nginx.org/download/nginx-1.14.2.tar.gz #(下载源码包)

[root@test nginx]# tar zxf nginx-1.14.2.tar.gz #(解压源码包)

[root@test nginx]# ls

nginx-1.14.2 nginx-1.14.2.tar.gz

[root@test nginx]# cd nginx-1.14.2

了解nginx软件包的结构:

# ll

total 732

drwxr-xr-x. 6 1001 1001 4096 Nov 30 22:04 auto

-rw-r--r--. 1 1001 1001 288742 Dec 4 2018 CHANGES

-rw-r--r--. 1 1001 1001 440121 Dec 4 2018 CHANGES.ru

drwxr-xr-x. 2 1001 1001 168 Nov 30 22:04 conf

-rwxr-xr-x. 1 1001 1001 2502 Dec 4 2018 configure

drwxr-xr-x. 4 1001 1001 72 Nov 30 22:04 contrib

drwxr-xr-x. 2 1001 1001 40 Nov 30 22:04 html

-rw-r--r--. 1 1001 1001 1397 Dec 4 2018 LICENSE

drwxr-xr-x. 2 1001 1001 21 Nov 30 22:04 man

-rw-r--r--. 1 1001 1001 49 Dec 4 2018 README

drwxr-xr-x. 9 1001 1001 91 Nov 30 22:04 src

-

src目录存放了nginx软件的所有源码

-

man目录存放nginx软件的帮助文档,nginx安装完成过去,可以使用

man nginx查看帮助 -

html目录存放了两个后缀名为.html的静态网页文件。这两个文件与nginx服务器的运行相关

-

log目录存放nginx服务器的运行日志文件

-

conf目录存放nginx的配置文件

-

auto目录存放了大量的脚本文件,和configure脚本程序有关

-

configure文件时nginx软件的自动脚本程序。运行configure自动脚本一般会完成两项工作:一、检查环境,根据环境检查结果生成c代码;二、生成编译代码需要的Makefie文件

-

CHANGES CHANGES.ru LICENSE README nginx服务器的文档资料

进入auto目录,我们可以看到各种资源脚本。这些脚本职能划分清晰,有的检查环境(如os目录下的脚本),有个检查模块(如modules脚本),有的处理脚本参数(options脚本),有的用来输出信息到生成文件的(如hava、nohava、make、及install等),还有的是为自动脚本本身服务(如feature脚本)的。前面已经提到,nginx软件的自动脚本是作者手工编写的,如果你在工作中需要编写自动脚本或者希望学习相关内容,这个目录具有很高的参考价值。

生成Makefile文件过程

nginx源代码的编译需要使用configure脚本自动生成Makefile文件,在介绍生成Makefile文件操作之前,我们先介绍下nginx 的configure脚本支持的常用选项:

./configure --help

--prefix=/usr/local/nginx #指定nginx软件的安装路径,此项如果未指定,默认/usr/local/nginx

--conf-path=/usr/local/nginx/conf/nginx.conf #指定默认的nginx.conf文件的路径及名字,未指定,默认<prefix>/conf/nginx.conf

--sbin-path=/usr/local/nginx/sbin/nginx #指定nginx可执行文件安装路径及名字,如果未指定,默认<prefix>/sbin/目录里

--user=nginx #指定运行nginx进程的用户,默认是nobody,表示不限制

--group=nginx #指定运行nginx进程的组,默认是nobody,表示不限制

--pid-path=/run/nginx.pid #指定pid文件,保存了nginx服务当前运行的进程号

--lock-path=/var/lock/nginx.lock #指定lock文件,nginx.lock是nginx服务器的锁文件。指向 lock 文件(nginx.lock)(安装文件锁定,防止安装文件被别人利用,或自己误操作。)进程ID文件

--http-log-path=/var/log/nginx/access.log #指定访问日志

--error-log-path=/var/log/nginx/error.log #指定错误日志

--with-http_ssl_module #启用HTTP的ssl模块,这样nginx服务器就可以支持HTTPS请求了。这个模块的正常运行需要安装openssl库(在debian上为libssl)

--with-http_realip_module #启用http的realip模块,此模块支持显示真实来源IP地址,主要用于nginx做前端负载均衡服务器使用。默认不启用

--with-http_realip_module #允许从请求标头更改客户端的IP地址值,默认关闭。此模块支持显示真实来源IP地址,主要用于nginx做前端负载均衡服务器使用

--with-http_gzip_static_module #在线实时压缩输出数据流,就是指定压缩

--with-http_stub_status_module #获取nginx自上次启动以来的状态,默认不启用

--with-pcre #此模块支持rewrite功能

--with-stream #支持4层转发,Nginx Stream 模块允许配置和管理基于 TCP 和 UDP 的流量,例如代理、负载均衡、SSL/TLS 终端等。

--with-stream=dynamic #使用动态编译选项 --with-stream=dynamic,可以在编译 Nginx 时启用 Stream 模块,并将其作为动态模块加载。通过将 Stream 模块设置为动态加载,可以灵活地根据需要加载或卸载该模块,而无需重新编译和安装整个 Nginx 服务器。编译完成后,在 Nginx 配置文件中可以使用 load_module 指令加载 Stream 模块: load_module modules/ngx_stream_module.so; 这样就完成了 Nginx 动态加载 Stream 模块的配置。

--with-stream_ssl_module #enable ngx_stream_ssl_module

--with-stream_realip_module #enable ngx_stream_realip_module

--with-stream_geoip_module #enable ngx_stream_geoip_module

--with-stream_geoip_module=dynamic #enable dynamic ngx_stream_geoip_module

--with-stream_ssl_preread_module #enable ngx_stream_ssl_preread_module

--http-client-body-temp-path=/var/lib/nginx/body #设定http客户端请求临时文件路径

--http-fastcgi-temp-path=/var/lib/nginx/fastcgi #设定http fastcgi临时文件路径

--http-proxy-temp-path=/var/lib/nginx/proxy #设定http代理临时文件路径

--http-scgi-temp-path=/var/lib/nginx/scgi #设定http scgi临时文件路径

--http-uwsgi-temp-path=/var/lib/nginx/uwsgi #设定http uwsgi临时文件路径

--with-debug #启用debug日志,默认不开启,实际建议开启

--with-pcre-jit #编译PCRE包含“just-in-time compilation”。是 Nginx 编译选项中的一个参数,用于启用 PCRE(Perl Compatible Regular Expressions)的 Just-In-Time 编译功能。PCRE 是一个用于正则表达式匹配的库,Nginx 使用 PCRE 来处理正则表达式相关的配置和规则。Just-In-Time 编译是 PCRE 的一项优化技术,它可以在运行时将部分正则表达式编译为机器码,以提高正则表达式的匹配性能。通过添加 --with-pcre-jit 编译选项进行编译,可以启用 PCRE 的 JIT 编译功能,从而获得更快的正则表达式匹配性能。

--with-ipv6 #启用ipv6支持

--with-http_auth_request_module #实现基于一个子请求的结果的客户端授权。如果该子请求返回的2xx响应代码,所述接入是允许的。如果它返回401或403中,访问被拒绝与相应的错误代码。由子请求返回的任何其他响应代码被认为是一个错误。

--with-http_addition_module #作为一个输出过滤器,支持不完全缓冲,分部分响应请求

--with-http_dav_module #增加PUT,DELETE,MKCOL:创建集合,COPY和MOVE方法 默认关闭,需编译开启

--with-http_geoip_module #使用预编译的MaxMind数据库解析客户端IP地址,得到变量值

--with-http_gunzip_module #它为不支持“gzip”编码方法的客户端解压具有“Content-Encoding: gzip”头的响应。

--with-http_image_filter_module #传输JPEG/GIF/PNG 图片的一个过滤器)(默认为不启用。gd库要用到)

--with-http_spdy_module #SPDY可以缩短网页的加载时间

--with-http_sub_module #允许用一些其他文本替换nginx响应中的一些文本

--with-http_xslt_module #过滤转换XML请求

--with-mail #启用POP3/IMAP4/SMTP代理模块支持

--with-mail_ssl_module #启用ngx_mail_ssl_module支持

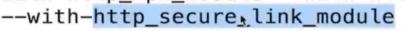

--with-http_secure_link_module #高级模块之安全模块,HTTP Secure Link 模块是 Nginx 的一个内置模块,用于生成和验证安全链接。安全链接是一种带有签名的 URL,用于授权访问受限资源。通过添加 --with-http_secure_link_module 编译选项进行编译,可以启用 HTTP Secure Link 模块,在 Nginx 中使用相关指令来生成和验证安全链接。

--builddir=DIR #指定编译时的目录

--add-module=PATH #指定第三方模块的路径,用于编译到nginx服务器中

--with-poll_module #声明启用poll模块,poll模块是信号处理的一种方法,和下面提到的select模式类似,都是采用轮询方法处理信号

--without-poll_module #禁用poll模块

--with-select_module #启用select信号处理模式。若configure未找到指定信号处理模式(上面提到的SUN系统中的kqueue、linux2.6+内核的epoll、实时信号rtsig以及和select类似的/dev/poll等),则默认使用select模式

--without-select_module #禁用select模块

--with-perl_modules_path=PATH #指定perl模块的路径

--with-perl=PATH #指定perl执行文件路径

--with-zlib=DIR #指定zlib库源码的路径。这样可以在编译nginx源码的同时编译zlib库,可以不提前用yum安装zlib库。zlib支持gzip模块

--with-zlib-opt=OPT #为zlib库的building指定额外的指令

--with-zlib-asm=CPU #针对特殊的cpu声明使用汇编源代码

--with-openssl=DIR #指定openssl库源码的路径。这样可以在编译nginx源码的同时编译openssl库,而不需要提前安装openssl库

--with-openssl-opt=OPTIONS #为openssl库的building指定额外的指令

--with-cc= #指向 C 编译器路径

--with-cpp= #指向 C 预处理路径

--with-cc-opt= #设置 C 编译器参数

--with-ld-opt= #设置连接文件参数

--with-cpu-opt= #指定编译的 CPU,可用的值为:pentium, pentiumpro, pentium3, pentium4, athlon, opteron, amd64, sparc32, sparc64, ppc64

--with-threads #开始为AIO引入了线程池支持,能够使用多线程读取和发送文件,以免工人进程被阻塞.要启用多线程支持,configure时需要显式加入–with-threads选项. 具体讲解可以参考该博客 Nginx线程池性能提升9倍,http://segmentfault.com/a/1190000002924458

--with-file-aio #启用aio时会自动启用directio,小于directio定义的大小的文件则采用sendfile进行发送,超过或等于directio定义的大小的文件,将采用aio线程池进行发送,也就是说aio和directio适合大文件下载.因为大文件不适合进入操作系统的buffers/cache,这样会浪费内存,而且Linux AIO(异步磁盘IO)也要求使用directio的形式. sendfile_max_chunk可以减少阻塞调用sendfile()所花费的最长时间.因为Nginx不会尝试一次将整个文件发送出去,而是每次发送大小为256KB的块数据

--with-compat #是 Nginx 编译选项中的一个参数,用于启用与第三方动态模块兼容的能力。当使用 --with-compat 编译选项编译 Nginx 时,会生成一个特殊的“兼容性”模块。这个模块的作用是允许使用以前版本编译的动态模块在新版本的 Nginx 上继续工作,减少模块升级所需的修改和兼容性问题。通过添加 --with-compat 编译选项进行编译,可以确保新版本的 Nginx 与旧版本的第三方动态模块保持兼容。这意味着,你无需对现有的第三方模块进行重新编译,而是可以直接加载它们而不会出现兼容性问题。

--with-http_flv_module #是 Nginx 的编译选项,用于启用 http_flv_module 模块的支持。通过添加这个选项进行编译,可以使 Nginx 具备处理 FLV 文件的能力。这样,客户端发送 FLV 文件的请求时,Nginx 就能够正确地处理并传输 FLV 文件给客户端。

--with-http_mp4_module #是 Nginx 的编译选项之一,用于启用对 MP4 视频文件的支持。该选项允许 Nginx 处理和传输 MP4 文件。 MP4(MPEG-4 Part 14)是一种常见的数字多媒体容器格式,常用于存储音频和视频数据。通过启用 --with-http_mp4_module 编译选项,你可以使 Nginx 具备处理和传输 MP4 文件的能力。

--with-http_v2_module #是一个 Nginx 编译选项,用于启用 HTTP/2 模块。 HTTP/2 是一种新一代的网络传输协议,与之前的 HTTP/1.1 相比,它具有更高效的传输性能和更多的功能。启用 HTTP/2 模块后,Nginx 将能够提供对客户端使用 HTTP/2 进行通信的支持。完成编译和安装后,在 Nginx 的配置文件中,可以使用 listen 指令启用 HTTP/2 支持: listen 443 ssl http2; 使用上述配置指令将 Nginx 监听在端口 443 上,并启用 SSL 和 HTTP/2。`请注意`,这只是启用 HTTP/2 模块的基本步骤。还可以根据需要对 Nginx 进行更多的配置和定制。另外,确保你的 OpenSSL 版本支持 HTTP/2,因为 HTTP/2 需要适当的 OpenSSL 版本才能正常工作。

使用如下命令配置生成Makefile文件:

[root@test nginx-1.14.2]# #(进入编译安装的目录)

./configure \

--prefix=/usr/local/nginx \

--user=nginx \

--group=nginx \

--sbin-path=/usr/local/nginx/sbin/nginx \

--conf-path=/usr/local/nginx/conf/nginx.conf \

--http-log-path=/usr/local/nginx/logs/access.log \

--error-log-path=/usr/local/nginx/logs/error.log \

--pid-path=/usr/local/nginx/logs/nginx.pid \

--lock-path=/usr/local/nginx/logs/nginx.lock \

--with-http_ssl_module \

--with-http_stub_status_module \

--with-http_gzip_static_module \

--with-http_realip_module \

--with-http_secure_link_module \

--with-http_sub_module \

--with-pcre \

--with-stream \

--http-client-body-temp-path=/usr/local/nginx/client_body_temp \

--http-proxy-temp-path=/usr/local/nginx/proxy_temp \

--http-fastcgi-temp-path=/usr/local/nginx/fastcgi_temp \

--http-uwsgi-temp-path=/usr/local/nginx/uwsgi_temp \

--http-scgi-temp-path=/usr/local/nginx/scgi_temp

可以在屏幕上看到configure自动脚本运行的全过程。在运行过程中,configure脚本调用auto目录中的各种脚本对系统已经相关的配置和设置进行检查

报错:

解决方案:安装pcre pcre-devel软件包,然后重新执行./configure ......

成功编译的界面:

nginx的编译、安装过程

得到了nginx软件的Makefile文件后,我们就可以使用make命令进行源码编译:

# make #把源代码文件编译成可执行的二进制文件,按照Makefile文件编译,可以使用-j 4 来指定4核心CPU编译,提升速度(根据你机器的CPU来指定哈)。如果是多核,那么可以make -j n #n代表物理机核数

同样,我们可以在屏幕上看到nginx源码的编译全过程

编译顺利完成后,使用make的install命令安装nginx软件了:

# make install #按Makefile定义的文件路径安装

或者直接合并在一起:

[root@test nginx-1.14.2]# make && make install

不报错默认已完成安装

# make clean #清除上次的make命令所产生的object和Makefile文件。使用场景:当需要重新执行./configure时,需要先执行make clean

配置环境变量或者软连接二进制文件

echo 'export PATH=/usr/local/nginx/sbin/:$PATH' /etc/profile.d/nginx.sh

# source /etc/profile.d/nginx.sh #加载环境变量

#或者软连接:

ln -s /usr/local/nginx/sbin/nginx /usr/local/sbin

[root@nginx-1.8.1]# mkdir /var/run/nginx # 创建 nginx pid 文件目录(需要看你安装在哪里的)

#mkdir -pv /var/tmp/nginx/client #创建http客户端请求临时文件(需要看你安装在哪里的)

[root@nginx-1.8.1]# chown nginx.nginx /var/run/nginx # 配置/var/run/nginx 文件属性

初次调整nginx配置文件

有路径的必须写正确:

# vim /usr/local/nginx/conf/nginx.conf

user nginx nginx;

worker_processes auto;

error_log /usr/local/nginx/logs/error.log;

pid /usr/local/nginx/logs/nginx.pid;

events {

worker_connections 1024;

}

http {

include mime.types;

default_type application/octet-stream;

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

sendfile on;

keepalive_timeout 65;

server {

listen 80;

server_name localhost;

access_log logs/access-main.log main;

location / {

root /usr/local/nginx/html;

index index.html index.htm;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root /usr/local/nginx/html;

}

}

include /usr/local/nginx/conf/vhost/*.conf;

}

# nginx -t -c /usr/local/nginx/conf/nginx.conf # 确认配置文件格式及语法是否正确

nginx: the configuration file /usr/local/nginx/conf/nginx.conf syntax is ok

nginx: configuration file /usr/local/nginx/conf/nginx.conf test is successful

安装后初次检查配置文件是否报错

# cd /usr/local/nginx/ #安装后,未启动nginx是,安装目录所包含的文件

# ./sbin/nginx -t #检查配置文件是否正确

如果有报错,一步一步解决,可能提示你为创建某些目录,你跟着创建后在次检查配置文件是否正确

nginx服务启动脚本,有无都可以

# centos6

# 从其他yum 安装nginx的服务器拷贝nginx 服务启动脚本到/etc/init.d 目录中

[root@conf]# scp root@192.168.23.100:/etc/rc.d/init.d/nginx /etc/init.d/

root@192.168.23.100's password:

nginx 100% 2795 2.7KB/s 00:00

[root@conf]# vi /etc/init.d/nginx # 修改nginx服务启动脚本

...

nginx="/usr/local/nginx/bin/nginx" # 指定nginx命令路径

lockfile="/var/lock/nginx" # 指定nginx lockfile文件

pidfile="/var/run/nginx/${prog}.pid" # 指定nginx 启动pid文件路径

NGINX_CONF_FILE="/etc/nginx/nginx.conf" # 指定配置脚本nginx.conf 文件路径

[root@nginx]# chkconfig --add nginx # 设置添加到chkconfig 列表

[root@nginx]# chkconfig nginx on # 设置开机自动启动

[root@nginx]# service nginx start # nginx服务启动

[root@nginx]# ss -tunlp | grep nginx

tcp LISTEN 0 128 *:80 *:* users:(("nginx",11893,6),("nginx",11895,6))

[root@nginx]# ps aux | grep nginx # 验证nginx服务 ,root角色启动主进程 ,nginx角色启动worker proess进程

# centos7的system启动文件

cat > /usr/lib/systemd/system/nginx.service << EOF

[Unit]

Description=nginx web service

After=network.target

[Service]

# 指定程序运行的用户

User=nginx

# 指定程序运行的组

Group=nginx

#Type 属性设置为 forking,表示 Systemd 将期望从 ExecStart 指定的命令中获取一个进程ID,并将其作为主服务进程。

Type=forking

PIDFile=/usr/local/nginx/logs/nginx.pid

ExecStartPre=/usr/local/nginx/sbin/nginx -t -c /usr/local/nginx/conf/nginx.conf

ExecStart=/usr/local/nginx/sbin/nginx -c /usr/local/nginx/conf/nginx.conf

ExecStop=/usr/local/nginx/sbin/nginx -s stop -c /usr/local/nginx/conf/nginx.conf

ExecReload=/usr/local/nginx/sbin/nginx -c /usr/local/nginx/conf/nginx.conf -s reload

# on-failure,表示服务在发生故障时将自动重启

Restart=on-failure

# 状态码为1时不自动重启,1为正常关闭状态码

RestartPreventExitStatus=1

# 等多久(秒)重启

RestartSec=10

# 重启只限制在300秒内

StartLimitInterval=300

# 300秒内只能重启2次

StartLimitBurst=2

# 启动服务的超时时间

TimeoutStartSec=30

# 停止服务的超时时间

TimeoutStopSec=30

# PrivateTmp=true 属性指示 Systemd 创建一个私有的临时文件系统来运行该服务,以提高安全性并避免与其他进程冲突

PrivateTmp=true

[Install]

WantedBy=multi-user.target

EOF

# 确保在修改 system.service 文件后重新加载服务配置以使其生效。可以使用以下命令重新加载 Systemd 配置:

systemctl daemon-reload

# 启动服务

systemctl start nginx

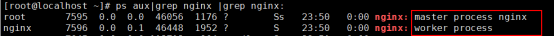

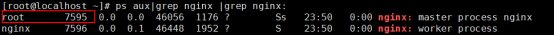

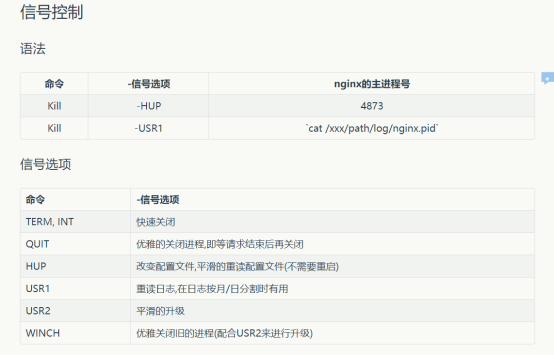

nginx服务的信号控制

在nginx服务的启停办法中,有一类是通过信号机制来实现的,介绍下nginx服务器的信号控制

nginx服务在运行时,会保持一个主进程和一个或多个worker process工作进程,只需要给nginx服务的主进程发起信号就可以控制服务的启停了,那么如何给主进程发起信号呢?首先我们要知道主进程的进程号PID

获取nginx的PID有两个方法:

一、nginx在启动后,会产生文件名为nginx.pid的文件,此文件中保存的就是nginx服务主进程的PID。这个pid文件存放的路径及位置都可以在nginx主配置文件中进行设置。

# cat /usr/local/nginx/logs/nginx.pid

7595

二、用进程工具进行查看。

ps aux | grep nginx | grep nginx

nginx的主进程是以root用户运行的,所有pid为7595,和nginx.pid里的pid一致

nginx服务主进程能够接收的信号如下:

信号 作用

TERM或者INT 快速停止nginx服务

QUIT 平缓停止nginx服务

HUP 使用新的配置文件启动进程,之后平缓停止原有进程,也就是所谓的“平缓启动”

USR1 重新打开日志文件,常用于日志切割

USER2 使用新版本的nginx文件启动服务,之后平缓停止原有nginx进程,也就是所谓的“平滑升级”

WINCH 平缓停止worker process,用于nginx服务器平滑升级

向nginx服务主进程发送信号也有两种方法:一种是使用nginx二进制文件,另一种是使用kill命令发送信号,用法如下:

kill SIGNAL PID

SIGNAL,用于指定信号,即指定上面信号中的某一个

PID,指定nginx服务主进程的PID,也可以使用nginx.pid动态获取pid:

kill SIGNAL `pid_file_path`

pid_file_path,nginx的pid文件路径

nginx服务的启动

在linux平台下,启动nginx服务器直接运行安装目录下sbin目录中的二进制文件即可

1、直接在命令行键入nginx:这样默认的启动的配置文件/usr/local/nginx/conf/nginx.conf,你也可以nginx -h查看

# nginx #启动nginx服务

如果没有任何错误信息输出,就表示nginx服务正常启动了。可以用ps -ef | grep nginx命令查看nginx服务进程的状态

2、加入-c filename,通过配置文件启动nginx

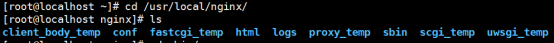

再次查看安装目录下包括的文件:会生成你编译时所加入参数的目录:

接下来我们来看看nginx的安装目录包含的内容:

# ll

total 4

drwx------. 2 nginx root 6 Oct 20 17:12 client_body_temp

drwxr-xr-x. 2 root root 4096 Nov 7 21:25 conf

drwx------. 2 nginx root 6 Oct 20 17:12 fastcgi_temp

drwxr-xr-x. 3 root root 92 Oct 29 22:57 html

drwxr-xr-x. 2 root root 41 Nov 7 23:59 logs

drwx------. 12 nginx root 96 Oct 20 22:40 proxy_temp

drwxr-xr-x. 2 root root 19 Oct 20 17:09 sbin

drwx------. 2 nginx root 6 Oct 20 17:12 scgi_temp

drwx------. 2 nginx root 6 Oct 20 17:12 uwsgi_temp

nginx服务器的安装目录主要包括conf、html、logs、sbin等4个目录:

-

conf目录中存放了nginx的所有配置文件。而nginx.conf文件时nginx服务的主配置文件,其他的文件时用来配置nginx的相关功能的,比如,配置fastcgi使用的fastcgi.conf和fastc_params两个文件。在此目录下,所有的配置文件都提供了以.default结尾的默认配置文件,方便我们将配置过的.conf文件恢复到初始状态

-

html目录中存放了nginx服务器在运行过程中调用的一些html网页文件。其他index.html文件,是nginx服务器运行成功后,默认调用的网页,提示用户nginx服务器成功运行了。50x.html则是nginx出现某些问题是将会调用的这个页面

-

logs目录,顾名思义,就是存放nginx服务器的日志的,nginx的日志功能比较强大,有不同种类,并且可以自定义输出格式内容等。

-

sbin目录,目前其中只有nginx一个文件,这就nginx服务器的主程序

注意:在启动nginx服务前,应该先检查下配置文件语法是否正确

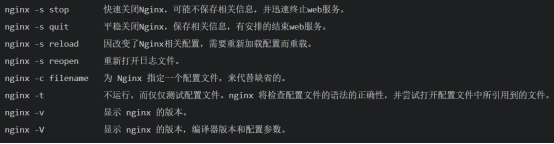

这里简单介绍下二进制文件nginx的相关用法

# nginx -h

nginx version: nginx/1.14.2

Usage: nginx [-?hvVtTq] [-s signal] [-c filename] [-p prefix] [-g directives]

Options:

-?,-h : this help

-v : show version and exit

-V : show version and configure options then exit

-t : test configuration and exit

-T : test configuration, dump it and exit

-q : suppress non-error messages during configuration testing

-s signal : send signal to a master process: stop, quit, reopen, reload

-p prefix : set prefix path (default: /usr/local/nginx/)

-c filename : set configuration file (default: /usr/local/nginx/conf/nginx.conf)

-g directives : set global directives out of configuration file

-v 显示nginx版本信息并退出

-V 显示版本号和nginx的编译情况并退出

-t 测试配置文件的语法正确性并退出

-T 测试配置文件正确性并输出到屏幕,然后退出

-q 测试配置时只显示错误

-s 向主进程发起信号

-c filename 用来指定启动nginx服务使用的配置文件

-p 指定nginx服务器路径前缀

-g directives 指定附加的配置文件路径,向nginx服务指定启动时应用全局的配置

-t可以与-c联用,是输出内容更详细,这对查找配置文件中的语法错误很有帮助,如下是正确配置的情况:

# nginx -t -c /usr/local/nginx/conf/nginx.conf

nginx: the configuration file /usr/local/nginx/conf/nginx.conf syntax is ok

nginx: configuration file /usr/local/nginx/conf/nginx.conf test is successful

-q可以与-t联用,如果配置文件无错误,将不输出任何内容

# nginx -qt

nginx服务的停止

停止nginx服务用两种方法:一、快速停止;二、平缓停止

快速停止是指立即停止当前nginx服务正在处理的所有网络请求,马上丢弃连接,停止工作

平缓停止是指运行nginx服务将当前正在处理的网络请求处理完成,但不在接受新的请求,之后再关闭nginx连接,最后停止工作

停止nginx服务的操作很多:

# nginx -s stop #建议用这种方式,这种方式关闭了nginx不会留下pid文件,防止其他报错行为

# pkill nginx

# killall nginx

# kill -9 2927 #2927是nginx主进程的pid,虽然worker进程是没有杀死的,但是nginx服务是停止了,不建议用这种方式

# curl -I localhost

HTTP/1.1 502 Bad Gateway

Server: nginx/1.14.2

Date: Sun, 01 Dec 2019 08:07:10 GMT

Content-Type: text/html; charset=utf-8

Content-Length: 537

Connection: keep-alive

ETag: "5dac2446-219"

#或者:

# nginx -g TERM | INT | QUIT ->这种操作不行,,,不知道啥原因

其中,TERM | INT信号用于快速停止,QUIT用于平缓停止

nginx服务的重载

更改nginx服务器的配置和加入了新的模块,如果希望当前的nginx服务应用新的配置或者使用新的模块生效,那么就需要重启nginx服务。当然可以先关闭nginx服务,然后使用新的配置文件重启服务。

但是在实际环境中,我们是平滑启动或者是重载配置文件

平滑启动是这样的一个过程:nginx服务接收到信号后,首先读取新的配置文件,乳房配置语法正确,则启动新的nginx服务,然后平缓关闭旧的服务进程;如果新的nginx配置有问题,将显示错误,仍然使用旧的nginx进程提供服务

使用以下命令,实现nginx服务的平滑重启:

# nginx -g HUP [-c newConffile]

-

HUP信号用户发送平滑重启信号

-

newConffile可选项,用于指定新的配置文件路径

重载配置nginx服务:在实际环境中,都是用这种来重载nginx服务

nginx -s reload

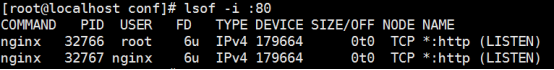

查看端口是否监听着(默认是80)

# lsof -i :80

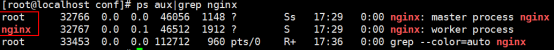

# ps aux|grep nginx

nginx默认会启动一个root 的master进程、剩下就是worker进程,根据worker_processes auto;这个参数来启动的worker进程

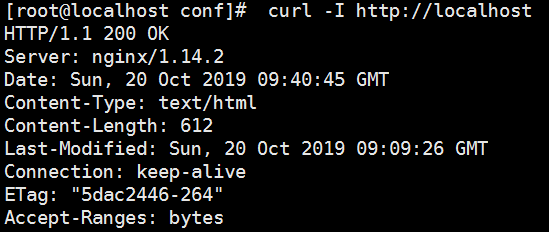

# curl -I http://localhost # 验证nginx 运行状态

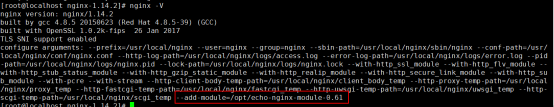

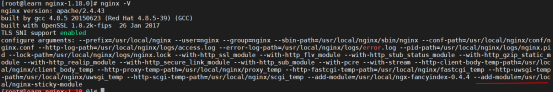

Nginx的编译配置参数

[root@test-7 ~]# nginx -V

nginx version: nginx/1.14.2

built by gcc 4.8.5 20150623 (Red Hat 4.8.5-39) (GCC)

built with OpenSSL 1.0.2k-fips 26 Jan 2017

TLS SNI support enabled

configure arguments: --prefix=/usr/local/nginx --user=nginx --group=nginx --sbin-path=/usr/local/nginx/sbin/nginx --conf-path=/usr/local/nginx/conf/nginx.conf --http-log-path=/usr/local/nginx/logs/access.log --error-log-path=/usr/local/nginx/logs/error.log --pid-path=/usr/local/nginx/logs/nginx.pid --lock-path=/usr/local/nginx/logs/nginx.lock --with-http_ssl_module --with-http_stub_status_module --with-http_gzip_static_module --with-http_realip_module --with-http_secure_link_module --with-http_sub_module --with-pcre --with-stream --http-client-body-temp-path=/usr/local/nginx/client_body_temp --http-proxy-temp-path=/usr/local/nginx/proxy_temp --http-fastcgi-temp-path=/usr/local/nginx/fastcgi_temp --http-uwsgi-temp-path=/usr/local/nginx/uwsgi_temp --http-scgi-temp-path=/usr/local/nginx/scgi_temp

以上就是源码安装时编译用的参数

重新编译和安装nginx

另外,在没有修改nginx的源码情况下,如果需要重新编译和安装nginx,就不必再使用configure脚本自动生成Makefile文件了,直接使用以下命令删除上次安装的nginx软件:

# rm -rf /usr/local/nginx/

然后进入nginx软件包的解压目录,清除上次编译的遗留文件:

# make clean

最后在使用一下命令进行编译和安装nginx:

# make && make install

到此nginx就成功部署完成

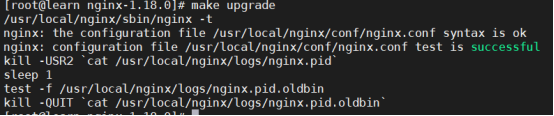

nginx服务器的升级

如果要对当前nginx服务器进行版本升级、应用新模块,最简单的方法就是停止当前nginx服务,然后开启新的nginx服务,缺点就是,在一段时间内无法访问服务器。为了解决此问题,nginx服务器提供平滑升级的功能

按照原来的编译参数安装 nginx 的方法进行安装,只需要到make,不需要执行make install 。

以此建议用户在安装新服务器之前先备份旧服务器。

nginx服务器平滑升级

注意:为了实现nginx服务器的平滑升级,新的服务器安装路径应该和旧的保持一致。以此建议用户在安装新服务器之前先备份旧服务器。以此建议用户在安装新服务器之前先备份旧服务器。

第一步:安装新版本nginx,同时启动2个版本的nginx

第二步:关闭旧版本nginx的worker进程

第三步:优雅关闭旧版本的master进程

第一步:如果你是用systemctl或者service管理nginx服务,那么必须先停止旧版本的nginx,然后用原生的方式启动nginx。

# systemctl stop nginx

# /data/nginx/sbin/nginx -c /data/nginx/conf/nginx.conf # 原生方式启动就版本nginx

# curl -I localhost # 现在的请求都是走的旧的nginx

HTTP/1.1 200 OK

Server: nginx/1.20.2

Date: Mon, 08 Apr 2024 06:27:18 GMT

Content-Type: text/html

Content-Length: 612

Last-Modified: Mon, 08 Apr 2024 06:25:58 GMT

Connection: keep-alive

ETag: "66138df6-264"

Accept-Ranges: bytes

# /data/nginx/sbin/nginx -V

nginx version: nginx/1.20.2

built by gcc 4.8.5 20150623 (Red Hat 4.8.5-44) (GCC)

configure arguments: --prefix=/data/nginx

第二步:编译安装新版本nginx

tar xf nginx-1.24.0.tar.gz

cd nginx-1.24.0 && ./configure --prefix=/data/nginx .... # --prefix=参数必须和旧版本保持一致

make && make install

在Linux服务器如果编译两个nginx的--prefix参数相同,那么sbin/目录下面会存在两个可执行文件,如下:

[root@k8s13343 nginx]# ll sbin/ # 执行make install后就会存在两个nginx可执行文件

total 7620

-rwxr-xr-x 1 root root 3913936 Apr 7 18:17 nginx # 新版本

-rwxr-xr-x 1 root root 3883616 Apr 7 18:15 nginx.old # 旧版本

# /data/nginx/sbin/nginx -V # 现在是最新版本了

nginx version: nginx/1.24.0

built by gcc 4.8.5 20150623 (Red Hat 4.8.5-44) (GCC)

configure arguments: --prefix=/data/nginx

# curl -I localhost # 现在的请求还是走的旧版本nginx

HTTP/1.1 200 OK

Server: nginx/1.20.2

Date: Mon, 08 Apr 2024 06:33:58 GMT

Content-Type: text/html

Content-Length: 612

Last-Modified: Mon, 08 Apr 2024 06:25:58 GMT

Connection: keep-alive

ETag: "66138df6-264"

Accept-Ranges: bytes

第三步:同时启动两个nginx

# ps aux | grep nginx # 查看旧版本nginx的PID

root 12595 0.0 0.0 20572 616 ? Ss 18:25 0:00 nginx: master process /data/nginx/sbin/nginx -c /data/nginx/conf/nginx.conf

nobody 12596 0.0 0.0 21016 1308 ? S 18:25 0:00 nginx: worker process

root 12638 0.0 0.0 112812 976 pts/0 S+ 18:25 0:00 grep --color=auto nginx

kill -USR2 旧版本nginx的master的进程IP

# kill -USR2 12595

# ps aux | grep nginx

root 12595 0.0 0.0 20572 804 ? Ss 18:25 0:00 nginx: master process /data/nginx/sbin/nginx -c /data/nginx/conf/nginx.conf

nobody 12596 0.0 0.0 21016 1308 ? S 18:25 0:00 nginx: worker process

root 20875 0.0 0.0 20580 1592 ? S 18:29 0:00 nginx: master process /data/nginx/sbin/nginx -c /data/nginx/conf/nginx.conf # 第2个nginx的master进程

nobody 20878 0.0 0.0 21024 1312 ? S 18:29 0:00 nginx: worker process # 第2个nginx的worker进程

root 20903 0.0 0.0 112812 980 pts/0 R+ 18:29 0:00 grep --color=auto nginx

# curl -I localhost # 启动新的nginx后,后续的请求都是走的新的nginx

HTTP/1.1 200 OK

Server: nginx/1.24.0

Date: Sun, 07 Apr 2024 10:31:06 GMT

Content-Type: text/html

Content-Length: 612

Last-Modified: Sun, 07 Apr 2024 10:23:45 GMT

Connection: keep-alive

ETag: "66127431-264"

Accept-Ranges: bytes

第四步:把旧版本nginx的worker进程关掉

kill -WINCH 旧版本nginx的worker进程ID

[root@k8s13343 nginx-1.20.2]# ps aux| grep nginx

root 12595 0.0 0.0 20572 804 ? Ss 18:25 0:00 nginx: master process /data/nginx/sbin/nginx -c /data/nginx/conf/nginx.conf

nobody 12596 0.0 0.0 21016 1308 ? S 18:25 0:00 nginx: worker process

root 20875 0.0 0.0 20580 1592 ? S 18:29 0:00 nginx: master process /data/nginx/sbin/nginx -c /data/nginx/conf/nginx.conf

nobody 20878 0.0 0.0 21024 1560 ? S 18:29 0:00 nginx: worker process

root 21296 0.0 0.0 112816 980 pts/0 R+ 18:32 0:00 grep --color=auto nginx

[root@k8s13343 nginx-1.20.2]# kill -WINCH 12596

[root@k8s13343 nginx-1.20.2]# ps aux | grep nginx

root 12595 0.0 0.0 20572 804 ? Ss 18:25 0:00 nginx: master process /data/nginx/sbin/nginx -c /data/nginx/conf/nginx.conf

root 20875 0.0 0.0 20580 1592 ? S 18:29 0:00 nginx: master process /data/nginx/sbin/nginx -c /data/nginx/conf/nginx.conf

nobody 20878 0.0 0.0 21024 1560 ? S 18:29 0:00 nginx: worker process

nobody 21553 0.0 0.0 21016 1308 ? S 18:34 0:00 nginx: worker process

root 21570 0.0 0.0 112812 976 pts/0 S+ 18:34 0:00 grep --color=auto nginx

第四步:把旧版本nginx的master进程关掉

kill -QUIT 旧版本nginx的master进程ID

[root@k8s13343 nginx-1.20.2]# ps aux | grep nginx

root 12595 0.0 0.0 20572 804 ? Ss 18:25 0:00 nginx: master process /data/nginx/sbin/nginx -c /data/nginx/conf/nginx.conf

root 20875 0.0 0.0 20580 1592 ? S 18:29 0:00 nginx: master process /data/nginx/sbin/nginx -c /data/nginx/conf/nginx.conf

nobody 20878 0.0 0.0 21024 1560 ? S 18:29 0:00 nginx: worker process

nobody 21553 0.0 0.0 21016 1308 ? S 18:34 0:00 nginx: worker process

root 21570 0.0 0.0 112812 976 pts/0 S+ 18:34 0:00 grep --color=auto nginx

[root@k8s13343 nginx-1.20.2]# kill -QUIT 12595

[root@k8s13343 nginx-1.20.2]# ps aux | grep nginx # 只有一个nginx服务了

root 20875 0.0 0.0 20580 1592 ? S 18:29 0:00 nginx: master process /data/nginx/sbin/nginx -c /data/nginx/conf/nginx.conf

nobody 20878 0.0 0.0 21024 1560 ? S 18:29 0:00 nginx: worker process

root 21885 0.0 0.0 112812 980 pts/0 S+ 18:37 0:00 grep --color=auto nginx

卸载nginx

# rm -rf /usr/local/nginx

解决云主机的报错

在重启云主机(系统)之后,执行 nginx -t 是OK的,然而在执行 nginx -s reload 的时候报错

nginx: [error] invalid PID number "" in "/run/nginx.pid"

经过查找,找到http://www.cnblogs.com/yuqianwen/p/4285686.html

#需要先执行

nginx -c /etc/nginx/nginx.conf #需要配置文件的全路径

nginx.conf文件的路径可以从`nginx -t`的返回中找到。

nginx -s reload

对nginx的配置文件语法高亮设置

1.下载nginx.vim语法高亮配置到 ~/.vim/syntax,如果不存在则创建该目录

cd ~/.vim/syntax

wget http://www.vim.org/scripts/download_script.php?src_id=14376 -O nginx.vim

http://www.vim.org/scripts/script.php?script_id=1886 #这里使用的是0.3.3版本

2.增加配置~/.vim/filetype.vim 到最后一行,如果文件不存在则创建

vim ~/.vim/filetype.vim

加入如下内容:

au BufRead,BufNewFile /etc/nginx/* set ft=nginx

其中红色路径为你的nginx.conf文件路径

Nginx基本配置指令(重点)

注意:

在nginx配置中,每一条指令配置必须已分号结束,切记。

nginx.conf配置文件一共由三部分组成,分别为:全局块、events块和http块。在http块中,又包含http全局快、多个server块。每个server块,可以包含server全局块和多个location块。在用一个配置块中嵌套的配置块,各个之间不存在次序关系。

配置文件支持大量可配置的指令,绝大多数指令不是特定属于某一块的。用一个指令放在不同层级的块中,其作用域不同,一般情况下,高一级块中的指令可以作用于自身所在的块和此块包含的所有低层级块。

如果某个指令在两个不同层级的块同时出现,则采用"就近原则",即以较低层级块中的配置为准。比如,某指令同时出现在http全局块中和server块中,并且配置不同,则应该以server块中的配置为准

conf目录中内容

nginx.conf --- nginx程序的主配置文件

nginx.conf.default --- nginx配置备份文件

因为初始化的nginx配置文件内有较多注释,影响对配置文件的修改,所以进行精简化配置文件

[root@test-7 ~]# vim /etc/nginx/conf.d/default.conf #(如果主配置文件没有配置,就默认读取这个默认的配置里面的内容)

A、全局块配置

全局块是默认配置文件从开始到events块之间的配置内容,主要设置一些影响nginx服务器整体运行的配置指令,因此,这些指令的作用域是nginx服务器全局

通常包括配置运行nginx服务器的用户、用户组、运行生成的worker process数、nginx进程pid、存放路径、日志存放路径和类型以及配置文件引入等。

全局配置->nginx在运行时与具体业务功能(比如http服务或者email服务代理)无关的一些参数,比如工作进程数,运行的身份等

user nginx nginx;

worker_processes auto;

error_log /usr/local/nginx/logs/error.log info;

pid /usr/local/nginx/logs/nginx.pid;

worker_rlimit_nofile 51200;

daemon on;# daemon off 可关闭 Nginx 后台守护进程,默认开启.在docker中需要关闭,让进程在前台启动

参数解释:

#定义Nginx运行的用户和用户组

user www www; 配置为nginx运行用户及用户组,否则报403错误

#nginx进程数,建议设置为等于CPU总核心数。

worker_processes auto;

• woker_processes 2

在配置文件的顶级main部分,worker角色的工作进程的个数,master进程是接收并分配请求给worker处理。这个数值简单一点可以设置为cpu的核数grep ^processor /proc/cpuinfo | wc -l,也是 auto 值,如果开启了ssl和gzip更应该设置成与逻辑CPU数量一样甚至为2倍,可以减少I/O操作。如果nginx服务器还有其它服务,可以考虑适当减少。

#全局错误日志定义类型,[ debug | info | notice | warn | error | crit ]

error_log /var/log/nginx/error.log info;

关键字:其中关键字error_log不能改变

日志文件:可以指定任意存放日志的目录

错误日志级别:常见的错误日志级别有[debug | info | notice | warn | error | crit | alert | emerg],级别越高记录的信息越少。

生产场景一般是 warn | error | crit 这三个级别之一

#进程文件

pid /usr/local/nginx/logs/nginx.pid;

• worker_rlimit_nofile 10240

#写在main部分。默认是没有设置,可以限制为操作系统最大的限制65535

#一个nginx进程打开的最多文件描述符数目,理论值应该是最多打开文件数(系统的值ulimit -n)与nginx进程数相除,但是nginx分配请求并不均匀,所以建议与ulimit -n的值保持一致。

• worker_cpu_affinity

#也是写在main部分。在高并发情况下,通过设置cpu粘性来降低由于多CPU核切换造成的寄存器等现场重建带来的性能损耗。如worker_cpu_affinity 0001 0010 0100 1000; (四核)。

B、events块配置 ->I/O事件配置

events块涉及的指令主要影响nginx服务器与用户的网络连接。常用到的设置包括是否开启对多worker process下的网络连接进行系列化,是否允许同时接收多个网络连接,选取哪种事件驱动模型处理连接请求,每个worker process可以同时支持的最大连接数等

该部分指令对nginx服务器的性能影响较大,在实际情况中应该根据实际情况灵活调整。

events {

use epoll; #使用epoll模型

worker_connections 65535; #每个worker进程支持的最大连接数

multi_accept on;

accept_mutex on;

}

使用"events"界定标记,用来指定nginx进行的I/O响应模型,每个进行的连接数量设置。对于2.6及以上版本内核,建议使用epoll模型以提高性能;每个进程的连接数应根据实际需求来定,一般在10000以下(默认为1024)

工作模式与连接数上限

work_connection:每个进程数的最大连接,这个是工作中必须优化的,一般是10000个,就可以达到要求

参数解释:

·use epoll #use 设置用于复用客户端线程的轮询方法

写在events部分。在Linux操作系统下,nginx默认使用epoll事件模型,得益于此,nginx在Linux操作系统下效率相当高。同时Nginx在OpenBSD或FreeBSD操作系统上采用类似于epoll的高效事件模型kqueue。在操作系统不支持这些高效模型时才使用select。

#参考事件模型,use [ kqueue | rtsig | epoll | /dev/poll | select | poll ]; epoll模型是Linux 2.6以上版本内核中的高性能网络I/O模型,如果跑在FreeBSD上面,就用kqueue模型。

• epoll是多路复用I/O中的一种方式,epoll 有两种工作模式:LT(水平触发)模式和 ET(边缘触发)模式。

默认情况下,epoll 采用 LT 模式工作,这时可以处理阻塞和非阻塞套接字。ET 模式的效率要比 LT 模式高,它只支持非阻塞字。ET 和 LT 模式的区别在于,当一个新的事件到来时,ET 模式下当然可以从 epoll_wait调用中获取这个事件,可是如果这次没有把这个事件对应的套接字缓冲区处理完,在这个套接字没有新的事件再次到来时,在 ET 模式下是无法再次从epoll_wait 调用中获取这个事件的;而 LT 模式则相反,只要一个事件对应的套接字缓冲区还有数据,就总能从 epoll_wait中获取这个事件。因此,LT 模式相对简单,而在 ET 模式下事件发生时,如果没有彻底地将缓冲区数据处理完,则会导致缓冲区中的用户请求得不到响应。默认情况下,Nginx 是通过 ET 模式使用 epoll 的。

·worker_connections 2048 #最大连接数=连接数*进程数

写在events部分。每一个worker进程能并发处理(发起)的最大连接数(包含与客户端或后端被代理服务器间等所有连接数)。nginx作为反向代理服务器,计算公式 最大连接数 = worker_processes * worker_connections/4,所以这里客户端最大连接数是1024,这个可以增到到8192都没关系,看情况而定,但不能超过后面的worker_rlimit_nofile。当nginx作为http服务器时,计算公式里面是除以2。

·multi_accept 告诉nginx收到一个新连接通知后接受尽可能多的连接

C、http块配置

http块是nginx服务器配置中的重要部分,代理、缓存和日志定义等绝大多数的功能及第三方模块配置都可以放在这个快中。

在本书中,我们使用http全局快,来表示http中自己的全局块,即http块中不包含在server块中的部分

可以在http全局中配置的指令包括文件引入、MIME-type定义、日志定义、是否使用sendfile传输文件、连接超时时间、单链接请求数上限等

作用->与提供http服务相关的一些配置参数。例如:是否使用keepalive啊,是否使用gzip进行压缩等

http {

include mime.types; #Nginx支持的媒体类型库文件

default_type application/octet-stream; #默认的媒体类型

#log_format main '$remote_addr - $remote_user [$time_local] "$request" '

# '$status $body_bytes_sent "$http_referer" '

# '"$http_user_agent" "$http_x_forwarded_for"';

#access_log logs/access.log main; #访问日志位置

sendfile on; #支持文件发送(下载)

#tcp_nopush on; #告诉nginx在一个数据包里发送所有头文件,而不一个接一个的发送

keepalive_timeout 65; ##给客户端分配keep-alive连接超时时间

#gzip on; #开启gzip压缩

server { #web服务的监听配置

listen 80; #监听地址及端口

server_name localhost; #网站名称(FQDN)

#ssl_protocols TLSv1 TLSv1.1 TLSv1.2; #协议配置

#ssl_ciphers AES128-SHA:AES256-SHA:RC4-SHA:DES-CBC3-SHA:RC4-MD5; #加密套件配置

#charset utf-8; #网页默认字符集

location / { #根目录配置;匹配任何查询,因为所有请求都以 / 开头

root html; #网站根目录的位置;指定对应uri的资源查找路径,这里html为相对路径

index index.html index.htm; #默认首页(索引页);指定首页index文件的名称,可以配置多个,以空格分开。如有多个,按配置顺序查找

}

#error_page 404 /404.html;

# redirect server error pages to the static page /50x.html

error_page 500 502 503 504 /50x.html; #内部错误的反馈页面

location = /50x.html {

root html; #指定对应的站点目录为html

}

}

D、server块

server块和"虚拟主机"的概念密切联系。

虚拟主机,又称虚拟服务器、主机空间或者网页空间,它是一种技术。该技术是为了节省互联网服务器硬件成本而出现的。这里的"主机"或者"空间"是由实体的服务延伸而来的,硬件系统可以基于服务器群,或者单个服务器等。

虚拟主机技术主要应用于http、ftp及EMAIL等多项服务,将一台服务器的某项或者全部服务内容逻辑划分为多个服务单位,对外表现为多个服务器,从而充分利用服务器硬件资源。

从用户的角度来看,一台虚拟主机和一台独立的硬件主机时完全一样的。

在使用nginx服务器提供web服务时,利用虚拟主机的技术就可以避免为每一个要运行的网站提供单独的nginx服务器,也无需为每个网站对应运行一组nginx进程。虚拟主机技术使得nginx服务器可以在同一台服务器上只运行一组nginx进程,就可以运行多个网站

注意:和http块相同,server块也可以包含自己的全局块,同时可以包含多个location块。在server全局块中,最常见的两个配置项是虚拟主机的监听配置和本地虚拟主机的名称或者IP配置

E、location指令

每个server块可以包含多个location块。从严格意义上来说,location其实是server块的一个指令,但是由于其在整个nginx配置文件中起着重要作用,而且nginx服务器在许多功能上的灵活性往往在location指令的配置中体现出来

location指令的主要作用,基于nginx服务器接收请求字符串(例如,server_name/uri-string)对除虚拟主机名称(也可以是IP别名)之外的字符串(/uri-string)进行匹配,对特定的请求进行匹配。地址定向、数据缓存和应答控制等功能。许多第三方模块的配置也是在location块中提供功能

配置运行nginx服务器用户、用户组

指令user,其语法格式:

user user [group];

-

user指定可以运行nginx服务器的用户

-

group可选项,指定可以运行nginx服务器的用户组

只有被设置的用户或者用户组成员才能有权限启动nginx进程。

如果希望所有用户都可以启动nginx进程,有两种方法:(但是实际环境中,不允许所有用户启动nginx进程哈!!!!)

一、将此指令注释掉

#user nginx nginx;

二、将用户和用户组设置为nobody,这也是user指令的默认配置,user指令只能在全局快配置

user nobody nobody;

配置允许生成的worker process数

worker process是nginx服务器实现并发处理服务的关键所在。从理论上来说,worker process的值越大,可以支持的并发处理量也越多,但是实际上它还是受到来自软件本身、操作系统本身资源和能力、硬件设备(如CPU和磁盘驱动器)等的制约。

指令worker_process,其语法格式:

worker_processes auto | number;

-

number指定nginx进程最多可以产生的worker process数

-

auto设置此值,nginx进程将自动检测

在默认配置文件中,number=1启动nginx服务器后,可以使用如下命令查看:

# ps aux|grep nginx |grep -v grep

root 7505 0.0 0.1 46188 2060 ? Ss 18:02 0:00 nginx: master process nginx

nginx 7998 0.0 0.1 46596 1984 ? S 18:14 0:00 nginx: worker process

配置nginx主进程pid存放路径

nginx进程作为系统的守护进程运行,如果需要在某文件中保存当前运行程序的主进程号。nginx支持对它的存放路径进行自定义配置

指令pid,其语法格式:

pid path_file-name;

path_file-name指定存放路径和文件名

配置文件默认将此文件存放在nginx安装目录logs下,名字为nginx.pid。path可以是绝对路径,也可以是以nginx安装目录为根目录的相对路径。

注意:

在指定path的时候,一定要包括文件名,如果只设置了路径,没有设置文件名,会报一下错误:

nginx: [crit] pread() "/usr/local/nginx/logs/" failed (21: Is a directory)

此指令也只能在全局快配置

配置错误日志的存放路径

在全局块、http块和server块中都可以对nginx服务器日志进行相关配置。

指令error_log,其语法格式:

error_log path_filel |stderr[debug|info|notice|warn|error|crit|alert|emerg];

从语法结构可以看到,nginx服务器的日志支持输出到某一固定的文件file或者输出到标准错误输出stderr;日志级别是可选项,有低到高分为debug(需要在编译时使用--with-debug开启debug开关)|info|notice|warn|error|crit|alert|emerg

注意:

不要配置info等级较低的级别,会带来大量的磁盘I/O消耗

设置某一级别后,比这一级别高的日志也会被记录。比如设置error级别后,级别为error以及crit、alert、emerg的日志都会被记录下来。

指定的文件对于运行nginx进程的用户具有写权限,否则在启动nginx进程的时候会出现无法打开该文件,且权限失败的字眼

日志的级别越高,那么输出的内容就越少

此指令可以在全局快、http块、server块以及location指令中配置,但是错误日志一般就在全局配置中设置就行了,除非有其他需要就才对应块进行设置

配置文件的引入

此指令可以放在配置文件的任意地方

在一些情况下,我们可能需要将其他的nginx配置或者第三方模块的配置引用到当前的主配置文件中。nginx提供了include指令来完成配置文件的引入,语法如下:

include file;

其中,file是要引入的配置文件,它支持相对路径和绝对路径,并且支持通配符

注意:新引入进来的文件同样要求运行nginx进程的用户对其具有写权限,并且符合nginx配置文件规定的相关语法和结构

设置网络连接的序列化

在\<\

为了解决此问题,nginx配置中包含了这样一条指令accept_mutex,当其设置为开启的时候,将会对多个nginx进程接收连接进行序列化,防止多个进程对其连接的争抢。语法结构如下:

accept_mutex on|off;

此指令默认为开启(on)状态,只能在events块进行配置

设置是否允许同时接收多个网络连接

此指令只能在events块进行配置

每个nginx服务器的worker process都有能力同时接收多个新到达的网络连接,但是这需要在配置文件中进行配置,其指令为multi_accept,语法格式如下:

multi_accept on|off;

此指令默认为关闭(off)状态,即每个worker process一次只能接收一个新到达的网络连接。

事件驱动模型选择

nginx服务器提供了多种事件驱动模型来处理网络消息。配置文件中为我们提供了相关的指令来强制nginx服务器选择哪种事件驱动模型进行消息处理,指令为use,语法结构如下:

use method;

其中,method可选择的内容有:select、poll、kqueeu、epoll、rtsig、/dev/poll以及eventport

注意:

可以在编译时使用--with-select_module和--without-select_module设置是否强制编译select模块到nginx内核;使用--with-poll_module和--without-poll_module设置是否强制编译poll模块到nginx内核。

此指令 只能在events块中进行配置

配置最大连接数

指令worker_connections主要用来设置允许每一个worker process同时开启的最大连接数。其语法结构为:

worker_connections number;

注意:

这里的number不仅仅包括和前端用户建立的连接数,而是包括所有可能的连接数。另外,number值不能大于操作系统支持打开的最大文件句柄数量。用ulimit -n命令查看打开的最大文件句柄数量

此指令只能在events块进行配置

定义MIME-type

在常用浏览器中,可以显示的内容有HTML、xml、GIF及flash等种类繁多的文本、媒体等资源,浏览器为了区分这些资源,需要使用MIME Type。换言之,MIME type是网络资源的媒体类型

nginx服务器作为web服务器,必须能够识别前端请求的资源类型

在默认的nginx配置文件中,我们看到在http全局块中有一下两行配置:

include mime.types;

default_type application/octet-stream;

第一行从外部引用了mime_types文件,我们来查看下它的内容片段:

# cat /usr/local/nginx/conf/mime.types

types {

text/html html htm shtml;

text/xml xml;

……………………………省略…………………………

image/gif gif;

video/quicktime mov;

}

从mime_types文件的内容片断可以看到,其中定义了一个type结构,结构中包含了浏览器能够识别的MIME类型以及对应相关类型的文件后缀名。

由于mime_types文件时主配置文件应用的第三方文件,因此,types也是nginx配置文件中的一个配置块,我们可以称为types块

其用于定义MIME类型。

第二行中使用指令default_type配置了用于处理前端请求的MIME类型,其语法结构为:

default_type mime-type;

其中,mime-type为types块中定义的MIME-type,如果不加此指令,默认值为test/plain。

此指令可以在http块、server块、location指令中进行配置

自定义服务日志

在全局块中,error_log指令,其用于配置nginx进程运行时的日志存放位置及级别,此处所指的日志与常规的不同,它是指记录nginx服务器提供服务过程应答前端请求的日志,我们将其称为服务日志来区分开

nginx服务器支持对服务日志的格式,大小,输出等进行配置,需要使用两个指令,分别是access_log和log_format指令。

assess_log指令的语法结构为:

access_log path [format [buffer=size]]

-

path配置服务日志的文件存放的路径和名称

-

format可选项,自定义服务日志的格式字符串,也可以通过"格式串的名称"使用log_format指令定义好的格式。"格式串的名称"在log_format指令中定义

-

size配置临时存放日志的内存缓存区的大小

此指令可以在http块、server块、location指令中进行设置

access_log /usr/local/nginx/logs/access.log combined;

其中,combined为log_format指令默认定义的日志格式字符串的名称

如果需要取消记录服务日志的功能,则使用:

access_log off;

和access_log联合使用的另一个指令是log_format,它专门定义服务日志的格式,并且可以为格式字符串定义一个名字,以便access_log指令可以直接调用。语法如下:

log_format name string ……; 此指令只能在http块中进行配置

-

name,格式字符串的名字,默认的名字为combined

-

string,服务日志的格式字符串。在定义过程中,可以使用nginx配置预设的一些变量获取相关内容,变量的名称使用双引号括起来,string整体使用单引号括起来。

实例:

#log_format main '$remote_addr - $remote_user [$time_local] "$request" '

# '$status $body_bytes_sent "$http_referer" '

# '"$http_user_agent" "$http_x_forwarded_for"';

#access_log logs/access.log main;

| Nginx日志变量 | 说明 |

|---|---|

| $remote_addr | 记录访问网站的客户端地址;即源 ip地址 |

| $http_x_forwarded_for | 当前端有代理服务器时,设置web节点记录客户端地址的配置,此参数生效的前提是代理服务器上也进行了相关的 x_forwarded_for设置可以记录用户真实的IP地址信息 |

| $remote_user | 远程客户端用户名称 |

| $request | 用户的 http请求和http协议起始行信息 |

| $status | http状态码,记录请求返回的状态,例如:200,404,301等 |

| $body_bytes_sents | 服务器发送给客户端的响应body字节数;不包括响应头的大小 |

| $http_referer | 记录此次请求是从哪个链接访问过来的,可以根据referer进行防盗链设置即表示是哪个网站介绍过来的 |

| $http_user_agent | 记录客户端访问信息,例如:浏览器、手机客户端等 |

| $bytes_sent | 发送给客户端的总字节数 |

| $connection | 连接的序列号 |

| $connection_requests | 当前通过一个连接获得的请求数量 |

| $msec | 日志写入时间。单位为秒,精度是毫秒 |

| $pipe | 如果请求是通过HTTP流水线(pipelined)发送,pipe值为"p",否则为"." |

| $request_length | 请求的长度(包括请求行,请求头和请求正文) |

| $request_time | 请求处理时间,单位为秒,精度毫秒 |

| $time_iso8601 | ISO8601标准格式下的本地时间 |

| $time_local | 记录访问时间与时区 |

| $upstream_addr | 负载均衡时,转发的真实后端地址 |

| $upstream_status | 负载均衡时,转发后端时的状态码 |

| $request_time | 服务端从接受客户端请求的第一个字节到服务端应用程序处理完发送完响应数据的时间,包括请求数据时间、程序响应时间、输出响应时间 |

| $upstream_response_time | 指nginx向后端如php,tomcat等建立连接开始到到处理完数据关闭连接为止的时间。$request_time肯定比$upstream_response_time值大,特别是使用POST方式传递参数时,因为Nginx会把request body缓存住,接受完毕后才会把数据一起发给后端。所以如果用户网络较差,或者传递数据较大时,$request_time会比$upstream_response_time大很多。参考: https://blog.51cto.com/qiangsh/1743207 |

| $upstream_cache_status | 记录缓存的命中率到日志中 |

在没有特殊要求的情况下,采用默认的配置即可,更多可以设置的记录日志信息的变量见: http://nginx.org/en/docs/http/ngx_httpJog_module.html

配置允许sendfile方式传输文件

在Apache、lighttpd服务器配置中,都有和sendfile相关配置,主要学习下配置sendfile传输方式的相关指令sendfile和sendfile_max_chunk,语法结构如下:

sendfile on|off;

用于开启或者关闭使用sendfile()传输文件,默认值off

该指令可以http块、server块、location指令中进行配置

sendfile_max_chunk size;

其中,size值如果大于0,nginx进程的每个worker process每次调用sendfile()传输的数据量最大不能超过这个值;如果设置为0,则无限制。默认值也是为0

此指令可以在http块、server块、location块中配置

配置实例:

sendfile_max_chunk 128k;

配置连接超时时间

与用户建立会话连接后,nginx服务器可以保持这些连接打开一段时间,指令keepalive_timeout就是用来设置此时间的,语法结构如下:

keepalive_timeout timeout [header_timeout];

-

timeout,服务器端对连接保持时间。默认值75s

-

header_timeout,可选项,在应答报文头部的Keep-Alive域设置超时时间:

"Keep-Alive:timeout=header_timeout"。报文在的这个指令可以被Mozilla或者konqueror识别

实例:

keepalive_timeout 120s 100s;

其含义,在服务器保持连接的时间设置120s,发给用户端的应答报文头部中Keep-Alive域的超时时间设置为100s

此指令可以出现在http块、server块和location指令中配置

单连接请求上限

nginx服务器和用户端建立会话连接后,用户端通过此连接发送请求。指令keepalive_requests用于限制用户通过某一连接向nginx服务器发送请求的次数。语法结构如下:

keepalive_requests number;

此指令还可以出现在server块和location中,默认值是100

配置网络监听

第一种:配置监听的IP地址

第二种:配置监听端口

第三种:配置UNIX Domain Socker

-

IP地址,如果是ipv6,需要使用中括号括起来,比如[dsadas::55],如果自定义了ip地址没有定义端口号,那么端口号就是80

-

端口号,如果只定义了端口号,那么ip就是0.0.0.0

-

socket文件路径,如/var/run/nginx.socket

配置主机名称

指令为server_name,语法结构如下:

server_name name……

对于name来说,可以是一个名称,也可以由多个名称并列,之间用空格隔开。每个名字就是一个域名,由2段或者3端组成,之间由.隔开

name中可以使用通配符*,但是通配符只能用在由三段字符串组成的名字的首段或者尾段,或者有2段字符串组成的名称的尾段,如下:

server_name *.test.com www.test.*;

在name中还可以使用正则表达式,并使用波浪号~作为正则表达式字符串的开始标记,如下:

server_name ~^www\d\.test\.com$;

由于server_name指令支持使用通配符和正则表达式两种配置名称的方式,因此在包含有多个虚拟主机的配置文件,可能会出现一个名称被多个虚拟主机的server_name匹配成功。那么,来自这个名称的请求到底要交给哪个虚拟主机处理呢?nginx服务器做了如下规定:

a.对于匹配方式不同,按照以下方式进行处理,排在前面的优先处理请求

1、准确匹配server_name

2、通配符在开始时匹配server_name成功

3、通配符在结尾时匹配server_name成功

4、正则表达式匹配server_name成功

b.在以上四种匹配方式中,如果server_name被处于同一优先级的匹配方式多次匹配成功,则首先匹配成功的虚拟主机处理请求

http完整配置-1及详解

http {

include mime.types;

server_tokens off;

#charset utf-8;

default_type application/octet-stream;

#default_type text/html;

large_client_header_buffers 4 32k;

client_max_body_size 1024m;

client_body_buffer_size 10m;

sendfile on;

tcp_nopush on;

tcp_nodelay on;

keepalive_timeout 120;

server_names_hash_max_size 512;

#服务器名字的hash表最大值

server_names_hash_bucket_size 128;

#如果Nginx检查语法提示需增大server_names_hash_max_size或server_names_hash_bucket_size,那么首要增大hash_max_size

client_header_timeout 10;

client_body_timeout 10;

reset_timedout_connection on;

send_timeout 10;

log_format main '"$http_x_forwarded_for" - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" $remote_addr';

#fastcgi配置

fastcgi_connect_timeout 300;

fastcgi_send_timeout 300;

fastcgi_read_timeout 300;

fastcgi_buffer_size 64k;

fastcgi_buffers 4 64k;

fastcgi_busy_buffers_size 128k;

fastcgi_temp_file_write_size 128k;

#Gzip Compression

gzip on;

gzip_buffers 16 8k;

gzip_comp_level 6;

gzip_http_version 1.1;

gzip_min_length 256;

gzip_proxied any;

gzip_vary on;

gzip_disable "MSIE [1-6]\.(?!.*SV1)";

#gzip_disable "msie6";

gzip_types

text/xml application/xml application/atom+xml application/rss+xml application/xhtml+xml image/svg+xml

text/javascript application/javascript application/x-javascript

text/x-json application/json application/x-web-app-manifest+json

text/css text/plain text/x-component

font/opentype application/x-font-ttf application/vnd.ms-fontobject

image/x-icon;

#If you have a lot of static files to serve through Nginx then caching of the files' metadata (not the actual files' contents) can save some latency.

open_file_cache max=1000 inactive=20s;

open_file_cache_valid 30s;

open_file_cache_min_uses 2;

open_file_cache_errors on;

server{

listen 80 default;

location / {

return 403;

}

}

# server{

# listen 81;

# ## server_name ; #绑定域名

# index index.htm index.html; #默认文件

# root /home/www/; #网站根目录

# location ~ .*.jsp$ {

# proxy_pass http://localhost:8080;

# proxy_set_header Host $host:$server_port;

# }

# location ~ .*.php$ {

# proxy_pass http://localhost:80;

# proxy_set_header Host $host:$server_port;

# }

# location / {

# try_files $uri $uri/ /index.html;

# }

# }

access_log off;

#将服务器404错误页面重定向到静态页面/404.html

#error_page 404 /404.html;

#将服务器错误页面重定向到静态页面/50x.html

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

include vhost/*.conf;

}

参数解释:

·include

只是一个在当前文件中包含另一个文件内容的指令。这里我们使用它来加载稍后会用到的一系列的MIME类型。

·default_type

设置文件使用的默认的MIME-type。

• server_tokens

并不会让nginx执行的速度更快,但它可以关闭在错误页面中的nginx版本数字,这样对于安全性是有好处的

• charset utf-8; # charset UTF-8;

设置我们的头文件中的默认的字符集

• sendfile on

开启高效文件传输模式,sendfile指令指定nginx是否调用sendfile函数来输出文件,减少用户空间到内核空间的上下文切换。对于普通应用设为 on,如果用来进行下载等应用磁盘IO重负载应用,可设置为off,以平衡磁盘与网络I/O处理速度,降低系统的负载。

• tcp_nopush

告诉nginx在一个数据包里发送所有头文件,而不一个接一个的发送

• tcp_nodelay

告诉nginx不要缓存数据,而是一段一段的发送当需要及时发送数据时,就应该给应用设置这个属性,这样发送一小块数据信息时就不能立即得到返回值

Nginx的TCP配置:

HTTP是一个应用层协议,在传输层使用TCP协议。在TCP协议中,数据是以一块一块的TCP数据包传输的。Nginx提供了多个directive,可以用来调整TCP栈。

TCP_NODELAY

TCP/IP网络有一个"小数据包"的问题,如果一条信息中只有一个字符,那么网络可能会堵塞。这样的数据包大小为41字节,其中TCP信头40字节,内容为1字节。像这种小数据包,它们的开销是4000%。大量的小数据包可以迅速让网络饱和。

John Nagle发明了Nagle算法,它在一定的时间段,将小数据包暂存,将这些小数据包集合起来,整合为一个数据包发送,在下一个时间段又是如此。这改善了网络传输的效率。时间段通常为200ms。

但值得注意的是,小数据包的问题在telnet的通信过程中仍然存在。在telnet中,每一次敲键都分别在网络发送。不过这跟web服务器没有关联。web服务器发送的文件大多是大数据包,所以它们会被立即发送,而不需要等待200ms。

TCP_NODELAY可以用来关闭Nagle的缓冲算法,将数据尽快地发送。Nginx可以在http, server, location当中定义

http {

tcp_nodelay on;

}

Nginx默认启用了tcp_nodelay。Nginx在keep-alive模式下会使用tcp_nodelay。

TCP_CORK

除了Nagle算法外,Linux内核提供了一个TCP_CORK选项,也可以解决小数据包问题。TCP_CORK告诉TCP栈将数据包附加在另外一个数据包,当数据包饱和时或程序明确地指示发送时再发送。在FreeBSD和Mac OS系统上,TCP_NOPUSH选项相当于TCP_CORK。

Nginx可以在http, server和location模块中定义tcp_nopush。

http {

tcp_nopush on;

}

Nginx默认启用了tcp_nopush

上面的两个directives负责不同的任务。tcp_nodelay可以降低网络延迟,而tcp_nopush可以优化发送的数据包。

同时启用tcp_nopush和sendfile可以确保在传输文件时,内核总是生成最大量的完整TCP数据包以供传输,而最后一个TCP数据包可以是不完整的,这个不完整的数据包

• keepalive_timeout 65 50;

长连接超时时间,单位是秒,这个参数很敏感,涉及浏览器的种类、 后端服务器的超时设置、操作系统的设置,可以另外起一片文章了。长连接请求大量小文件的时候,可以减少重建连接的开销,但假如有大文件上传,65s内没上传完成会导致失败。如果设置时间过长,用户又多,长时间保持连接会占用大量资源。

• send_timeout 60;

用于指定响应客户端的超时时间。这个超时仅限于两个连接活动之间的时间,如果超过这个时间,客户端没有任何活动,Nginx将会关闭连接。

指定客户端的响应超时时间。这个设置不会用于整个转发器,而是在两次客户端读取操作之间。如果在这段时间内,客户端没有读取任何数据,nginx就会关闭连接

• client_max_body_size 10m;

允许客户端请求的最大单文件字节数。如果有上传较大文件,请设置它的限制值

上传文件最大限制,php.ini中也要修改,最后优化时会提及

• client_body_buffer_size 128k;

缓冲区代理缓冲用户端请求的最大字节数

·client_header_timeout 和client_body_timeout

设置请求头和请求体(各自)的超时时间。我们也可以把这个设置低些

client_header_timeout 10;

client_body_timeout 10;

·reset_timeout_connection on;

告诉nginx关闭不响应的客户端连接。这将会释放那个客户端所占有的内存空间

·gzip on;

是告诉nginx采用gzip压缩的形式发送数据。这将会减少我们发送的数据量。

·gzip_disable "MSIE [1-6]\.(?!.*SV1)";

为指定的客户端禁用gzip功能。我们设置成IE6或者更低版本以使我们的方案能够广泛兼容。

·gzip_static

告诉nginx在压缩资源之前,先查找是否有预先gzip处理过的资源。这要求你预先压缩你的文件(在这个例子中被注释掉了),从而允许你使用最高压缩比,这样nginx就不用再压缩这些文件了(想要更详尽的gzip_static的信息,请点击这里)。

·gzip_proxied

允许或者禁止压缩基于请求和响应的响应流。我们设置为any,意味着将会压缩所有的请求。

·gzip_min_length

设置对数据启用压缩的最少字节数。如果一个请求小于1000字节,我们最好不要压缩它,因为压缩这些小的数据会降低处理此请求的所有进程的速度。

·gzip_comp_level

设置数据的压缩等级。这个等级可以是1-9之间的任意数值,9是最慢但是压缩比最大的。我们设置为4,这是一个比较折中的设置。

·gzip_type

设置需要压缩的数据格式。上面例子中已经有一些了,你也可以再添加更多的格式

# cache informations about file descriptors, frequently accessed files

# can boost performance, but you need to test those values

·open_file_cache

打开缓存的同时也指定了缓存最大数目,以及缓存的时间。我们可以设置一个相对高的最大时间,这样我们可以在它们不活动超过20秒后清除掉。

·open_file_cache_valid

在open_file_cache中指定检测正确信息的间隔时间。

·open_file_cache_min_uses

定义了open_file_cache中指令参数不活动时间期间里最小的文件数。

·open_file_cache_errors

指定了当搜索一个文件时是否缓存错误信息,也包括再次给配置中添加文件。我们也包括了服务器模块,这些是在不同文件中定义的。如果你的服务器模块不在这些位置,你就得修改这一行来指定正确的位置

·underscores_in_headers off;

默认off,配置在http、server中;启用或禁用客户端请求标头字段中下划线的使用。禁用下划线时,名称包含下划线的请求标头字段将标记为无效,并受到ignore_invalid_headers指令的约束

·server_names_hash_max_size 512;

服务器名字的hash表最大值

·server_names_hash_bucket_size 128;

如果Nginx检查语法提示需增大server_names_hash_max_size或server_names_hash_bucket_size,那么首要增大hash_max_size

模块http_proxy

这个模块实现的是nginx作为反向代理服务器的功能,包括缓存功能(另见文章)

• proxy_connect_timeout 60

nginx跟后端服务器连接超时时间(代理连接超时)

• proxy_read_timeout 60

连接成功后,与后端服务器两个成功的响应操作之间超时时间(代理接收超时)

• proxy_buffer_size 4k

设置代理服务器(nginx)从后端realserver读取并保存用户头信息的缓冲区大小,默认与proxy_buffers大小相同,其实可以将这个指令值设的小一点

• proxy_buffers 4 32k

proxy_buffers缓冲区,nginx针对单个连接缓存来自后端realserver的响应,网页平均在32k以下的话,这样设置

• proxy_busy_buffers_size 64k

高负荷下缓冲大小(proxy_buffers*2)

• proxy_max_temp_file_size

当proxy_buffers放不下后端服务器的响应内容时,会将一部分保存到硬盘的临时文件中,这个值用来设置最大临时文件大小,默认1024M,它与proxy_cache没有关系。大于这个值,将从upstream服务器传回。设置为0禁用。

• proxy_temp_file_write_size 64k

当缓存被代理的服务器响应到临时文件时,这个选项限制每次写临时文件的大小。proxy_temp_path(可以在编译的时候)指定写到哪那个目录。

proxy_pass,proxy_redirect见 location 部分。

-

gzip on : 开启gzip压缩输出,减少网络传输。

-

gzip_min_length 1k :设置允许压缩的页面最小字节数,页面字节数从header头得content-length中进行获取。默认值是20。建议设置成大于1k的字节数,小于1k可能会越压越大。

-

gzip_buffers 4 16k :设置系统获取几个单位的缓存用于存储gzip的压缩结果数据流。4 16k代表以16k为单位,安装原始数据大小以16k为单位的4倍申请内存。

-

gzip_http_version 1.0 :用于识别 http 协议的版本,早期的浏览器不支持 Gzip 压缩,用户就会看到乱码,所以为了支持前期版本加上了这个选项,如果你用了 Nginx 的反向代理并期望也启用 Gzip 压缩的话,由于末端通信是 http/1.0,故请设置为 1.0。

-

gzip_comp_level 6 :gzip压缩比,1压缩比最小处理速度最快,9压缩比最大但处理速度最慢(传输快但比较消耗cpu)

-

gzip_types :匹配mime类型进行压缩,无论是否指定,"text/html"类型总是会被压缩的。

-

gzip_proxied any :Nginx作为反向代理的时候启用,决定开启或者关闭后端服务器返回的结果是否压缩,匹配的前提是后端服务器必须要返回包含"Via"的 header头。

-

gzip_vary on :和http头有关系,会在响应头加个 Vary: Accept-Encoding ,可以让前端的缓存服务器缓存经过gzip压缩的页面,例如,用Squid缓存经过Nginx压缩的数据。。

server虚拟主机

http服务上支持若干虚拟主机。每个虚拟主机一个对应的server配置项,配置项里面包含该虚拟主机相关的配置。在提供mail服务的代理时,也可以建立若干server。每个server通过监听地址或端口来区分。

• listen

监听端口,默认80,小于1024的要以root启动。可以为listen *:80、listen 127.0.0.1:80等形式。

• server_name

服务器名,如localhost、www.example.com,可以通过正则匹配。

• ssl_protocols TLSv1 TLSv1.1 TLSv1.2;#协议配置

Nginx的虚拟主机配置,使多个网站可以部署在同一个服务器(同一IP地址)对外提供服务。但是在实际测试中发现,虽然两个配置都在server 块内,ssl_protocols 却属于全局配置,而 ssl_ciphers 却针对特定的虚拟主机起作用

由于 SSLv3 的 POODLE 漏洞, 建议不要在开启 SSL 的网站使用 SSLv3。 你可以简单粗暴的直接禁用 SSLv3,用 TLS 来替代

• ssl_ciphers AES128-SHA:AES256-SHA:RC4-SHA:DES-CBC3-SHA:RC4-MD5;#加密套件

模块http_stream

这个模块通过一个简单的调度算法来实现客户端IP到后端服务器的负载均衡,upstream后接负载均衡器的名字,后端realserver以 host:port options; 方式组织在 {} 中。如果后端被代理的只有一台,也可以直接写在 proxy_pass 。

location->http服务中,某些特定的URL对应的一系列配置项

• root /var/www/html

定义服务器的默认网站根目录位置。如果locationURL匹配的是子目录或文件,root没什么作用,一般放在server指令里面或/下。

• index index.jsp index.html index.htm index.php

定义路径下默认访问的文件名,一般跟着root放

• proxy_pass http:/backend

请求转向backend定义的服务器列表,即反向代理,对应upstream负载均衡器。也可以proxy_pass http://ip:port。

• proxy_redirect off;

proxy_set_header Host \$host:\$server_port;

proxy_set_header X-Real-IP \$remote_addr;

proxy_set_header X-Forwarded-For \$proxy_add_x_forwarded_for;

这四个暂且这样设,如果深究的话,每一个都涉及到很复杂的内容,也将通过另一篇文章来解读。

关于location匹配规则的写法,可以说尤为关键且基础的,参考文章 nginx配置location总结及rewrite规则写法;

http完整配置-2及详解

http {

include mime.types; #文件扩展名与文件类型映射表,#设定mime类型(邮件支持类型),类型由mime.types文件定义

default_type application/octet-stream; #默认文件类型

charset utf-8; #默认编码

server_names_hash_bucket_size 128; #服务器名字的hash表大小

client_header_buffer_size 32k; #上传文件大小限制

large_client_header_buffers 4 64k; #设定请求缓

client_max_body_size 8m; #设定请求缓

sendfile on; #开启高效文件传输模式,sendfile指令指定nginx是否调用sendfile函数来输出文件,对于普通应用设为 on,如果用来进行下载等应用磁盘IO重负载应用,可设置为off,以平衡磁盘与网络I/O处理速度,降低系统的负载。注意:如果图片显示不正常把这个改成off。

autoindex on; #开启目录列表访问,合适下载服务器,默认关闭。

tcp_nopush on; #防止网络阻塞

tcp_nodelay on; #防止网络阻塞

keepalive_timeout 120; #长连接超时时间,单位是秒

#FastCGI相关参数是为了改善网站的性能:减少资源占用,提高访问速度。下面参数看字面意思都能理解。

fastcgi_connect_timeout 300;

fastcgi_send_timeout 300;

fastcgi_read_timeout 300;

fastcgi_buffer_size 64k;

fastcgi_buffers 4 64k;

fastcgi_busy_buffers_size 128k;

fastcgi_temp_file_write_size 128k;

#gzip模块设置

gzip on; #开启gzip压缩输出

gzip_vary on;#gzip_vary on 给响应头加上 Vary: Accept-Encoding

gzip_proxied any;#gzip_proxied any 为所有的代理的响应头启用压缩

gzip_http_version 1.1;

#gzip_http_version 1.0; #压缩版本(默认1.1,前端如果是squid2.5请使用1.0)

gzip_comp_level 2; #压缩等级,指定压缩级别[1-9],数字越小,压缩比越小,压缩速度越快

gzip_min_length 1k; #最小压缩文件大小

gzip_buffers 4 16k; #设置缓冲区的个数和大小

gzip_disable "MSIE [1-6]\.";#对于特定浏览器禁用压缩功能

gzip_disable "MSIE [1-6]\.(?!.*SV1)";#设定启用压缩的文件类型

#gzip_types text/plain application/x-javascript text/css application/xml;

#压缩类型,默认就已经包含text/html,所以下面就不用再写了,写上去也不会有问题,但是会有一个warn。

gzip_types

text/plain

text/html

text/css

text/javascript

text/xml

application/json

application/x-javascript

application/javascript

application/xml

application/xhtml+xml

application/atom+xml

application/xml+rss

image/png

image/jpeg

image/gif

image/x-icon

image/bmp

image/svg+xml

audio/mpeg

audio/ogg

video/mp4

video/quicktime

video/ogg

video/webm;

#开启限制IP连接数的时候需要使用

#limit_zone crawler $binary_remote_addr 10m;

#配置共享会话缓存大小

ssl_session_cache shared:SSL:10m;

#配置会话超时时间

ssl_session_timeout 10m;

#upstream的负载均衡,weight是权重,可以根据机器配置定义权重。weigth参数表示权值,权值越高被分配到的几率越大。

upstream www.test.com {

server 192.168.80.121:80 weight=3;

server 192.168.80.122:80 weight=2;

}

#虚拟主机的配置

server {

#监听端口

listen 80;

#域名可以有多个,用空格隔开

server_name www.test.com test.com;

#设置长连接

keepalive_timeout 70;

#HSTS策略

add_header Strict-Transport-Security "max-age=31536000; includeSubDomains; preload" always;

#证书文件

ssl_certificate www.example.com.crt;

#私钥文件

ssl_certificate_key www.example.com.key;

#优先采取服务器算法

ssl_prefer_server_ciphers on;

#使用DH文件

ssl_dhparam /etc/ssl/certs/dhparam.pem;

ssl_protocols TLSv1 TLSv1.1 TLSv1.2;

ssl_ciphers AES128-SHA:AES256-SHA:RC4-SHA:DES-CBC3-SHA:RC4-MD5;

#定义算法

ssl_ciphers AES128-SHA:AES256-SHA:RC4-SHA:DES-CBC3-SHA:RC4-MD5;

#ssl_ciphers "EECDH+ECDSA+AESGCM EECDH+aRSA+AESGCM EECDH+ECDSA+SHA384 EECDH+ECDSA+SHA256 EECDH+aRSA+SHA384 EECDH+aRSA+SHA256 EECDH+aRSA+RC4 EECDH EDH+aRSA !aNULL !eNULL !LOW !3DES !MD5 !EXP !PSK !SRP !DSS !RC4";

#减少点击劫持

add_header X-Frame-Options DENY;

#禁止服务器自动解析资源类型

add_header X-Content-Type-Options nosniff;

#防XSS攻擊

add_header X-Xss-Protection 1;

index index.html index.htm index.php;

root /data/www/test;

location ~ .*\.(php|php5)?$

{

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.php;

include fastcgi.conf;

}

#浏览器缓存,静态资源缓存用expire;图片缓存时间设置

location ~ .*\.(gif|jpg|jpeg|png|bmp|swf)$ {

expires 10d;

}

#浏览器缓存,静态资源缓存用expire;JS和CSS缓存时间设置

location ~ .*\.(js|css)?$ {

expires 1h;

}

#日志格式设定

log_format access '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" $http_x_forwarded_for';

#定义本虚拟主机的访问日志

access_log /var/log/nginx/access.log access;

#对 "/" 启用反向代理

location / {

proxy_pass http://127.0.0.1:888;

proxy_redirect off;

proxy_set_header X-Real-IP $remote_addr;

#后端的Web服务器可以通过X-Forwarded-For获取用户真实IP

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

#以下是一些反向代理的配置,可选。

proxy_set_header Host $host; # 设置浏览器请求的host

client_max_body_size 10m; #允许客户端请求的最大单文件字节数

client_body_buffer_size 128k; #缓冲区代理缓冲用户端请求的最大字节数,

proxy_connect_timeout 90; #nginx跟后端服务器连接超时时间(代理连接超时)

proxy_send_timeout 90; #后端服务器数据回传时间(代理发送超时)

proxy_read_timeout 90; #连接成功后,后端服务器响应时间(代理接收超时)

proxy_buffer_size 4k; #设置代理服务器(nginx)保存用户头信息的缓冲区大小

proxy_buffers 4 32k; #proxy_buffers缓冲区,网页平均在32k以下的设置

proxy_busy_buffers_size 64k; #高负荷下缓冲大小(proxy_buffers*2)

proxy_temp_file_write_size 64k;

#设定缓存文件夹大小,大于这个值,将从upstream服务器传

}

#设定查看Nginx状态的地址

location /NginxStatus {

stub_status on;

access_log on;

auth_basic "NginxStatus";

auth_basic_user_file conf/htpasswd;

#htpasswd文件的内容可以用apache提供的htpasswd工具来产生。

}

#---------------------------------------------------------------

#本地动静分离反向代理配置

#所有jsp的页面均交由tomcat或resin处理

location ~ .(jsp|jspx|do)?$ {

proxy_pass http://127.0.0.1:8080;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

#所有静态文件由nginx直接读取不经过tomcat或resin

location ~ .*.(htm|html|gif|jpg|jpeg|png|bmp|swf|ioc|rar|zip|txt|flv|mid|doc|ppt|pdf|xls|mp3|wma)$ {

expires 15d;

}

location ~ .*.(js|css)?$ {

expires 1h;

}

}

}

nginx.conf

[root@learn conf]# cat nginx.conf

user nginx nginx;

error_log logs/error.log;

pid logs/nginx.pid;

#可以写绝对路径或者相对路径

#pid /usr/local/nginx/logs/nginx.pid;

worker_processes auto;

worker_rlimit_nofile 51200;

worker_cpu_affinity auto;

events {

use epoll;

multi_accept on;

accept_mutex on;

worker_connections 1024;

}

http {

include mime.types;

default_type application/octet-stream;

# log_format main '$remote_addr - $remote_user [$time_local] "$request" '

# '$status $body_bytes_sent "$http_referer" '

# '"$http_user_agent" "$http_x_forwarded_for"';

log_format main '$remote_addr - $http_x_forwarded_for - $remote_user [$time_local] "$request" ' '$status $body_bytes_sent "$http_referer" ' '"$http_user_agent" ';

# server_tokens off;

sendfile on;

charset utf-8;

tcp_nopush on;

tcp_nodelay on;

keepalive_timeout 65 50;

keepalive_requests 100;

send_timeout 60;

client_max_body_size 100m;

client_body_buffer_size 256k;

client_header_timeout 10;

client_body_timeout 10;

reset_timedout_connection on;

client_header_buffer_size 16k;

server_names_hash_max_size 512;

server_names_hash_bucket_size 128;

#proxy_pass http://39.107.229.89:8100;

#proxy_redirect default;

#proxy_set_header X-Real-IP $remote_addr;

#proxy_set_header X-Forwaarded-For $proxy_add_x_forwarded_for;

#proxy_set_header Host $host:$server_port;

#proxy_send_timeout 180;

#proxy_read_timeout 180;

#proxy_connect_timeout 180;

#proxy_buffering on;

#proxy_buffer_size 8k;

#proxy_buffers 8 64k;

#proxy_busy_buffers_size 128k;

#proxy_max_temp_file_size 256k;

#proxy_temp_file_write_size 128k;

#proxy_next_upstream error timeout invalid_header http_500 http_502 http_503 http_504 http_404;

#Gzip Compression

gzip on;

gzip_buffers 16 8k;

gzip_comp_level 6;

gzip_http_version 1.0;

gzip_min_length 1024;

gzip_disable "MSIE [1-6]\.(?!.*SV1)";

gzip_proxied any;

gzip_vary on;

gzip_types

application/atom+xml

application/javascript

application/x-javascript

application/json

application/ld+json

application/manifest+json

application/rss+xml

application/vnd.geo+json

application/vnd.ms-fontobject

application/x-font-ttf

application/x-web-app-manifest+json

application/xhtml+xml

application/xml

font/opentype

image/bmp

image/svg+xml

image/x-icon

text/xml

text/x-json

text/javascript

text/cache-manifest

text/css

text/plain

text/vcard

text/vnd.rim.location.xloc

text/vtt

text/x-component

text/x-cross-domain-policy;

#If you have a lot of static files to serve through Nginx then caching of the files' metadata (not the actual files' contents) can save some latency.

open_file_cache max=1000 inactive=20s;

open_file_cache_valid 30s;

open_file_cache_min_uses 2;

open_file_cache_errors on;

#fastcgi配置

fastcgi_connect_timeout 300;

fastcgi_send_timeout 300;

fastcgi_read_timeout 300;

fastcgi_buffer_size 64k;

fastcgi_buffers 4 64k;

fastcgi_busy_buffers_size 128k;

fastcgi_temp_file_write_size 128k;

#proxy cache

# proxy_cache_path /usr/local/nginx/cache/a levels=1:1 keys_zone=zone_a:10m inactive=300s max_size=5g;

# proxy_cache_path /usr/local/nginx/cache/b levels=1:2 keys_zone=zone_b:100m inactive=300s max_size=5g;

# proxy_cache_path /usr/local/nginx/cache/c levels=1:1:2 keys_zone=zone_c:100m inactive=300s max_size=5g;

#limit_conn && limit_req

# limit_conn_zone $binary_remote_addr zone=one:10m;

# limit_conn_zone $server_name zone=two:10m;

# limit_req_zone $binary_remote_addr zone=three:10m rate=1r/s;

# limit_conn_log_level error;

# limit_conn_status 503;

server {

listen 80;

server_name localhost;

access_log logs/access.log main;

location / {

# try_files $uri $uri/ /index.html;

# root /usr/local/nginx/html;

root html;

index index.html index.htm;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

include /usr/local/nginx/conf/vhost/*.conf;

}

nginx一键生成配置文件

Nginx模块(面试必问)

模块化设计的概念:以"功能块"为单位进行程序设计、实现其求解算法的方法

nginx涉及到的模块分为核心模块、标准HTTP模块、可选HTTP模块、邮件服务模块以及第三方模块等五大类,如下:

-

核心模块是指nginx服务器正常运行必不可少的模块,他们提供了nginx最基本核心服的服务,如进程管路、权限控制、错误日志记录等

-

标准HTTP模块是指编译nginx后包含的模块,其支持nginx服务器的标准HTTP功能

-

可选HTTP模块是指主要用于扩展标准的HTTP功能,使其能处理一些特殊的HTTP请求

-

邮件服务模块主要用于支持nginx邮件服务,默认不编译进nginx,需要自定义加入

-

第三方模块是为了扩展nginx服务器应用,完成特殊功能而由第三方机构或者个人编写的可编译到nginx中的模块

nginx的每个模块都基本符合单一职责原则,在具体环境中可以根据实际情况进行裁减和加入

nginx所有固有模块的源码放在编译目录下的src目录中。在src目录中,我们看到一共分成了core event http mail misc os stream 等7个目录。从这里看,源码包含了邮件服务的模块,但是在快速编译时默认不将其编译到nginx中。

核心模块

核心模块主要包含对两类功能的支持:

一类是主体功能,包括进行管理、权限管理、错误日志记录、配置解析等

另一类是用于响应请求时间必须的功能,包括时间驱动机制、正则表达式解析等。

标准HTTP模块

这些模块在默认情况下是被编译到nginx内核中,除非在配置是添加--without-xxx参数声明不编译

比较重要的标准HTTP模块:

-

ngx_http_core_module 配置端口、URI分析、服务器响应错误处理,别名控制以及其他HTTP核心事务

-

ngx_http_access_module 基于IP地址访问控制(运行/拒绝)

-

ngx_http_auth_basic_module 基于HTTP的身份认证

-

ngx_http_autoindex_module 处理以"/"结尾的请求并自动生成目录列表

-

ngx_http_browser_module 解析http请求头中的"User-Agent"域的值

-

ngx_http_charset_module 指定网页编码

-

ngx_http_empty_gif_module 从内存创建一个1*1的透明gif图片,可以快速调用

-

ngx_http_fastcgi_module 对fastcgi的支持

-

ngx_http_geo_module 将客户端请求中的参数转化为键值对变量

-

ngx_http_gzip_module 压缩请求响应,可以减少数据传输

-

ngx_http_index_module 处理以"/"结尾的请求,如果没有找到该目录下的index页,就将请求转发给ngx_http_autoindex_module模块处理;如果nginx开启了ngx_http_random_index_module模块,则随机选择index页ngx_http_geoip_module

-

ngx_http_limit_conn_module 限制来自客户端的连接的响应和处理速率

-

ngx_http_limit_req_module 限制来自客户端的请求的响应和处理速率

-

ngx_http_log_module 自定义access日志

-

ngx_http_map_module 创建任意键值对变量

-

ngx_http_memcached_module 对memcached的支持

-

ngx_http_proxy_module 支持代理服务

-

ngx_http_referer_module 过滤HTTP头中"Referer"域值为空的HTTP请求

-

ngx_http_rewrite_module 通过正则表达式重定向请求

-

ngx_http_scgi_module 对SCGI的支持

-

ngx_http_ssl_module 对HTTPS的支持

可选的HTTP模块

- ngx_http_f4f_module

- ngx_http_auth_jwt_module

- ngx_http_auth_request_module

- ngx_http_addition_module 在响应请求的页面开始或者结尾添加文本信息

- ngx_http_api_module

- ngx_http_dav_module 支持http协议和webDAV协议中PUT、DELETE、MKCOL、COPY很热MOVE方法

- ngx_http_flv_module 支持将Flash多媒体信息按照流文件传输,可以根据客户端指定的开始位置返回Flash

- ngx_http_grpc_module

- ngx_http_gunzip_module

- ngx_http_gzip_static_module 搜索并使用预压缩的以

.gz为后缀的文件代替一般文件响应客户端请求 - ngx_http_headers_module

- ngx_http_hls_module

- ngx_http_image_filter_module 支持改变JPEG、GIF很热PNG图片的尺寸和旋转方向

- ngx_http_js_module

- ngx_http_keyval_module

- ngx_http_mirror_module

- ngx_http_mp4_module 支持将H.264/AAC编码的多媒体信息(后缀名通常为MP4、m4v或者m4a)安装流文件传输,常与ngx_http_flv_module模块一起使用

- ngx_http_perl_module 在nginx的配置文件中可以使用perl脚本

- ngx_http_secure_link_module 支持对请求链接的有效检查

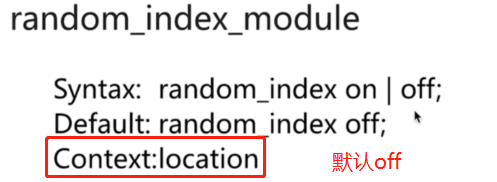

- ngx_http_random_index_module nginx接收到以

/结尾请求时,在对应目录下随机选择一个文件作为index文件 - ngx_http_realip_module

- ngx_http_session_log_module

- ngx_http_slice_module

- ngx_http_spdy_module

- ngx_http_split_clients_module

- ngx_http_ssi_module

- ngx_http_status_module

- ngx_http_stub_status_module 支持返回nginx服务器的统计信息,一般包括处理连接的数量,连接成功的数量,处理的请求、读取和返回header信息数等信息

- ngx_http_sub_module 使用指定的字符串替换响应信息中的信息

- ngx_http_upstream_module

- ngx_http_upstream_conf_module

- ngx_http_upstream_hc_module

- ngx_http_userid_module

- ngx_http_uwsgi_module

- ngx_http_v2_module

-

ngx_http_xslt_module 将xml响应信息使用xslt(扩展样式表转换语言)进行转换

-

ngx_stream_geoip_module 支持解析基于GeoIP数据库的客户端请求(关于GeoIP数据库,查看官网http://www.maxmind.com)

-

ngx_google_perftools_module 支持Google Performance Tools(Google Performance Tools是Google公司开发的一套用于C++Profile的工具集,详解查看官网:http://code.google.com/p/gperftools)

服务邮件模块

邮件服务是nginx服务器提供的主要服务之一,这些模块完成了邮件服务的主要功能,包括多pop/3、imap协议和smtp协议的支持,对身份认证、邮件代理和ssl安全服务的提供

第三方模块

参考:https://www.nginx.com/resources/wiki/modules

记录在wiki站点,如:

echo-nginx-module

memc-nginx-module

rds-json-nginx-module

lua-nginx-module

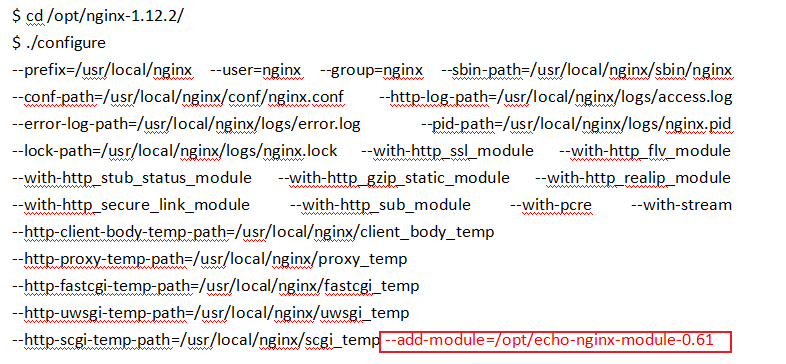

编译三方模块:echo-nginx-module 模块为例

参考:https://www.cnblogs.com/52fhy/p/10166333.html

获取echo-nginx-module

我们下载最新稳定版(截止到2018-12-23),并解压,不用安装:

$ cd /opt

$ wget https://github.com/openresty/echo-nginx-module/archive/v0.61.tar.gz

$ tar zxvf v0.61.tar.gz

编译Nginx

注意:重新编译 Nginx 二进制,Nginx 需要停止重启。而普通配置更新则 reload 即可

Nginx编译参数配置:

$ cd /opt/nginx-1.12.2/

$ ./configure