- Docker内容介绍

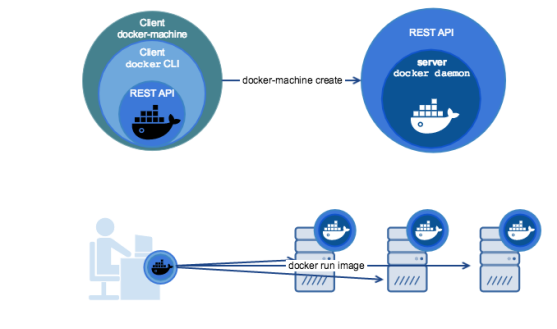

- 部署docker容器虚拟化平台

- daemon.json

- Keep containers alive during daemon downtime

- 线上docker优化

- 修改Docker Root Dir

- Docker命令行的操作参数

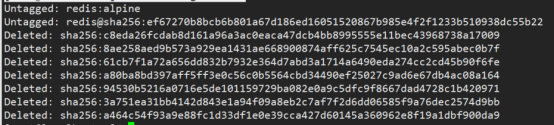

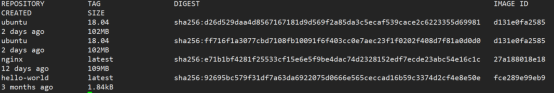

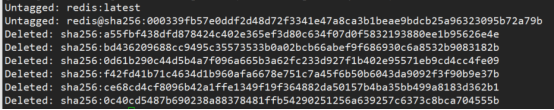

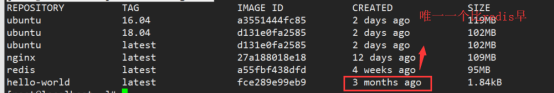

- 常见docker清理方法

- 推送镜像脚本

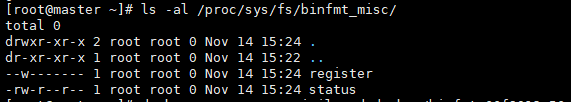

- Docker疑难杂症汇总

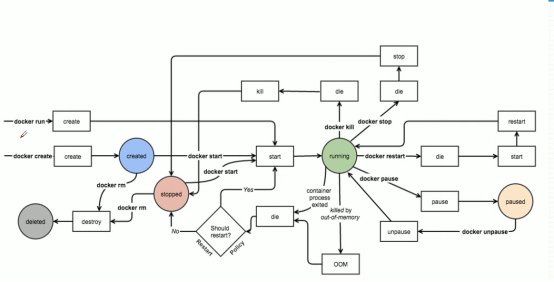

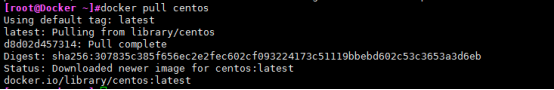

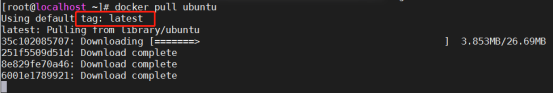

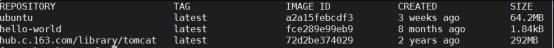

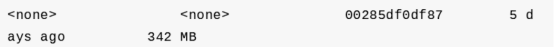

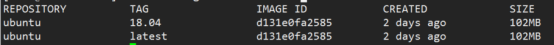

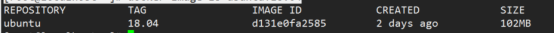

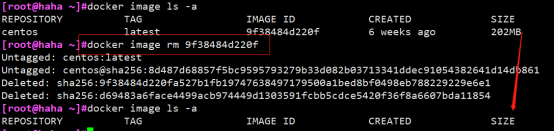

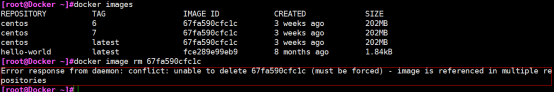

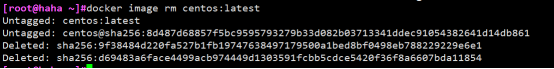

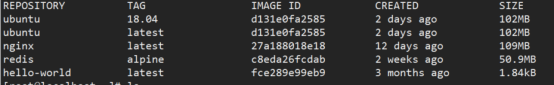

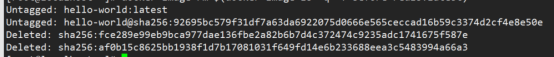

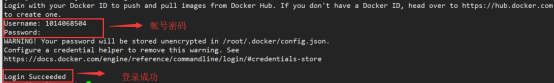

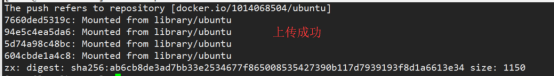

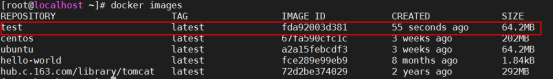

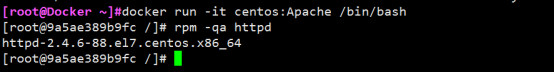

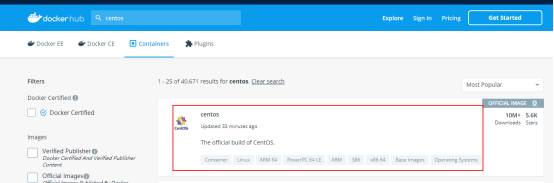

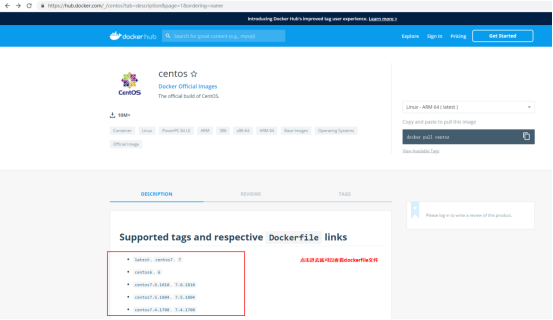

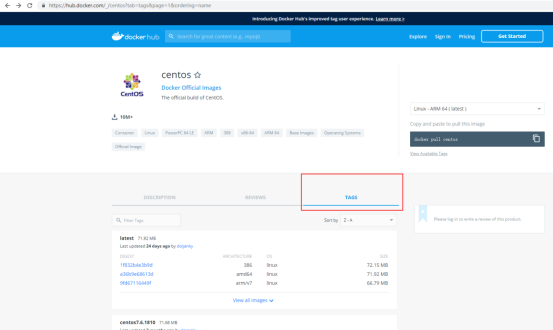

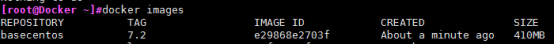

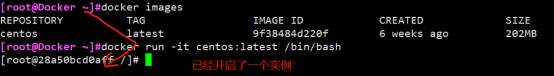

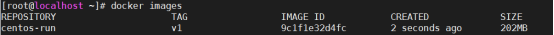

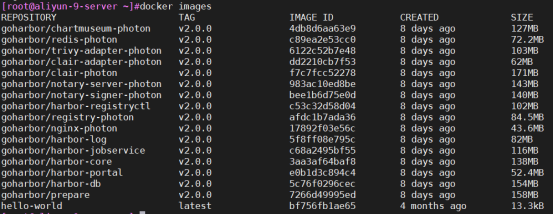

- Docker 镜像

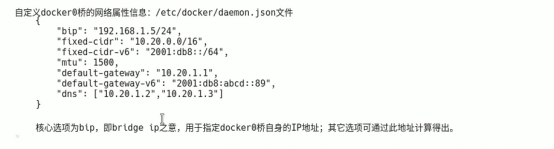

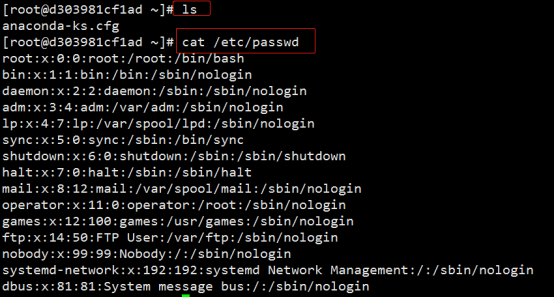

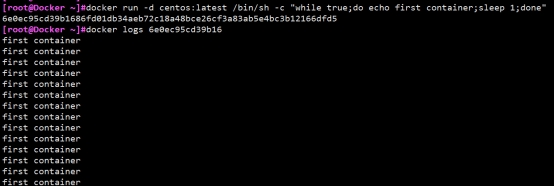

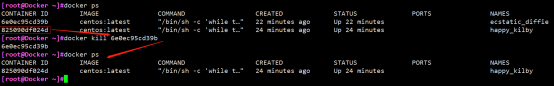

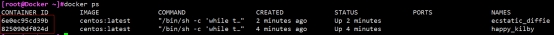

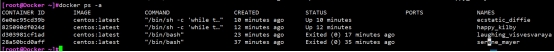

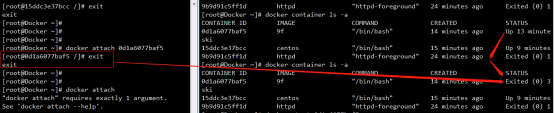

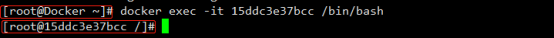

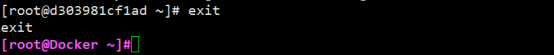

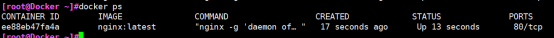

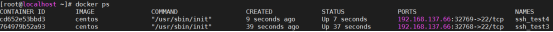

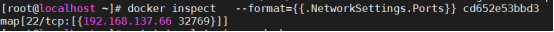

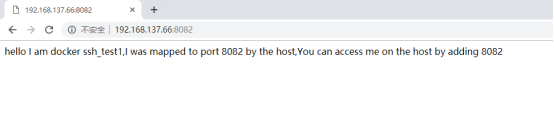

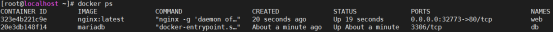

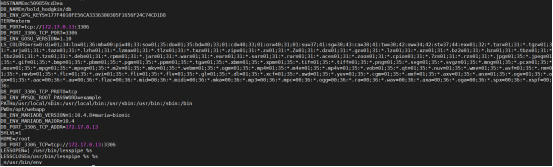

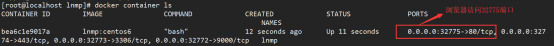

- Docker 容器

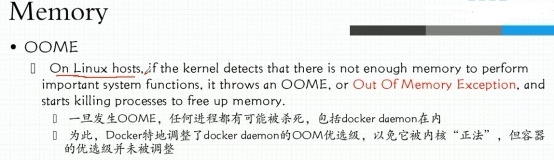

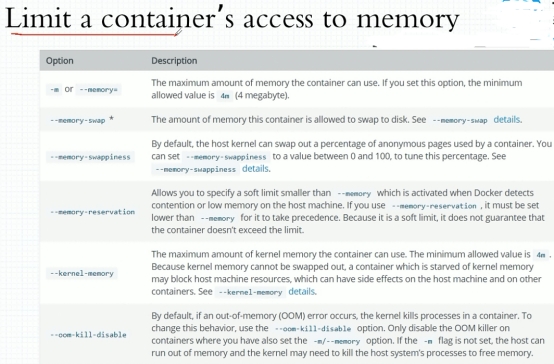

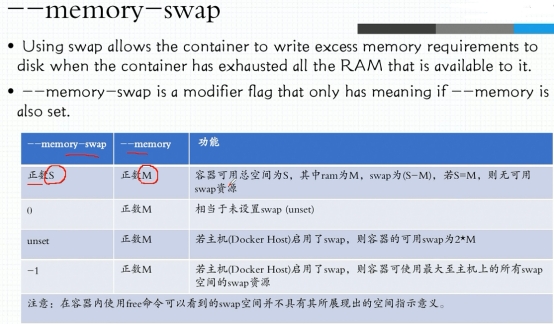

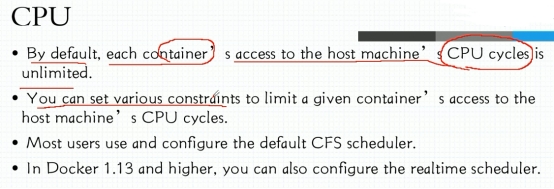

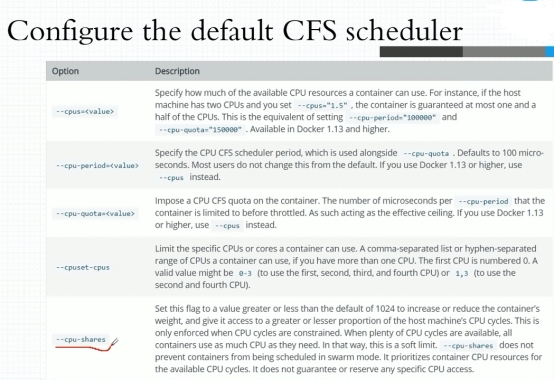

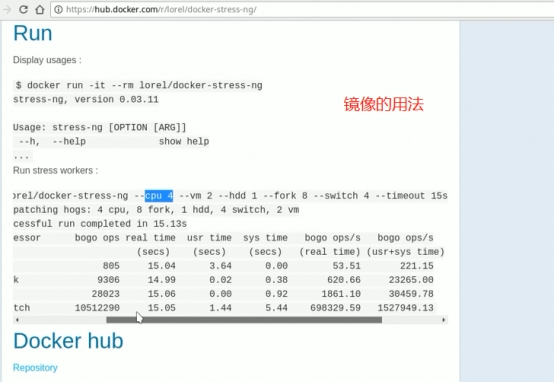

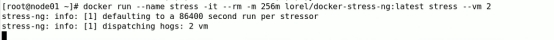

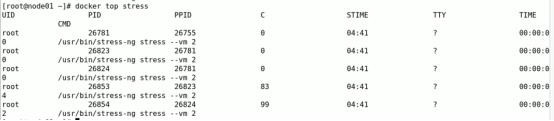

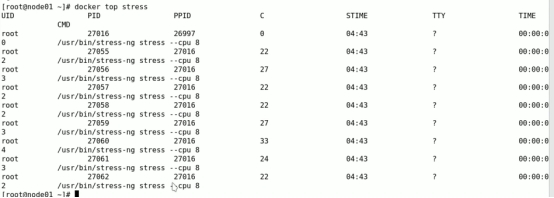

- Docker系统资源限制

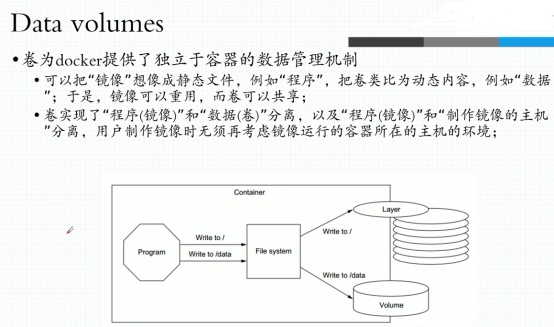

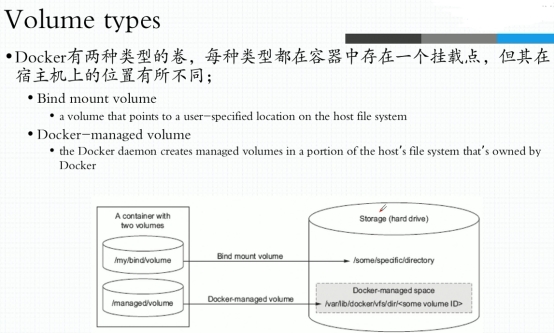

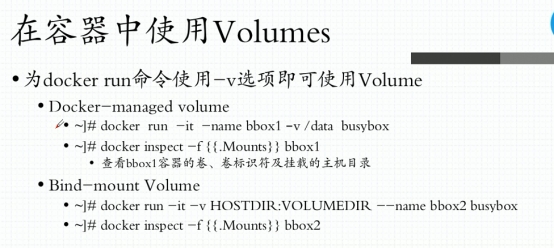

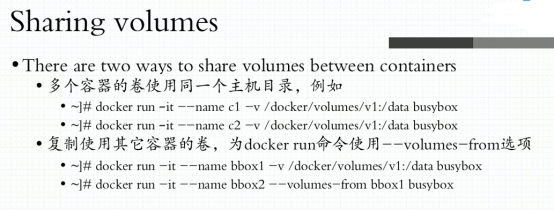

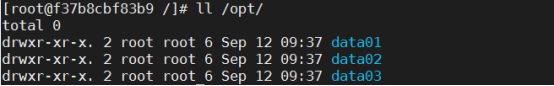

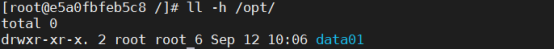

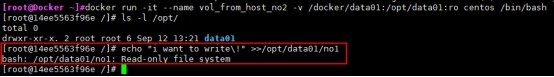

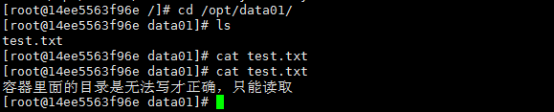

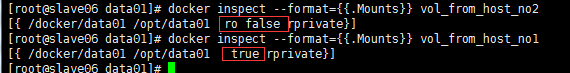

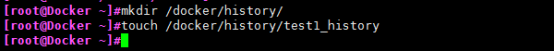

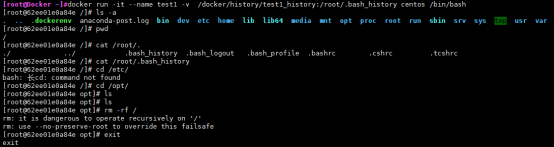

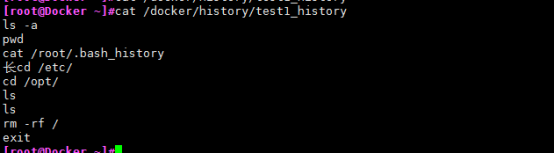

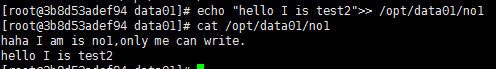

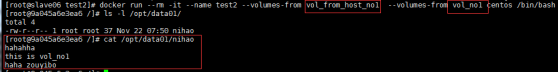

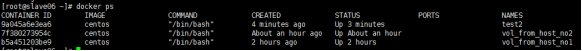

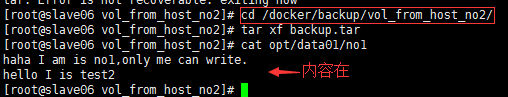

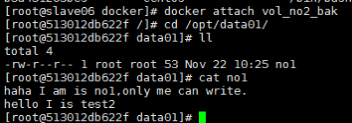

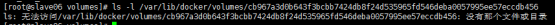

- Docker 数据管理

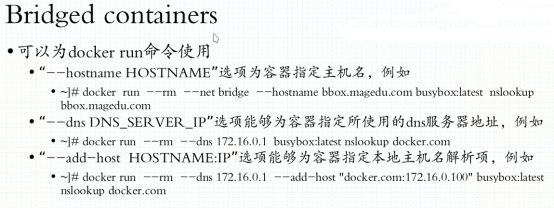

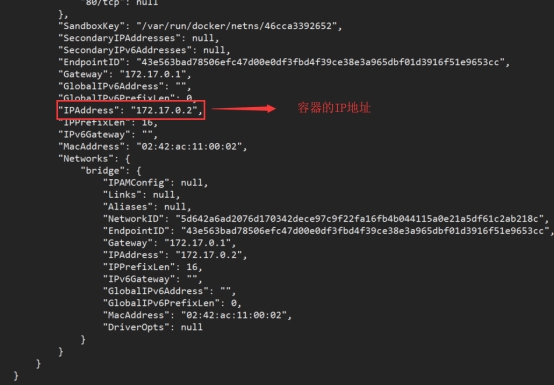

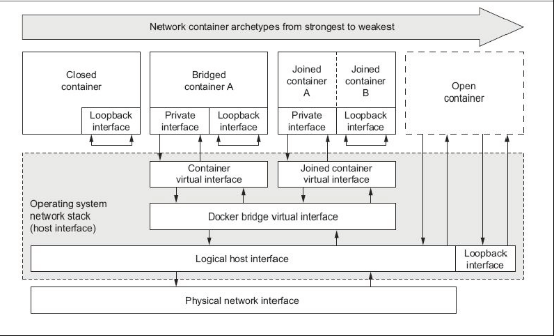

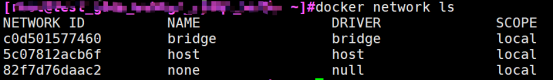

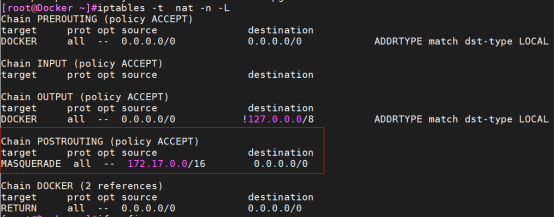

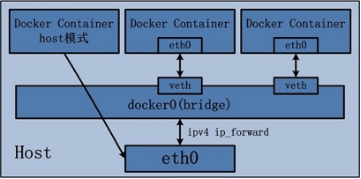

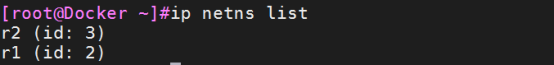

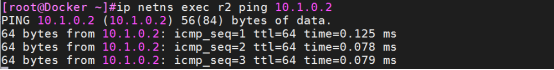

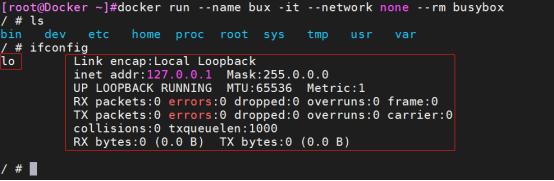

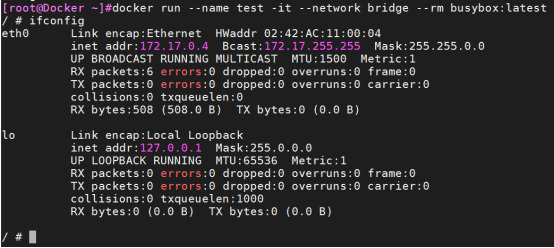

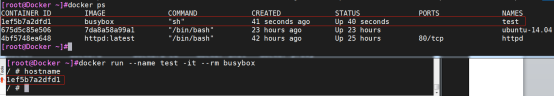

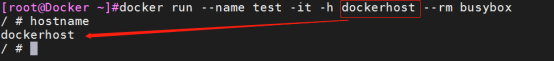

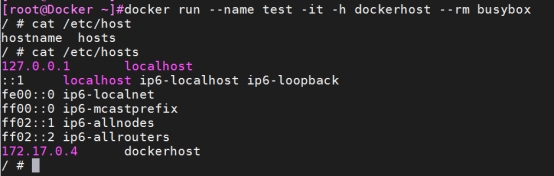

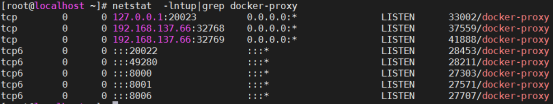

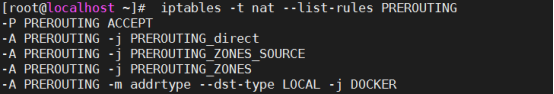

- Docker容器网络(4种)

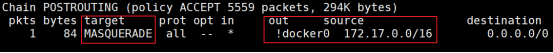

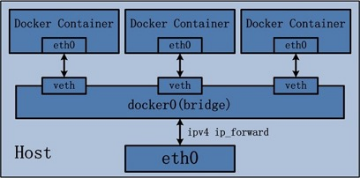

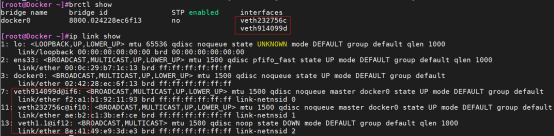

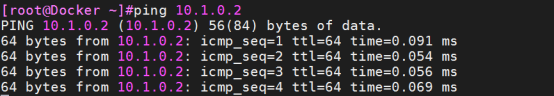

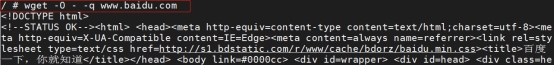

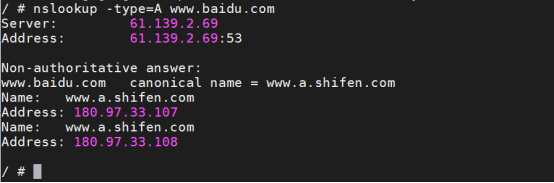

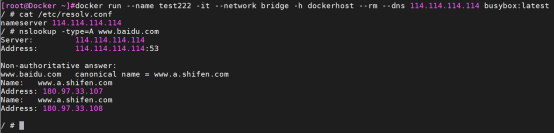

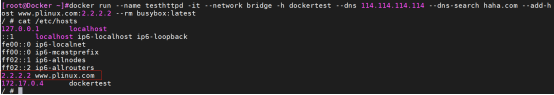

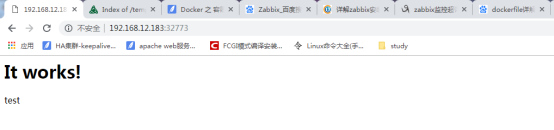

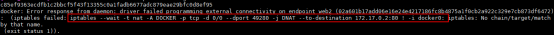

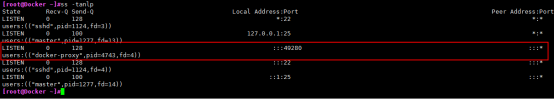

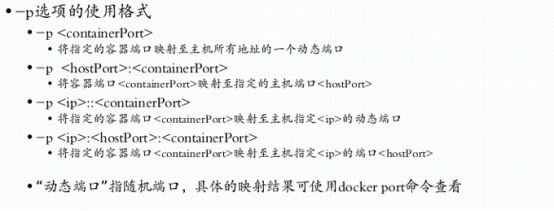

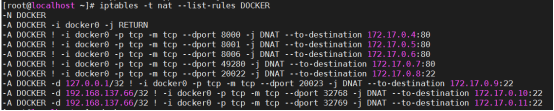

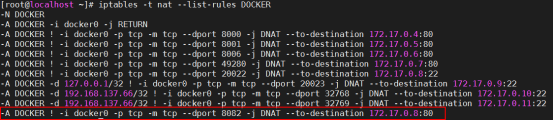

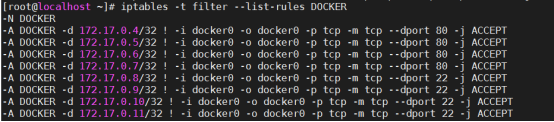

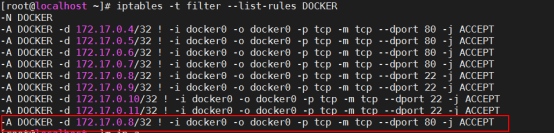

- Docker的网络通信

- docker pipework 实现跨宿主主机容器互联

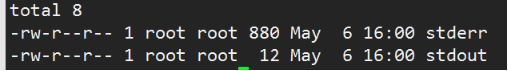

- 如何调试 Docker

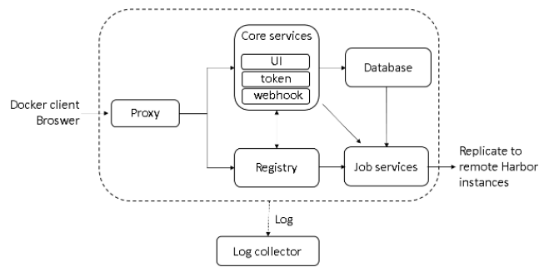

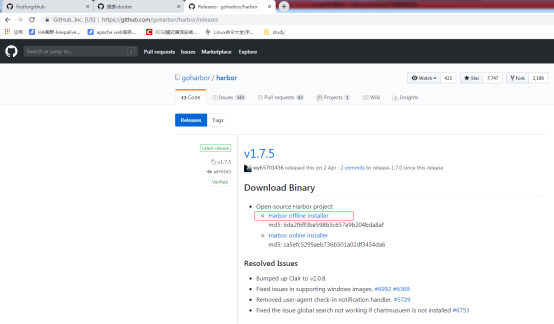

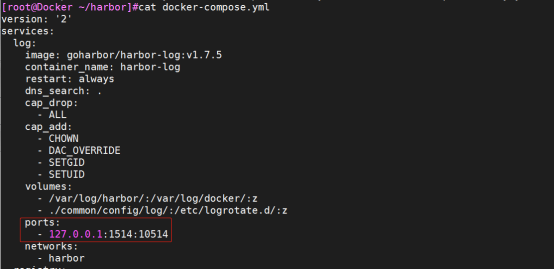

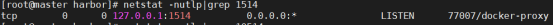

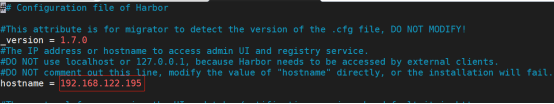

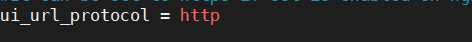

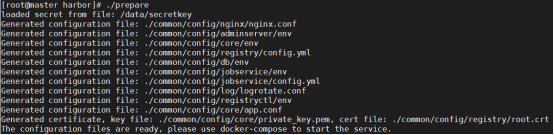

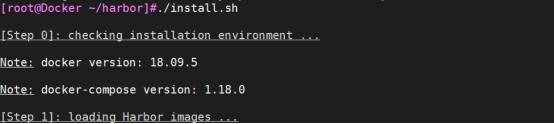

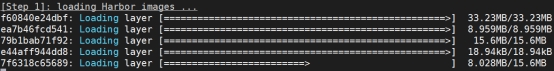

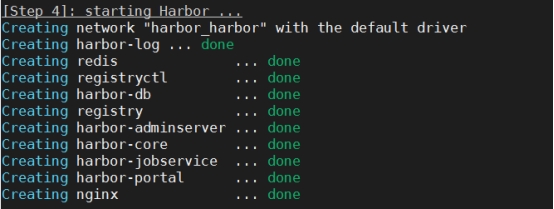

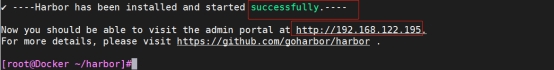

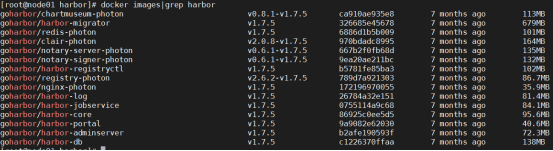

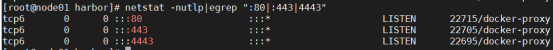

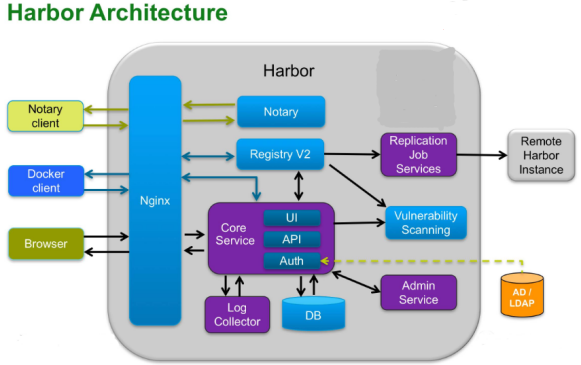

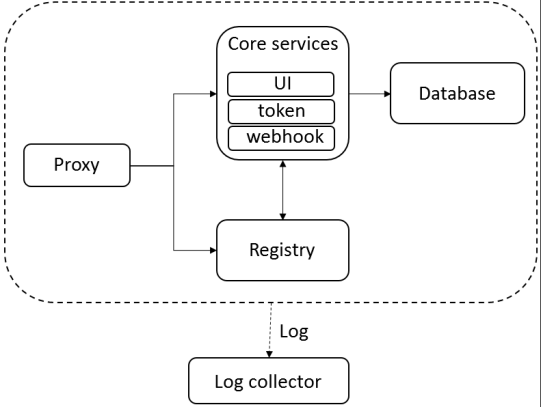

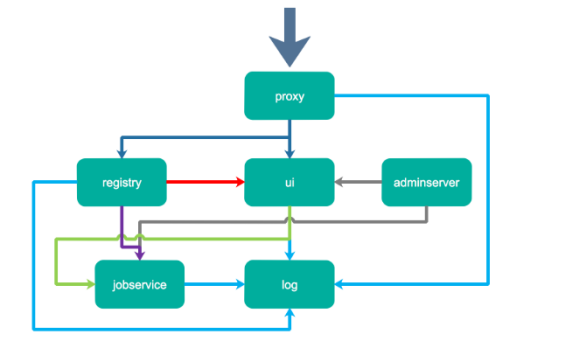

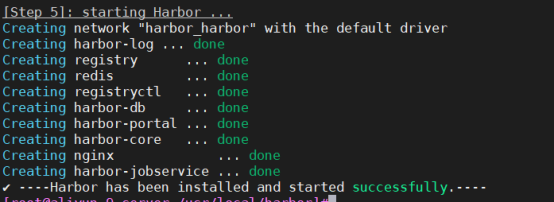

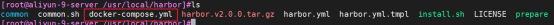

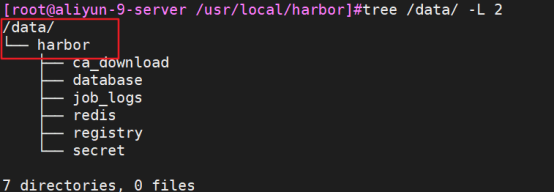

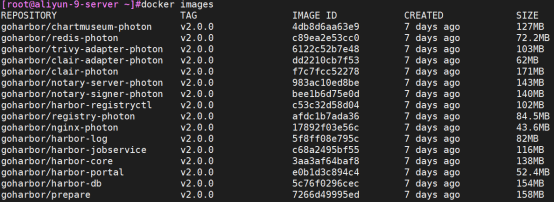

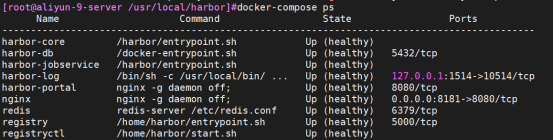

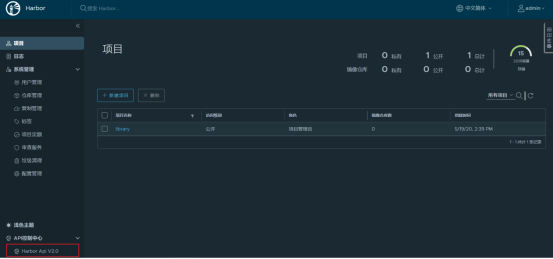

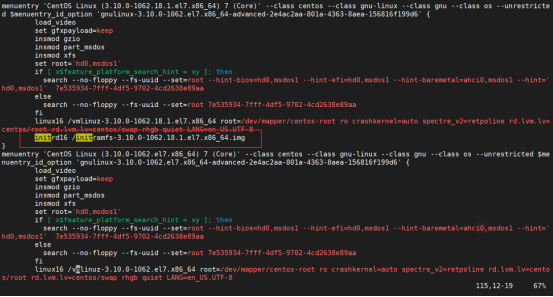

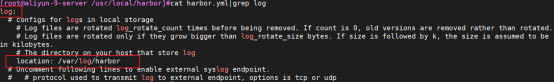

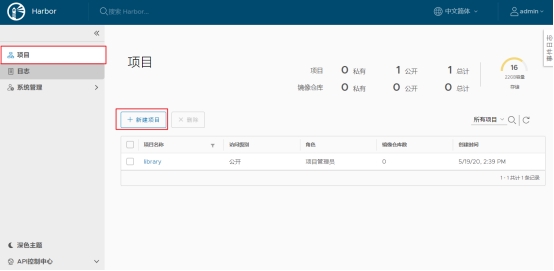

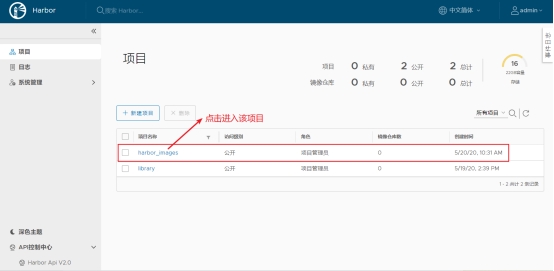

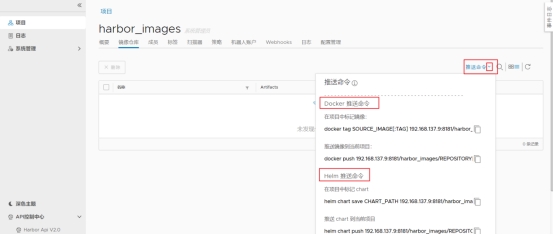

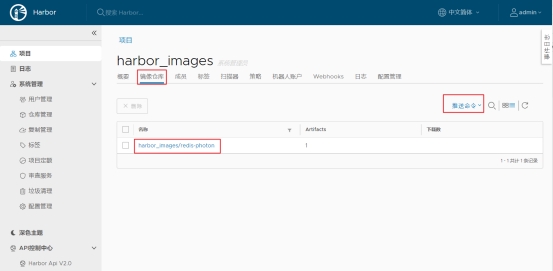

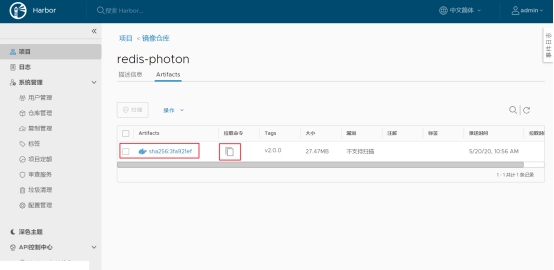

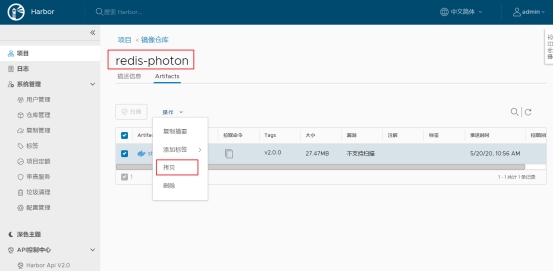

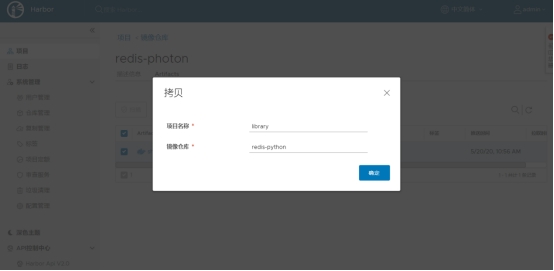

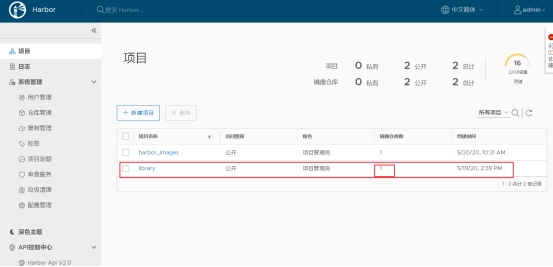

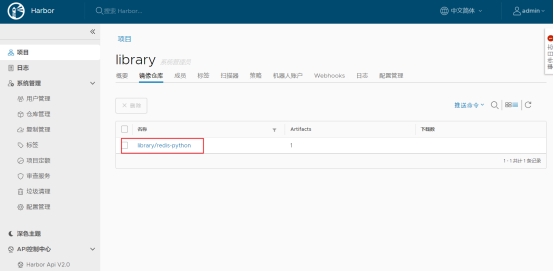

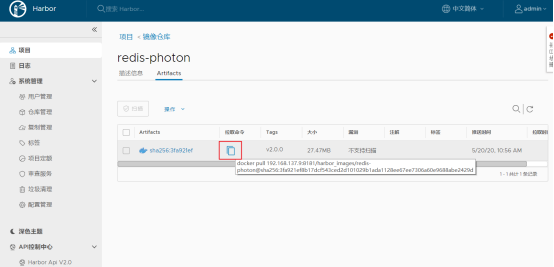

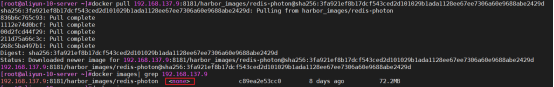

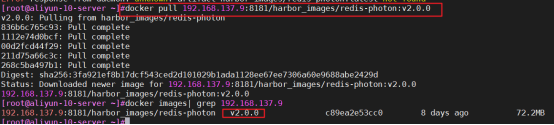

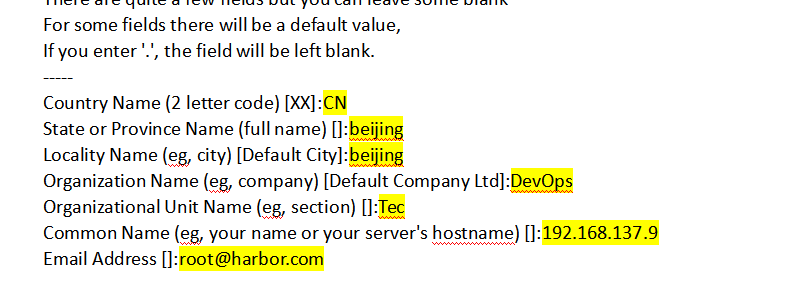

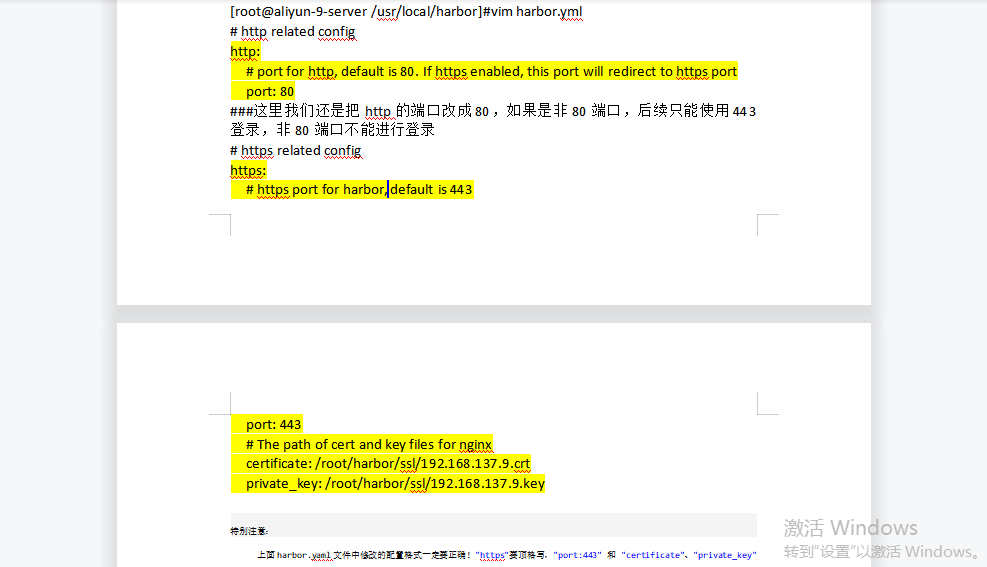

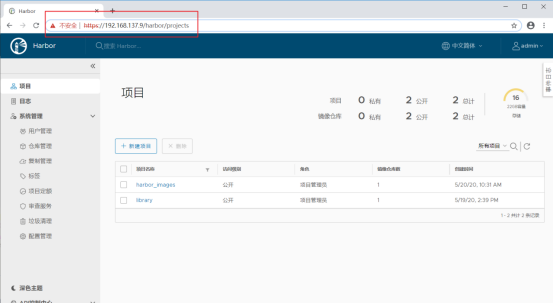

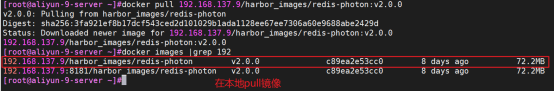

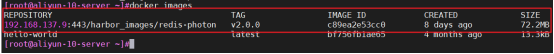

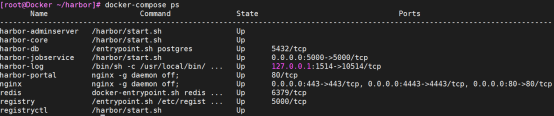

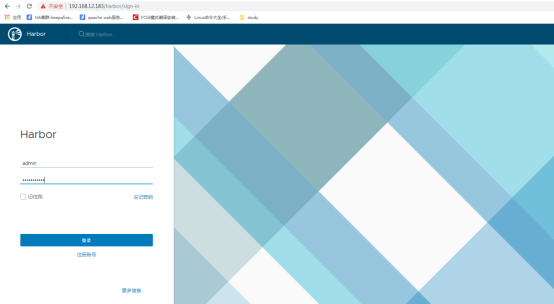

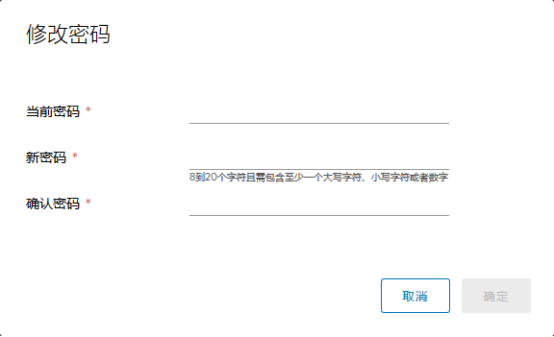

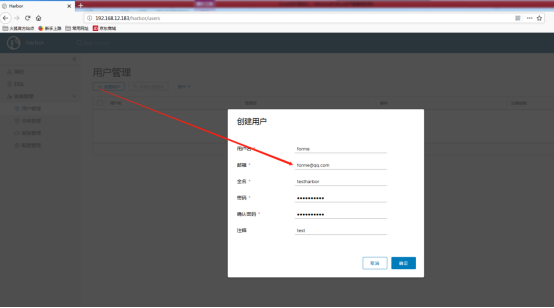

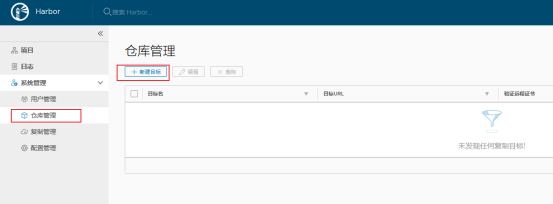

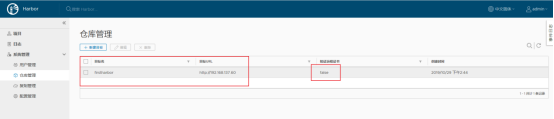

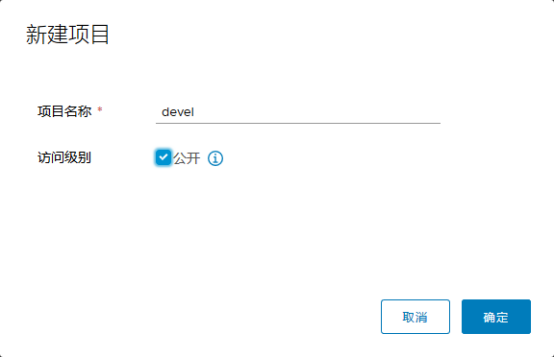

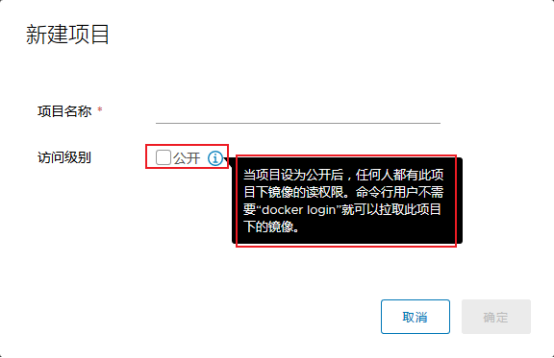

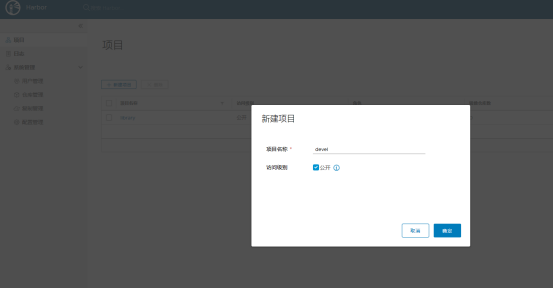

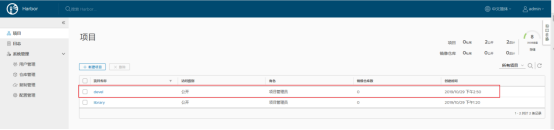

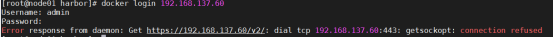

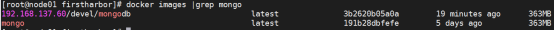

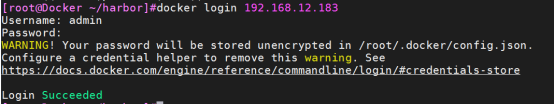

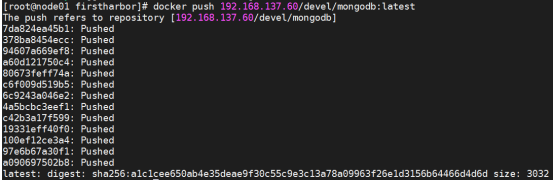

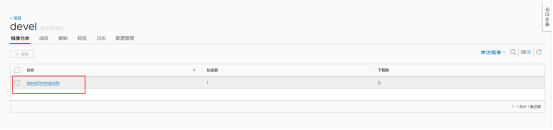

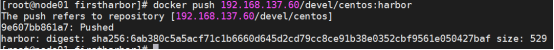

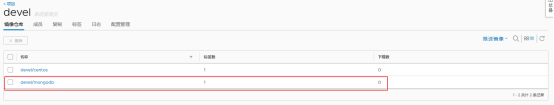

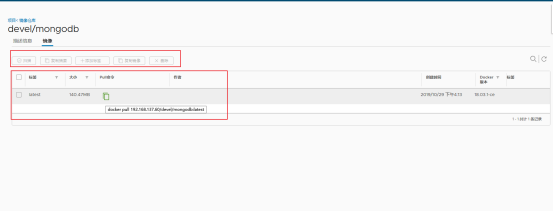

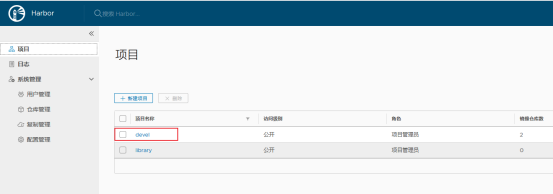

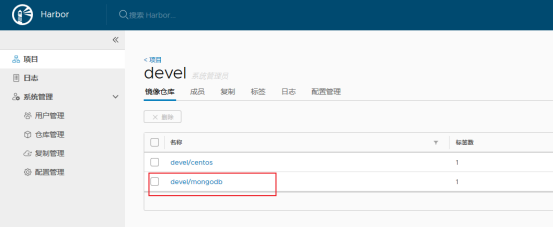

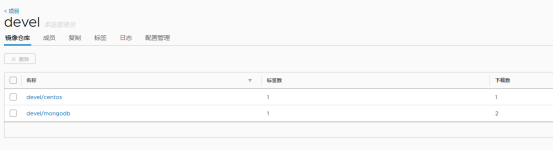

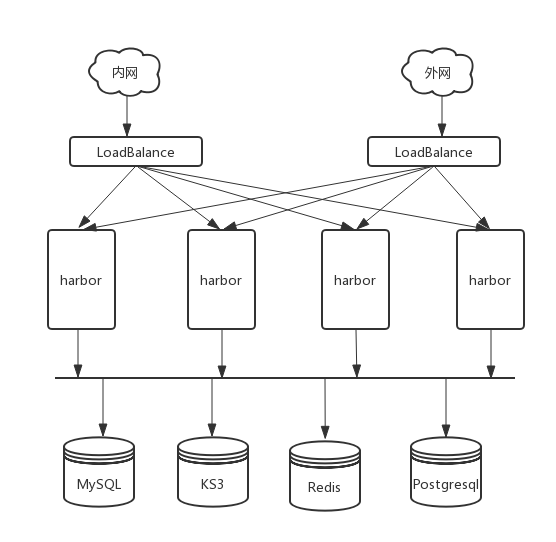

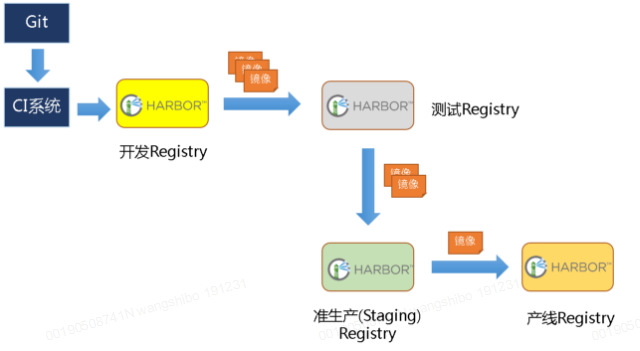

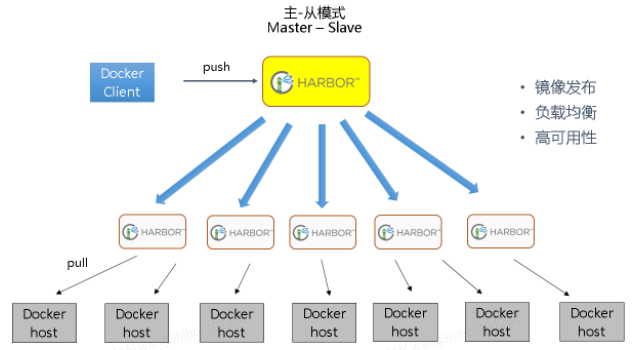

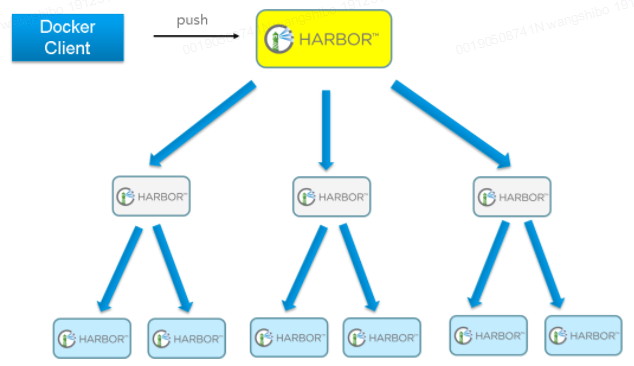

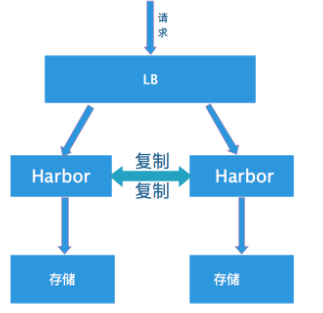

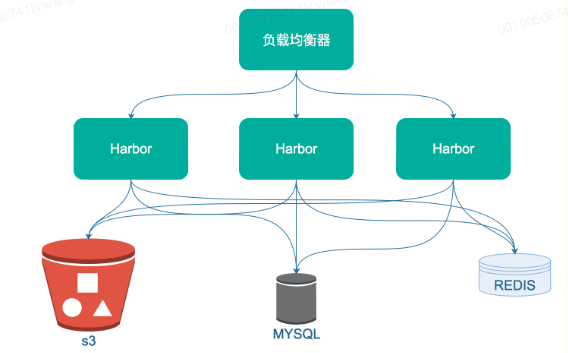

- Docker私有registry->harbor

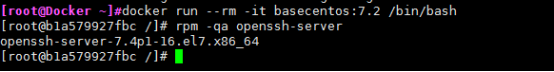

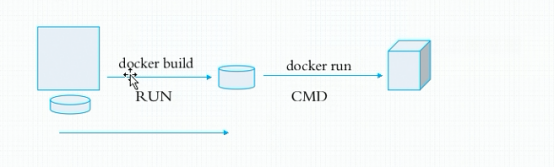

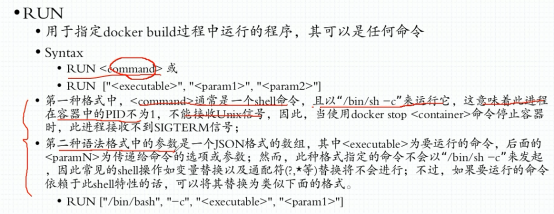

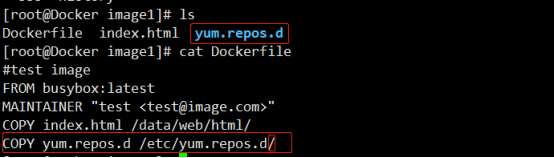

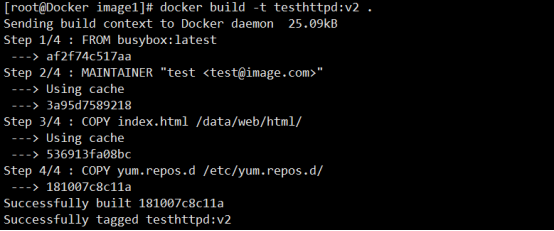

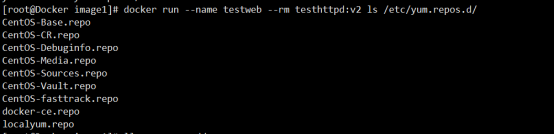

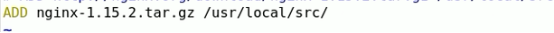

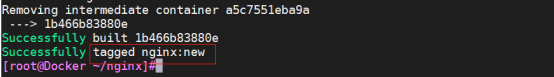

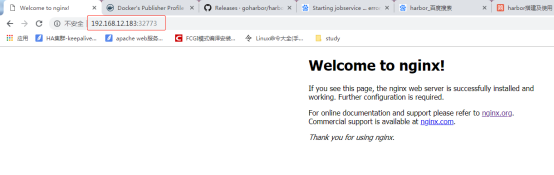

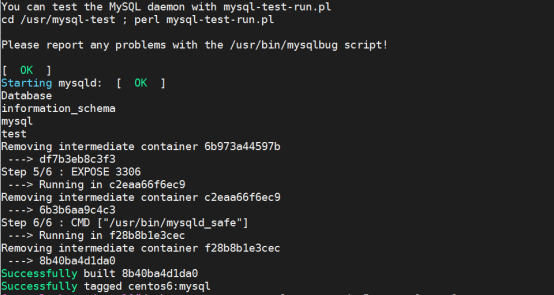

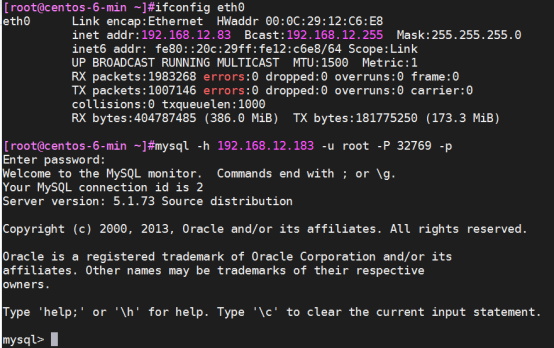

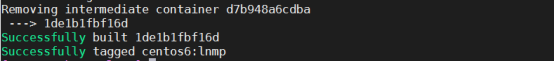

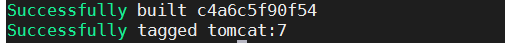

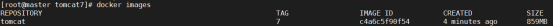

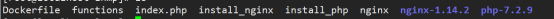

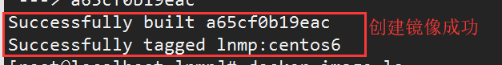

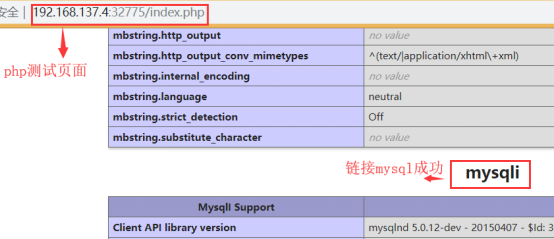

- Docker的构建汇总

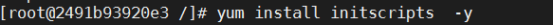

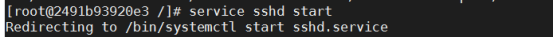

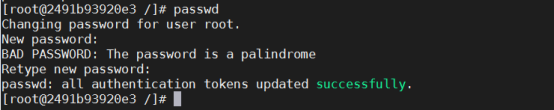

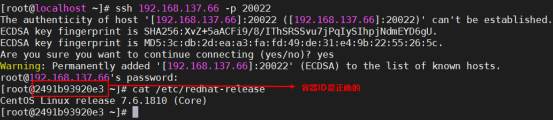

- 如何在运行docker容器时自动启动服务?

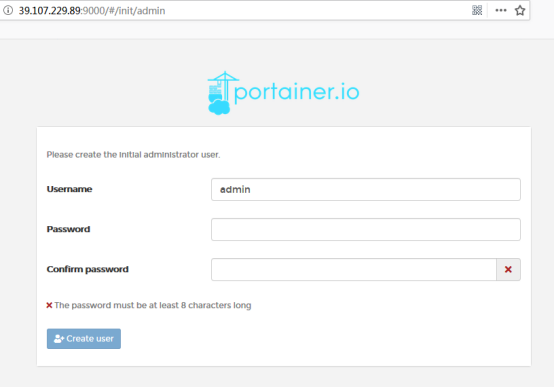

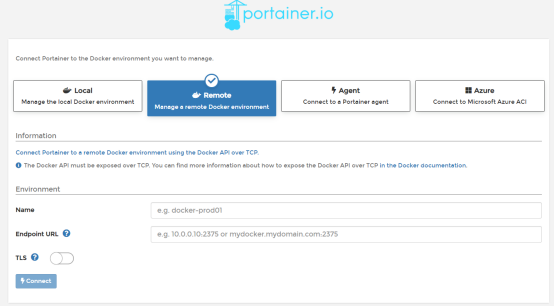

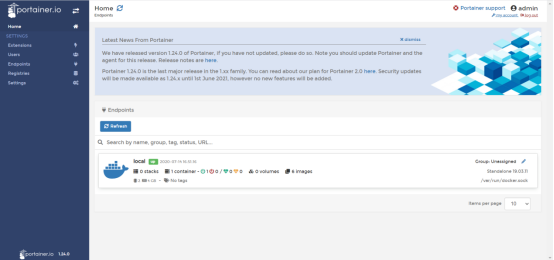

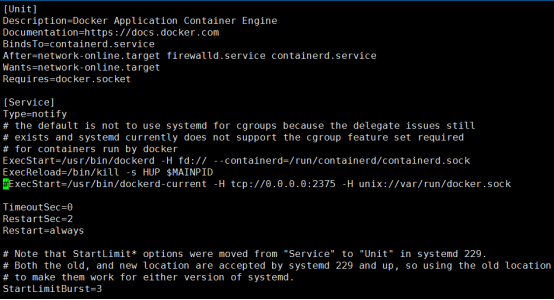

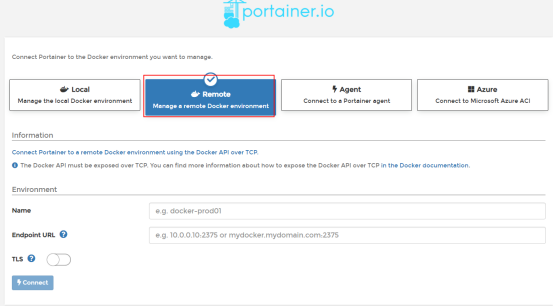

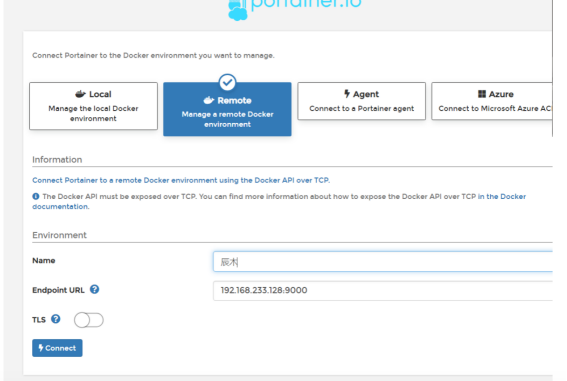

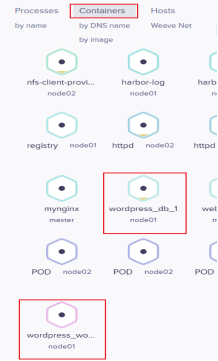

- Portainer一个轻量级的Docker环境管理UI

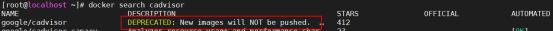

- Cadvisor:对docker所有容器的监控

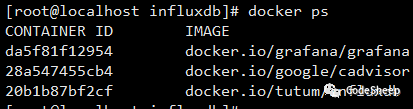

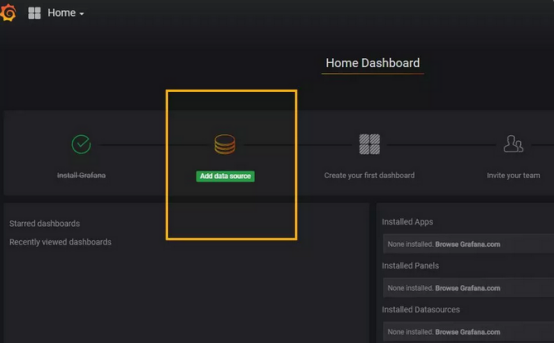

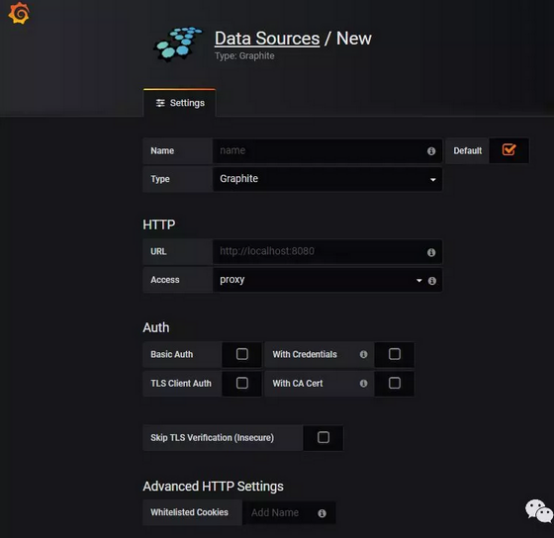

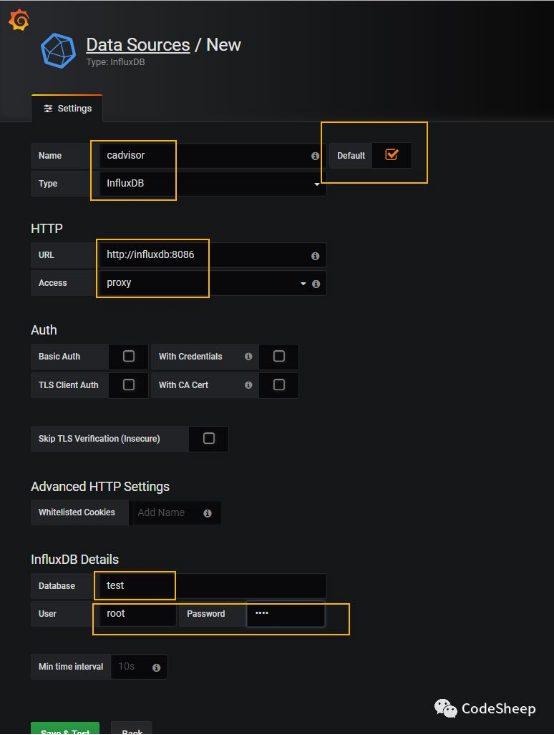

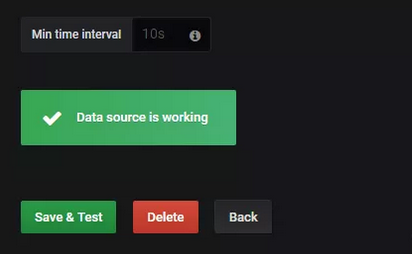

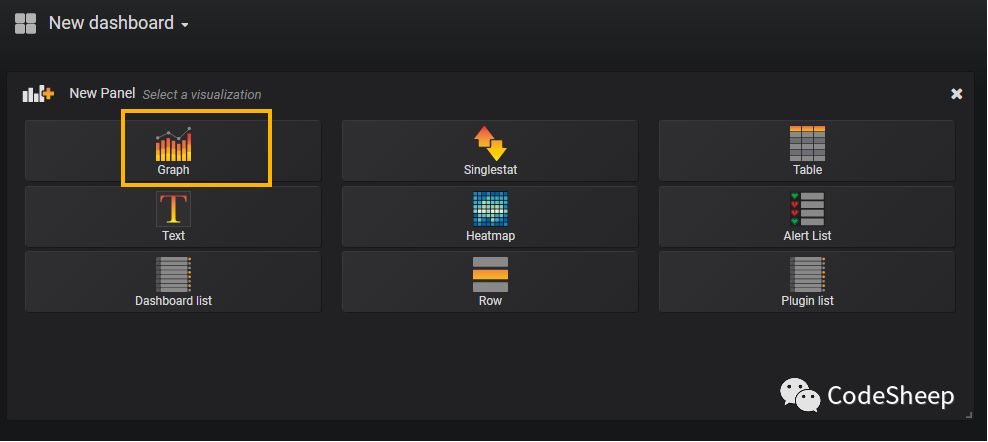

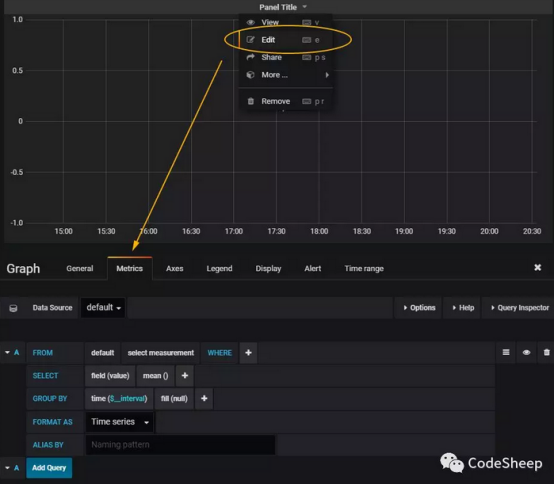

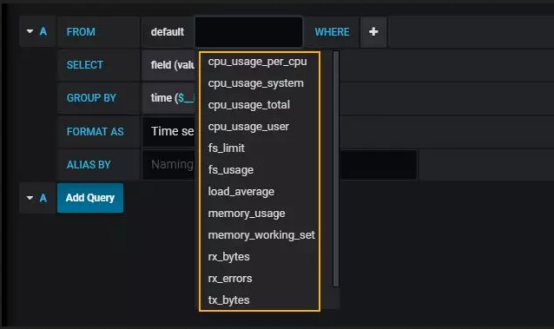

- Docker容器可视化监控中心搭建

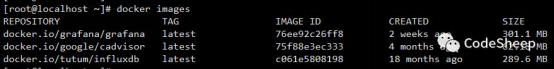

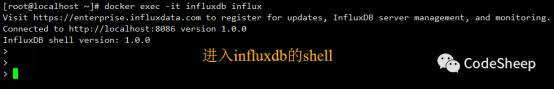

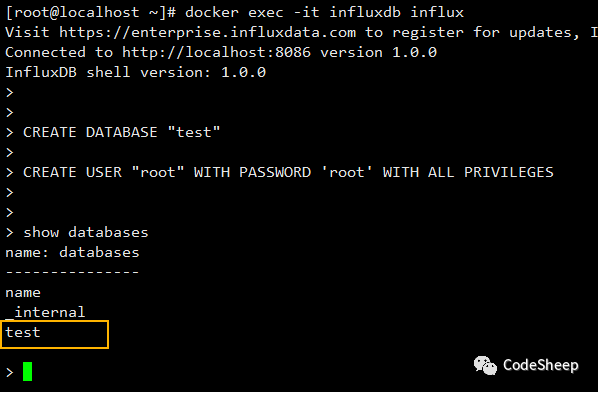

- 利用TICK搭建Docker容器可视化监控中心

- skopeo

- Podman

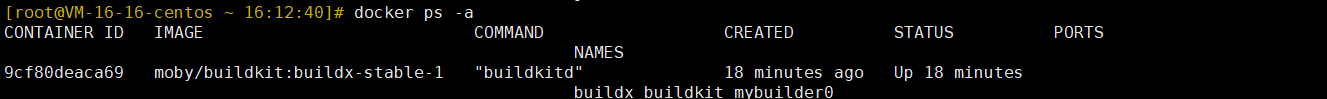

- 构建多平台Docker镜像

- Docker 部署 Django+Mysql+Redis+Gunicorn+Nginx

- 使用Docker部署Ngrok实现内网穿透

- docker三剑客

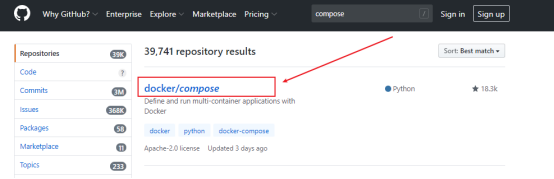

- Docker-compose

- Compose 中有两个重要的概念:

- Overview of Docker Compose

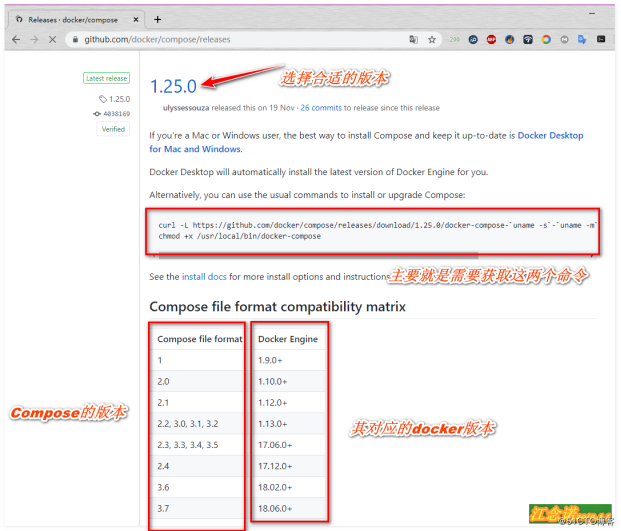

- Install Docker Compose

- Get started with Docker Compose

- 在项目根目录创建 docker-compose.yml,内容如下

- Compose命令说明

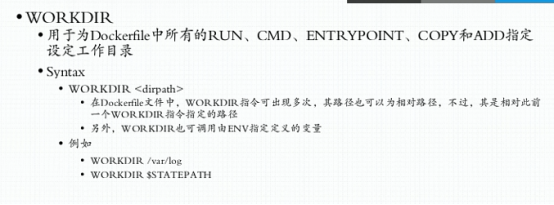

- Compose 模板文件

- version

- build

- cap_add, cap_drop

- command

- configs

- cgroup_parent

- container_name

- deploy

- devices

- depends_on

- dns

- dns_search

- tmpfs

- environment

- env_file

- expose

- external_links

- extra_hosts

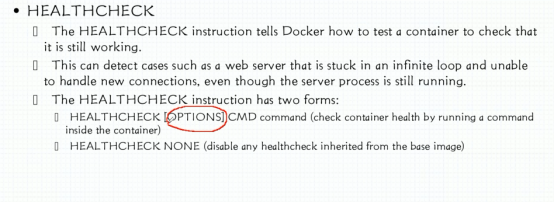

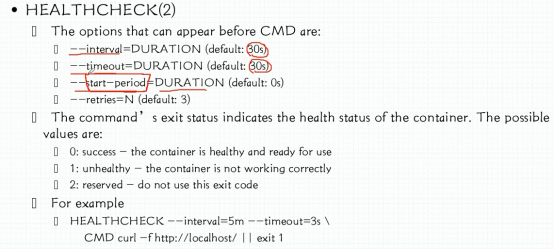

- healthcheck

- image

- labels

- links

- logging

- network_mode

- networks

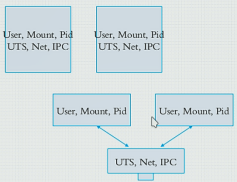

- pid

- ports

- restart

- secrets

- security_opt

- stop_signal

- hostname

- privileged

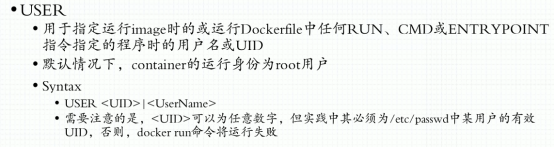

- user

- tty

- sysctls

- ulimits

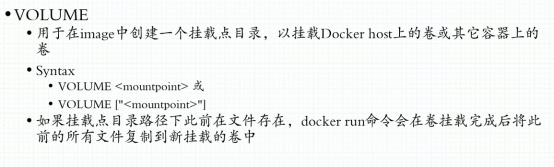

- Volumes

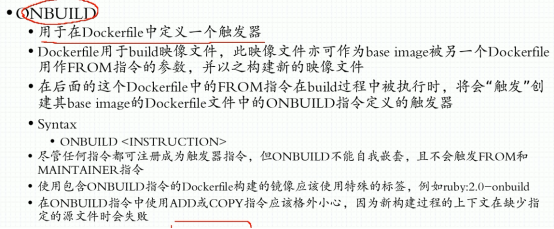

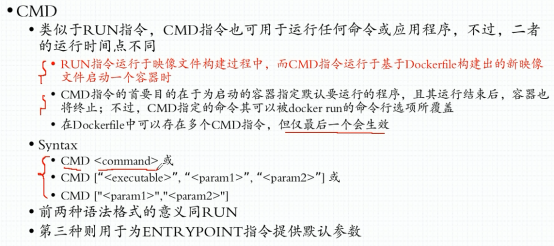

- 其它指令

- 读取变量

- 构建简单的Nginx服务.yml文件

- 部署redis

- compose+dockerfile构建镜像

- 使用.yml文件搭建WordPress

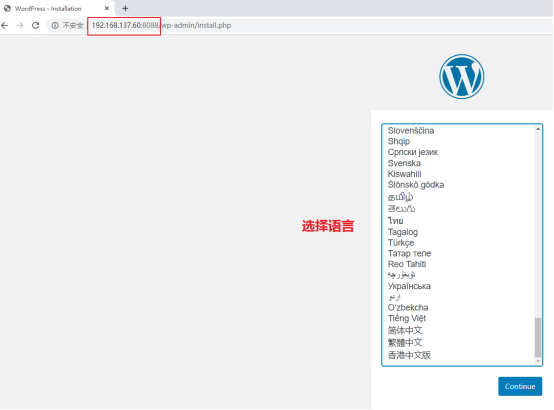

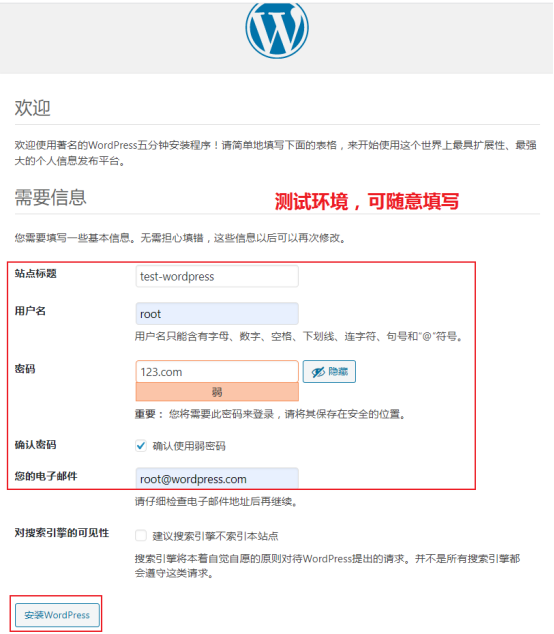

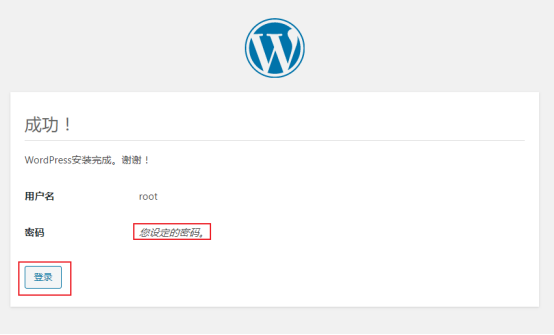

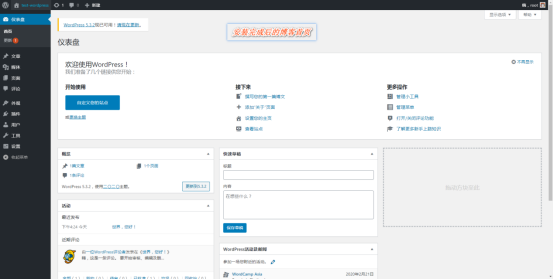

- WordPress

- lnmp

- Docker Swarm

- Docker Machine

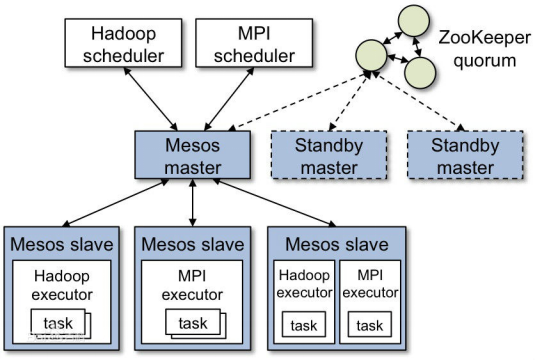

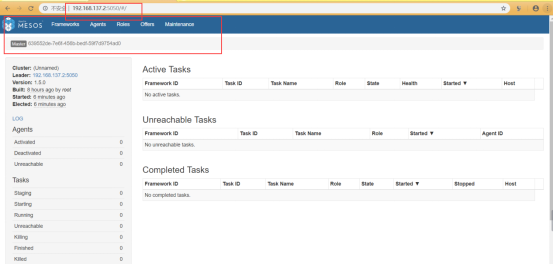

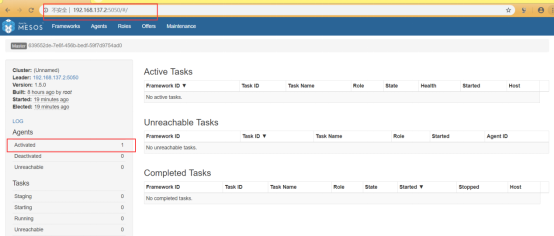

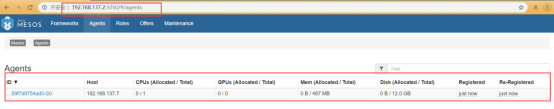

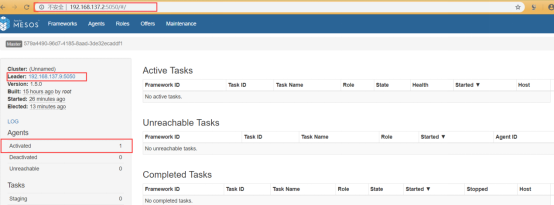

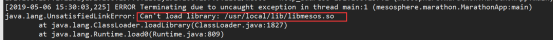

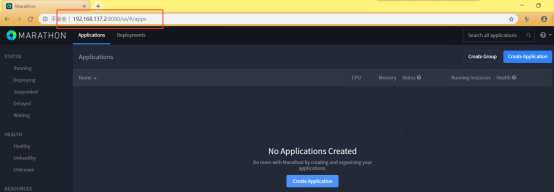

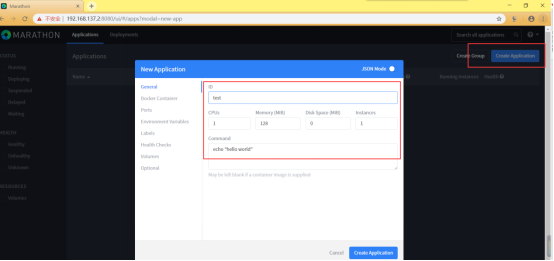

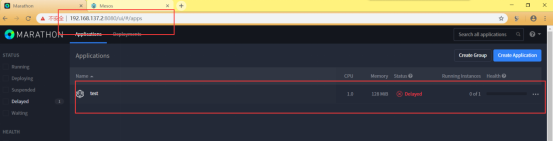

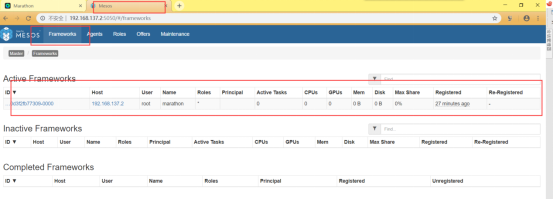

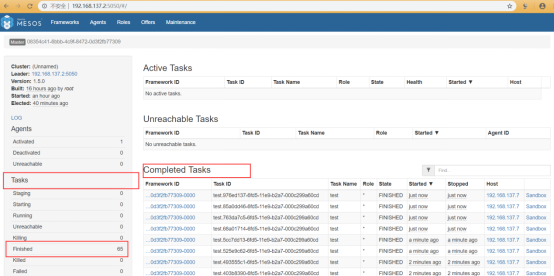

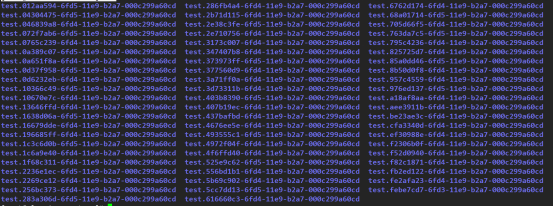

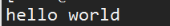

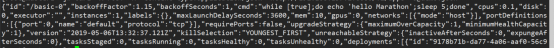

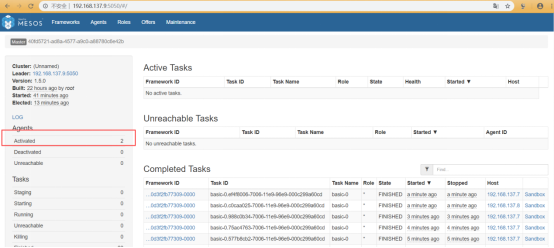

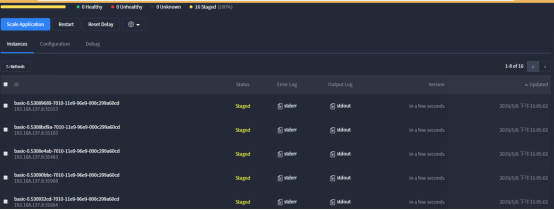

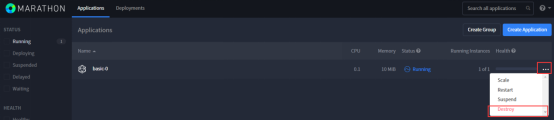

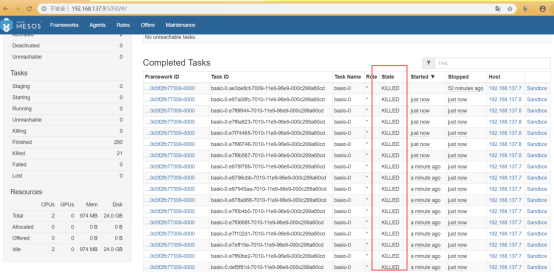

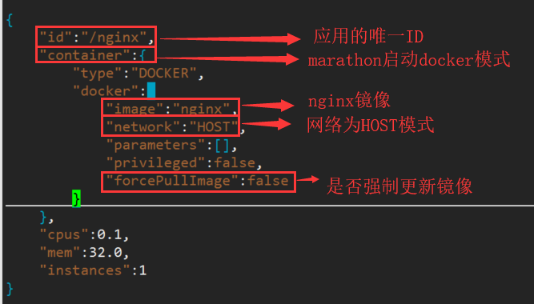

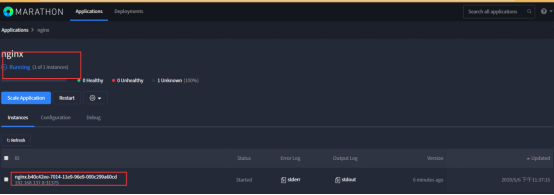

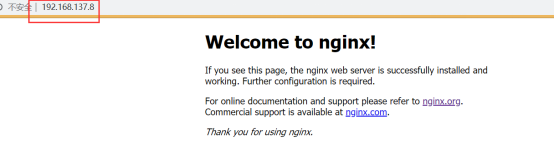

- ~~Marathon+Mesos+Docker (没用)~~

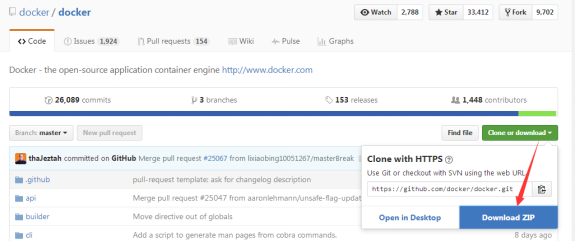

Docker内容介绍

源代码下载:

https://github.com/docker/docker

下载docker 二进制文件:

https://download.docker.com/linux/static/stable/x86_64/

官方网站:

镜像地址:

https://hub.docker.com/search?offering=community&type=edition&operating_system=linux

国内镜像源:

mirrors.aliyun.com

参考网址:安装参考地址

https://mirrors.tuna.tsinghua.edu.cn/help/docker-ce/

https://www.docker-cn.com/registry-mirror

三方网站:

quay.io

dev.aliyun

资源链接

官方网站

Docker 官方主页:https://www.docker.com

Docker 官方博客:https://blog.docker.com/

Docker 官方文档:https://docs.docker.com/

Docker Hub:https://hub.docker.com

Docker 的源代码仓库:https://github.com/moby/moby

Docker 发布版本历史:https://docs.docker.com/release-notes/

Docker 常见问题:https://docs.docker.com/engine/faq/

Docker 远端应用 API:https://docs.docker.com/develop/sdk/

实践参考

Dockerfile 参考:https://docs.docker.com/engine/reference/builder/

Dockerfile 最佳实践:https://docs.docker.com/engine/userguide/eng-image/dockerfile_best-practices/

技术交流

Docker 邮件列表: https://groups.google.com/forum/#!forum/docker-user

Docker 的 IRC 频道:https://chat.freenode.net#docker

Docker 的 Twitter 主页:https://twitter.com/docker

其它

Docker 的 StackOverflow 问答主页:https://stackoverflow.com/search?q=docker

实验环境: CENTOS7.4-63 64位

CI:持续集成

CD:持续部署 -> DevOPS

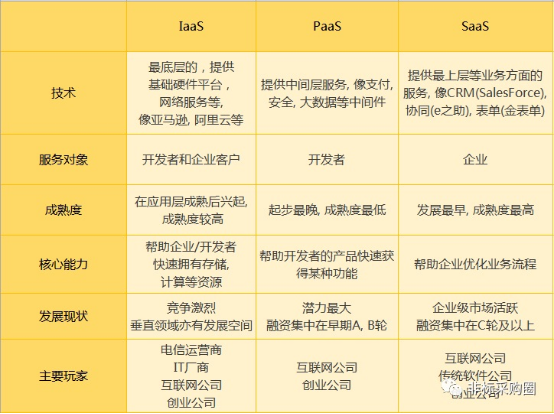

云架构:

-

IaaS:基础设置即服务(Infrastucture-as-aService);提供给消费者的服务是对所有计算基础设施的利用,包括处理CPU、内存、存储、网络和其它基本的计算资源,用户能够部署和运行任意软件,包括操作系统和应用程序。

-

PASS:平台即服务(Platform-as-a-Service);提供给消费者的服务是把客户采用提供的开发语言和工具(例如与Java,python、Net等)开发或收购的应用程序部署到供应商的云计算基础设施上。 客户不需要管理控制底层的云基础设施,包括网络、服务器、操作系统存储等,但客户能控制部署的应用程序,也能控制运行应用程序的托管环境配置。

-

SaaS:软件即服务(Software-as-a-Service);提供给客户的服务是运营商运行在云计算基础设施上的应用程序,用户可以在各种设备上通过客户端界面访问。消费者不需要管理或控制任何云计算基础设置,包括网络、服务器、操作系统、存储等。

云计算平台介绍

参考:https://zhinan.sogou.com/guide/number/316513843918.htm?rcer=Q9PEmk2kVIvu-wIIl

https://wenwen.sogou.com/z/q825705149.htm?rcer=Q9PEmk2kVIvu-wIIl

云计算是一种资源的服务模式,该模式可以实现随时随地、便捷按需地从可配置计算资源共享池中获取所需的资源(如网络、服务器、存储、应用及服务),资源能够快速供应并释,大大减少了资源管理工作开销。

经典云计算架构包括IaaS(Infrastructure as a Service,基础设施即服务)、PaaS(Platform-as-a-Service:平台即服务)、SaaS(Software as a Service,软件即服务)三层服务。下面是对这三种服务的介绍:

IaaS层为基础设施运维人员服务,提供计算、存储、网络及其他基础资源,云平台使用者可以在上面部署和运行包括操作系统和应用程序在内的任意软件,无需再为基础设施的管理而分心。

PaaS层为应用开发人员服务,提供支撑应用运行所需的软件运行时环境、相关工具与服务,如数据库服务、日志服务、监控服务等,让应用开发者可以专注于核心业务的开发。

SasS层为一般用户服务,提供了一套完整可用的软件系统,让一般用户无需关注技术细节,只需通过浏览器、应用客户端等方式就能使用部署在云上的应用服务。

IaaS的发展主要以虚拟机为最小粒度的资源调度单位,出现了资源利用率低、调度分发缓慢、软件堆栈环境不统一等一系列问题。PaaS在IaaS基础上发展而来,众多PaaS已经意识到可以利用容器技术解决资源利用率问题,但是PaaS通常在应用架构选择、支持的软件环境服务方面有较大的限制,这带来了应用与平台无法解耦、应用运行时环境局限性强、运维人员控制力下降的问题

IaaS的发展主要以虚拟机为最小粒度的资源调度单位,出现了资源利用率低、调度分发缓慢、软件堆栈环境不统一等一系列问题。PaaS在IaaS基础上发展而来,众多PaaS已经意识到可以利用容器技术解决资源利用率问题,但是PaaS通常在应用架构选择、支持的软件环境服务方面有较大的限制,这带来了应用与平台无法解耦、应用运行时环境局限性强、运维人员控制力下降的问题

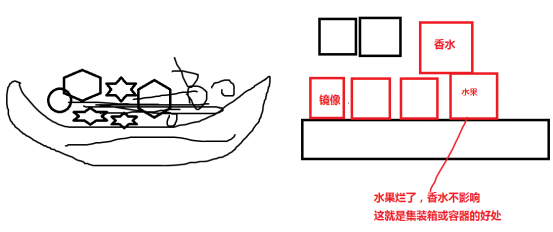

容器化思维

如今已迈入互联网+的时代,各行各业更加广泛地与互联网技术结合,软件称为连接人与人、人与企业、企业与企业之间的桥梁,互联网+时代对应用开发迭代速度和质量有了更高的要求,开发者也渐渐由单纯的开发进入到开发、维护、发布的全过程之中(DevOps)。应用开发模式正在朝着微服务模式发展。所谓微服务模式有如下三大特性:

彼此独立。 微服务模式下的每一个组成部分,都是一个独立的服务。有一整套完整的运行机制以及标准化的对外接口。不依赖于其他部分就能正常运行,同时可以探测其他组成部分的存在。

原子化。 微服务应该是不可再分的原子化服务。如果一个服务还能继续划分为几个更小的服务,那便不能称为微服务,而更像是由多个微服务组成的"微系统"。

组合和重构。 微服务的最大特点就在于它能快速的组合和重构,彼此组合成一个系统。系统里所有的实体在逻辑上是等价的,因此它的结构相对简单和松散、具有极强的可扩展性和鲁棒性(健壮和强壮)。

容器化思维就等同于微服务化思维,每个容器承载一个微服务,容器之间彼此独立正常运行,每个容器中只允许一个进程,容器间可以快速组合重构,形成一个更大的系统。所以使用Docker时需要关注容器本身,时刻提醒自己是在使用容器,享受它带来的种种便利,如快速的应用分发能力、高效的操作及反应能力、弹性灵活的部署能力以及低廉的部署成本;同时我们也要转变思维模式,学习和适应容器化的管理方式。容器的本质是一个系统进程加上一套运行时库的文件系统封装、而针对容器,我们需要监控、资源控制、配置管理、安全等

什么是Docker?

Docker 是一个开源的应用容器引擎,让开发者可以打包他们的应用以及依赖包到一个可移植的容器中,然后发布到任何流行的 Linux 机器上,也可以实现虚拟化。容器是完全使用沙盒机制,相互之间不会有任何接口(类似 iPhone 的 app)。几乎没有性能开销,可以很容易地在机器和数据中心中运行。最重要的是,他们不依赖于任何语言、框架或包装系统。

Docker是以Docker容器来资源分割和调度的基本单位,封装整个软件运行时的环境,为开发者和系统管理员设计,用于构建、发布和运行分布式应用的平台。它是一个跨平台、可移植并且简单易用的容器解决方案。Docker的源代码托管在GitHub上,基于Go语言开发并遵从Apache 2.0协议.Docker可在容器内容快速自动化地部署应用,并通过操作系统内核技术(namespaces、cgroups等)为容器提供资源隔离与安全保障。Docker是Docker.inc公司开源的一个基于LXC技术之上构建的Container容器引擎

什么是LXC? 链接地址:https://www.cnblogs.com/cherishui/p/4147240.html #这篇博客介绍的很详细

Docker 最初 dotCloud 公司内部的一个业余项目

Docker 基于 Go 语言

Docker 项目的目标是实现轻量级的操作系统虚拟化解决方案

Docker 的基础是 Linux 容器(LXC)等技术

Docker 容器的启动可以在秒级实现,这相比传统的虚拟机方式要快得多

Docker 对系统资源的利用率很高,一台主机上可以同时运行数千个 Docker 容器

扩展:沙盒

沙盒也叫沙箱,英文sandbox。在计算机领域指一种虚拟技术,且多用于计算机安全技术。安全软件可以先让它在沙盒中运行,如果含有恶意行为,则禁止程序的进一步运行,而这不会对系统造成任何危害。

Docker是dotCloud公司开源的一个基于LXC的高级容器引擎,源代码托管在Github上, 基于go语言并遵从Apache2.0协议开源。

Docker让开发者可以打包他们的应用以及依赖包到一个可移植的container中,然后发布到任何流行的Linux机器上。

ps:

现在接触的软件是怎么发布的? windows下的 2016-0ffice.exe ,不能在xp运行 ;mk.rpm 在redhat系列Linux上运行,但是不能在其他linux版本上运行。

例: /mnt/Packages/vsftpd-3.0.2-10.el7.x86_64.rpm #这个包是rhel7,就不能在rhel6运行。

现在软件包必须和系统相关。 docker镜像一次编译,到处运行。

android : linux -> JVM -> java程序 app

linux -> docker ->服务做成镜像,就可以直接运行起来

windows -> docker ->服务做成镜像,就可以直接运行起来

IOS 苹果-> docker ->服务做成镜像,就可以直接运行起来

扩展:

LXC为Linux Container的简写。Linux Container容器是一种内核虚拟化技术,可以提供轻量级的虚拟化,以便隔离进程和资源,而且不需要提供指令解释机制以及全虚拟化的其他复杂性。

LXC主要通过来自kernel的namespace实现每个用户实例之间的相互隔离,通过cgroup实现对资源的配额和度量。

docker [ˈdɒkə(r)] 码头工人

logo:

注:docker服务相当于鲸鱼,container容器就是集装箱。

container :集装箱,容器

docker: 码头工人

扩展:

集装箱是海上运货的一个创新。

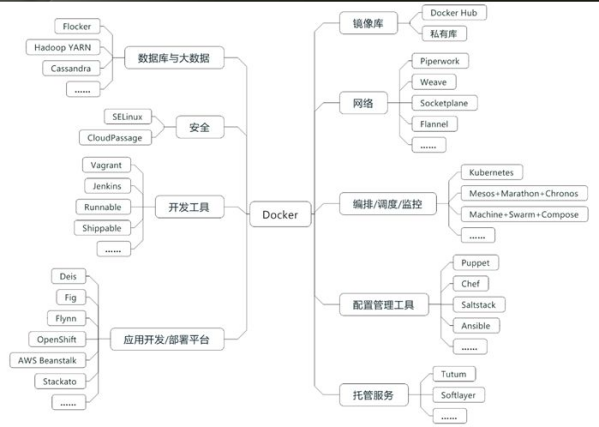

Docker生态系统

上图为Docker生态系统

围绕Docker的生态系统,自下而上分别覆盖了IaaS层和PaaS层所涉及的各类问题,包括资源调度、编排、部署、配置管理、网络管理、应用开发和部署平台、应用开发工具、应用服务供应以及大数据分析等云计算相关的服务。Docker及其生态系统主要带来了以下几点好处:

持续部署与测试。 Docker消除了线上线下的环境差异,保证了应用生命周期的环境一致性和标准化。开发人员使用镜像实现标准开发环境的构建,开发完成后通过封装着完整环境和应用的镜像进行迁移,大大简化了持续集成、测试和发布的过程。

跨云平台支持。 Docker的最大好处之一就是其适配性、越来越多的云平台都支持Docker。目前支持Docker的IaaS云平台包括但不限于亚马逊云平台(AWS)、Google云平台(GCP)、微软云平台(Azure)、OpenStack等,还包括Chef、Puppet、Ansible等配置管理工具。

环境标准化和版本控制。 可以使用Git等工具对Docker镜像进行版本控制,一旦出现故障可以快速回滚。相比以前的虚拟机镜像、Docker压缩和备份速度更快,镜像启动也像启动一个普通进程一样快速。

高资源利用率与隔离。 Docker容器没有管理程序的额外开销,与底层共享操作系统,性能更加优良,系统负载更低,在同等条件下可以运行更多的应用实例,可以更充分地利用系统资源。同时,Docker拥有不错的资源隔离与限制能力,可以精确地对应用分配CPU、内存等资源,保证了应用间不会相互影响。

容器跨平台与镜像。 Linux容器虽然早在Linux 2.6版本内核已经存在,但是缺少容器的跨平台性,难以推广。Docker在原有的Linux容器的基础上进行大胆革新,为容器设定了一整套标准化的配置方法,将应用及其依赖的运行环境打包成镜像,真正实现了"构建一次,到处运行"的理念,大大提高了容器的跨平台性。

易于理解且易用。 一个开发者可以在15分钟之内入门Docker并进行安装和部署。

应用镜像仓库。 Docker官方构建了一个镜像仓库,组织和管理形式类似于GitHub,上面已经积累了成千上万的镜像。因为Docker的跨平台的适配性,相当于为用户提供了一个非常有用的应用商店,所有人都可以自由下载微服务组件

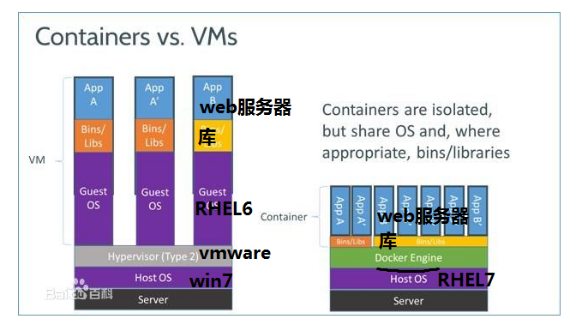

Docker的优势

1.更高效的利用系统资源

由于容器不需要进行硬件虚拟及运行完整操作系统等额外开销,Docker对系统资源的利用率更高。无论是应用执行速度、内存损耗或者文件存储速度,都要比传统虚拟机技术更高效。因此相比虚拟机技术,一个相同配置的主机,往往都可以运行更多数量的应用。

2.更快速的启动时间

传统的虚拟机技术启动应用服务往往需要数分钟,而docker容器应用,由于直接运行于宿主内核,无需启动完整的操作系统,因此可以做到秒级、甚至毫秒级的启动时间。大大的节约了开发、测试、部署时间。

3.一致的运行环境

开发过程中一个常见的问题是环境一致性的问题。由于开发环境、测试环境、生产环境不一致,导致有些bug并未在开发过程中被发现。而Docker的镜像提供了出内核外完整的运行时环境,确保了应用运行环境的一致性。

4.持续交付和部署(CI、CD)

对于开发和运维(DevOps)人员来说,最希望的就是一次创建或配置,可以在任意地方正常运行。

使用Docker可以通过制定应用镜像来实现持续集成、持续交付、部署。开发人员可以通过Dockerfile来进行镜像构建,并结合持续集成(Continuous Integration)系统进行集成测试,而运维人员则可以直接在生产环境中快速部署该镜像,甚至结合持续部署(Continuous Delivery/Deployment)系统进行自动部署。

5.更轻松的迁移

由于Docker确保了执行环境的一致性,使得应用迁移更加容易。Docker可以在很多平台上运行,无论是物理机、虚拟机、公有云、私有云,甚至是笔记本,其运行结果是一致的。因此用户可以很轻易的将在一个平台上运行的应用,迁移到另一个平台上,而不用担心运行环境的变换导致应用无法正常运行的情况。

6.更轻松的维护和扩展

Docker使用分层存储以及镜像的技术,使得应用重复部分的复用更为容易,也使得应用的维护更新更加简单,基于基础镜像进一步扩展镜像也变得非常简单。此外,Docker团队同各个开源项目团队一起维护了一大批高质量的官方镜像,既可以直接在生产环境使用,又可以作为基础进一步定制,大大降低了应用服务的镜像制作成本。

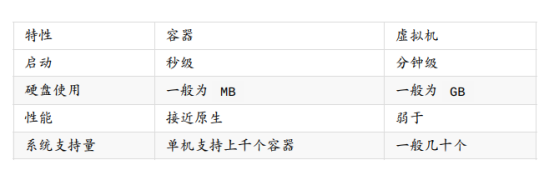

Docker容器与传统虚拟化比较

| 特性 | Docker容器 | 虚拟机 |

|---|---|---|

| 启动速度 | 秒级 | 分钟级 |

| 计算机能力消耗 | 几乎无 | 损耗50%左右 |

| 性能 | 接近原生 | 弱于 |

| 系统支持量(单机) | 上千个 | 几十个 |

| 隔离性 | 资源限制 | 完全隔离 |

| 硬盘使用 | 一般为MB | 一般为GB |

Docker特性

文件系统隔离:每个进程容器运行在一个完全独立的根文件系统里。

资源隔离:系统资源,像CPU和内存等可以分配到不同的容器中,使用cgroup。

网络隔离:每个进程容器运行在自己的网络空间,虚拟接口和IP地址。

日志记录:Docker将会收集和记录每个进程容器的标准流(stdout/stderr/stdin),用于实时检索或批量检索。

变更管理:容器文件系统的变更可以提交到新的镜像中,并可重复使用以创建更多的容器。无需使用模板或手动配置。

交互式shell:Docker可以分配一个虚拟终端并关联到任何容器的标准输入上,例如运行一个一次性交互shell。

优点:

1.一些优势和VM一样,但不是所有都一样。

比VM小,比VM快,Docker容器的尺寸减小相比整个虚拟机大大简化了分布到云和从云分发时间和开销。Docker启动一个容器实例时间很短,一两秒就可以启动一个实例。

2.对于在笔记本电脑,数据中心的虚拟机,以及任何的云上,运行相同的没有变化的应用程序,IT的发布速度更快。

Docker是一个开放的平台,构建,发布和运行分布式应用程序。

Docker使应用程序能够快速从组件组装和避免开发和生产环境之间的摩擦。

3.您可以在部署在公司局域网或云或虚拟机上使用它。

4.开发人员并不关心具体哪个Linux操作系统,使用Docker,开发人员可以根据所有依赖关系构建相应的软件,针对他们所选择的操作系统。然后,在部署时一切是完全一样的,因为一切都在DockerImage的容器在其上运行。开发人员负责并且能够确保所有的相关性得到满足。

5.Google,微软,亚马逊,IBM等都支持Docker。

6.Docker支持Unix/Linux操作系统,也支持Windows或Mac

缺点局限性:

1.Docker用于应用程序时是最有用的,但并不包含数据。日志,跟踪和数据库等通常应放在Docker容器外。 一个容器的镜像通常都很小,不适合存大量数据,存储可以通过外部挂载的方式使用。比如使用:NFS,ipsan,MFS等, -v 映射磁盘分区

一句话:docker只用于计算,存储交给别人。

oracle 不适合使用docker来运行,太大了,存储的数据太多。

Docker三大核心概念

镜像(Image)

- 一个只读的模板,镜像可以用来创建 Docker 容器

-

用户基于镜像来运行自己的容器。镜像是基于 Union 文件系统(UnionFS)的层式结构

-

可以简单创建或更新现有镜像,或者直接下载使用其他人的。可以理解为生成容器的『源代码』

操作系统分为内核和用户空间。对于Linux而言,内核启动后,会挂载root文件系统为其提供用户空间支持。而Docker镜像(Image),就相当于是一个root文件系统。

Docker镜像是一个特殊的文件系统,除了提供容器运行时所需的程序、库、资源、配置等文件外,还包含了一些为运行时准备的一些配置参数(如匿名卷、环境变量、用户等)。镜像不包含任何动态数据,其内容在构建之后不会改变。

镜像

Docker镜像(image)类似于虚拟机镜像,可以将它理解为一个面向Docker引擎的只读模板,包含了文件系统。

例如:一个镜像可以只包含一个完整的Centos操作系统环境,可以把它称为一个Centos镜像,镜像也可以安装了Nginx应用程序(或者用户需要的其他软件),可以把它称为一个Nginx镜像。

镜像是创建Docker容器的基础,通过版本管理和增量的文件系统,Docker提供了一套十分简单的机制(仓库)创建和更新现有镜像,用户可以从网上下载一个已经做好的应用镜像,并通过命令直接创建Docker容器来使用。

Docker运行容器前需要本地存在对应的镜像,如果镜像不存在本地,Docker会尝试先从默认镜像仓库下载(默认使用Docker Hub公共注册服务器中的仓库),用户也可以通过配置,使用自定义的镜像仓库。

1.分层存储

因为镜像包含操作系统完整的root文件系统,体积往往是庞大的,因此在Docker设计时,就充分利用Union FS技术,将其设计为分层存储的架构。所以严格来说,镜像并非是像ISO那样的打包文件,镜像只是一个虚拟的概念,其实际体现并非由一个文件组成,而是由一组文件系统组成,或者说由多层文件系统联合组成。

镜像构建时,会一层层构建,前一层是后一层的基础。每一层构建就不会再发生改变,后一层上的任何改变只发生在自己的这一层。比如,删除前一层文件的操作,实际不是真的删除前一层的文件,而是仅在当前层标记为该文件已删除。在最终容器运行的时候,虽然看不到该文件,但实际上该文件会一直跟随镜像。因此在构建镜像时,需要额外小心,每一层尽量只包含盖层需要添加的东西,任何额外的东西应在该层构建结束前清理掉。

分层存储的特征还使得镜像的复用、定制变得更为容易。甚至可以用之前构建好的镜像作为基础层,然后进一步添加新的层,以定制自己所需的内容,构建新的镜像。

容器(Container)

-

容器是从镜像创建的运行实例,在启动的时候创建一层可写层作为最上层(因为镜像是只读的)

-

可以被启动、开始、停止、删除。每个容器都是相互隔离的、保证安全的平台

-

可以把容器看做是一个简易版的 Linux 环境(包括root用户权限、进程空间、用户空间和网络空间等)和运行在其中的应用程序

容器(Container)和镜像(Image)的关系,就像是面向对象程序设计中的类和实例一样,镜像是静态的定义,容器是镜像运行时的实体。容器可以被创建、启动、停止、删除、暂停等。

容器的实质是进程,但与直接在宿主执行的进程不同,容器进程运行于属于自己的独立的命名空间(namespace)。因此容器可以拥有自己的root文件系统、自己的网络配置、自己的进程空间,甚至自己的用户ID空间。容器内的进程是运行在一个隔离的环境里,使用起来,好像是在一个独立于宿主的系统下操作一样。这种特性使得容器封装的应用比直接在宿主上运行更加安全。

镜像使用的是分层存储,容器也是如此。每一个容器运行时,是以镜像为基础层,在其上创建一个当前容器的存储层,可以称这个为容器运行时读写而准备的存储层为容器存储层。

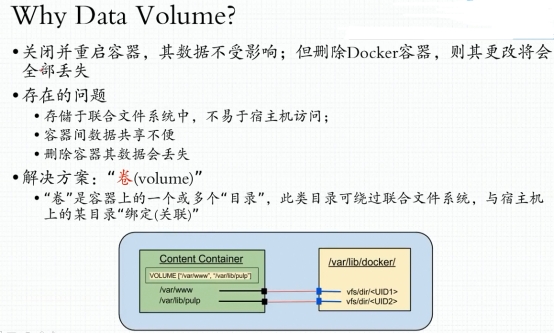

容器存储层的生存周期和容器一样,容器消亡时,容器存储层也随之消亡。因此,任何保存于容器存储层的信息都会随容器删除而丢失。

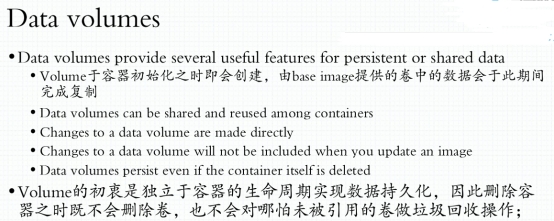

按照Docker最佳实践的要求,容器不应该向其存储层写入任何数据,容器存储层要保持无状态化。所有文件的写入操作,都应该使用数据卷(Volume)或者绑定宿主目录,在这些位置的读写会跳过容器存储层,直接对宿主(或网络存储)发生读写,性能和稳定性更高。

数据卷的生存周期独立于容器,容器消亡,数据不会消亡。因此,使用数据卷后,容器删除或者重新运行之后,数据却不会丢失

容器

Docker容器(Container)类似于一个箱子,可以把容器看做是一个简易的Linux系统环境(其中包括root用户权限,进程空间,用户空间和网路空间等),以及运行在其中的应用程序打包而成的一个箱子。Docker利用容器这个箱子来隔离和运行应用镜像。

容器是从镜像创建的应用运行实例,可以对他进行启动,停止,删除等常规操作。这些不同的容器之间都是相互隔离互不可见的。镜像自身是只读的,容器从镜像启动的时候,Docker会在镜像的最上层创建一个可写层,镜像本身将保持不变。

仓库(Repository )

-

集中存放镜像文件的场所,可以是公有的,也可以是私有的

-

最大的公开仓库是 Docker Hub

-

国内的公开仓库包括 Docker Pool 等

-

当用户创建了自己的镜像之后就可以使用

push 命令将它上传到公有或者私有仓库,这样下次在另外一台机器上使用这个镜像时候,只需要从仓库上pull下来就可以了 -

Docker 仓库的概念跟 Git 类似,注册服务器可以理解为 GitHub 这样的托管服务

-

另外 Docker 采用的是客户端/服务器架构,客户端只需要向 Docker 服务器或守护进程发出请求即可完成各类操作。那么问题来了,我们能用 Docker 来做什么呢?我们可以:

-

统一、优化和加速本地开发和构建流程

-

保证不同的环境中可以得到相同的运行结果

-

创建隔离环境用于测试

-

仓库

Docker仓库(Repostory)类似于代码的仓库(与svn、git、maven等概念类似)是Docker用来集中存放镜像文件的场所。

根据所存储的镜像是否公开分享,Docker仓库又分为:公开仓库和私有仓库。

顾名思义,公开仓库就是公共开放的镜像存储的地方,目前最大的公开仓库是Dokcer Hub (registry.hub.docker.com),存放了大量的镜像可供下载使用,国内的公开仓库有aliyun(acs-public-mirror.oss-cn-hangzhou.aliyuncs.com)。私有仓库是内部使用的私有不对外开放的仓库,用户可以内部自行搭建,内部分享镜像,方便快捷的分享专属环境的镜像文件

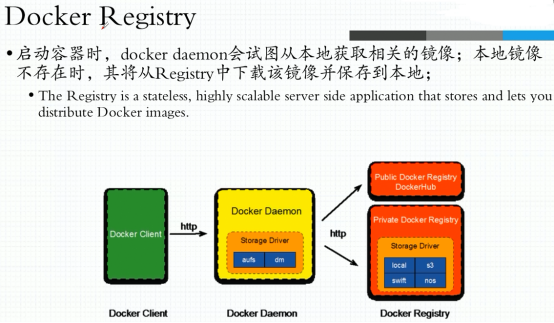

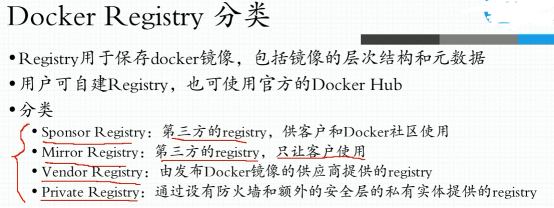

1.Docker Registry

镜像构建完成后,可以很容易的在当前宿主机上运行,但是,如果需要在其他服务器上使用这个镜像,就需要一个集中的存储、分发镜像的服务,Docker Registry就是这样的服务。

一个Docker Registry中可以包含多个仓库(Repository);每个仓库可以包含多个标签(Tag);每个标签对应一个镜像。

通常,一个仓库会包含同一个软件不同版本的镜像,而标签就常用于对应该软件的各个版本。可以通过<仓库名>:<标签>的格式来指定具体是该软件哪个版本的镜像。如果不给出标签,将以latest作为默认标签。

以Ubuntu镜像为例,ubuntu是仓库的名字,其内包含有不同的版本标签,如:16.04,18.04。可以通过ubuntu:14.04或者ubuntu:18.04来具体指定所需哪个版本的镜像。如果忽略了标签,比如ubuntu,那将视为ubuntu:latest。

仓库名经常以两段式路径形式出现,比如xxxx/nginx-proxy,前者往往意味着Docker Registry多用户环境下的用户名,后者往往是对应的软件名。但这并非绝对。

2.Docker Registry公开服务

Docker Registry公开服务是开放给用户使用、允许用户管理镜像的Registry服务。一般这类公开服务运行用户免费上传、下载公开的镜像,并可能提供收费收费服务供用户管理私有镜像。

最常使用的Registry公开服务是官方的Docker Hub,这也是默认的Registry,并提供大量的高质量的官方镜像。

由于某些原因,在国内访问这些服务可能会比较慢。国内的一些云服务商提供了针对Docker Hub的镜像服务(Registry Mirror),这些镜像服务被称为加速器。常见的有阿里云加速器、DaoCloud加速器等。使用加速器会直接从国内的地址下载Docker Hub的镜像。

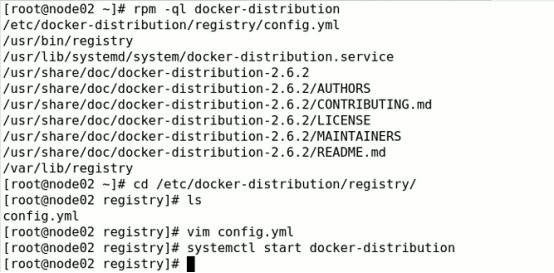

3.私有Docker Registry

除了使用公开服务外,用户还可以在本地搭建私有的Docker Registry。Docker官方提供了Docker Registry镜像,可以直接使用做为私有Registry服务。

开源的Docker Registry镜像只提供了Docker Registry API的服务端实现,足以支持docker命令,不影响使用。但不包含图形界面,以及镜像维护、用户管理、访问控制等高级功能。

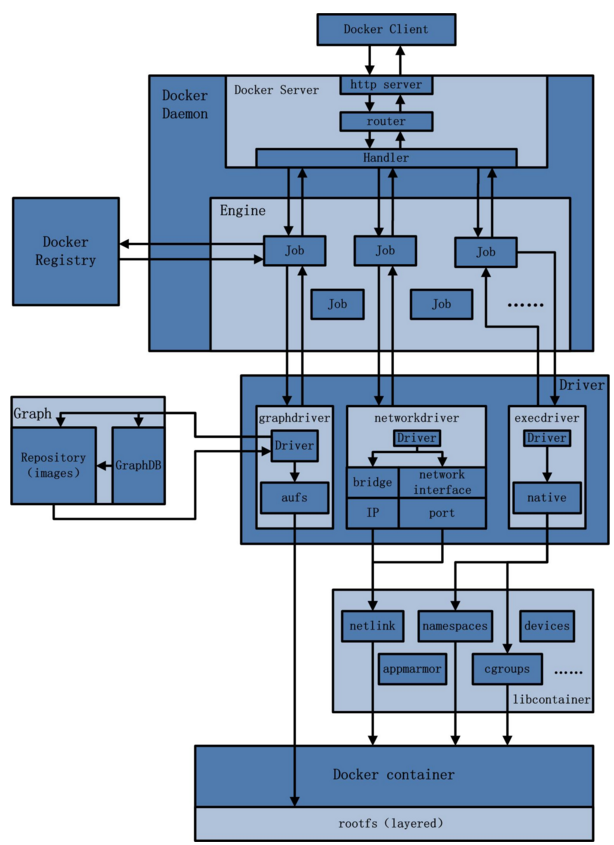

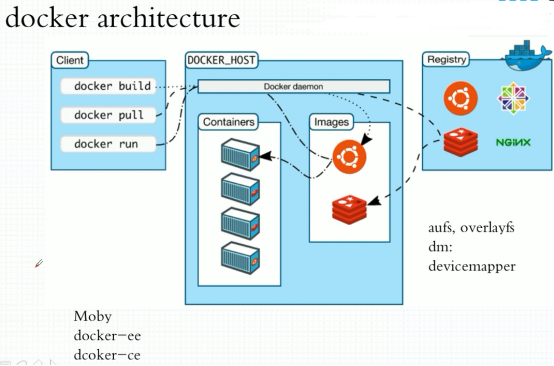

Docker架构概览

Docker架构:http://www.infoq.com/cn/articles/docker-source-code-analysis-part1/

Docker是一个典型的客户端/服务端(C/S)架构。

Docker采用C/S架构。系统管理员通过docker客户端与docker服务端进行交互

Docker服务器负责构建、运行和分发docker镜像

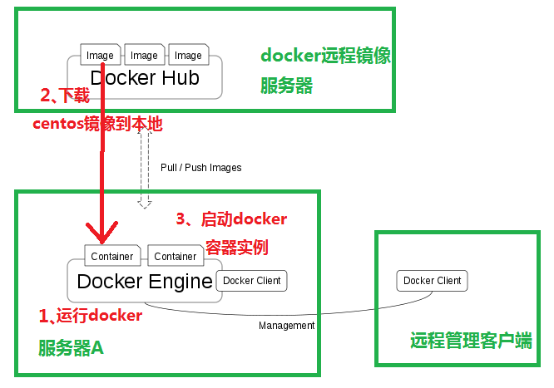

Docker的总架构图

工作流程:服务器A上运行docker Engine 服务,在docker Engine上启动很多容器container , 从外网Docker Hub上把image操作系统镜像下载来,放到container容器运行。这样一个容器的实例就运行起来了。

最后,通过Docker client 对docker 容器虚拟化平台进行控制。

Image和Container的关系:image可以理解为一个系统镜像,Container是Image在运行时的一个状态。\ 如果拿虚拟机作一个比喻的话,Image就是关机状态下的磁盘文件,Container就是虚拟机运行时的磁盘文件,包括内存数据。

dockerhub:dockerhub是docker官方的镜像存储站点,其中提供了很多常用的镜像供用户下载,如ubuntu, centos等系统镜像。通过dockerhub用户也可以发布自己的docker镜像,为此用户需要注册一个账号,在网站上创建一个docker仓库。

账号注册地址:https://hub.docker.com/

github : 有自己的帐号:1 没有:2

作为一个成功的开源人士或运维人才: 一定要注册一个github和dockerhub帐号。

为了?

各个功能模块的功能简述:

Docker client:

Docker client是一个泛称,用来向指定的Docker daemon发起请求,执行相应的容器管理操作。它既可以使docker命令行工具,也可以是任何遁循了Docker API的客户端。

Docker daemon:

Docker daemon是Docker架构的主要用户接口,也是最核心的后台进程(service docker start 就是启动DOcker daemon进程),它负责响应来自Docker client的请求,然后将这些请求翻译成系统调用完成容器管理操作。该进程会在后台启动一个API server,负责接收由Docker client 发送的请求;接收到的请求将通过Docker daemon内部的一个路由分发调度,再由具体函数来执行请求。

Graph:

Graph组件负责维护已下载的镜像信息及它们之间的关系,所以大部分Docker镜像相关的操作都会由graph组件来完成。graph通过镜像"层"和每层的元数据来记录这些镜像的信息,用户发起的镜像管理操作最终都转换成了graph对这些层和元数据的操作。但正是由于这个原因,而且很多时候Docker操作都需要加载当前Docker daemon维护者的所有镜像信息,graph组件常常会成为性能瓶颈。

GraphDB:

Docker daemon通过GraphDB记录它所维护的所有容器以及它们之间的link关系,所以这里就采用了一个图结构来保存这些数据。具体来说,GraphDB就是一个基于SQLite的最简单版本的图形数据库,能够为调用者提供节点、删、遍历、连接、所有父子节点的查询等操作。这些节点对应的就是一个容器,而节点间的边就是一个Docker link关系。每创建一个容器,Docker daemon都会在GraphDB里添加一个节点,而当为某个容器设置了link操作后,在GraphDB中就会为它创建一个父子关系。

drive:

Docker通过driver模块来实现对Docker容器执行环境的定制。Docker daemon负责将用户请求转译成系统调用,为了将这些系统调用抽象成统一的操作接口方便调用者使用,Docker把这些操作分类成容器管理驱动(execdriver)、网络管理驱动(networkdriver)、文件存储驱动(graphdriver)三种。

execdriver是对Linux操作系统的namespace、cgroups、apparmor、SELinux等容器运行所需的系统操作进行的一层二次封装,其本质作用类似于LXC,但功能更全面。execdriver最主要的实现是Docker官方编写的libcontainer库。libcontainer是一个独立的容器管理包,networkdriver和execdriver都通过libcontainer来实现对容器的具体操作(包括利用UTS、IPC、PID、Network、Mount、User等namespace来实现容器之间的资源隔离和利用cgroup实现对容器的资源限制)。当运行容器的命令执行完毕后,一个实际的容器就处于运行状态,该容器拥有独立的文件系统、安全且相互隔离的运行环境。

networkdriver是对容器网络环境操作所进行的封装。对于容器来说,网络设备的配置相比较独立,并且应该允许用户进行更多的配置。这些操作具体包括创建容器通信所需的网络,容器的network namespace,这个网络所需的虚拟网卡,分配通信所需的IP,服务访问的端口和容器与宿主机之间的端口映射(设置hosts、resolv.conf、iptables等)。

graphdriver是所有与容器镜像相关操作的最终执行者。graphdriver会在Docker工作目录下维护一组与镜像层对应的目录,并记下容器和镜像之间的关系等元数据。这样,用户对镜像的操作最终会被映射成对这些目录文件及元数据的增删改查,从而屏蔽掉不同文件存储实现对于上层调用者的影响。目前Docker已经支持的文件存储包括aufs、btrfs、devicemapper、overlay和vfs.

daemon 对象的创建和初始化过程

Docker容器的配置信息:

容器的配置信息主要功能是供用户自由配置Docker容器的可选功能,使得Docker容器的运行更贴近用户期待的运行场景,配置信息的处理包含以下部分:

设置默认的网络最大传输单元:当用户没有对-mtu参数进行指定时,将其设置为1500.否则,沿用用户指定的参数值。

检测网桥配置信息:此部分配置为进一步配置Docker网络提供铺垫。

查验容器通信配置:主要用于确定用户设置是否允许对iptables配置及容器间通信,分别用--iptables和--icc参数表示,若两者皆为false则报错。

验证系统支持及用户权限:

初步处理完Docker的配置信息之后,Docker对自身运行的环境进行了一系列的检查,主要包括:

操作系统类型对Docker daemon的支持,目前Docker daemon只能运行在Linux系统上。

用户权限的级别,必须是root权限。

内核版本上与处理器的支持,只支持"amb64"架构的处理器,且内核版本必须升至3.10.0及以上。

配置daemon工作路径:

配置Dockerdaemon的工作路径,主要是创建Docker daemon运行中所在的工作目录,默认为/var/lib/docker。若目录不存在,则会创建并赋予"0700"权限。

配置Docker容器所需的文件环境:

这一步Docker daemon会在Docker工作根目录/var/lib/docker下面初始化一些重要的目录和文件来构建Docker容器工作所需的文件系统环境。

配置graphdriver目录,它用于完成Docker镜像管理所需的联合文件系统的驱动层。所以,这一步的配置工作就是加载并配置镜像存储驱动graphdriver,创建镜像管理所需的目录和环境。

创建容器配置文件目录。Docker daemon在创建Docker容器之后,需要将容器内的配置文件放到这个目录下统一管理。目录默认位置为:/var/lib/docker/containers,它下面会为每个具体容器创建一个目录,下面保存一些配置文件。

配置镜像目录,主要工作是:在工作根目录下创建一个graph目录来存储所有镜像描述文件,默认目录为/var/lib/docker/graph。对于每一个镜像层,Docker在这里使用json和layersize两个文件描述这一层镜像的父镜像ID和本层大小,而正在的镜像内容保存在aufs的diff工作目录的同名目录下。

创建volume驱动目录(默认/var/lib/docker/volumes),Docker中volume是宿主机上挂载到Docker容器内部的特定目录。由于Docker需要使用graphdriver来挂载这些volumes,所以采用vfs驱动实现volumes的管理。这里的volumes目录下仅保存一个volume配置文件config.json,其中会以Path指出这个目录的真正位置。

准备"可信镜像"所需的工作目录。在Docker工作目录下创建trust目录,并创建一个TrustStore。这个存储目录可以根据用户给出的可信url加载授权文件,用来处理可信镜像的授权和验证过程。

创建TagStore,用于存储镜像的仓库列表。

创建Docker daemon网络

创建GraphDB。这一步初始化GraphDB实际上就是建立数据库连接的过程。

初始化execdriver.

恢复已有的Docker容器。当Docker daemon启动时,会去查看在daemon.repository也就是在/var/lib/docker/containers/中的内容。若有已经存在的Docker容器,则将相应的信息收集并进行维护,同时重启restart policy为always的容器。

Docker daemon进程的启动都要遵循以下3步:

首先启动一个APIServer,它工作在用户通过-H指定的socker上面

然后Docker使用NewDaemon方法创建一个daemon对象来保存信息和处理业务逻辑。

最后将上述APIServer和daemon对象绑定起来,接受并处理client的请求。

libcontainer详解:http://www.infoq.com/cn/articles/docker-container-management-libcontainer-depth-analysis

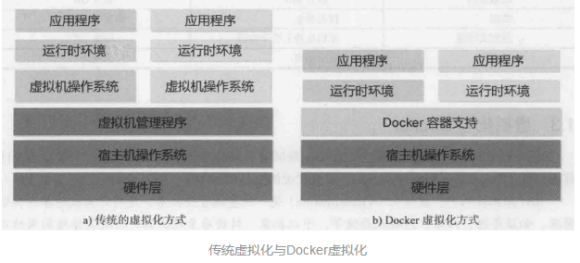

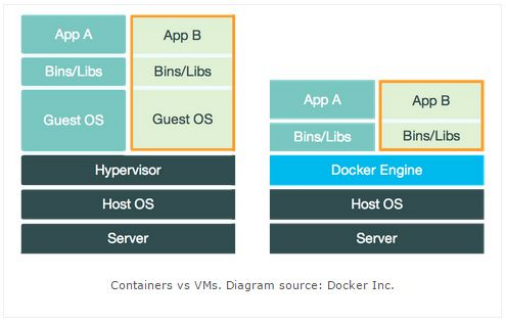

Docker容器技术和虚拟机对比

传统方式是在硬件层面实现虚拟化,需要有额外的虚拟机管理应用和虚拟机操作系统层。Docker容器是在操作系统层面上实现虚拟化,直接复用本机本地的操作系统,因此更加轻量级,性能方面也更加高效。Docker 从 0.9 版本开始使用 libcontainer 替代 lxc

相同点: docker容器技术和虚拟机技术,都是虚拟化技术。

不同点:容器除了运行其中应用外,基本不消耗额外的系统资源,使得应用的性能很高,同时系统的开销尽量小。传统虚拟机方式运行 10 个不同的应用就要起 10 个虚拟机,而Docker 只需要启动 10 个隔离的应用即可。

传统虚拟化与Docker

对比传统虚拟机总结

总结:docker相对于VM虚拟机,少了虚拟机操作系统这一层,所以docker效率比虚拟机高你的物理系统启动使用几秒? 10秒

在docker上启动一个实例 1-2秒 吃鲸吗?:哈哈

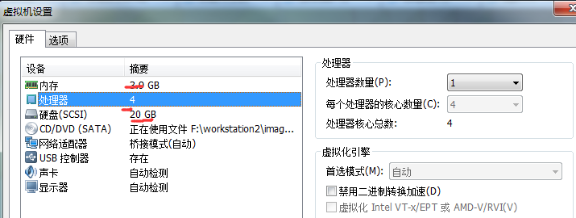

Docker 核心技术

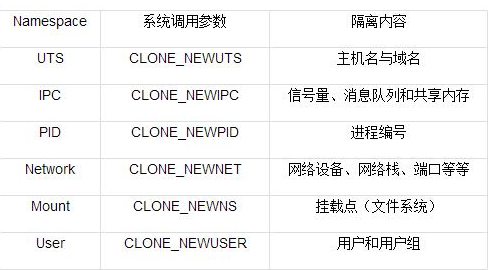

1.Namespace --- 实现Container的进程、网络、消息、文件系统和主机名的隔离。

2.Cgroup --- 实现对资源的配额和度量。

注:Cgroup的配额,可以指定实例使用的cpu个数,内存大小等。就像如下图,vmware虚拟机中的硬件配置参数。

Linux 3.8内核中包括了6种命名空间:

| 命名空间 | 描述 |

|---|---|

| Mount(mnt) | 隔离挂载点 |

| Process ID(process) | 隔离进程ID |

| Network(net) | 隔离网络设备、协议栈、端口等 |

| InterProcess Communication(ipc) | 隔离进程间通信 |

| UTS | 隔离Hostname和NIS域名 |

| User ID(user) | 隔离用户和group ID |

还有一个CGroup Name Space,和上述这些命名空间是container技术的一个基础。

链接:https://www.jianshu.com/p/369e50201bce

容器技术内核特性

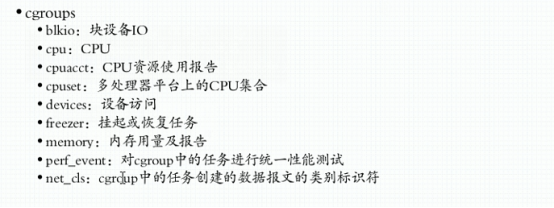

(1)Cgroup

Cgroup是control group,又称为控制组,它主要是做资源控制。原理是将一组进程放在放在一个控制组里,通过给这个控制组分配指定的可用资源,如:cpu、memory、IO等,达到控制这一组进程可用资源的目的。

-

限制进程组可以使用的资源数量(Resource limiting )。比如:memory子系统可以为进程组设定一个memory使用上限,一旦进程组使用的内存达到限额再申请内存,就会触发OOM(out of memory)。

-

进程组的优先级控制(Prioritization )。比如:可以使用cpu子系统为某个进程组分配特定cpu share。

-

记录进程组使用的资源数量(Accounting )。比如:可以使用cpuacct子系统记录某个进程组使用的cpu时间

-

进程组隔离(Isolation)。比如:使用ns子系统可以使不同的进程组使用不同的namespace,以达到隔离的目的,不同的进程组有各自的进程、网络、文件系统挂载空间。

-

进程组控制(Control)。比如:使用freezer子系统可以将进程组挂起和恢复。

(2)Namespace,命名空间

Namespace又称为命名空间,它主要实现容器与容器之间的访问隔离。其原理是针对一类资源进行抽象,并将其封装在一起提供给一个容器使用,对于这类资源,因为每个容器都有自己的抽象,而他们彼此之间是不可见的,所以就可以做到访问隔离。

pid namespace:不同的容器会产生不同的进程id

net namespace:每个容器都存在独立的网络

ipc namespace:每个容器都可以单独实现信号的发起和消息队列

mnt namespace:一个进程放到一个特定的目录执行

uts namespace:每个container拥有独立的hostname和domain name

user namespace:每个container可以有不同的 user 和 group id

Docker里的内核知识

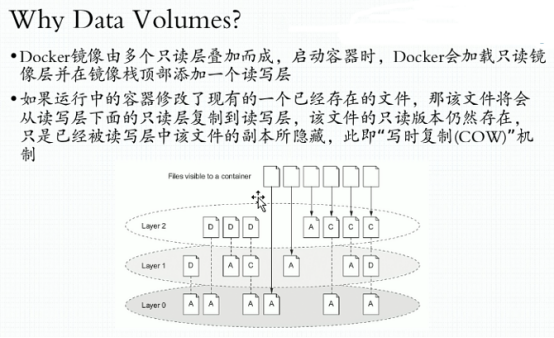

Docker容器本质是宿主机上的进程,Docker通过namespace实现了资源隔离,通过cgroups实现了资源限制,通过写时复制机制(copy-on-write)实现了高效的文件操作。

namespace资源隔离

linux内核中提供了6种namespace隔离的系统调用,如下图:

实际上,Linux内核实现namespace的主要目的之一就是实现轻量级虚拟化(容器)服务。在同一个namespace下的进程可以感知彼此的变化,而对外界的进程一无所知。这样就可以让容器中的进程产生错觉,仿佛自己置身于一个独立的系统环境中,以达到独立和隔离的目的。

进行namespace API操作的四种方式包括clone()在创建新进场的同时创建namespace,sent()加入一个已经存在的namespace以及unshare()在原先进场上进行namespace隔离还有/pro下的部分文件。为了确定隔离的到底是哪6项namespace,在使用这些API时,通常需要制定以下6个参数的一个或多个,通过|(位或)操作来实现。这6个参数就是上图上面那6个系统调用参数。

下面对6种namespace做下简单介绍:

UTS namespace: UTS(UNIX Time-sharing System)namespace提供了主机名和域名的隔离,这样每个Docker容器就可以拥有独立的主机名和域名了。在网络上可以被视作一个独立的节点,而非宿主机上的一个进程。Docker中,每个镜像基本都以自身所提供的服务名称来命名镜像的hostname,且不会对宿主机产生任何影响,其原理就是利用UTS namespace。

IPC namespace:进程间通信(Inter-Process Communication,IPC)涉及的IPC资源包括常见的信号量、消息队列和共享内存。申请IPC资源就申请了一个全局唯一的32位ID,所以IPC namespace中实际上包含了系统IPC标识符以及实现POSIX消息队列的文件系统。在同一个IPC namespace下的进程彼此可见,不同IPC namespace下的进程互相不可见。目前使用IPC namespace机制其中比较有名的有PostgreSQL。Docker当前也使用IPC namespace实现了容器与宿主、容器与容器之间的IPC隔离。# ipcs -q #可以查看已经开启的message queue。

PID namespace : PID namespace隔离非常实用,它对进程PID重新标号,即两个不同namespace下的进程可以有相同的PID。 每个PID namespace都有自己的计数程序。内核为所有的PID namespace维护了一个树状结构,最顶层的是系统初始时创建的,被称为root namespace。它创建的新的PID namespace被称为child namespace(树的子节点),而原先的PID namespace就是新创建的PID namespace的parent namespace(树的父节点)。通过这种方式,不同的PID namespace会形成一个层级体系。所属的父节点可以看到子节点的进程,并可以通过信号灯方式对子节点中的进程产生影响。反过来,子节点却不能看到父节点的PID namespace中的任何内容。

Network namespace : network namespace主要提供了关于网络资源的隔离,包括网络设备、IPV4和IPV6协议栈、IP路由表、防火墙、/proc/net目录、/sys/class/net目录、套接字(socket)等。一个物理的网络设备最多存在于一个network namespace中,可以通过创建veth pair(虚拟网络设备对:有两端,类似管道,如果数据从一端传入另一端也能接收到)在不同的network namespace间创建通道,以达到通信目的。

Mount namespace : 通过隔离文件系统挂载点对隔离文件系统提供支持,它是历史上第一个Linux namespace,所以标示位比较特殊,就是CLONE_NEWNS。隔离后不同mount namespace中的文件结构发生变化也互不影响。可以通过/proc/[pid]/mounts查看所有挂载到当前namespace中的文件系统,还可以通过/proc/[pid]/mountstats看到mount namespace中文件设备的统计信息,包括挂载文件的名字、文件系统类型、挂载位置等。进程在创建mount namespace时,会把当前的文件结构复制给新的namespace。新的namespace中的所有mount操作都只影响自身的文件系统,对外界不会产生任何影响。

user namespace : 这个主要隔离了安全相关的标识符(identifiers)和属性(attributes),包括用户ID、用户组ID、root目录、key(指密钥)以及特殊权限。user namespace直到Linux内核3.8版本的时候还未完全实现

cgroups资源限制

cgroups在2007年更名为(control groups)并整合进Linux内核。cgroups可以限制、记录任务组所使用的物理资源(包括CPU、memory、IO等),为容器实现虚拟化提供了基本保证,是构建Docker等一系列虚拟化管理工具的基石。

cgroups的作用:

实现cgroups的主要目的是为不同用户层面的资源管理,提供一个统一化的接口。从单个任务的资源控制到操作系统层面的虚拟化,cgroups提供了以下四大功能:

资源限制 #cgroups可以对任务使用的资源总额进行限制。如设定应用运行时使用内存的上限,一旦超过这个配额就发出OOM(Out of Memory)提示。

优先级分配 #通过分配的CPU时间片数量及磁盘IO带宽大小,实际上就相当于控制了任务运行的优先级。

资源统计 #cgroups可以统计系统的资源使用量,如CPU使用时长、内存用量等,这个功能非常适用于计费。

任务控制 #cgroups可以对任务执行挂起、恢复等操作。

cgroups术语表:

task(任务) #在cgroups的术语中,任务表示系统的一个进程或线程。

cgroups(控制组) #cgroups中的资源控制都以cgroup为单位实现。cgroup表示按某种资源控制标准划分而成的任务组,包含一个或多个子系统。一个任务可以加入某个cgroup,也可以从某个cgroup迁移到另一个cgroup。

subsystem(子系统) #cgroups中的子系统就是一个资源调度控制器。比如CPU子系统可以控制CPU时间分配,内存子系统可以限制cgroup内存使用量。

hierarchy(层级) #层级由一系统cgroup以一个树状结构排列而成,每个层级通过绑定对应的子系统进行资源控制。层级中的cgroup节点可以包含零或多个子节点,子节点继承父节点挂载的子系统。整个操作系统可以有多个层级。

cgroups、任务、子系统、层级四者间的关系以及基本规则:

规则1: 同一个层级可以附加一个或多个子系统。

规则2:一个子系统可以附加到多个层级,当且仅当目标层级只有唯一一个子系统时。

规则3:系统每次新建一个层级时,该系统上的所有任务默认加入这个新建层级的初始化cggroup,这个cgroup也被称为root cgroup。对于创建的每个层级,任务只能存在于其中一个cgroup中,即一个任务不能存在于同一个层级的不同cgroup中,但一个任务可以存在于不同层级中的多个cgroup中。如果操作时把一个任务添加到同一个层级中的另一个cgroup中,则会将它从第一个cgroup中移除。

规则4: 任务在for/clone自身时创建的子任务默认与原任务在同一个cgroup中,但是子任务允许被移动到不同的cgroup中,即fork/clone完成后,父子任务间在cgroup方面是互不影响的。

子系统简介:

子系统实际上就是cgroups的资源控制系统,每种子系统独立地控制一种资源。目前Docker使用如下9种子系统:

bikio # 可以为块设备设定输入/输出限制,比如物理驱动设备(包括磁盘、固态硬盘、USB等)

cpu # 使用调度程序控制任务对CPU的使用

cpuacct # 自动生成cgroup中任务对CPU资源使用情况的报告。

cpuset # 可以为cgroup中的任务分配独立的CPU(此处针对多处理器系统)和内存。

devices # 可以开启或关闭cgroup中任务对设备的访问

freezer # 可以挂起或恢复cgroup中的任务

memory # 可以设定cgroup中任务对内存使用量的设定,并且自动生成这些任务对内存资源使用情况的报告。

perf_event # 使用后使cgroup中的任务可以进行统一的性能测试。

*net_cls # Docker没有直接使用它,它通过使用等级标识符(classid)标识网络数据包,从而允许Linux流量控制程序(Traffic Controller,TC)识别从具体cgroup中生成的数据包。

cgroup实现方式及工作原理简介:

cgroups的实现本质上是给任务挂上钩子,当任务运行的过程中涉及某种资源时,就会触发钩子上所附带的子系统进行检测,根据资源类别的不同使用对应的技术进行资源限制和优先级分配。

cgroups如何判断资源超限及超出限额之后的措施: 对于不同的系统资源,cgroups提供了统一的接口对资源进行控制和统计,但限制的具体方式则不仅相同。比如memory子系统,会在描述内存状态的"mm_struct"结构体重记录它所属的cgroup,当进程需要申请更多内存时,就会触发cgroup用量检测,如果用量超过cgroup规定的限额则拒绝用户的内存申请,否则就给予相应内存并在cgroup的统计信息中记录。实际实现要比以上描述复杂得多,不仅需要考虑内存的分配与回收,还需考虑不同类型的内存和Cache(缓存)和Swap(交换区内存拓展)等。

cgroups的子系统与任务之间的关联关系: cgroup与任务之间是多对多的关系。所以它们并不直接关联,而是通过一个中间结构把双向的关联信息记录起来。每个任务结构体task_struct中都包含了一个指针,可以查询到对应cgroup的情况,同时也可以查询到各个子系统的状态,这些子系统状态中也包含了找到任务的指针,不同类型的子系统按需定义本身的控制信息结构体,最终在自定义的结构体中把子系统状态指针包含进去,然后内核通过container_of(这个宏可以通过一个机构体的成员找到结构体自身)等宏定义来获取对应的结构体,关联到任务,以此达到资源限制的目的。同时为了让cgroups便于用户理解和使用,也为了用精简的内核代码为cgroup提供熟悉的权限和命名空间管理,内核开发者们按照Linux虚拟文件系统转换器(Virtual Filesystem Switch,VFS)接口实现了一套名为cgroup的文件系统,非常巧妙的用来表示cgroups的层级概念。把各个子系统的实现都封装到文件系统的各项操作中

Docker Hub

目前Docker官方维护了一个公有仓库https://hub.docker.com,其中已经有上万个镜像。大部分需求都可以通过在Docker Hub中直接下载镜像来实现。

仓库是集中存放镜像的地方。一个容易与之混淆的概念是注册服务器(Registry).实际上注册服务器是存放仓库的具体服务器,每个服务器上可以有多个仓库,而每个仓库下面有多个镜像。从这方面来说仓库可以被认为是一个具体的项目或目录。

仓库又分共有仓库和私有仓库

登录 DockerHub账户:

用户通过拥有一个Docker Hub账户,用以提交和推送自己的镜像。当用户在未登录状态下输入docker login命令后,Docker client端将提示用户依次输入Username、 Password和Email,并存放到用户希望登录的registry对应的配置文件中。若用户处于已登录状态且没有尝试以新用户身份重新登录,则根据配置文件中的既有信息来获取用户信息。其后,Docker client向Docker server发送"post/auth"的HTTP请求,进行权限认证。Docker server接受到相应的HTTP请求后,根据URL以及请求方法来确定需要执行的方法,认证的方法为postAuth。

在postAuth这个方法执行的过程中,根据HTTP请求中的配置信息,由daemon实例调用Auth函数来进行认证工作,并将函数返回状态(即认证是否通过)写入HTTP应答。

Auth函数代码实现包括如下几个关键步骤:

根据config中的registry address,得到有效的index配置信息

由返回的Index配置信息解析获得一个registry endpoint.

重置config中的registry address为上一步返回的endpoint.

执行Login函数登入该registry endpoint。

上述Login函数真正负责进行用户登录的实现过程。它会根据Docker registry的版本分别执行Login V2和Login V1.

基本操作:

无需登录就可以进行:docker search 和docker pull操作

根据是否为官方提供,可将这些镜像资源分为两类。一种是类似于centos这样的基础镜像,称为基础或根镜像。这些镜像是由docker公司创建、验证、支持、提供。这样的镜像往往使用单个单词作为名字。还有一种类型,比如tianon/centos镜像,它是由DockerHub的用户tianon创建并维护的,带有用户名称为前缀,表明是某用户的某仓库。可以通过用户名称前缀user_name/来指定使用某个用户提供的镜像.

# docker search centos --filter=stars=5000 # 显示评价为5000星以上的镜像

NAME DESCRIPTION STARS OFFICIAL AUTOMATED

centos The official build of CentOS. 5556 [OK]

用户可以再登录的情况下通过docker push命令将本地的镜像推送到Docker Hub

自动创建:

自动创建功能对于需要经常升级镜像内程序来说十分方便,自动创建功能使得用户通过Docker Hub指定跟踪一个目标网站(目前支持GitHub或BitBucket)上的项目,一旦项目发现新的提交,则会自动执行创建。要配置自动创建,包括如下的步骤:

1). 创建并登录Docker Hub,以及目标网站;*在目标网站中连接账户到Docker Hub。

2). 在Docker Hub中配置一个自动创建。

3).选取一个目标网站中的项目(需要含Dockerfile)和分支

4).指定Dockerfile的位置,并提交创建。

之后可以再Docker Hub的“自动创建”页面跟踪每次创建的状态

Pull镜像:

Docker的server端收到用户发起的pull请求后,需要做的主要工作如下:

1、根据用户命令行参数解析出其希望拉取的repository信息

2、通过TagStore设置锁,保证Docker daemon在一个时刻对一个repository只能进行一个拉取操作;拉取镜像完毕之后该锁释放。

3、获取endpoint信息,并向该endpoint指定的registry发起会话

4、如果待拉取repository为official版本或者endpoint的API版本为V2,同时用户没有配置Docker-Mirrors,Docker就直接向V2 registry拉取镜像。(如果向V2 registry拉取镜像失败,则尝试从V1 registry拉取。)

5、获取V2 registry的endpoint。

6、由endpoint和待拉取镜像名称获取拉取指定镜像的认证信息。

7、如果tag值为空,即没有指定标签,则获取V2 registry中repository的tag list,然后对于tag list中的每一个标签,都执行一次pullV2Tag方法。该方法的功能分为两大部分,一是验证用户请求,二是当且仅当某一层不在本地时进行拉取这一层文件到本地。如果tag值不为空,则只对指定标签的镜像进行上述工作

Commit镜像:

docker commit命令只提交容器镜像发生变更了的部分,即修改后的容器镜像与当前仓库中对应镜像之间的差异部分,这使得该操作实际需要提交的文件往往并不多。Docker server接收到对应的HTTP请求后,需要执行下面的步骤:

根据用户输入pause函数的设置确定是否暂停该Docker容器的运行。

寻找该容器文件系统再graphdriver上的路径。

返回该容器与其父镜像的差异并将这部分文件和目录打成压缩包,即待commit容器的可读写层的差异(diff)。

graphdriver根据返回的差异创建一个新的镜像,记录其元数据。

将上述镜像文件及目录上传至repository。

Build构建镜像:

Docker client端通过Dockerfile完成相关信息的设置之后,Docker client向Docker server发送“POST/build”的HTTP请求,包含了所需的context信息(文件或目录)。

Docker server端接受到相应的HTTP请求后,需要做的工作如下:

创建一个临时目录。并将context制定的文件系统解压到该目录下。

读取并解析Dockerfile

根据解析出的DOckerfile遍历其中的所有指令,并分发到不同的模块去执行。Dockerfile每条指令的格式均为INSTRUCION arguments,INSTRUCION是一些特定的关键词,包括FROM、RUN、USER等,都会映射到不同的parser进行处理。

parser为上述每一个指令创建一个对应的临时容器,然后通过commit使用此容器生成一层镜像。

Dockerfile中偶的指令对应的层的集合,就是此次build后的结果。其中最后一次commit生成的层镜像ID就会作为最终的镜像ID返回。

Push镜像:

当用户制作了自己的镜像后,希望将它上传至仓库,此时可以通过docker push命令完成该操作。而在Docker server接收到用户的push请求后的关键步骤如下:

解析出repository信息,通过TagStore设置锁。

通过ping操作检查指定的registry是否可用,返回一个registry endpoint,然后发起同registry的会话.

如果推送的镜像为Official镜像或者endpoint对应版本为V2 registry,则调用pushV2 Repository方法。这个方法会首先验证用户指定标签的镜像在本地是否存在,以及被推repository的访问权限。接下来,对于不同标签的待推送镜像,该方法会从顶向下逐个检验layer其checksum,标记被推送repository中不存在的layer和更改过的读写层内容。将这些标记后的镜像内容上传完毕后,再讲一份描述文件manifest上传到repository。

如果镜像不属于上述情况,则Docker会调用push Repository方法来推送镜像到V1 registry,并根据待推送的repository和tag信息保证当且仅当某layer在endpoint上不存在时,才上传该layer。

部署docker容器虚拟化平台

Docker官网:https://www.docker.com/

官网文档:https://docs.docker.com/

Docker中文社区:http://www.docker.org.cn/

一键部署参考:https://www.jianshu.com/p/34d3b4568059

Docker版本:

docker.io ,docker ,docker-engine 两个docker发行版本。

Docker的版本:

Docker-CE:Docker Commutication Enterprise

Docker-EE:企业版本

Docker分为CE和EE版本。CE为社区版(免费,支持周期7个月),EE为企业版,强调安全,付费使用,支持周期24个月。

CE分位stable,test和nightly三个更新频道。

注意:切勿在没有配置Docker YUM源的情况下直接使用yum命令安装Docker。

安装的前提条件:

目前,CentOS 仅发行版本中的内核支持 Docker。

Docker 运行在 CentOS 7 上,要求系统为64位、系统内核版本为 3.10 以上。

~~Docker 运行在 CentOS-6.5 或更高的版本的 CentOS 上,要求系统为64位、系统内核版本为2.6.32-431或者更高版本。 #(建议不要运行在6版本及以下)~~

Docker安装的基本要求:

1、Docker只支持64位CPU架构的计算机,目前不支持32位CPU.

2、建议系统的Linux内核版本为3.10及以上。

3、Linux内核需开启cgroups和namespace功能。

4、对于非Linux内核的平台,如Microsoft Windows和OS X,需要安装使用Boot2Docker工具。

cgroups 是Linux内核提供的一种可以限制单个进程或者多个进程所使用资源的机制,可以对 cpu,内存等资源实现精细化的控制,下面是一个博客的介绍链接:http://blog.csdn.net/hzrandd/article/details/52484332

Namespaces(命名空间)机制提供一种资源隔离方案,介绍链接:https://www.cnblogs.com/cherishui/p/4237883.html

卸载旧版本

旧版本的Docker称为docker或者docker-engine,使用以下命令卸载。

[root@localhost ~]# yum remove docker \

docker-client \

docker-common \

docker-latest \

docker-latest-logrotate \

docker-logrotate \

docker-selinux \

docker-engine-selinux \

docker-engine

建立docker用户组

默认情况下,docker命令会使用Unix socket与Docker引擎通讯。而只有root用户和docker组的用户才可以直接访问Docker引擎的Unix socket。处于安全考虑,一般Linux系统上不会直接使用root用户。因此更好的做法是将需要使用的用户加入docker组里面

(1)docker用户加入docker用户组

# groupadd docker

(2)将用户加入到docker组

# usermod -aG docker USERNAME

安装docker的7种方法:

~~方法1、配置本地docker的yum源 #(建议不用)~~

~~方法2:直接使用centos系统自带的yum源安装,速度比较慢 #(建议不用)~~

方法3:清华源 https://mirrors.tuna.tsinghua.edu.cn/docker-ce/linux/centos/

方法4:参考官网:https://docs.docker.com/install/linux/docker-ce/centos/

使用官方安装脚本自动安装 (仅适用于公网环境)

curl -fsSL https://get.docker.com | bash -s docker --mirror Aliyun

方法5:https://get.daocloud.io/

方法6:二进制离线安装

1、下载

https://download.docker.com/linux/static/stable/x86_64/docker-18.06.3-ce.tgz

https://mirrors.aliyun.com/docker-ce/linux/static/stable/x86_64/

安装脚本参考 https://github.com/liumiaocn/easypack/blob/master/docker/install-docker.sh

#!/bin/sh

SYSTEMDDIR=/usr/lib/systemd/system

SERVICEFILE=docker.service

SERVICENAME=docker

DOCKERDIR=/usr/bin

DOCKERBIN=docker

SOCKETFILE=docker.socket

CONTAINERDFILE=containerd.service

Usage(){

echo "Usage: $0 ./FILE_NAME_DOCKER_CE_TAR_GZ"

echo " $0 ./docker-23.0.6.tgz"

echo "Get docker-ce binary from: https://download.docker.com/linux/static/stable/x86_64/"

echo "eg: wget -c https://download.docker.com/linux/static/stable/x86_64/docker-23.0.6.tgz"

echo "eg: curl -O --progress https://download.docker.com/linux/static/stable/x86_64/docker-23.0.6.tgz"

echo ""

}

#传入的参数不等于1就退出

if [ $# -ne 1 ]; then

Usage

exit 1

else

FILETARGZ="$1"

fi

if [ ! -f ${FILETARGZ} ]; then

echo "Docker binary tgz files does not exist, please check it"

echo "Get docker-ce binary from: https://download.docker.com/linux/static/stable/x86_64/"

echo "eg: wget https://download.docker.com/linux/static/stable/x86_64/docker-23.0.6.tgz"

echo "eg: curl -O --progress https://download.docker.com/linux/static/stable/x86_64/docker-23.0.6.tgz"

exit 1

fi

# 判断 docker 命令是否存在

if command -v docker >/dev/null 2>&1; then

echo "Docker is installed."

exit 3

else

echo "Docker is not installed."

fi

echo "##EXTRACT : tar xvpf ./${FILETARGZ} --strip-components=1"

tar xvf ./${FILETARGZ} -C ${DOCKERDIR} -o --touch --strip-components=1 --no-same-owner --owner=root --group=root

which ${DOCKERBIN}

echo

#create docker group

echo "##create docker group"

getent group docker &> /dev/null

test $? -eq 0 || groupadd docker

echo "##systemd service: ${SERVICEFILE}"

echo "##docker.service: create docker systemd file"

cat >${SYSTEMDDIR}/${SERVICEFILE} << EOF

[Unit]

Description=Docker Application Container Engine

Documentation=https://docs.docker.com

#After=network-online.target docker.socket firewalld.service containerd.service

After=network-online.target docker.socket containerd.service

Wants=network-online.target

Requires=docker.socket containerd.service

[Service]

Type=notify

# the default is not to use systemd for cgroups because the delegate issues still

# exists and systemd currently does not support the cgroup feature set required

# for containers run by docker

ExecStart=${DOCKERDIR}/dockerd -H fd:// --containerd=/run/containerd/containerd.sock

ExecReload=/bin/kill -s HUP \$MAINPID

TimeoutSec=0

RestartSec=2

Restart=always

# Note that StartLimit* options were moved from "Service" to "Unit" in systemd 229.

# Both the old, and new location are accepted by systemd 229 and up, so using the old location

# to make them work for either version of systemd.

StartLimitBurst=3

# Note that StartLimitInterval was renamed to StartLimitIntervalSec in systemd 230.

# Both the old, and new name are accepted by systemd 230 and up, so using the old name to make

# this option work for either version of systemd.

StartLimitInterval=60s

# Having non-zero Limit*s causes performance problems due to accounting overhead

# in the kernel. We recommend using cgroups to do container-local accounting.

LimitNOFILE=infinity

LimitNPROC=infinity

LimitCORE=infinity

# Comment TasksMax if your systemd version does not support it.

# Only systemd 226 and above support this option.

TasksMax=infinity

# set delegate yes so that systemd does not reset the cgroups of docker containers

Delegate=yes

# kill only the docker process, not all processes in the cgroup

KillMode=process

OOMScoreAdjust=-500

[Install]

WantedBy=multi-user.target

EOF

echo "##systemd service: ${SOCKETFILE}"

echo "##docker.socket: create socket systemd file"

cat >${SYSTEMDDIR}/${SOCKETFILE} << EOF

[Unit]

Description=Docker Socket for the API

[Socket]

ListenStream=/var/run/docker.sock

SocketMode=0660

SocketUser=root

SocketGroup=docker

[Install]

WantedBy=sockets.target

EOF

echo "##systemd service: ${CONTAINERDFILE}"

echo "##containerd.service: create containerd systemd file"

cat >${SYSTEMDDIR}/${CONTAINERDFILE} << EOF

# Copyright The containerd Authors.

#

# Licensed under the Apache License, Version 2.0 (the "License");

# you may not use this file except in compliance with the License.

# You may obtain a copy of the License at

#

# http://www.apache.org/licenses/LICENSE-2.0

#

# Unless required by applicable law or agreed to in writing, software

# distributed under the License is distributed on an "AS IS" BASIS,

# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

# See the License for the specific language governing permissions and

# limitations under the License.

[Unit]

Description=containerd container runtime

Documentation=https://containerd.io

After=network.target local-fs.target

[Service]

ExecStartPre=-/sbin/modprobe overlay

ExecStart=${DOCKERDIR}/containerd

Type=notify

Delegate=yes

KillMode=process

Restart=always

RestartSec=5

# Having non-zero Limit*s causes performance problems due to accounting overhead

# in the kernel. We recommend using cgroups to do container-local accounting.

LimitNPROC=infinity

LimitCORE=infinity

LimitNOFILE=infinity

# Comment TasksMax if your systemd version does not supports it.

# Only systemd 226 and above support this version.

TasksMax=infinity

OOMScoreAdjust=-999

[Install]

WantedBy=multi-user.target

EOF

echo ""

echo "##create daemon.json file"

test -d /etc/docker || mkdir /etc/docker

cat > /etc/docker/daemon.json << EOF

{

"oom-score-adjust": -1000,

"log-driver": "json-file",

"log-opts": {

"max-size": "10m",

"max-file": "3"

},

"max-concurrent-downloads": 10,

"max-concurrent-uploads": 10,

"bip": "172.17.0.1/16",

"registry-mirrors": ["https://docker.mirrors.ustc.edu.cn"],

"storage-driver": "overlay2",

"live-restore": true

}

EOF

systemctl daemon-reload

echo "##Service restart: ${SERVICENAME}"

systemctl restart ${SERVICENAME}

echo "##Service status: ${SERVICENAME}"

systemctl status ${SERVICENAME}

# 检查 Docker 服务状态并获取状态值

docker_status=$(systemctl is-active docker.service)

# 判断 Docker 服务是否处于运行状态

if [ "$docker_status" == "active" ]; then

echo "Docker is running."

echo "##Service enabled: ${SERVICENAME}"

systemctl enable ${SERVICENAME}

echo "## docker version"

docker version

else

echo "Docker is not running."

fi

install-docker.sh docker-23.0.6.tgz

方法7:用阿里源,参考地址:

https://yq.aliyun.com/articles/110806

https://developer.aliyun.com/mirror/docker-ce?spm=a2c6h.13651102.0.0.53322f70lXYvKW

# step 1: 安装必要的一些系统工具

sudo yum install -y yum-utils device-mapper-persistent-data lvm2

# Step 2: 添加软件源信息

sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

docker安装版本查看:

# yum list docker-ce --showduplicates | sort -r

# Step 3: 更新并安装 Docker-CE,(最好安装18.09,因为k8s1.14配合18.09比较好)

sudo yum makecache fast && sudo yum -y install docker-ce-18.09.9 docker-ce-cli-18.09.9

# Step 4: 开启Docker服务并设置为开机自动启动

systemctl start docker.service && systemctl enable docker.service

#查看docker软件包

# rpm -qa docker*

docker-ce-18.09.9-3.el7.x86_64 #docker服务端

docker-ce-cli-18.09.9-3.el7.x86_64 #docker客户端

安装docker报错(虚拟机中可能会遇到,如果没有报错请忽略)

Error: Package: docker-ce-18.03.1.ce-1.el7.centos.x86_64 (docker-ce-stable)

Requires: container-selinux >= 2.9

报错原因: docker-ce-selinux 版本过低

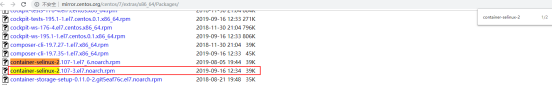

解决办法:在https://mirrors.tuna.tsinghua.edu.cn/docker-ce/linux/centos/7/x86_64/stable/Packages/网站下载对应版本的docker-ce-selinux,安装即可

# yum -y install https://mirrors.tuna.tsinghua.edu.cn/docker-ce/linux/centos/7/x86_64/stable/Packages/docker-ce-selinux-17.03.3.ce-1.el7.noarch.rpm

再次安装docker 成功:

# yum -y install docker-ce

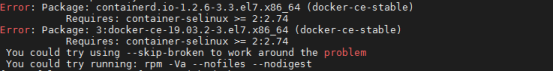

报错: 缺包container-selinux

Error: Package: containerd.io-1.2.6-3.3.el7.x86_64 (docker-ce-stable)

Requires: container-selinux >= 2:2.74

Error: Package: 3:docker-ce-19.03.2-3.el7.x86_64 (docker-ce-stable)

Requires: container-selinux >= 2:2.74

You could try using --skip-broken to work around the problem

You could try running: rpm -Va --nofiles --nodigest

[root@falcon-agent-01 ~]# rpm -ivh docker-ce

error: open of docker-ce failed: No such file or directory

在网上找,感谢:https://www.cnblogs.com/yidiandhappy/p/10694388.html,参考其中处理方法,进入:http://mirror.centos.org/centos/7/extras/x86_64/Packages/,查找到container-selinux-2,发现如下图所示rpm:

# yum -y install http://mirror.centos.org/centos/7/extras/x86_64/Packages/container-selinux-2.107-3.el7.noarch.rpm

# 再次安装docker 成功:

# yum -y install docker-ce-18.09.9 docker-ce-cli-18.09.9

关于启动docker的两个system文件

docker.service 和 docker.socket 是 Docker 服务在 Linux 系统中的两个 systemd 单元,用于管理 Docker 进程和监听 Unix Socket 的守护进程。

docker.service 是 Docker 服务的主要 systemd 单元,负责启动 Docker 守护进程、管理 Docker 容器和镜像。通过该单元,可以实现对 Docker 服务的启动、停止、重启、状态查看等操作。在大部分 Linux 系统中,Docker 的 systemd 单元文件路径为 /usr/lib/systemd/system/docker.service。

docker.socket 则是一个监听 Unix Socket 的系统守护进程,用于接收来自 Docker 客户端的请求并将其转发给 Docker 服务端。它在 Docker 服务启动前就已启动,并通过 Systemd 的 socket activation 机制监听 Unix Socket,从而缩短了 Docker 服务的启动时间。在大部分 Linux 系统中,Docker 的 systemd 单元文件路径为 /usr/lib/systemd/system/docker.socket。

当 Docker 客户端发送请求时,它会使用与 Docker 服务端相同的 Unix Socket 路径(默认为 /var/run/docker.sock),这时系统会将该请求交给 docker.socket 守护进程处理,如果 Docker 服务已启动,并且有可用的容器或镜像,则它会将请求转发给 docker.service 单元处理。如果 Docker 服务未启动,则 docker.socket 守护进程会等待 Docker 服务启动并监听 Unix Socket 后再将请求转发。这样,即使 Docker 服务意外终止,docker.socket 守护进程仍然会在 Docker 服务重新启动时自动监听 Unix Socket,并将存储在缓冲区中的请求全部传递给 Docker 服务处理。

查看docker版本信息:

# docker version

Client: # 客户端信息

Version: 18.09.5 # docker版本信息

API version: 1.39 # API接口信息

Go version: go1.10.8 # go语言版本信息

Git commit: e8ff056

Built: Thu Apr 11 04:43:34 2019

OS/Arch: linux/amd64 # 操作系统

Experimental: false

Server: Docker Engine - Community # 服务端信息

Engine:

Version: 18.09.5 # 引擎版本

API version: 1.39 (minimum version 1.12)

Go version: go1.10.8

Git commit: e8ff056

Built: Thu Apr 11 04:13:40 2019

OS/Arch: linux/amd64

Experimental: false

注意:服务端是一个服务进程,管理着所有容器;客户端则扮演着Docker服务端的远程控制器,可以用来控制Docker的服务端进程。

查看docker系统信息,包括镜像和容器:

# docker info

Client:

Debug Mode: false

Server:

Containers: 0 #容器个数

Running: 0 #正在运行的

Paused: 0 #暂停的

Stopped: 0 #停止的

Images: 0 #镜像个数

Server Version: 19.03.5 #docker版本

Storage Driver: overlay2 #镜像文件存储类型

Backing Filesystem: xfs

Supports d_type: true

Native Overlay Diff: false

Logging Driver: json-file

Cgroup Driver: cgroupfs

Plugins:

Volume: local

Network: bridge host ipvlan macvlan null overlay

Log: awslogs fluentd gcplogs gelf journald json-file local logentries splunk syslog

Swarm: inactive

Runtimes: runc

Default Runtime: runc

Init Binary: docker-init

containerd version: b34a5c8af56e510852c35414db4c1f4fa6172339

runc version: 3e425f80a8c931f88e6d94a8c831b9d5aa481657

init version: fec3683

Security Options:

seccomp

Profile: default

Kernel Version: 3.10.0-514.el7.x86_64 #操作系统内核

Operating System: CentOS Linux 7 (Core) #操作系统版本

OSType: linux #操作类型

Architecture: x86_64 #架构

CPUs: 4 #CPU

Total Memory: 15.38GiB #内存

Name: master #操作系统主机名

ID: 7QIJ:DWSP:VGLZ:LMV6:LYPV:BJRJ:MC64:RYNH:23DX:ZH6V:I3U4:FMI3

Docker Root Dir: /var/lib/docker #存储docker平台中相关信息

Debug Mode: false

Registry: https://index.docker.io/v1/ #加速器

Labels:

Experimental: false

Insecure Registries:

127.0.0.0/8

Live Restore Enabled: false

Docker命令补全

yum install -y bash-completion

source /usr/share/bash-completion/completions/docker

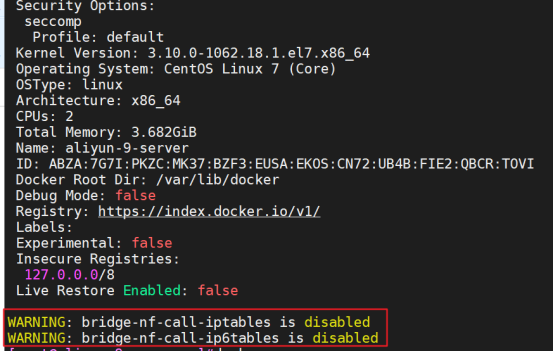

添加内核参数

如果在 CentOS 使用 Docker CE 看到下面的这些警告信息:

WARNING: bridge-nf-call-iptables is disabled

WARNING: bridge-nf-call-ip6tables is disabled

请添加内核配置参数以启用这些功能(随便选一组命令即可)。

$ sudo tee -a /etc/sysctl.conf <<-EOF

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.bridge.bridge-nf-call-arptables = 1

EOF

cat >> /etc/sysctl.conf << EOF

# iptables透明网桥的实现;

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

net.bridge.bridge-nf-call-arptables = 1

EOF

# 然后重新加载 sysctl.conf 即可

$ sudo sysctl -p

# 应用 sysctl 参数而不重新启动

sudo sysctl --system

然后在docker info告警消失

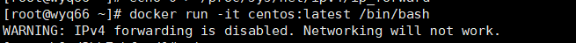

开启网络转发功能->以免其他连接不到容器

容器要想访问外部网络,需要本地系统的转发支持。在Linux 系统中,检查转发是否打开。

$ sysctl net.ipv4.ip_forward

net.ipv4.ip_forward = 1

如果为 0,说明没有开启转发,则需要手动打开。

$ sysctl -w net.ipv4.ip_forward=1

如果在启动 Docker 服务的时候设定 --ip-forward=true, Docker 就会自动设定系统的ip_forward参数为 1

开启网络转发功能,默认会自动开启.

# 手动开启:

# vim /etc/sysctl.conf #插入以下内容

net.ipv4.ip_forward = 1

# sysctl -p #生效

net.ipv4.ip_forward = 1

# 查看

# cat /proc/sys/net/ipv4/ip_forward

1

否则会报错以下警告:

# 设定iptables,防止Docker将iptables的FORWARD修改为DROP

# sed -i '/^ExecStart.*/aExecStartPost=/usr/sbin/iptables -P FORWARD ACCEPT' /usr/lib/systemd/system/docker.service

# 将Docker的网络端口开启,因为这台主要是来给我们build镜像的,因为测试需要,所以开启TCP地址,正常情况下应该做好安全防护

# sed -ri 's@(^ExecStart\>.*)@\1 -H tcp://0.0.0.0:2375@g' /usr/lib/systemd/system/docker.service

# 每次修改System风格程序的管理脚本都得重载配置

# systemctl daemon-reload

# 重启下Docker,让我们的配置生效;

# systemctl restart docker

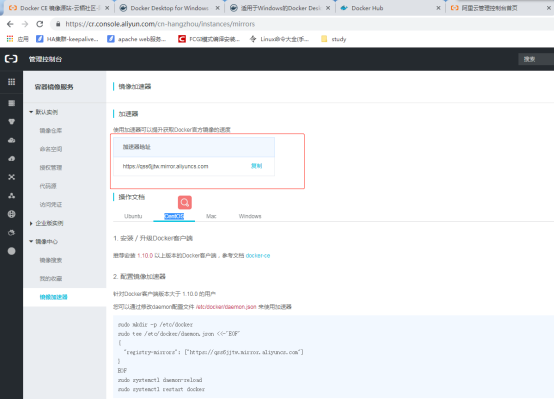

镜像加速

各厂的镜像加速器

国内从 Docker Hub 拉取镜像有时会遇到困难、十分缓慢,此时可以配置镜像加速器。国内很多云服务商都提供了国内加速器服务,例如:

-

Docker官方提供的中国registry mirror:https://registry.docker-cn.com

-

阿里云加速器(需要账号登录获取:https://cr.console.aliyun.com/cn-hangzhou/mirrors)

-

网易云

-

Azure 中国镜像 https://dockerhub.azk8s.cn

-

DaoCloud

-

中科大

对于使用systemd的系统,在/etc/docker/daemon.json中写入如下内容(如果文件不存在,就新建文件):

{

"registry-mirrors": [

"https://registry.docker-cn.com"

]

}

由于镜像服务可能出现宕机,建议同时配置多个镜像,最后重新启动服务

systemctl daemon-reload

systemctl restart docker

ustc 中科大的docker源 也是超级好的

官网:https://lug.ustc.edu.cn/wiki/mirrors/help/docker

请在该配置文件中加入(没有该文件的话,请先建一个):

# vim /etc/docker/daemon.json

{

"registry-mirrors": ["https://docker.mirrors.ustc.edu.cn"]

}

配置阿里云的加速器

如果拉取镜像报错,也可能是加速的原因,可以更换加速

[root@Docker ~]# docker pull centos

Using default tag: latest

Trying to pull repository docker.io/library/centos ...

latest: Pulling from docker.io/library/centosGet https://registry-1.docker.io/v2/library/centos/manifests/sha256:822de5245dc5b659df56dd32795b08ae42db4cc901f3462fc509e91e97132dc0: net/http: TLS handshake timeout

报错了,因为网络的问题。 无法连接到dockerhub 下载镜像。 如果你的网络没有问题,你可以下载。

解决:换一个docker下载地址

或者: 使用阿里云docker镜像加速,提升pull的速度:

你只需要登录容器Hub服务 https://cr.console.aliyun.com的控制台,使用你的支付宝帐号,第一次登录时,需要设置一个独立的密码,左侧的加速器帮助页面就会显示为你独立分配的加速地址。

配置加速器:

# vim /etc/docker/daemon.json #添加以下内容

{

"registry-mirrors": ["https://qss6jjtw.mirror.aliyuncs.com"]

}

# 有多个的情况下,用逗号隔开:

# vim /etc/docker/daemon.json #添加以下内容

{

"registry-mirrors": ["https://qss6jjtw.mirror.aliyuncs.com","https://qss7jjtw.mirror.aliyuncs.com"]

}

# systemctl daemon-reload

# systemctl restart docker

配置网易的加速器

网易蜂巢的镜像源,个人感觉上面的镜像好少,而且有时候pull他们的镜像还会失败,不过如果要写dockerfile的话,可以到上面参考参考,dockerfile他们到时写的很详细噢

https://c.163.com/hub#/m/home/ 需要先注册登录上,才能打开此站点

配置DaoCloud加速器

daocloud加速器,需要用户注册,每个用户每个月限制10GB

简介:DaoCloud 加速器 是广受欢迎的 Docker 工具,解决了国内用户访问 Docker Hub 缓慢的问题。DaoCloud 加速器结合国内的 CDN 服务与协议层优化,成倍的提升了下载速度。

DaoCloud官网:

https://www.daocloud.io/mirror

https://www.daocloud.io/mirror#accelerator-doc

一条命令加速(记得重启docker)

curl -sSL https://get.daocloud.io/daotools/set_mirror.sh | sh -s http://f1361db2.m.daocloud.io

[root@learn ~]# cat /etc/docker/daemon.json

{

"registry-mirrors": ["http://f1361db2.m.daocloud.io"]

}

# 重启docker

systemctl restart docker

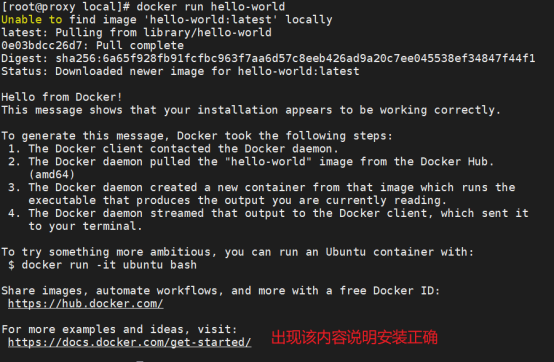

测试Docker是否安装正确

docker run hello-world

上面是执行成功了,说本地没有hello-world:latest的镜像,去下载了一个镜像,说明网络没有问题

daemon.json

docker安装后默认没有daemon.json这个配置文件,需要进行手动创建。配置文件的默认路径:/etc/docker/daemon.json 如果在daemon.json文件中进行配置,需要docker版本高于1.12.6(在这个版本上不生效,1.13.1以上是生效的)

--config-file命令参数可用于指定非默认位置

**参数 **

daemon.json文件可配置的参数表,我们在配置的过程中,只需要设置我们需要的参数即可,不必全部写出来。详细参考官网。

官方的配置地址:

https://docs.docker.com/engine/reference/commandline/dockerd/#/configuration-reloading

官方的配置地址:https://docs.docker.com/engine/reference/commandline/dockerd/#options

官方的配置地址:

https://docs.docker.com/engine/reference/commandline/dockerd/#/linux-configuration-file

{

"authorization-plugins": [],

"data-root": "", #Docker运行时使用的根路径,根路径下的内容稍后介绍,默认/var/lib/docker

"dns": [], #设定容器DNS的地址,在容器的 /etc/resolv.conf文件中可查看

"dns-opts": [], #容器 /etc/resolv.conf 文件,其他设置

"dns-search": [], #设定容器的搜索域,当设定搜索域为 .example.com 时,在搜索一个名为 host 的 主机时,DNS不仅搜索host,还会搜索host.example.com。注意:如果不设置,Docker 会默认用主机上的 /etc/resolv.conf来配置容器。

"oom-score-adjust": -1000, # 防止 docker 服务 OOM

"storage-driver": "overlay2", # docker存储驱动

"storage-opts": [

"overlay2.override_kernel_check=true"

],

"exec-opts": ["native.cgroupdriver=systemd"], # 启动时的额外参数, https://www.cnblogs.com/architectforest/p/12988488.html docker默认的Cgroup Driver是cgroupfs,cgroupfs是cgroup为给用户提供的操作接口而开发的虚拟文件系统类型,它和sysfs,proc类似,可以向用户展示cgroup的hierarchy,通知kernel用户对cgroup改动,对cgroup的查询和修改只能通过cgroupfs文件系统来进行

# 3,为什么要修改为使用systemd?

# Kubernetes 推荐使用 systemd 来代替 cgroupfs,为什么呢?

# 因为systemd是Kubernetes自带的cgroup管理器, 负责为每个进程分配cgroups,但docker的cgroup driver默认是cgroupfs,这样就同时运行有两个cgroup控制管理器, 当资源有压力的情况时,有可能出现不稳定的情况

"exec-root": "",

"experimental": false, #启用实验功能

"features": {},

"storage-driver": "overlay2",#表示使用OverlayFS的overlay2存储驱动

"storage-opts": ["overlay2.override_kernel_check=true"],

"labels": [], #docker主机的标签,很实用的功能,例如定义:–label nodeName=host-121

"live-restore": true,

"log-driver": "",

"log-opts": {},

"log-level": "", # 容器日志等级

"mtu": 0,

"pidfile": "", #Docker守护进程的PID文件

"cluster-store": "",

"cluster-store-opts": {},

"cluster-advertise": "",

"max-concurrent-downloads": 3,

"max-concurrent-uploads": 5,

"default-shm-size": "64M",

"shutdown-timeout": 15,

"debug": true, #启用debug的模式,启用后,可以看到很多的启动信息。默认false

"hosts": [], #设置容器hosts

"tls": true, #默认 false, 启动TLS认证开关

"tlscacert": "", #默认 ~/.docker/ca.pem,通过CA认证过的的certificate文件路径

"tlscert": "", #默认 ~/.docker/cert.pem ,TLS的certificate文件路径

"tlskey": "", #默认~/.docker/key.pem,TLS的key文件路径

"tlsverify": true, #默认false,使用TLS并做后台进程与客户端通讯的验证

"tls": true,

"tlsverify": true,

"tlscacert": "",

"tlscert": "",

"tlskey": "",

"swarm-default-advertise-addr": "",

"api-cors-header": "",

"selinux-enabled": false, # 默认 false,启用selinux支持

"userns-remap": "",

"group": "", # Unix套接字的属组,仅指/var/run/docker.sock

"cgroup-parent": "",

"default-ulimits": {

"nofile": {

"Name": "nofile",

"Hard": 64000,

"Soft": 64000

}

},

"init": false,

"init-path": "/usr/libexec/docker-init",

"ipv6": false,

"iptables": false,

"ip-forward": false, # 默认true, 启用 net.ipv4.ip_forward ,进入容器后使用sysctl -a|grepnet.ipv4.ip_forward查看

"ip-masq": false,

"userland-proxy": false,

"userland-proxy-path": "/usr/libexec/docker-proxy",

"ip": "0.0.0.0",

"bridge": "",

"bip": "", # 指定docker运行的网段

"fixed-cidr": "",

"fixed-cidr-v6": "",

"default-gateway": "",

"default-gateway-v6": "",

"icc": false,

"raw-logs": false,

"allow-nondistributable-artifacts": [],

"registry-mirrors": [], # 镜像加速的地址,增加后在 docker info中可查看。

"insecure-registries": [], # 配置docker的私库地址

"seccomp-profile": "",

"no-new-privileges": false,

"default-runtime": "runc",

"oom-score-adjust": -500,

"node-generic-resources": ["NVIDIA-GPU=UUID1", "NVIDIA-GPU=UUID2"],

"runtimes": { # 配置容器运行时

"cc-runtime": {

"path": "/usr/bin/cc-runtime"

},

"custom": {

"path": "/usr/local/bin/my-runc-replacement",

"runtimeArgs": [

"--debug"

]

}

},

"default-address-pools":[{"base":"172.80.0.0/16","size":24},

{"base":"172.90.0.0/16","size":24}]

}

# 查看参数:

docker info | grep -i storage

Keep containers alive during daemon downtime

$ sudo vim /etc/docker/daemon.yaml

{

"live-restore": true

}

# 在docker守护进程停机期间保持容器存活,就是即使docker进程停止了,之前运行的容器不会停止

$ sudo dockerd --live-restore

# 只能使用reload重载

# 相当于发送SIGHUP信号量给dockerd守护进程

$ sudo systemctl reload docker

# 但是对应网络的设置需要restart才能生效

$ sudo systemctl restart docker

线上docker优化

参考:https://docs.rancher.cn/rancher2x/install-prepare/best-practices/docker.html

[root@learn ~]# cat /etc/docker/daemon.json

{

"oom-score-adjust": -1000,

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "10m",

"max-file": "3"

},

"max-concurrent-downloads": 10,

"max-concurrent-uploads": 10,

"bip": "172.17.0.1/16",

"registry-mirrors": ["https://docker.mirrors.ustc.edu.cn"],

"storage-driver": "overlay2",

"storage-opts": [

"overlay2.override_kernel_check=true"

],

"live-restore": true

}

# docker-24.0.7 以下参数不生效了

"exec-opts": ["native.cgroupdriver=systemd"],

"storage-opts": [

"overlay2.override_kernel_check=true"

],

# 重启docker

systemctl restart docker

官方建议使用overlay2

修改Docker Root Dir

默认的路径: /var/lib/docker

如果空间不足,会导致程序无法正常使用、日志无法写入、导入docker镜像时,错误提示:磁盘空间不足。

https://blog.51cto.com/u_13293070/2620352

1.查看docker镜像存放目录空间大小

du -sh /var/lib/docker/

2.停止docker服务。

systemctl stop docker

3.查看磁盘容量大的空间,且在上面创建新的docker目录。

df -h

mkdir -p /data/docker/lib

4.迁移/var/lib/docker目录下的文件到新创建的目录/data/docker/lib(注意第一个路径后面一定不要到 “/”,否则是同步的/var/lib/docker/目录里面的内容,不会把docker目录同步过去)

rsync -avz /var/lib/docker /data/docker/lib/

5.编辑 /etc/docker/daemon.json 添加如下参数。在docker 19.xx 版本以后使用data-root来代替graph

{

"data-root": "/data/docker/lib/docker"

}

6.重新加载docker,并重启docker服务。

systemctl daemon-reload && systemctl start docker

7.检查docker是否变更为新目录/data/docker/lib/docker

[root@localhost ~]# docker info

...

Docker Root Dir: /data/docker/lib/docker

Debug Mode (client): false

Debug Mode (server): false

Registry: https://index.docker.io/v1/

...

8.重启服务器

reboot

9.删掉docker旧目录

rm -rf /var/lib/docker

Docker命令行的操作参数

用户在使用Docker时,需要使用Docker命令行工具docker与Docker daemon建立通信。Docker daemon是Docker守护进程,负责接收并分发执行Docker命令。

Docker命令的结构图,如下图:

命令结构

docker --help 查看操作参数

Usage: docker [OPTIONS] COMMAND

A self-sufficient runtime for containers

Options:

--config=~/.docker #客户端配置文件的位置

-D, --debug #启动调试模式

-H, --host=[] #守护进程套接字(s)连接到

-h, --help #打印帮助

-l, --log-level string #Set the logging level ("debug"|"info"|"warn"|"error"|"fatal") (default "info")

--tls #使用TLS;implied by --tlsverify

--tlscacert=~/.docker/ca.pem #仅由此CA签署的信任证书

--tlscert=~/.docker/cert.pem #TLS证书文件的路径

--tlskey=~/.docker/key.pem #TLS密钥文件的路径

--tlsverify #使用TLS并验证远程

-v, --version #打印版本信息并退出

Management Commands:

builder Manage builds

config Manage Docker configs

container Manage containers

engine Manage the docker engine

image Manage images

network Manage networks

node Manage Swarm nodes

plugin Manage plugins

secret Manage Docker secrets

service Manage services

stack Manage Docker stacks

swarm Manage Swarm

system Manage Docker

trust Manage trust on Docker images

volume Manage volumes

Commands:

attach #进入到正在运行的容器

build #从Dockerfile构建一个镜像

commit #从容器的更改中创建一个新的镜像

cp #在本地文件系统与容器中互相复制 文件/文件夹

create #创建一个新的容器

diff #检查容器文件系统上的更改

events #从服务器获取实时事件

exec #进入正在运行的容器中运行命令

export #将容器的文件系统导出为tar存档

history #显示镜像每一层的大小

images #镜像列表

import #从tarball中导入内容以创建文件系统映像

info #显示系统环境信息

inspect #检查返回容器,镜像或任务的低级信息

kill #杀死一个或多个正在运行的容器

load #从tar归档或STDIN加载镜像

login #登录到Docker镜像库。

logout #从Docker镜像库中注销。

logs #获取容器的日志。默认/var/lib/docker/containers/容器ID/容器ID-json.log

network #管理Docker网络

node #管理Docker Swarm节点

pause #暂停一个或多个容器内的所有进程

port #列出端口映射或容器的特定映射

ps #容器列表

pull #从镜像库中拉出镜像或存储库

push #推送镜像或存储库到镜像库

rename #重命名一个容器

restart #重启一个容器

rm #删除一个或多个容器

rmi #rmi删除一个或多个镜像

run #在新容器中运行命令

save #将一个或多个镜像保存到tar归档文件(默认流式传输到STDOUT)

search #在Docker Hub中搜索镜像

service #管理Docker服务

start #启动一个或多个停止的容器

stats #信息显示容器资源使用的实时统计信息

stop #停止一个或多个运行容器

swarm #管理Docker Swarm

tag #将镜像标记到存储库中

top #显示容器的运行过程

unpause #暂停取消暂停一个或多个容器内的所有进程

update #更新一个或多个容器的配置

version #显示Docker版本信息

volume #管理Docker卷

wait #阻塞直到容器停止,然后打印其退出代码

#对单个子命令执行help可以查看此子命令的详细用法,如下面对rm执行查看:

# docker rm --help

Usage: docker rm [OPTIONS] CONTAINER [CONTAINER...]

Remove one or more containers

Options:

-f, --force Force the removal of a running container (uses SIGKILL)

--help Print usage

-l, --link Remove the specified link

-v, --volumes Remove the volumes associated with the container

docker run常用选项:

参考:https://www.cnblogs.com/xiangsikai/p/9628479.html

run 运行容器

--name 指定容器的名字

-h 指定容器主机名

-i 以交互模式运行容器,通常与 -t 同时使用;

-t 为容器重新分配一个伪输入终端,通常与 -i 同时使用->-it;打算进入bash执行一些命令并查看返回结果,因此需要交互式终端

-d 后台运行容器,并返回容器ID;

-c 后面跟待完成的命令,docker exec xxx /bin/sh -c "aaa --version" # xxx表示容器名,aaa表示可执行文件

-p(小写字母p)映射指定端口,-p 宿主机端口:容器端口【-p 20022:22】

-P (大写字母P) 映射随机端口

-w /myapp 指定容器的/myapp目录为工作目录

-v 绑定存储卷 -> -v 宿主机目录:容器里面的目录[:ro/rw];只能创建bind mount,实例中的rw为读写,ro为只读

-e 设置环境变量,如:-e mysql_user=root ->就可以在容器里面或Dockfile里面引用这个变量

--rm 停止容器后,自动删除该容器;如果有挂载卷也会一并删除,建议只在测试时使用

--network 指定网络 [none、host、bridge]

--volumes-from

--dns dns配置

/bin/bash:放在镜像名后是命令,这里是希望是交互式,因此用/bin/bash。需要看容器里的基础镜像支持什么shell

/bin/sh:放在镜像名后是命令,这里是希望是交互式,因此用/bin/sh

pull 拉取(下载)镜像

Usage: docker run [OPTIONS] IMAGE [COMMAND] [ARG...]

-d, --detach=false 指定容器运行于前台还是后台,默认为false

-i, --interactive=false 打开STDIN,用于控制台交互

-t, --tty=false 分配tty设备,该可以支持终端登录,默认为false

-u, --user="" 指定容器的用户,覆盖容器中内置的账号

-a, --attach=[] 登录容器(必须是以docker run -d启动的容器)

-w, --workdir="" 指定容器的工作目录

-c, --cpu-shares=0 设置容器CPU权重,在CPU共享场景使用

-e, --env=[] 指定环境变量,容器中可以使用该环境变量

-m, --memory="" 指定容器的内存上限

-P, --publish-all=false 指定容器暴露的端口

-p, --publish=[] 指定容器暴露的端口

-h, --hostname="" 指定容器的主机名

--add-host list Add a custom host-to-IP mapping (host:ip) (在多机可以使用--bridge模式部署rabbitmq集群,https://blog.csdn.net/sanduo112/article/details/120074642)

-v, --volume=[] 给容器挂载存储卷,挂载到容器的某个目录

--volumes-from=[] 给容器挂载其他容器上的卷,挂载到容器的某个目录

--cap-add=[] 添加权限,权限清单详见:http://linux.die.net/man/7/capabilities

--cap-drop=[] 删除权限,权限清单详见:http://linux.die.net/man/7/capabilities

--cidfile="" 运行容器后,在指定文件中写入容器PID值,一种典型的监控系统用法

--cpuset="" 设置容器可以使用哪些CPU,此参数可以用来容器独占CPU

--device=[] 添加主机设备给容器,相当于设备直通

--dns=[] 指定容器的dns服务器

--dns-search=[] 指定容器的dns搜索域名,写入到容器的/etc/resolv.conf文件

--entrypoint="" 覆盖image的入口点

--env-file=[] 指定环境变量文件,文件格式为每行一个环境变量

--expose=[] 指定容器暴露的端口,即修改镜像的暴露端口

--link=[] 指定容器间的关联,使用其他容器的IP、env等信息

--lxc-conf=[] 指定容器的配置文件,只有在指定--exec-driver=lxc时使用

--name="" 指定容器名字,后续可以通过名字进行容器管理,links特性需要使用名字

--network="bridge" 容器网络设置:

bridge 使用docker daemon指定的网桥

host //容器使用主机的网络

container:NAME_or_ID >//使用其他容器的网路,共享IP和PORT等网络资源

none 容器使用自己的网络(类似--net=bridge),但是不进行配置

--privileged=false 指定容器是否为特权容器,特权容器拥有所有的capabilities

--restart="no" 指定容器停止后的重启策略( default "no")

no:容器退出时不重启

on-failure:容器故障退出(返回值非零)时重启

always:容器退出时总是重启

--rm=false 指定容器停止后自动删除容器(不支持以`docker run -d`启动的容器)

--sig-proxy=true 设置由代理接受并处理信号,但是SIGCHLD、SIGSTOP和SIGKILL不能被代理

--mount mount 将文件系统挂载到容器上,参数--mount默认情况下用来挂载volume,但也可以用来创建bind mount和tmpfs。如果不指定type选项,则默认为挂载volume,volume是一种更为灵活的数据管理方式,volume可以通过docker volume命令集被管理

示例:

docker run --name $CONTAINER_NAME -it \

--mount type=bind,source=$PWD/$CONTAINER_NAME/app,destination=/app \

--mount source=${CONTAINER_NAME}-data,destination=/data,readonly \

avocado-cloud:latest /bin/bash

注释:

- 挂载volume命令格式:[type=volume,]source=my-volume,destination=/path/in/container[,...]

- 创建bind mount命令格式:type=bind,source=/path/on/host,destination=/path/in/container[,...]

- 如果创建bind mount并指定source则必须是绝对路径,且路径必须已经存在

- 示例中readonly表示只读

差异总结

| 对比项 | bind mount | volume |

|---|---|---|

| Source位置 | 用户指定 | /var/lib/docker/volumes/ |

| Source为空 | 覆盖dest为空 | 保留dest内容 |

| Source非空 | 覆盖dest内容 | 覆盖dest内容 |

| Source种类 | 文件或目录 | 只能是目录 |

| 可移植性 | 一般(自行维护) | 强(docker托管) |

| 宿主直接访问 | 容易(仅需chown) | 受限(需登陆root用户) |

创建bind mount时使用--volume和--mount的比较

| 对比项 | --volume 或 -v |

--mount type=bind |

|---|---|---|

| 如果主机路径不存在 | 自动创建 | 命令报错 |

根据命令的用途进行分类:

| 子命令分类 | 子命令 |

|---|---|

| Docker环境信息 | info、version |

| 容器生命周期管理 | create、exec、kill、pause、restart、rm、run、start、stop、unpause |

| 镜像仓库命令 | login、logout、pull、push、search |

| 镜像管理 | build、images、import、load、rmi、save、tag、commit |

| 容器运维操作 | attach、export、inspect、port、ps、rename、stats、top、wait、cp、diff |

| 系统日志信息 | events、history、logs |

常见docker清理方法

新版的 docker 终于支持对无用数据的清除了,主要有以下命令:

docker image prune :删除无用的镜像。

docker container prune :删除无用的容器。

docker volume prune :删除无用的卷。

docker network prune :删除无用的网络。

docker system df :类似于Linux上的df命令,查看Docker 磁盘使用情况

docker system df -v:查看Docker 磁盘使用情况详情

docker system prune :可以用于清理磁盘,删除关闭的容器、无用的数据卷和网络,以及dangling镜像(即无tag的镜像)

# docker system prune

WARNING! This will remove:

- all stopped containers #删除关闭的容器

- all networks not used by at least one container #无用的数据卷和网络

- all dangling images #无tag的镜像

- all dangling build cache #cache清理

Are you sure you want to continue? [y/N] y

要强制删除可加上 -f 参数

docker system prune -a (慎用)清理得更加彻底,可以将没有容器使用Docker镜像都删掉。注意,这两个命令会把你暂时关闭的容器,以及暂时没有用到的Docker镜像都删掉了…所以使用之前一定要想清楚.。我没用过,因为会清理没有开启的 Docker镜像

推送镜像脚本

# cat pushimages.sh

#!/bin/bash

RepositoryAddr='dockerhub.koal.com:5000/idaas/'

NewRepositoryAddr='registry.cn-shanghai.aliyuncs.com/mefor/xwarm64'

ImageName=$1

Tag=$2

##set color##

echoRed() { echo $'\e[0;31m'"$1"$'\e[0m'; }

echoGreen() { echo $'\e[0;32m'"$1"$'\e[0m'; }

echoYellow() { echo $'\e[0;33m'"$1"$'\e[0m'; }

function Usage(){

echoYellow "Usage:"

echoGreen " /bin/bash $0 [app/id/gw/sso/pdp/web/all] [version]"

echoYellow " for example : $0 app 2.0.0"

return 0

}

if [[ "$#"q != "2"q ]]

then

echoRed "input error …………"

Usage

exit 6

fi

#Changing the image name

if [ "${ImageName}"x = 'app'x ] || [[ "${ImageName}"x = 'app-platform-integration'x ]]; then

ImageName='app-platform-integration'

NewTagPrefix='app-'

elif [ "$1"x = 'id'x -o "$1"x = 'id-integration'x ]; then

ImageName='id-integration'

NewTagPrefix='id-'

elif [ "$1"x = 'gw'x -o "$1"x = 'gateway'x ]; then

ImageName='gateway'

NewTagPrefix='gw-'

elif [ "$1"x = 'sso'x -o "$1"x = 'authn-integration'x ]; then

ImageName='authn-integration'

NewTagPrefix='sso-'

elif [ "$1"x = 'pdp'x -o "$1"x = 'policy-services'x ]; then

ImageName='policy-services'

NewTagPrefix='pdp-'

elif [ "$1"x = 'web'x -o "$1"x = 'idaas-admin-integration'x ]; then

ImageName='idaas-admin-integration'

NewTagPrefix='web-'

elif [ "$1"x = 'all'x ]; then

AImageName=("app-platform-integration" "id-integration" "gateway" "authn-integration" "policy-services" "idaas-admin-integration")

#ANewTagPrefix=("app-" "id-" "gw-" "sso-" "pdp-" "web-")

else

echoRed "Input ImageName Error"

echoRed "Exit immediately" && exit 3

fi

function GoGo() {

echoYellow "update ${ImageName} images"

echoYellow "modify tag"

echoYellow "${RepositoryAddr}${ImageName}:${Tag} ${NewRepositoryAddr}:${NewTagPrefix}${Tag}"

docker tag ${RepositoryAddr}${ImageName}:${Tag} ${NewRepositoryAddr}:${NewTagPrefix}${Tag} && echoGreen "Succeeded in modifying the tag" || { echoRed "Failed to modify tag" && echoRed "Exit immediately" && exit 2

}

echoYellow "Push a new image to a new repository"

echoYellow "${NewRepositoryAddr}:${NewTagPrefix}${Tag}"

docker push ${NewRepositoryAddr}:${NewTagPrefix}${Tag}

echoYellow "Delete the mirror of the new tag"

docker rmi ${NewRepositoryAddr}:${NewTagPrefix}${Tag}

}

case "$ImageName" in

app|app-platform-integration|id|id-integration|gw|gateway|sso|authn-integration|pdp|policy-services|web|idaas-admin-integration)

GoGo 2>&1 | tee ./GoGoLog.txt

;;

all)

{

echoYellow "update all images"

#echo ${AImageName[*]}

#echo ${ANewTagPrefix[@]}

#echo ${!ANewTagPrefix[@]}

for ImageName in ${AImageName[*]};do

if [[ "${ImageName}"x = 'app-platform-integration'x ]]; then

ImageName='app-platform-integration'

echo "ImageName=$ImageName"

NewTagPrefix='app-'

echo "NewTagPrefix=$NewTagPrefix"

GoGo

elif [[ "${ImageName}"x = 'id-integration'x ]]; then

ImageName='id-integration'

echo "ImageName=$ImageName"

NewTagPrefix='id-'

echo "NewTagPrefix=$NewTagPrefix"

GoGo

elif [[ "${ImageName}"x = 'gateway'x ]]; then

ImageName='gateway'

echo "ImageName=$ImageName"

NewTagPrefix='gw-'

echo "NewTagPrefix=$NewTagPrefix"

GoGo

elif [[ "${ImageName}"x = 'authn-integration'x ]]; then

ImageName='authn-integration'

echo "ImageName=$ImageName"

NewTagPrefix='sso-'

echo "NewTagPrefix=$NewTagPrefix"

GoGo

elif [[ "${ImageName}"x = 'policy-services'x ]]; then

ImageName='policy-services'

echo "ImageName=$ImageName"

NewTagPrefix='pdp-'

echo "NewTagPrefix=$NewTagPrefix"

GoGo

elif [[ "${ImageName}"x = 'idaas-admin-integration'x ]]; then

ImageName='idaas-admin-integration'

echo "ImageName=$ImageName"

NewTagPrefix='web-'

echo "NewTagPrefix=$NewTagPrefix"

GoGo

else

echoRed "Error defining mirror name"

echoRed "Exit immediately" && exit 3

fi

done

} 2>&1 | tee ./GoGoLog.txt

;;

*)

echoRed "input error …………"

Usage

;;

esac

Docker疑难杂症汇总

https://www.escapelife.site/posts/43a2bb9b.html#!

https://mp.weixin.qq.com/s/JuUULOE-axo7wFzijt1l_Q

Docker 镜像

镜像Docker的三大组件之一:

Docker运行容器前需要本地存在对应的镜像,如果本地不存在该镜像,Docker会从镜像仓库下载该镜像。

什么是Docker镜像?

详解链接:

http://www.infoq.com/cn/articles/analysis-of-docker-file-system-aufs-and-devicemapper/

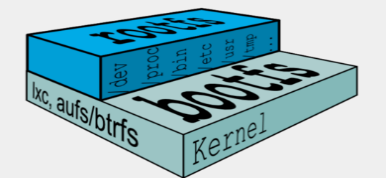

Docker镜像含有启动Docker容器所需的文件系统结构及其内容,因此是启动一个Docker容器的基础。Docker镜像采用分层的结构构件,最底层是bootfs,之上的部分是roofs,其租住结果如下图:

boofs:

bootfs是Docker镜像最底层的引导文件系统,包括bootloader和操作系统内核,类似于传统的Linux/Unix引导文件系统。然而,Docker用户很少有机会直接与bootfs打交道,并且在容器启动完毕之后,为了节省内存空间,bootfs将会被卸载。

rootfs

rootfs位于bootfs之上,是Docker容器在启动时内部进程可见的文件系统,即Docker容器的根目录。rootfs通常包含一个操作系统运行所需的文件系统,例如可能包含典型的类Unix操作系统中的目录系统,如/dev,/tmp等及运行Docker容器所需的配置文件、工具等。

在Docker的架构中,当Docker daemon为Docker容器挂载rootfs时,沿用了Linux内核启动时的方法,即将rootfs设置为只读模式。在挂载完毕之后,利用联合挂载(union mount)技术在已有的只读rootfs上再挂载一个读写层。这样,可读写层处于Docker容器文件系统的最顶层,其下可能联合挂载多个读写层,并隐藏只读层中的老版本文件,这样的技术被称为写时复制(Copy On Write)。联合挂载技术可以在一个挂载点同时挂载多个文件系统,将挂载点的原目录与被挂载内容进行整合,使得最终可见的文件系统将会包含整合之后的各层的文件和目录。

如上图,实现这种联合挂载技术的文件系统通常被称为联合文件系统(union filesystem)。由于初始挂载时读写层为空,所以从用户的角度看,改容器的文件系统与底层的rootfs没有差别。当需要修改镜像内的某个文件时,只对处于最上方的读写层进行了变动,不覆盖下层已有文件系统的内容,已有文件在只读层中的原始版本仍然存在,但会被读写层中的新文件所隐藏,当docker commit这个修改过的容器文件系统为一个新的镜像时,保存内容仅为最上层读写文件系统中被更新过的文件。

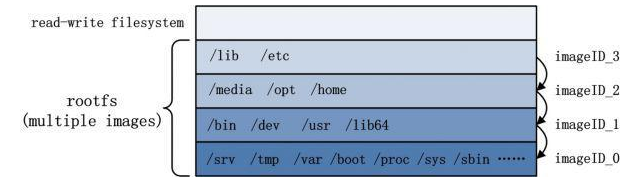

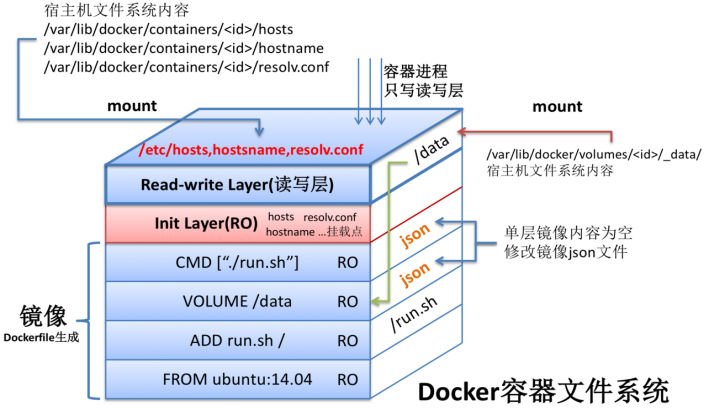

镜像的存储组织方式

上图是一个完整的、在运行的容器的所有文件系统结构的描述。上图体现了镜像的层级结构,里面有volume、init-layer、可读写层这些概念。可读写层(read-write Layer以及volume)、init-layer、只读层(read-only layer)这3层结构共同组成一个容器所需的下层文件系统,他们通过联合挂载的方式巧妙的表现为一层,使得容器进程对这些层的存在一点都不知道。

Docker镜像系统实际分成了分多层,任何一层和它直接或间接依赖的所有层构成一个镜像。镜像分层机制提供的复用特性使得存储一个新的镜像时只需要保存修改的内容而不是全部文件。

镜像关键概念

registry

每个docker容器都将从Docker镜像生成。registry用以保存Docker镜像,其中还包括镜像层次结构和关于镜像的元数据,可以将registry理解为类似于Git仓库之类的实体。

除了使用官方的公用registry(即Git Hub),它是由Docker公司维护的一个公共镜像仓库,其中包含了超过45000个公共镜像,供用户下载使用。Docker Hub中有两种类型的仓库,及用户仓库(user repository)与顶层仓库(top-level repository)。用户仓库由普通的Docker Hub用户创建,顶层仓库由Docker公司负责维护,提供官方版本镜像。理论上,顶层仓库中的镜像经过Docker公司验证,被认为是架构良好且安全的。

repository

repository即由具有某个功能的Docker镜像的所有迭代版本构成的镜像库。registry由一系列经过命名的repository组成,可以通过命名规范对用户仓库和顶层仓库进行区分。用户仓库的命名由用户名和库名两部分组成,中间以"/"隔开,即username/repository_name的形式,库名通常表示镜像所具有的功能,如:centos7-ansible ;而顶层仓库则只包含库名的部分,如:centos(可以通过#docker search centos来查看)。

registry是repository的集合,repository是镜像的集合。

index

registry负责存储和提供真正的镜像,而index则类似于registry的索引,负责管理用户账号、访问权限认证、搜索镜像以及为镜像打标签等事务。

当用户执行docker search时,真正搜索的是index,而非registry。当执行docker push或docker pull时,将由index判断使用者是否有拉取或推送相应镜像及访问registry的权限,而registry则是将需要存储或拉取镜像存储的实际位置。

graph

从registry中下载的Docker镜像需要保存在本地,这一功能由Docker graph完成。

在本graph的本地目录/var/lib/docker/devicemapper/devicemapper中,保存了每一个下载到本地的Docker镜像的主体文件,在/var/lib/docker/image目录下面保存了每一个下载到本地的Docker镜像的元数据,包括有json与layersize。其中json文件记录了相应Docker镜像的ID、依赖关系、创建时间和配置信息等,layersize为Docker镜像的大小。

Dockerfile

Dockerfile是在通过docker build命令构建自己的Docker镜像时需要使用到的定义文件。它允许用户使用基本的DSL语法来定义Docker镜像,每一条指令描述了构建镜像的步骤

Docker镜像的操作

Docker registry是存储器镜像的仓库,用户可以通过Docker client与Docker registry进行通信,以此来完成镜像的搜索、下载和上传等相关操作。Docker HUb是由Docker公司在互联网上提供的一个镜像仓库,提供镜像的公有与私有存储服务,它是用户最主要的镜像来源。除了Docker Hub外,用户还可以自行搭建私有服务器来实现镜像仓库的功能

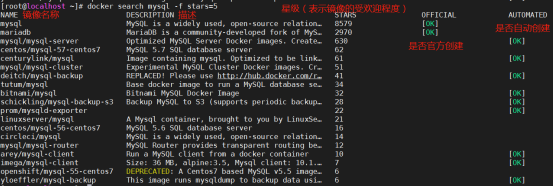

搜索镜像:

使用docker search命令可以搜索远端仓库中共享的镜像,默认搜索Docker Hub官方仓库中的镜像。

Usage: docker search [OPTIONS] TERM

从docker hub上搜索符合条件的images

# docker search --help

用法:docker search [OPTIONS] TERM

选项:

-f, --filter value #根据提供的条件过滤输出(默认[])

--limit int #搜索结果的最大数目(默认为25)

--no-index #不要截断输出

--no-trunc #不要截断输出

# docker search mysql #搜索带mysql关键字的镜像

解释:

NAME:image名字

DESCRIPTION:image描述

STARS:受欢迎受欢迎程度

OFFICIAL:是否官方提供,如果OFFICIAL 为[ok] ,说明可以放心使用。

# docker search mysql --filter=stars=5 #仅显示评价为5星以上的镜像

# docker search mysql -f=stars=5

# docker search mysql -f stars=5

获取镜像(没有指定tag,则默认下载latest)

镜像是docker运行容器的前提。docker pull命令从网络上下载镜像。

语法:docker pull [选项] [Docker Registry 地址[:端口号]/]仓库名[:标签]

具体选项通过docker pull --help命令可以查看。

用法:docker pull [OPTIONS] NAME[:TAG|@DIGEST]

选项:

-a, --all-tags #下载存储库中的所有标记的镜像

--disable-content-trust #跳过镜像验证(默认为true)

--help #打印帮助

对Docker镜像来说,如果不显示地指定TAG,则默认会选择latest标签,即下载仓库中最新版本的镜像

-

Docker镜像仓库地址:地址的格式一般是<域名/IP>[:端口号]。默认地址是Docker Hub

-

仓库名:这里的仓库名是两段式名称,即<用户名>/<软件名>。对于Docker Hub,如果不给出用户名,则默认为library,也就是官方镜像

方法1:从公网docker hub 拉取(下载)image pull:拉

Usage: docker pull [OPTIONS] NAME[:TAG|@DIGEST]

或者: Usage: docker image pull [OPTIONS] NAME[:TAG|@DIGEST]

eg:

[root@Docker ~]# docker pull centos #如果报错了,因为网络的问题,那么配置镜像加速,再下载,就可以了。

eg:

# docker pull ubuntu # 下载最新版的ubuntu镜像

上图为从默认的注册服务器的ubuntu仓库下载标记为latest的镜像。

Downloading行首的子串代表各个层的ID。下载过程中会获取并输出镜像的各层信息。层(Layer)其实是AUFS(一种联合文件系统)中的重要概念,是实现增量保存与更新的基础

方法2:导入把之前下载好的image镜像:

把docker.io-centos.tar 镜像上传到linux上

参数: -i " docker.io-centos.tar " 指定载入的镜像归档。

[root@haha ~]# docker load -i /root/docker.io-centos.tar

方法3:下载其他站点的镜像(指定仓库下载镜像)

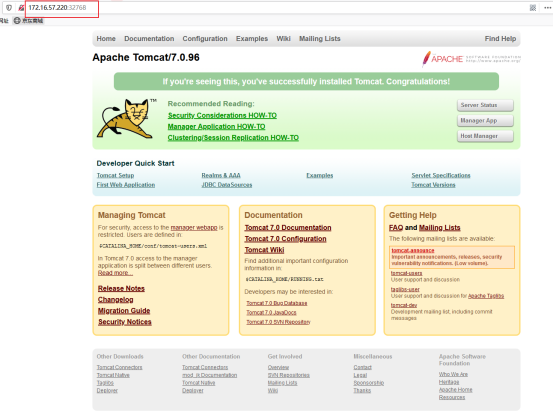

[root@haha ~]# docker pull hub.c.163.com/library/tomcat:latest

[root@haha ~]# docker images

REPOSITORY TAG IMAGE ID CREATED SIZE

hub.c.163.com/library/tomcat latest 72d2be374029 4 months ago 292.4 MB

~~docker pull dl.~~~~dockerpool.com:5000/ubuntu~~

可以从其他注册服务器的仓库下载,但是需要在仓库的名称前指定完整的仓库注册服务器地址。例如这个dockerpool社区的镜像源

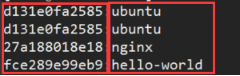

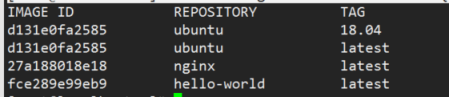

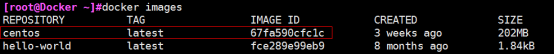

查看镜像信息:

使用`docker images`命令可以列出本地主机上已有的镜像。

Usage: docker image COMMAND

或者: Usage: docker images [OPTIONS] [REPOSITORY[:TAG]]

# docker images --help

用法:docker images [OPTIONS] [REPOSITORY[:TAG]]

选项:

-a, --all # 显示所有的镜像,默认只列出最顶层的镜像

--digests # 显示摘要

-f, --filter value # 根据提供的条件过滤输出(默认[])

--format string # 漂亮的打印镜像使用Go模板

--help # 打印帮助

--no-trunc # 不要截断输出

-q, --quiet # 只显示镜像ID

eg:

# docker images # 列出主机上面已有的镜像

各个选项说明:

-

REPOSITORY:是来自于哪个仓库,这里可以看出都是来自于官方镜像库

-

TAG:镜像的标签信息,用来标记来自于同一个仓库的不同镜像。通过TAG信息来区分发行版本。也就是镜像的标签信息

-

IMAGE ID:这是一个唯一值,也就是镜像的唯一ID号

-

CREATED:镜像创建时间

-

SIZE:镜像大小

同一仓库源可以有多个 TAG,代表这个仓库源的不同个版本,镜像 ID 则是镜像的唯一标识,一个镜像可以对应多个标签;如ubuntu仓库源里,有15.10、14.04等多个不同的版本,我们使用 REPOSITORY:TAG 来定义不同的镜像。

eg:

[root@Docker ~]#docker image ls #列出本地可用镜像。其中 [name] 对镜像名称进行关键词查询。

[root@Docker ~]#docker image ls -a #列出本地所有镜像。包括<none>的镜像

eg:

# docker run -it --rm ubuntu:18.04 bash

镜像体积:

如果仔细观察, 会注意到, 这里标识的所占用空间和在 Docker Hub 上看到的镜像大小不同。 比如,ubuntu:18.04 镜像大小, 在这里是 127 MB , 但是在Docker Hub 显示的却是 50 MB 。 这是因为 Docker Hub 中显示的体积是压缩后的体积。 在镜像下载和上传过程中镜像是保持着压缩状态的, 因此 Docker Hub 所显示的大小是网络传输中更关心的流量大小。 而 docker image ls 显示的是镜像下载到本地后, 展开的大小, 准确说, 是展开后的各层所占空间的总和, 因为镜像到本地后, 查看空间的时候, 更关心的是本地磁盘空间占用的大小。

列出镜像

另外一个需要注意的问题是, docker image ls 列表中的镜像体积总和并非是所有镜像实际硬盘消耗。 由于 Docker 镜像是多层存储结构, 并且可以继承、 复用,因此不同镜像可能会因为使用相同的基础镜像, 从而拥有共同的层。 由于 Docker使用 Union FS, 相同的层只需要保存一份即可, 因此实际镜像硬盘占用空间很可能要比这个列表镜像大小的总和要小的多。

你可以通过以下命令来便捷的查看镜像、 容器、 数据卷所占用的空间

[root@Docker ~]#docker system df

TYPE TOTAL ACTIVE SIZE RECLAIMABLE

Images 6 3 620.1MB 449.8MB (72%)

Containers 4 0 201.5MB 201.5MB (100%)

Local Volumes 0 0 0B 0B

Build Cache 0 0 0B 0B

3.虚悬镜像

上面的镜像列表中, 还可以看到一个特殊的镜像, 这个镜像既没有仓库名, 也没有标签, 均为

这个镜像原本是有镜像名和标签的,原来为 mongo:3.2 ,随着官方镜像维护, 发布了新版本后, 重新docker pull mongo:3.2 时, mongo:3.2 这个镜像名被转移到了新下载的镜像身上, 而旧的镜像上的这个名称则被取消, 从而成为了docker pull可能导致这种情况,docker build 也同样可以导致这种现象。 由于新旧镜像同名, 旧镜像名称被取消, 从而出现仓库名、 标签均为

[root@Docker ~]#docker image ls -f dangling=true

REPOSITORY TAG IMAGE ID CREATED SIZE

<none> <none> 03966321a4eb 19 hours ago 318MB

一般来说, 虚悬镜像已经失去了存在的价值, 是可以随意删除的, 可以用下面的命令删除

[root@Docker ~]#docker image prune # 删除无用的镜像

WARNING! This will remove all dangling images.

Are you sure you want to continue? [y/N] y

Total reclaimed space: 0B

4.中间镜像层

为了加速镜像构建,重复利用资源,Docker会利用中间层镜像。所以在使用一段时间后,可能会看到一些依赖的中间层镜像。默认的docker image ls列表中只会显示顶层镜像。如果希望显示包括中间层镜像在内的所有镜像,需要加上-a参数。

[root@localhost ~]# docker image ls -a

这样会看到很多无标签的镜像,与之前的虚悬镜像不同,这些标签的镜像很多都是中间层镜像,是其他镜像所依赖的镜像。这些无标签镜像 不应该删除,否则会导致上层镜像因为依赖丢失而出错。实际上,这些镜像也没必要删除,因为相同的层只会存一次,而这些镜像时别的镜像的依赖,因此并不会因为他们被列出来而多存了一份,无论如何也会需要它们。只要删除那些依赖他们的镜像后,这些依赖的中间层镜像也会被连带删除。

5.列出部分镜像

不加任何参数,docker image ls会列出所有顶级镜像。

(1)根据仓库名列出镜像

[root@localhost ~]# docker image ls ubuntu

列出某个特定镜像,指定仓库名和标签

[root@localhost ~]# docker image ls ubuntu:18.04

docker image ls还支持强大的过滤器参数,--filter 或 -f。比如希望看到ubuntu:18.04之后建立的镜像,可以使用以下命令:

[root@localhost ~]# docker image ls -f since=ubuntu:18.04

想看之前的,可以把since换成before即可

注意:之前、之后是指创建时间之前或之后

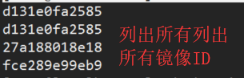

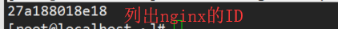

(2)以特定格式显示

默认情况,docker image ls会输出一个完整表格。有时只需要列出ID,然后交个docker image rm命令作为参数删除指定镜像,可以使用-q:

[root@localhost ~]# docker image ls -q

[root@localhost ~]# docker image ls -q nginx

--filter配合-q产生出指定范围ID的列表,然后送给另一个docker命令作为参数。

有些时候,对表格结构不满意,希望自己组织列;或者不希望有标题,方便其他程序解析结果等。这就用到就用到了Go的模版语法。

比如:下面的命令会直接列出镜像结果,只包含镜像ID和仓库名

[root@localhost ~]# docker image ls --format "{{.ID}}:{{.Repository}}"

或者打算以表格等距显示,并且有标题行,和默认一样,不过自己定义列

[root@localhost ~]# docker image ls --format "table {{.ID}}\t{{.Repository}}\t{{.Tag}}"

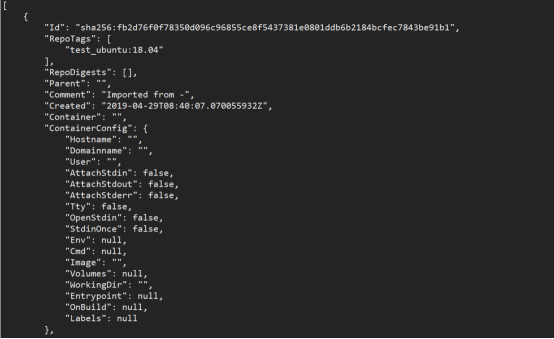

6.查看镜像详细信息

用户可以根据镜像的唯一标识ID号,获取镜像详细信息。

语法:docker inspect [OPTIONS] NAME|ID [NAME|ID...]

[root@localhost ~]# docker inspect fb2 <==查看镜像

获取镜像的详细信息:

docker inspect 命令可以查看镜像和容器的详细信息,默认会列出全部信息

# docker inspect --help

用法:docker inspect [OPTIONS] CONTAINER|IMAGE|TASK [CONTAINER|IMAGE|TASK...]

-f, --format # 可以通过此参数指定输出的模板格式,以便输出特定信息。

-s, --size # 如果类型是容器,则显示总文件大小

--type # 回指定类型的JSON(例如镜像,容器或任务)

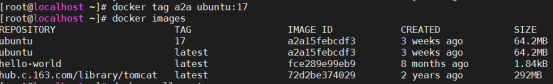

# docker inspect a2a #获取ID号镜像的详细信息

[

{

"Id": "sha256:a2a15febcdf362f6115e801d37b5e60d6faaeedcb9896155e5fe9d754025be12",

"RepoTags": [

"ubuntu:17",

"ubuntu:latest"

],

# 上面是JSON输出信息,内容比较多,只粘贴了部分内容。

# docker inspect -f {{".Architecture"}} a2a #可以指定{{".key"}}的形式只显示指定的值

# docker inspect -f {{".Architecture"}} a2 #当然也可以只截取ID的前一部分

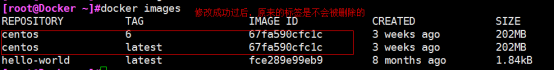

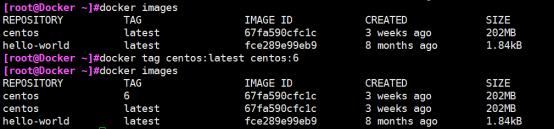

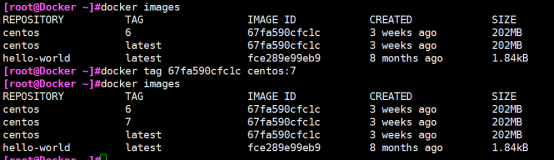

给镜像打标签:

Usage: docker tag SOURCE_IMAGE[:TAG] TARGET_IMAGE[:TAG]