- MySQL备份与还原操作(重点)

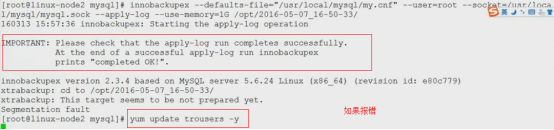

- Xtrabackup备份及恢复

- Xtrabackup完全备份+两次增量备份

- MySQL不停机维护主从同步

- MySql5.7从.frm和.ibd文件恢复数据

- 删库不跑路:论MySQL数据恢复

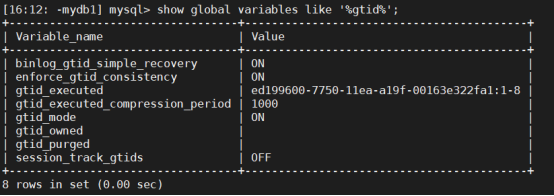

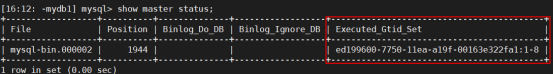

- MySQL的Gtid同步

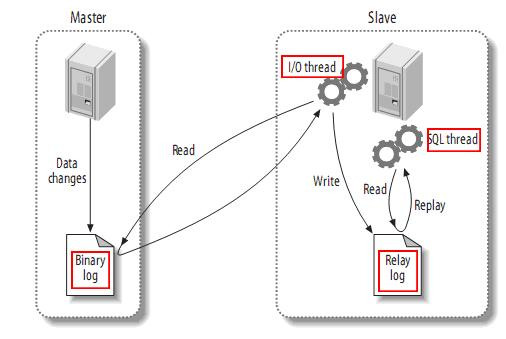

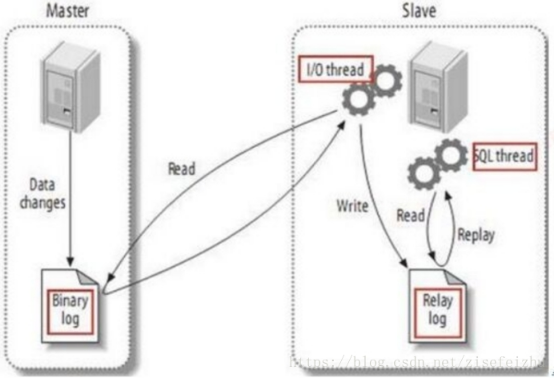

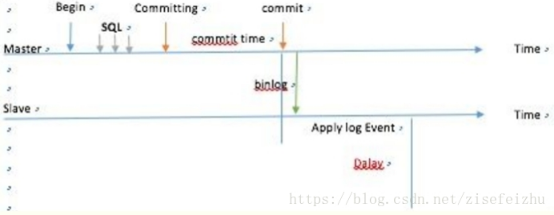

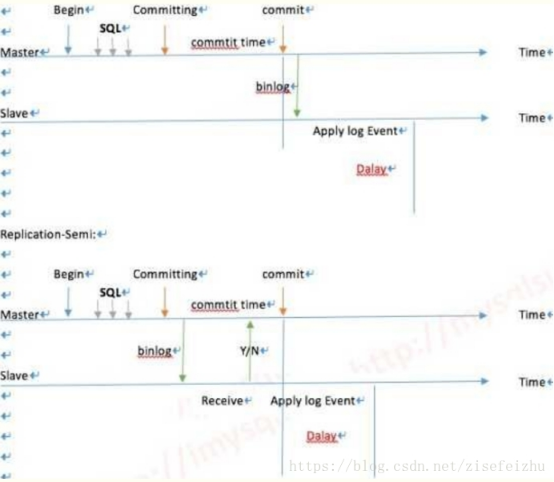

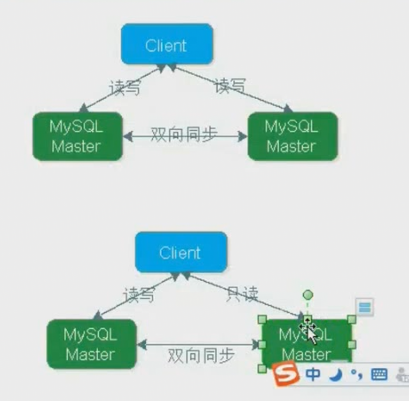

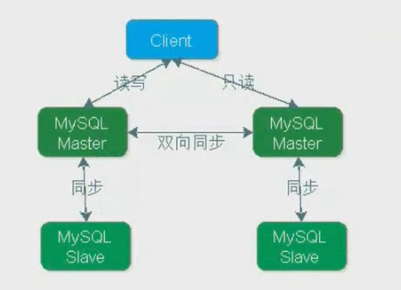

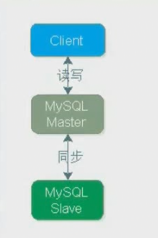

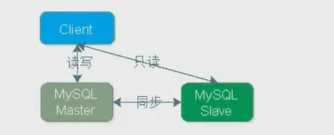

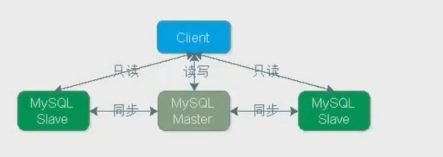

- MySQL主从复制(重点)

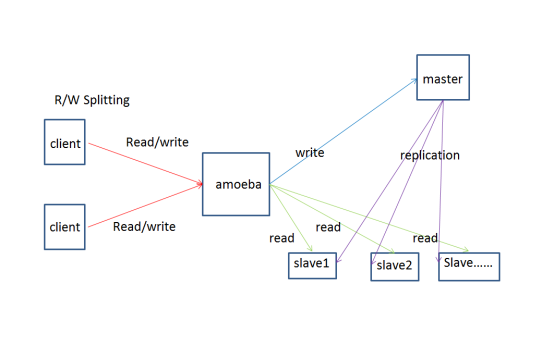

- MySQL的读写分离Amoeba(已经没有维护了,建议不用)

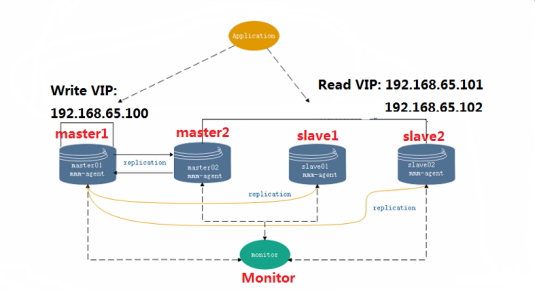

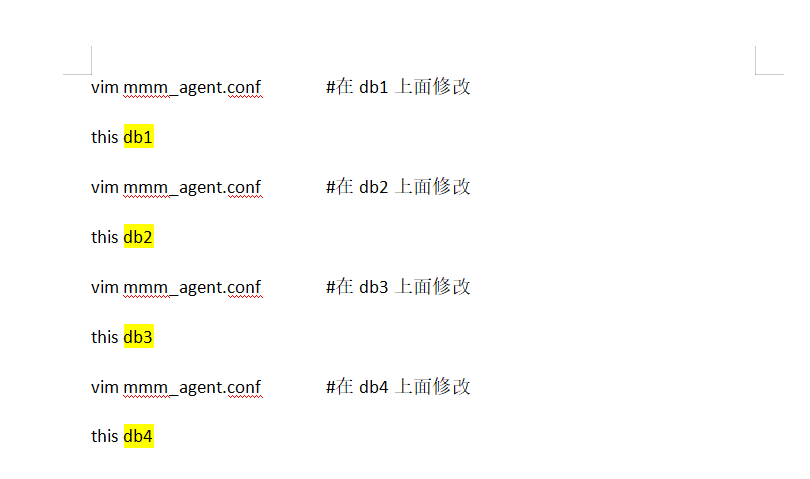

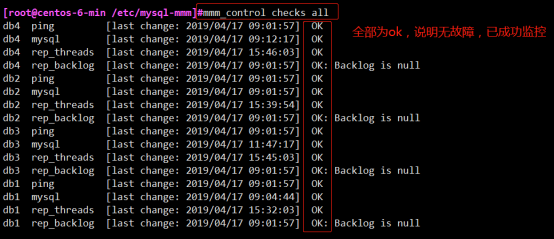

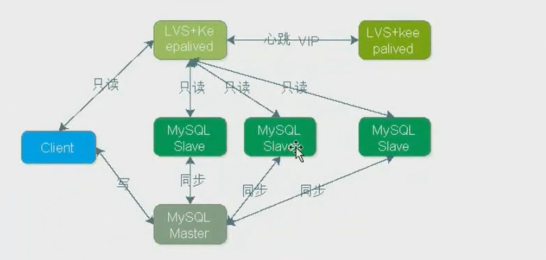

- MySQL-MMM高可用集群(线上建议不用)

- MySQL-MHA高可用(线上建议使用)

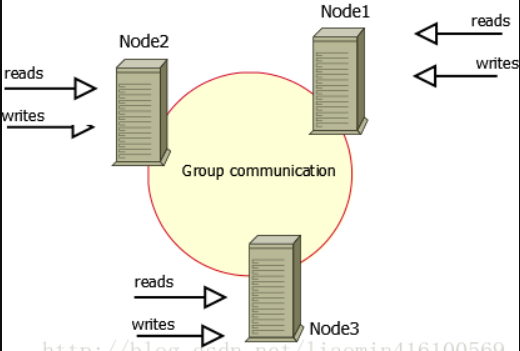

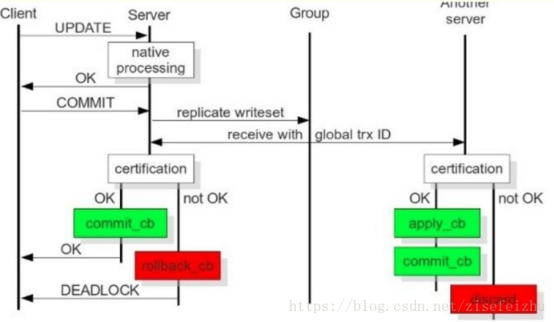

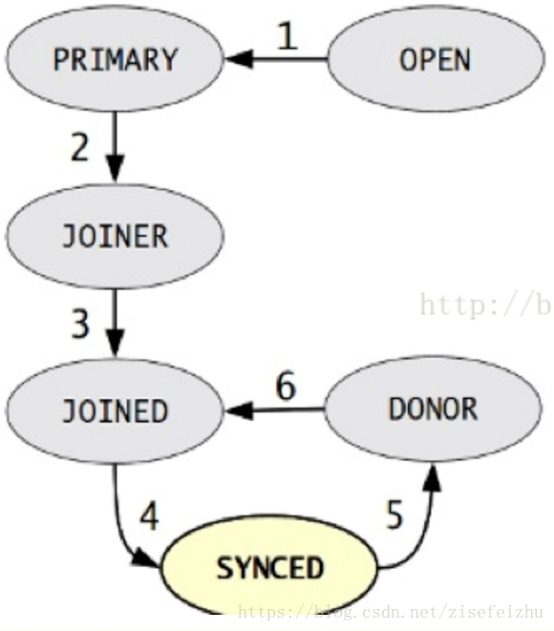

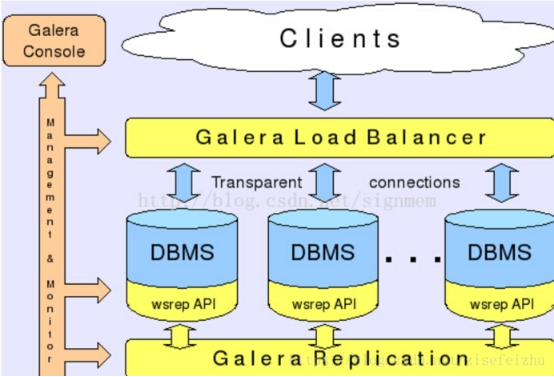

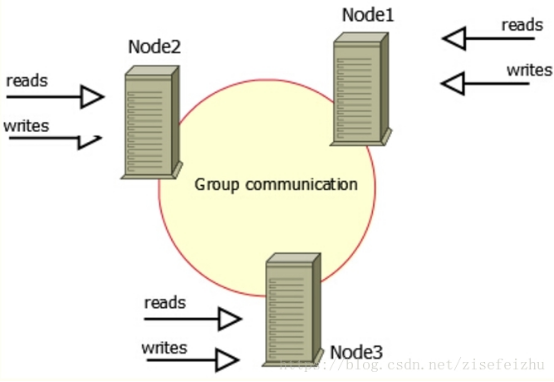

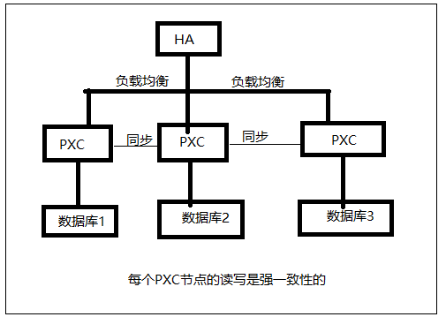

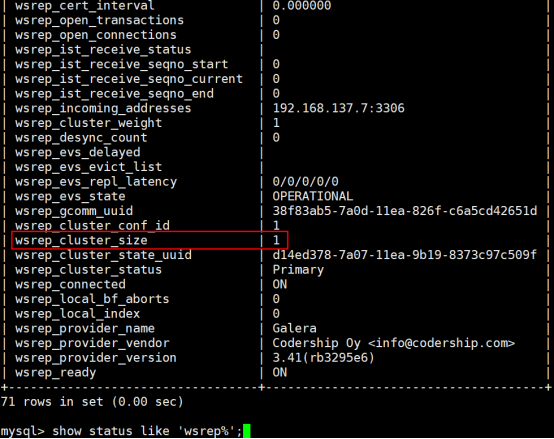

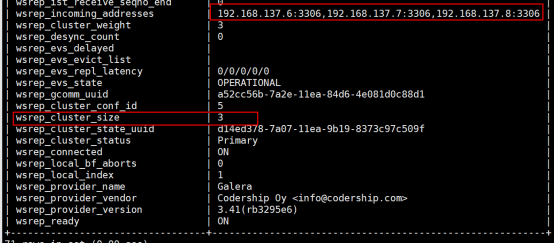

- MySQL高可用之PXC

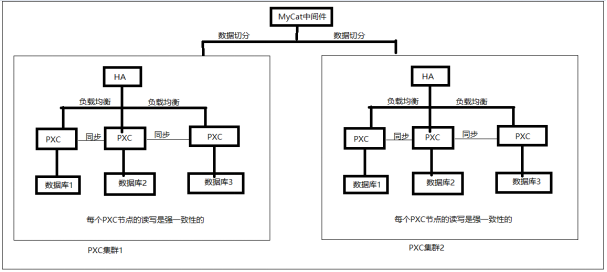

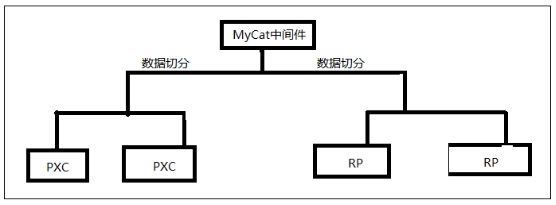

- Mycat中间件实现Mysql数据分片(之一)

- Mysql+haproxy+mycat+pxc+zookeeper实现高可用集群

- MySQL Router 高可用原理与实战

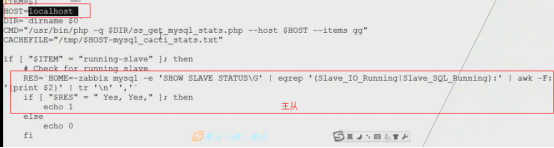

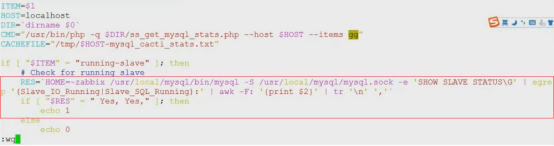

- MySQL监控

- 架构扩展方案

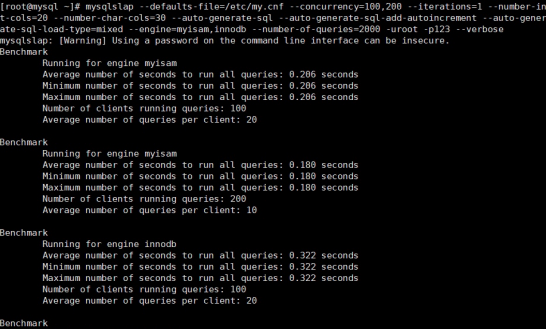

- MySQL进行压测

- MYSQL 开源SQL语句审核平台

- Archery

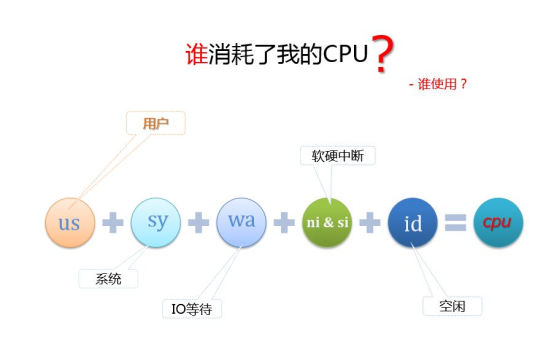

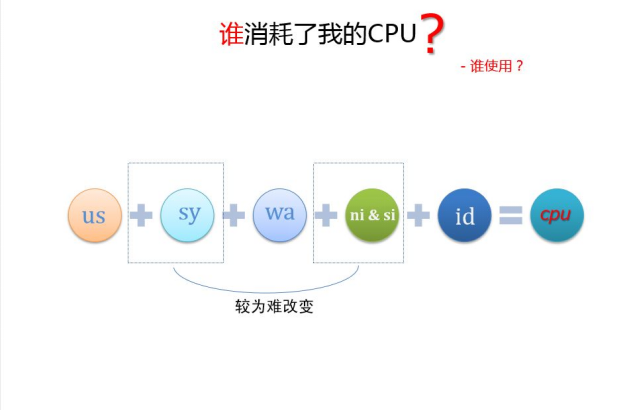

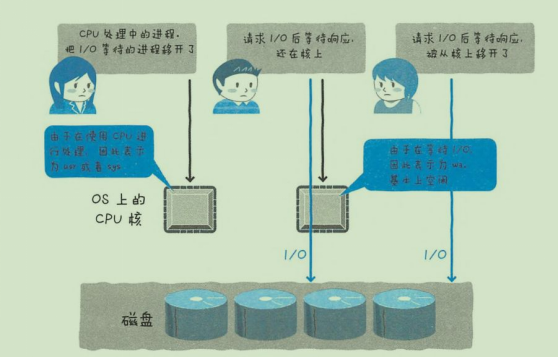

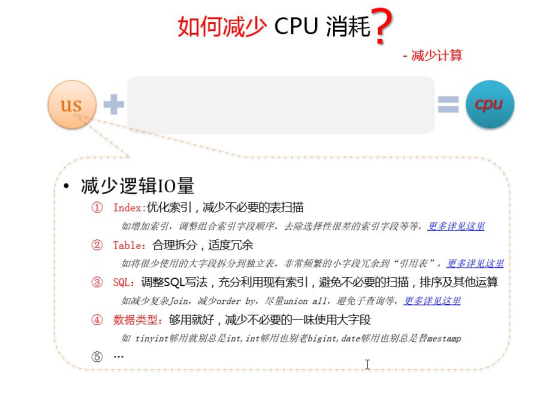

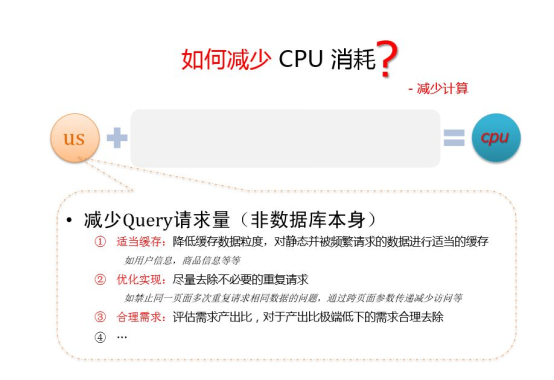

- MySQL 导致 CPU 消耗过大,如何优化

MySQL备份与还原操作(重点)

备份:将当前已有的数据或者记录保留

还原:将已经保留的数据恢复到对应的表中

为什么需要备份数据?

具体了解一下为什么要备份数据:在生产环境中我们数据库可能会遭遇各种各样的不测从而导致数据丢失, 大概分为以下几种.

-

硬件故障

-

软件故障

-

自然灾害

-

黑客攻击

-

误操作 (占比最大)

-

保护数据记录(利用数据,进行分析数据

->为什么销户等原因)

所以, 为了在数据丢失之后能够恢复数据, 我们就需要定期的备份数据, 备份数据的策略要根据不同的应用场景进行定制, 大致有几个参考数值, 我们可以根据这些数值从而定制符合特定环境中的数据备份策略

-

能够容忍丢失多少数据

-

恢复数据需要多长时间

-

需要恢复哪一些数据

企业应用

企业场景全量和增量的频率

1、中小公司,全量一般每天一次,业务流量低谷进行,备份时锁表

增量:定时,例如每分钟rsync推一次binlog

2、大公司,一般周备,节省备份时间,减小备份压力,缺点是binlog文件副本太多,还原比较麻烦

3、一主多从环境,主从复制本身就是实时远程备份,可以解决物理故障

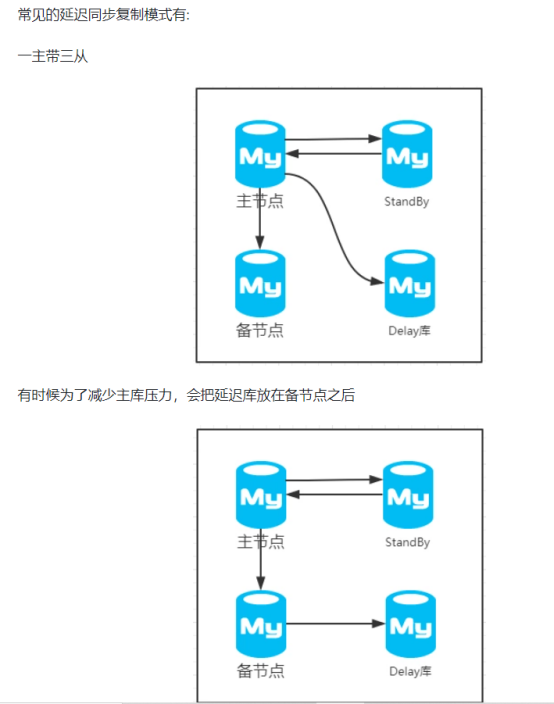

4、一主多从环境,可以采取一个从库上专门进行备份,通过延时同步解决人为误操作

MySQL备份类型

根据服务器状态

Hot backup:热备

-

在数据库运行的过程中,进行备份[虽然可以实现备份]

-

数据库的读写不受影响;但是读写效率明显很低[一般都将其排程到凌晨执行]

Cold backup:冷备

-

在数据库停止运行的情况下,进行备份

-

相对安全,离线备份;读、写操作均中止;但是无法正常运行数据库

Warm backup:温备

-

备份时,同样是在数据库运行的情况下,仅可以执行读操作;但对于当前数据库的操作有一定影响。会以一个全局读锁保证备份数据的一致性

-

锁:为了保证数据的完整性和一致性,通过事务的隔离性实现的一种数据分割的过程

从对象来分

从物理与逻辑角度,可以将备份分为:

A、物理备份:->直接复制(归档)数据文件的备份方式

-

冷备份

-

热备份

B、逻辑备份:->把数据从库中提取出来保存为文本文件

将对数据库逻辑组件(如表等数据库对象)的备份->将数据导出至文本文件中

逻辑备份

逻辑备份的优点:

-

在备份速度上两种备份要取决于不同的存储引擎

-

物理备份的还原速度非常快。但是物理备份的最小力度只能做到表

-

逻辑备份保存的结构通常都是纯ASCII的,所以我们可以使用文本处理工具来处理

-

逻辑备份有非常强的兼容性,而物理备份则对版本要求非常高

-

逻辑备份也对保持数据的安全性有保证

逻辑备份的缺点:

-

逻辑备份要对RDBMS产生额外的压力,而裸备份无压力

-

逻辑备份的结果可能要比源文件更大。所以很多人都对备份的内容进行压缩

-

逻辑备份可能会丢失浮点数的精度信息

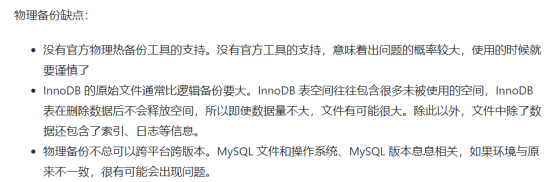

物理备份

从数据收集来分

也可以说从备份策略上讲:

A、完全备份:每次对数据库进行完整的备份[包括所有的数据文件]

B、差异备份:以完全备份作为基础,备份那些自从上次完全备份之后,又被修改过的文件

C、增量备份:仅仅只有上次完全备份或者增量备份以后被修改的文件才做备份

完全备份:[相当于'冷备份'],会对整个数据进行备份(数据库的结构和数据文件的类型以及数据文件结构的备份)

注意:完全备份可以保存上一时刻的完整数据,完全备份是差异备份的基础

优点:备份与恢复简单

缺点:

A、数据存储量比较大,且备份的内容有重复

B、占用数据备份空间

C、备份和恢复时间较长

说明,差异备份要比增量备份占用的空间大,但恢复时比较方便!但我们一般都用增量备份!

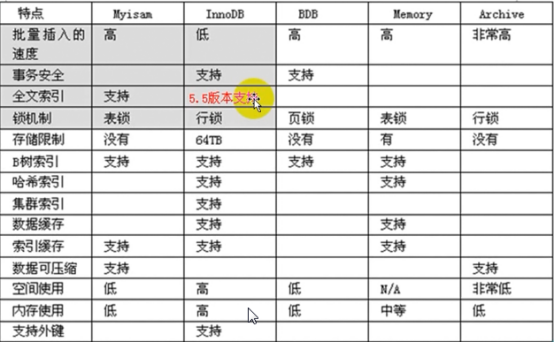

MySQL中进行不同方式的备份还要考虑存储引擎是否支持

- MyISAM

热备 ×

温备 √

冷备 √

- InnoDB

热备 √

温备 √

冷备 √

我们在考虑完数据在备份时, 数据库的运行状态之后还需要考虑对于MySQL数据库中数据的备份方式

- 物理备份

- 逻辑备份

物理备份一般就是通过

tar,cp等命令直接打包复制数据库的数据文件达到备份的效果逻辑备份一般就是通过特定工具从数据库中导出数据并另存备份(逻辑备份会丢失数据精度)

备份需要考虑的问题,定制备份策略前, 我们还需要考虑一些问题

为什么要备份binlog

复制和备份

我们要备份什么?

一般情况下, 我们需要备份的数据分为以下几种

-

数据

-

二进制日志, InnoDB事务日志

-

代码(存储过程、存储函数、触发器、事件调度器)

-

服务器配置文件

MySQL备份策略

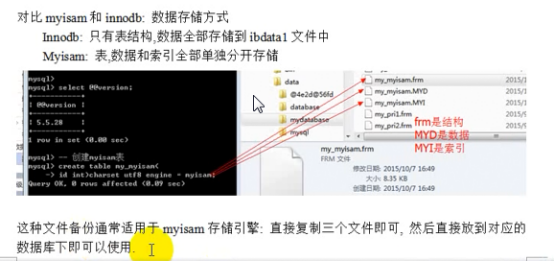

1.策略一:直接拷贝数据库文件(文件系统备份工具 cp)(适合小型数据库,是最可靠的)

当你使用直接备份方法时,必须保证表不在被使用。如果服务器在你正在拷贝一个表时改变它,拷贝就失去意义。保证你的拷贝完整性的最好方法是关闭服务器,拷贝文件,然后重启服务器。如果你不想关闭服务器,要在执行表检查的同时锁定服务器。如果服务器在运行,相同的制约也适用于拷贝文件,而且你应该使用相同的锁定协议让服务器"安静下来"。当你完成了备份时,需要重启服务器(如果关闭了它)或释放加在表上的锁定(如果你让服务器运行)。要用直接拷贝文件把一个数据库从一台机器拷贝到另一台机器上,只是将文件拷贝到另一台服务器主机的适当数据目录下即可。要确保文件是MyIASM格式或两台机器有相同的硬件结构,否则你的数据库在另一台主机上有奇怪的内容。你也应该保证在另一台机器上的服务器在你正在安装数据库表时不访问它们。

2.策略二:mysqldump备份数据库(完全备份+增加备份,速度相对较慢,适合中小型数据库)(MyISAM是温备份,InnoDB是热备份)

mysqldump 是采用SQL级别的备份机制,它将数据表导成 SQL 脚本文件,在不同的 MySQL 版本之间升级时相对比较合适,这也是最常用的备份方法。mysqldump 比直接拷贝要慢些。对于中等级别业务量的系统来说,备份策略可以这么定:第一次完全备份,每天一次增量备份,每周再做一次完全备份,如此一直重复。而对于重要的且繁忙的系统来说,则可能需要每天一次全量备份,每小时一次增量备份,甚至更频繁。为了不影响线上业务,实现在线备份,并且能增量备份,最好的办法就是采用主从复制机制(replication),在 slave 机器上做备份。

3.策略三:lvs快照从物理角度实现几乎热备的完全备份,配合二进制日志备份实现增量备份,速度快适合比较烦忙的数据库

前提:

-

数据文件要在逻辑卷上;

-

此逻辑卷所在卷组必须有足够空间使用快照卷;

-

数据文件和事务日志要在同一个逻辑卷上;

策略三步骤:

(1).打开会话,施加读锁,锁定所有表;

mysql> FLUSH TABLES WITH READ LOCK;

mysql> FLUSH LOGS;

(2).通过另一个终端,保存二进制日志文件及相关位置信息;

mysql -uroot -p -e 'SHOW MASTER STATUS\G' > /path/to/master.info

(3).创建快照卷

lvcreate -L -s -p r -n LV_NAME /path/to/source_lv

(4).释放锁

mysql> UNLOCK TABLES;

(5).挂载快照卷,备份

mount

cp

(6).删除快照卷;

或者用现成的集成命令工具mylvmbackup(可以集成上面的命令集合,自动完成备份)

mylvmbackup --user=dba --password=xxx --mycnf=/etc/my.cnf --vgname=testvg --lvname=testlv --backuptype=tar --lvsize=100M --backupdir=/var/lib/backup

4.策略四:xtrabackup备份数据库,实现完全热备份与增量热备份(MyISAM是温备份,InnoDB是热备份),由于有的数据在设计之初,数据目录没有存放在LVM上,所以不能用LVM作备份,则用xtrabackup代替来备份数据库

说明:Xtrabackup是一个对InnoDB做数据备份的工具,支持在线热备份(备份时不影响数据读写),是商业备份工具InnoDB Hotbackup或ibbackup的一个很好的替代品。

Xtrabackup有两个主要的工具:xtrabackup、innobackupex

-

xtrabackup 只能备份InnoDB和XtraDB两种数据表,而不能备份MyISAM数据表。

-

innobackupex 是参考了InnoDB Hotbackup的innoback脚本修改而来的。innobackupex是一个perl脚本封装,封装了xtrabackup。主要是为了方便的同时备份InnoDB和MyISAM引擎的表,但在处理myisam时需要加一个读锁。并且加入了一些使用的选项。如slave-info可以记录备份恢复后作为slave需要的一些信息,根据这些信息,可以很方便的利用备份来重做slave。

特点:

-

备份过程快速、可靠;

-

备份过程不会打断正在执行的事务;

-

能够基于压缩等功能节约磁盘空间和流量;

-

自动实现备份检验;

-

还原速度快;

下载地址:https://www.percona.com

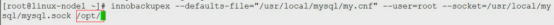

举例:

5.策略五:主从复制(replication)实现数据库实时备份(集群中常用)

常用的备份工具

| 备份方法 | 备份速度 | 恢复速度 | 便捷性 | 功能 | 一般用于 |

|---|---|---|---|---|---|

| cp | 快 | 快 | 一般、灵活性低 | 很弱 | 少量数据备份 |

| mysqldump | 慢 | 慢 | 一般、可无视存储引擎的差异 | 一般 | 中小型数据量的备份 |

| lvm2快照 | 快 | 快 | 一般、支持几乎热备、速度快 | 一般 | 中小型数据量的备份 |

| xtrabackup | 较快 | 较快 | 实现innodb热备、对存储引擎有要求 | 强大 | 较大规模的备份 |

1.Mysql自带的备份工具

-

mysqldump 逻辑备份工具,支持所有引擎,MyISAM引擎是温备,InnoDB引擎是热备,备份速度中速,还原速度非常非常慢,但是在实现还原的时候,具有很大的操作余地。具有很好的弹性。

-

mysqlhotcopy 物理备份工具,但只支持MyISAM引擎,基本上属于冷备的范畴,物理备份,速度比较快。

2.文件系统备份工具

- cp 冷备份,支持所有引擎,复制命令,只能实现冷备,物理备份。使用归档工具,cp命令,对其进行备份的,备份速度快,还原速度几乎最快,但是灵活度很低,可以跨系统,但是跨平台能力很差。

lvm 几乎是热备份,支持所有引擎,基于快照(LVM,ZFS)的物理备份,速度非常快,几乎是热备。只影响数据几秒钟而已。但是创建快照的过程本身就影响到了数据库在线的使用,所以备份速度比较快,恢复速度比较快,没有什么弹性空间,而且LVM的限制:不能对多个逻辑卷同一时间进行备份,所以数据文件和事务日志等各种文件必须放在同一个LVM上。而ZFS则非常好的可以在多逻辑卷之间备份。

3.其它工具

-

ibbackup 商业工具 MyISAM是温备份,InnoDB是热备份 ,备份和还原速度都很快,这个软件它的每服务器授权版本是5000美元。

-

xtrabackup 开源工具 MyISAM是温备份,InnoDB是热备份 ,是ibbackup商业工具的替代工具。

这里我们列举出常用的几种备份工具

- mysqldump : 逻辑备份工具, 适用于所有的存储引擎, 支持温备、完全备份、部分备份、对于InnoDB存储引擎支持热备

- cp, tar 等归档复制工具: 物理备份工具, 适用于所有的存储引擎, 冷备、完全备份、部分备份

- lvm2 snapshot: 几乎热备, 借助文件系统管理工具进行备份

- mysqlhotcopy: 名不副实的的一个工具, 几乎冷备, 仅支持MyISAM存储引擎

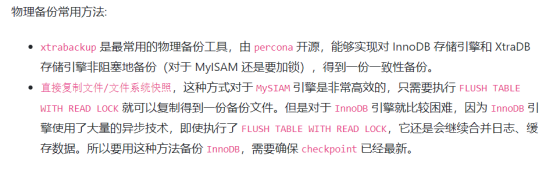

- xtrabackup: 一款非常强大的InnoDB/XtraDB热备工具, 支持完全备份、增量备份, 由percona提供

设计合适的备份策略

针对不同的场景下, 我们应该制定不同的备份策略对数据库进行备份, 一般情况下, 备份策略一般为以下三种

-

直接cp,tar复制数据库文件

-

mysqldump+复制BIN LOGS

-

lvm2快照+复制BIN LOGS

-

xtrabackup

以上的几种解决方案分别针对于不同的场景

-

如果数据量较小, 可以使用第一种方式, 直接复制数据库文件

-

如果数据量还行, 可以使用第二种方式, 先使用mysqldump对数据库进行完全备份, 然后定期备份BINARY LOG达到增量备份的效果

-

如果数据量一般, 而又不过分影响业务运行, 可以使用第三种方式, 使用lvm2的快照对数据文件进行备份, 而后定期备份BINARY LOG达到增量备份的效果

-

如果数据量很大, 而又不过分影响业务运行, 可以使用第四种方式, 使用xtrabackup进行完全备份后, 定期使用xtrabackup进行增量备份或差异备份

完全备份及恢复(3种方法)

进行冷备->完全备份

将当前数据库停止运行,然后对数据库文件,整体进行copy操作

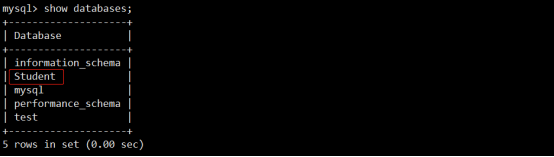

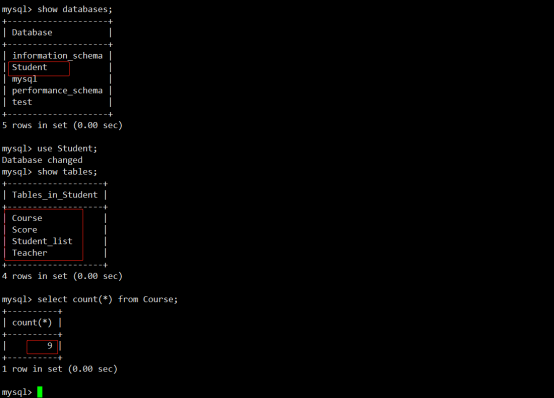

查看当前数据库的信息:

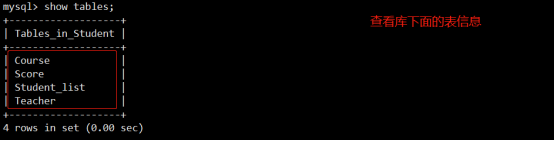

查看库下面的表信息:

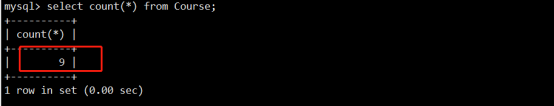

查看表下面的行数:(由于时间问题,就查看Course表的行数)

Course表的总行数9条。

向所有表施加读锁:

停止运行数据库:

service mysqld stop

恢复数据库:

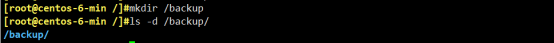

创建目录用于存放备份数据:

保留权限的拷贝源数据文件:

(生产环境中应把备份文件拷到另一台服务器上)

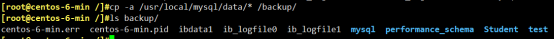

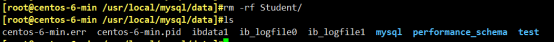

模拟数据丢失并恢复:(删除Student库)

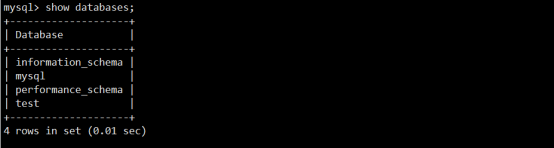

删除Student库过后,再次查看没有Student库:

恢复数据(把删除的数据从备份区域copy至MySQL的data目录下):

重启数据库:

重新连接数据库,然后进行验证:

库已经恢复

表的行数未发生变化

完成。

通过mysqldump命令进行完全备份

官网: https://dev.mysql.com/doc/refman/5.7/en/mysqldump.html

[自带的工具],mysqldump是一个客户端的逻辑备份工具, 适用于相对不那么大的数据库,因为使用mysql协议,速度比较慢; 可以生成一个重现创建原始数据库和表的SQL语句, 可以支持所有的存储引擎, 对于InnoDB支持热备

mysqldump备份方式是采用的逻辑备份,其最大的缺陷是备份和恢复速度较慢,如果数据库大于50G,mysqldump备份就不太适合

基本语法格式:

默认不带参数的导出,导出文本内容大概如下:创建数据库判断语句-删除表-创建表-锁表-禁用索引-插入数据-启用索引-解锁表。

shell> mysqldump [options] db_name [tbl_name ...]恢复需要手动CRATE DATABASES

shell> mysqldump [options] --databases db_name ...恢复不需要手动创建数据库

shell> mysqldump [options] --all-databases 恢复不需要手动创建数据库

mysql 导出表结构和表数据 mysqldump用法,命令行下具体用法如下:

mysqldump -u用户名 -p密码 -d 数据库名 表名 > 脚本名;

常用选项:使用时请mysqldump --help查看本版本支持的参数

说明:长选项需要加等于符合,短选项除了-p(密码)直接接到后面

--user=root -padmin -B djangoblog --flush-privileges

- -u[user_name] |--user:通过指定用户名进行备份;连接MySQL服务器的用户名。

- -p[password] |--password:连接MySQL服务器的密码;提醒:数据库有密码时,就需要用这些参数

- -P[port] |--port:MySQL服务器的端口号;

-

-h|--host:指定要备份数据库的服务器;

-

-B|--databases:指定要备份的数据库1、数据库2......;如果没有该选项,mysqldump把第一个名字参数作为数据库名,后面的作为表名;如果使用该选项,mysqldum把每个名字都当作为数据库名

-

-A|--all-databases:备份MySQL服务器上的所有数据库(适用于不记得数据库名或者表名的情况下)

-

--tables Overrides option --databases (-B).

-

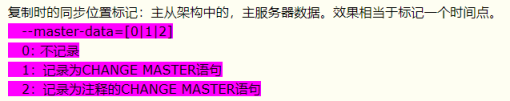

--master-data=2表示在备份文件中记录当前二进制日志的位置;

-

--master-data={0|1|2} 此选项会自动关闭

--lock-tables功能,自动打开--lock-all-tables功能(除非开启--single-transaction) -

0: 不记录二进制日志文件及路位置

-

1:以CHNAGE MASTER TO的方式记录位置,可用于恢复后直接启动从服务器

-

2:以CHANGE MASTER TO的方式记录位置,但默认为被注释

-

-d | --no-data 只备份表结构

-

-t |--no-create-info:只备份数据,不备份表结构(create table),只导出数据,而不添加CREATE TABLE 语句。

mysqldump -uroot -p --host=localhost --all-databases --no-create-info -

-n|--no-create-db 禁止生成创建数据库语句;只导出数据,而不添加CREATE DATABASE 语句

mysqldump -uroot -p --host=localhost --all-databases --no-create-db -

--add-drop-database每个数据库创建之前添加drop数据库语句。

mysqldump -uroot -p --all-databases --add-drop-database -

--add-drop-table:在每个创建数据库表语句前添加删除数据库表的语句;每个数据表创建之前添加drop数据表语句。(默认为打开状态,使用

--skip-add-drop-table取消选项)

mysqldump -uroot -p --all-databases (默认添加drop语句)

mysqldump -uroot -p --all-databases --skip-add-drop-table (取消drop语句)

- -E|--events表示备份数据的同时备份时间调度器代码;

-

-R|--routines表示备份数据的同时备份存储过程和存储函数;

-

--triggers:备份表相关触发器,默认启用,用--skip-triggers,不备份触发器

- -F|--flush-logs: 备份前滚动日志,锁定表完成后,执行

flush logs命令,生成新的二进制日志文件,配合-A时,会导致刷新多次数据库,在同一时刻执行转储和日志刷新,则应同时使用--flush-logs和-x,--master-data或-single-transaction,此时只刷新一次。建议:和-x,--master-data或--single-transaction一起使用 -

--log-error=name 指定此次备份的出错日志文件路径,附加警告和错误信息到给定文件。

mysqldump -uroot -p --host=localhost --all-databases --log-error=/tmp/mysqldump_error_log.err -

--add-locks:备份数据库表时锁定数据库表;在每个表导出之前增加LOCK TABLES并且之后UNLOCK TABLE。(默认为打开状态,使用

--skip-add-locks取消选项)

mysqldump -uroot -p --all-databases (默认添加LOCK语句)

mysqldump -uroot -p --all-databases --skip-add-locks (取消LOCK语句)

- --compact Give less verbose output (useful for debugging). Disables:产生更少的输出(一般用于Debug调试);导出更少的输出信息(用于调试)。去掉注释和头尾等结构。可以使用选项:

--skip-add-drop-table --skip-add-locks --skip-comments --skip-disable-keys

mysqldump -uroot -p --all-databases --compact

-

-C, --compress Use compression in server/client protocol. 在服务器/客户端协议中使用压缩

-

--complete-insert:输出完成的插入语句;使用完整的insert语句(包含列名称)。这么做能提高插入效率,但是可能会受到max_allowed_packet参数的影响而导致插入失败。

mysqldump -uroot -p --all-databases --complete-insert

- -f |--force:在导出过程中忽略出现的SQL错误,当出现错误时仍然继续备份操作

mysqldump -uroot -p --all-databases --force

-

--quick,-q 该选项在导出大表时很有用,它强制 mysqldump 从服务器查询取得记录直接输出而不是取得所有记录后将它们缓存到内存中。默认为打开状态,使用

--skip-quick取消该选项 -

--ignore-table=dbname.tablename 不导出指定表。指定忽略多个表时,需要重复多次,每次一个表。每个表必须同时指定数据库和表名。例如:

--ignore-table=database.table1 --ignore-table=database.table2 ......

mysqldump -uroot -p --host=localhost --all-databases --ignore-table=mysql.user

- --hex-blob 该参数文档描述该工具只能对BINARY, VARBINARY, BLOB类型作十六进制转换。但是测试过程中发现,对bit类型也可以作十六进制转换. 同版本下不加此参数一般不会有什么问题,但在不同MySQL版本间最好加此参数。使用十六进制格式导出二进制字符串字段。如果有二进制数据就必须使用该选项。影响到的字段类型有BINARY、VARBINARY、BLOB。

mysqldump -uroot -p --all-databases --hex-blob

- --opt 如果有这个参数表示同时激活了mysqldump命令的quick, add-drop-table, add-locks,extended-insert, lock-tables 等参数,它可以给出很快的转储操作并产生一个可以很快装入MySQL服务器的转储文件。当备份大表时,这个参数可以防止占用过多内存。该选项默认开启, 可以用--skip-opt禁用。Same as --add-drop-table, --add-locks, --create-options,--quick, --extended-insert, --lock-tables, --set-charset,and --disable-keys. Enabled by default, disable with--skip-opt.

mysqldump -uroot -p --host=localhost --all-databases --opt

- --include-master-host-port在

--dump-slave产生的'CHANGE MASTER TO..'语句中增加MASTER_HOST=<host>,MASTER_PORT=<port>

mysqldump -uroot -p --host=localhost --all-databases --include-master-host-port

- --insert-ignore 在插入行时使用INSERT IGNORE语句.

mysqldump -uroot -p --host=localhost --all-databases --insert-ignore

- --replace 使用REPLACE INTO 取代INSERT INTO.

mysqldump -uroot -p --host=localhost --all-databases --replace

- --default-character-set 设置默认字符集,默认值为utf8

mysqldump -uroot -p --all-databases --default-character-set=utf8

mysqldump -uroot -p --all-databases --default-character-set=latin

- --comments 附加注释信息。默认为打开,可以用

--skip-comments取消

mysqldump -uroot -p --all-databases (默认记录注释)

mysqldump -uroot -p --all-databases --skip-comments (取消注释)

- -w, --where=name Dump only selected records. Quotes are mandatory. 条件导出,导出db1表a1中id=1的数据

mysqldump -uroot -proot --databases db1 --tables a1 --where='id=1' >/tmp/a1.sql

跨服务器导出导入数据

mysqldump --host=h1 -uroot -proot --databases db1 | mysql --host=h2 -uroot -proot db2

将h1服务器中的db1数据库的所有数据导入到h2中的db2数据库中,db2的数据库必须存在否则会报错

mysqldump --host=192.168.80.137 -uroot -proot -C --databases test | mysql --host=192.168.80.133 -uroot -proot test

默认mysqldump会将多条插入语句导出成一条insert语句格式,如:

insert into t values(1),(2);

那有时我想生成多条insert语句,如:

insert into t values(1);

insert into t values(2);

这时,在mysqldump时加上参数--skip-extended-insert即可。

mysqldump 会导出一条insert语句,虽说执行起来会快一些。但是遇到大表,很可能因为缓冲区过载而挂掉。 而且不容易阅读 mysqldump 的--skip-opt这个参数,就可以导出多条insert

mysqldump --skip-opt -uroot -p database tablename > script.sql

1 -A --all-databases:导出全部数据库

2 -Y --all-tablespaces:导出全部表空间

3 -y --no-tablespaces:不导出任何表空间信息

4 --add-drop-database每个数据库创建之前添加drop数据库语句。

5 --add-drop-table每个数据表创建之前添加drop数据表语句。(默认为打开状态,使用--skip-add-drop-table取消选项)

6 --add-locks在每个表导出之前增加LOCK TABLES并且之后UNLOCK TABLE。(默认为打开状态,使用--skip-add-locks取消选项)

7 --comments附加注释信息。默认为打开,可以用--skip-comments取消

8 --compact导出更少的输出信息(用于调试)。去掉注释和头尾等结构。便会忽略:--skip-add-drop-table --skip-add-locks --skip-comments --skip-disable-keys等几个参数的功能

9 -c --complete-insert:使用完整的insert语句(包含列名称)。这么做能提高插入效率,但是可能会受到max_allowed_packet参数的影响而导致插入失败。

10 -C --compress:在客户端和服务器之间启用压缩传递所有信息

11 -B --databases:导出几个数据库。参数后面所有名字参量都被看作数据库名。

12 --debug输出debug信息,用于调试。默认值为:d:t:o,/tmp/

13 --debug-info输出调试信息并退出

14 --default-character-set设置默认字符集,默认值为utf8

15 --delayed-insert 采用延时插入方式(INSERT DELAYED)导出数据

16 -E --events:导出事件。

17 --master-data:在备份文件中写入备份时的binlog文件,在恢复进,增量数据从这个文件之后的日志开始恢复。值为1时,binlog文件名和位置没有注释,为2时,则在备份文件中将binlog的文件名和位置进行注释

18 -F, --flush-logs 开始导出之前刷新日志。请注意:假如一次导出多个数据库(使用选项--databases或者--all-databases),将会逐个数据库刷新日志。除使用--lock-all-tables或者--master-data外。在这种情况下,日志将会被刷新一次,相应的所以表同时被锁定。因此,如果打算同时导出和刷新日志应该使用--lock-all-tables 或者--master-data 和--flush-logs。 刷新binlog,如果binlog打开了,-F参数会在备份时自动刷新binlog进行切换。

19 --flush-privileges在导出mysql数据库之后,发出一条FLUSH PRIVILEGES 语句。为了正确恢复,该选项应该用于导出mysql数据库和依赖mysql数据库数据的任何时候。

20 --force在导出过程中忽略出现的SQL错误。

21 -h --host:需要导出的主机信息

22 --ignore-table不导出指定表。指定忽略多个表时,需要重复多次,每次一个表。每个表必须同时指定数据库和表名。例如:--ignore-table=database.table1 --ignore-table=database.table2 ……

23 -x --lock-all-tables:提交请求锁定所有数据库中的所有表,以保证数据的一致性。这是一个全局读锁,并且自动关闭--single-transaction 和--lock-tables 选项。

24 -l --lock-tables:开始导出前,锁定所有表。用READ LOCAL锁定表以允许MyISAM表并行插入。

对于支持事务的表例如InnoDB和BDB --single-transaction是一个更好的选择,因为它根本不需要锁定表。请注意当导出多个数据库时,--lock-tables分别为每个数据库锁定表。因此,该选项不能保证导出文件中的表在数据库之间的逻辑一致性。不同数据库表的导出状态可以完全不同。

25 --single-transaction:适合innodb事务数据库的备份。保证备份的一致性,原理是设定本次会话的隔离级别为Repeatable read,来保证本次会话(也就是dump)时,不会看到其它会话已经提交了的数据。

26 -n --no-create-db:只导出数据,而不添加CREATE DATABASE 语句。

27 -t --no-create-info:只导出数据,而不添加CREATE TABLE 语句。

28 -d --no-data:不导出任何数据,只导出数据库表结构。

29 -p --password:连接数据库密码

30 -P --port:连接数据库端口号

31 -u --user:指定连接的用户名。

MyISAM备份选项:

支持温备;不支持热备,所以必须先锁定要备份的库,而后启动备份操作

锁定方法如下:

- -x,--lock-all-tables:加全局读锁,锁定所有库的所有表,同时加

--single-transaction或--lock-tables选项会关闭此选项功能

注意:数据量大时,可能会导致长时间无法并发访问数据库

-l,--lock-tables:对于需要备份的每个数据库,在启动备份之前分别锁定其所有表,默认为on,--skip-lock-tables选项可禁用,对备份MyISAM的多个库,可能会造成数据不一致

注:以上选项对InnoDB表一样生效,实现温备,但不推荐使用

- -B:指定多个库,在备份文件中增加建库语句和use语句

-

--compact:去掉备份文件中的注释,适合调试,生产场景不用

-

-A:备份所有库

- -F:刷新binlog日志

- --master-data:在备份文件中增加binlog日志文件名及对应的位置点

-

-x --lock-all-tables:锁表

-

-l:只读锁表

-

-d:只备份表结构

-

-t:只备份数据

InnoDB备份选项:

支持热备,可用温备但不建议用

--single-transaction

此选项Innodb中推荐使用,适合innodb事务数据库的备份,不适用MyISAM,此选项会开始备份前,先执行START TRANSACTION指令,并且在备份期间,不允许对数据进行修改操作,此选项和--lock-tables(此选项隐含提交挂起的事务)选项是相互排斥;备份大型表时,建议将--single-transaction选项和--quick结合一起使用

InnoDB表在备份时,通常启用选项--single-transaction来保证备份的一致性,原理是设定本次会话的隔离级别为Repeatable read,来保证本次会话(也就是dump)时,不会看到其它会话已经提交了的数据

综合示例:

- 备份所有数据库:

shell> mysqldump -uroot -p --all-database > all.sql

- 备份数据库 test

shell> mysqldump -uroot -p test > test.sql

- 备份数据库 test 下的emp表

shell> mysqldump -uroot -p test emp > emp.sql

- 备份数据库 test 下的 emp 和 dept 表

shell> mysqldump -uroot -p test emp dept > emp_dept.sql

- 备份数据库test 下的所有表为逗号分割的文本,备份到 /tmp:

shell> mysqlddump -uroot -p -T /tmp test emp --fields-terminated-by ','

shell> more emp.txt

1,z1

2,z2

3,z3

4,z4

6、导出单个数据表结构和数据

mysqldump -h localhost -uroot -p123456 database table > dump.sql

7、导出整个数据库结构(不包含数据)

mysqldump -h localhost -uroot -p123456 -d database > dump.sql

8、导出单个数据表结构(不包含数据)

mysqldump -h localhost -uroot -p123456 -d database table > dump.sql

9、mysqldump 备份导出数据排除某张表就用--ignore-table=dbname.tablename参数就行了。

mysqldump -uusername -ppassword -h192.168.0.1 -P3306 dbname --ignore-table=dbname.dbtables > dump.sql

注意: 为了保证数据备份的一致性,myisam 存储引擎在备份时需要加上-l参数,表示将所有表加上读锁,在备份期间,所有表将只能读而不能进行数据更新。但是对于事务存储引擎来说,可以采用更好的选项--single-transaction,此选项使得 innodb 存储引擎得到一个快照(snapshot),使得备份的数据能够保证一致性。

不同引擎备份命令参数用法(重点)

(1)Myisam引擎:

mysqldump -uroot -p123456 -A -B --master-data=1 -x | gzip > /data/all_$(date +%F).sql.gz

(2)InnoDB引擎:

mysqldump -uroot -p123456 -A -B --master-data=1 --single-transaction > /data/bak.sql

(3)生产环境DBA给出的命令

a、for MyISAM

mysqldump --user=root --all-databases --opt --flush-privileges \

--lock-all-tables \

--master-data=2 --flush-logs --triggers --routines --events \

--hex-blob > $BACKUP_DIR/full_dump_$BACKUP_TIMESTAMP.sql

b、for InnoDB

mysqldump --user=root --all-databases --opt --flush-privileges --single-transaction \

--master-data=2 --flush-logs --triggers --routines --events \

--hex-blob > $BACKUP_DIR/full_dump_$BACKUP_TIMESTAMP.sql

恢复数据库[针对mysqldump及mysql命令导出的sql备份文件进行恢复]

A、source命令:在mysql内部命令行执行。如果sql文件中没有创建库语句,必须手动创建该库且进入该库

语法:

mysql> source /backup/backup.sql

mysql> \. /backup/backup.sql

-- /backup/backup.sql -> /备份路径/备份文件名称

B、mysql命令:在Linux命令行执行。如果sql文件中没有创建库语句,必须手动创建

语法:

mysql [options] < 备份数据库文件

mysql -u root -p666666 zabbix < /root/zabbix-4.4.7/database/mysql/schema.sql

1、首先建空数据库

mysql> create database abc;

2、导入数据库

方法一:

(1)选择数据库

mysql> use abc;

(2)设置数据库编码

mysql> set names utf8;

(3)导入数据(注意sql文件的路径)

mysql> source /home/abc/abc.sql;

方法二:建议使用第二种方法导入

mysql -u用户名 -p密码 数据库名 < 数据库名.sql

mysql -uroot -p abc < abc.sql

注意:完全备份与恢复,都是在实际环境中经常使用,且必须搭配crontab进行定时任务备份

Xtrabackup

增量备份及恢复

基于binlog时间点增量备份及恢复

增量备份的特点:

-

没有重复的数据文件,且备份量不大,用时比较短

-

增量恢复的基础

->上一次完全备份,而且要对所有增量备份进行逐个反推恢复

增量备份实现方法:mysqlbinlog命令

必须依赖于二进制日志文件进行备份[binary log]

从binlog日志恢复数据,恢复语法格式:

# mysqlbinlog mysql-bin.0000xx | mysql -u用户名 -p密码 数据库名

常用选项:

-

-d 指定库的binlog

-

-r 相当于重定向到指定文件

-

--start-position=953 起始pos点

-

--stop-position=1437 结束pos点

-

--start-datetime=

2013-11-29 13:18:54起始时间点 -

--stop-datetime=

2013-11-29 13:21:53结束时间点 -

--database=zyyshop 指定只恢复zyyshop数据库(一台主机上往往有多个数据库,只限本地log日志)

不常用选项:

-

-u --user=name Connect to the remote server as username.连接到远程主机的用户名

-

-p --password[=name] Password to connect to remote server.连接到远程主机的密码

-

-h --host=name Get the binlog from server.从远程主机上获取binlog日志

-

--read-from-remote-server Read binary logs from a MySQL server.从某个MySQL服务器上读取binlog日志

小结:实际是将读出的binlog日志内容,通过管道符传递给mysql命令。这些命令、文件尽量写成绝对路径;

1、首先做一次完整备份:

mysqldump -h10.6.208.183 -utest2 -p123 -P3310 --single-transaction --master-data=2 test > test.sql #这时候就会得到一个全备文件test.sql

在test.sql文件中我们会看到:

-- CHANGE MASTER TO MASTER_LOG_FILE='bin-log.000002', MASTER_LOG_POS=107; #是指备份后所有的更改将会保存到bin-log.000002二进制文件中。

2、在test库的t_student表中增加两条记录,然后执行flush logs命令。这时将会产生一个新的二进制日志文件bin-log.000003,bin-log.000002则保存了全备过后的所有更改,既增加记录的操作也保存在了bin-log.00002中。

3、再在test库中的a表中增加两条记录,然后误删除t_student表和a表。a中增加记录的操作和删除表a和t_student的操作都记录在bin-log.000003中。

三、恢复

1、首先导入全备数据

mysql -h10.6.208.183 -utest2 -p123 -P3310 < test.sql #也可以直接在mysql内部用source导入

2、恢复bin-log.000002

mysqlbinlog bin-log.000002 | mysql -h10.6.208.183 -utest2 -p123 -P3310

3、恢复部分 bin-log.000003

在general_log中找到误删除的时间点,然后更加对应的时间点到bin-log.000003中找到相应的position点,需要恢复到误删除的前面一个position点。

可以用如下参数来控制binlog的区间

- --start-position 开始点 --stop-position 结束点

- --start-date 开始时间 --stop-date 结束时间

找到恢复点后,既可以开始恢复。

mysqlbinlog mysql-bin.000003 --stop-position=208 |mysql -h10.6.208.183 -utest2 -p123 -P3310

实例:

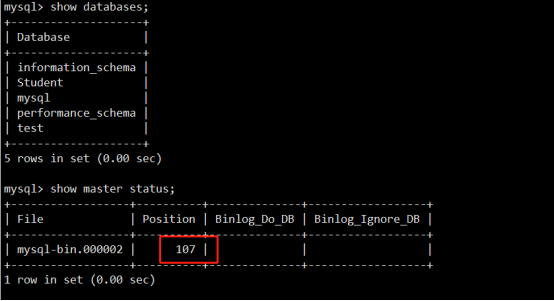

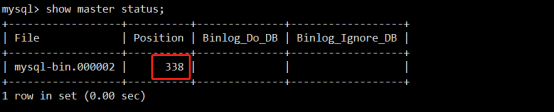

查看当前二进制文件的状态, 并记录下position的数字:

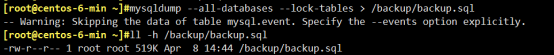

备份数据库到/backup/backup.sql文件中:

mysqldump --all-databases --lock-tables > /backup/backup.sql

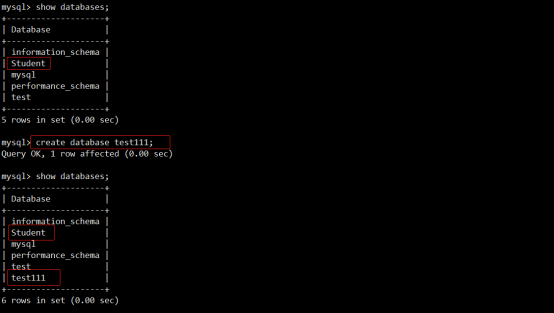

创建一个数据库test111(用于实现增量备份):

记下现在的position(用于实现增量备份):

备份二进制文件(用于实现增量备份):

cp /usr/local/mysql/data/mysql-bin.000002 /backup/

停止MySQL

service mysqld stop

模拟数据丢失(删除Student和test111数据库):

rm -rf Student/ test111/

启动MySQL, 如果是编译安装的应该不能启动(需重新初始化), 如果rpm安装则会重新初始化数据库

service mysqld start

说明:这里只删除了两个库,并没有删除数据库下面的所有内容,所有可以启动

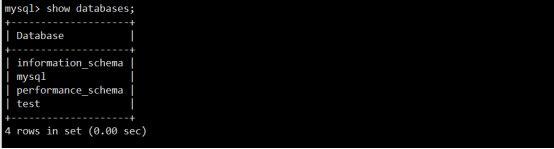

连接数据库,查看数据库,数据已丢失:

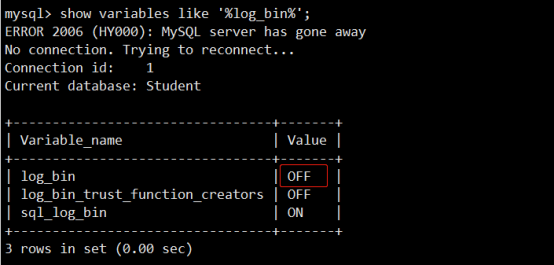

暂时先将二进制日志关闭:

mysql> SET sql_log_bin=OFF;

Query OK, 0 rows affected (0.00 sec)

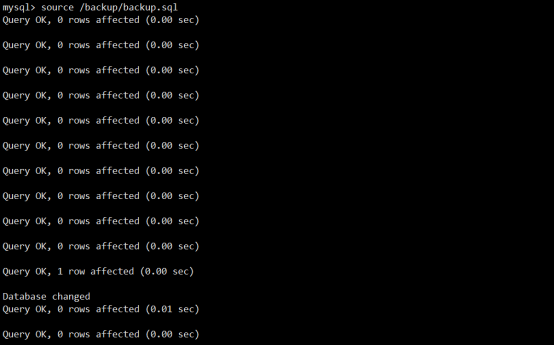

恢复数据,所需时间根据数据库时间大小而定:

mysql> create database Studnet;

mysql> create database test111;

mysql> source /backup/backup.sql

开启二进制日志:

mysql> SET sql_log_bin=ON;

Query OK, 0 rows affected (0.00 sec)

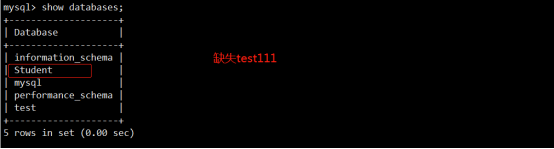

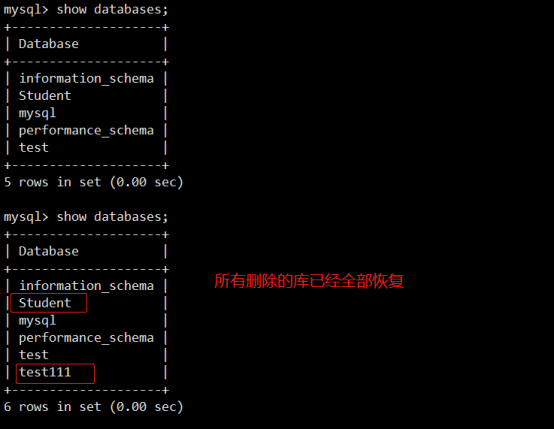

数据库恢复, 但是缺少test111:

通过二进制日志增量恢复数据:

mysqlbinlog --start-position=107 --stop-position=338 /backup/mysql-bin.000002 | mysql Student

Xtrabackup

参考下一章节

MySQL基于日志还原数据

简介

Binlog日志,即二进制日志文件,用于记录用户对数据库操作的SQL语句信息,当发生数据误删除的时候我们可以通过binlog日志来还原已经删除的数据,还原数据的方法分为传统二进制文件还原数据和基于GTID的二进制文件还原数据

传统二进制日志还原数据

1.修改配置文件

[root@localhost ~]# vi /etc/my.cnf

server-id=1

log-bin=binlog

#重启数据库服务

[root@localhost ~]# systemctl restart mysqld

2.操作数据库

mysql> create database mydb charset utf8mb4;

mysql> use mydb;

mysql> create table test(id int)engine=innodb charset=utf8mb4;

mysql> insert into test values(1);

mysql> insert into test values(2);

mysql> insert into test values(3);

mysql> insert into test values(4);

mysql> commit;

mysql> update test set id=10 where id=4;

mysql> commit;

mysql> select * from test;

+------+

| id |

+------+

| 1 |

| 2 |

| 3 |

| 10 |

+------+

4 rows in set (0.00 sec)

mysql> drop database mydb;

3.查看二进制日志信息

[14:59: -(none)] mysql> show master status\G

*************************** 1. row ***************************

File: mysql-bin.000071

Position: 2284

Binlog_Do_DB:

Binlog_Ignore_DB:

Executed_Gtid_Set:

1 row in set (0.00 sec)

查找创库和删库的点,为543和2192

mysql> show binlog events in 'mysql-bin.000071';

4.另存为二进制日志信息

[root@learn ~]# mysqlbinlog --start-position=543 --stop-position=2192 /MysqlData/mysql-bin.000071 > /root/mydb_binlog.sql

5.恢复数据

#临时关闭二进制日志记录以免重复记录

mysql> set sql_log_bin=0;

#恢复数据

mysql> source /root/mydb_binlog.sql

#重启二进制日志记录

mysql> set sql_log_bin=1;

6.查看数据恢复情况

mysql> show databases;

mysql> use mydb;

mysql> select from test;

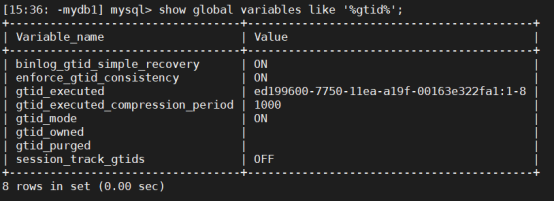

基于GTID二进制日志还原数据

参考:https://www.jianshu.com/p/ea9fdcc25378

原创地址:https://blog.51cto.com/14832653/2509121?source=drh

1.修改配置文件

[root@localhost ~]# vi /etc/my.cnf

server-id=1

log-bin=binlog

gtid_mode=ON

enforce_gtid_consistency=true

log_slave_updates=1

#重启数据库服务

[root@localhost ~]# systemctl restart mysqld

2.操作数据库

mysql> create database mydb1;

mysql> use mydb1;

mysql> create table t1(id int)engine=innodb charset=utf8mb4;

mysql> insert into t1 values(1);

mysql> insert into t1 values(2);

mysql> insert into t1 values(3);

mysql> insert into t1 values(11);

mysql> insert into t1 values(12);

mysql> commit;

mysql> select * from t1;

+------+

| id |

+------+

| 1 |

| 2 |

| 3 |

| 11 |

| 12 |

+------+

5 rows in set (0.00 sec)

mysql> drop database mydb1;

3.查看二进制日志信息

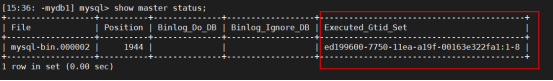

mysql> show master status\G

mysql> show binlog events in 'mysql-bin.000002';

[15:25: -(none)] mysql> show binlog events in 'mysql-bin.000002';

+------------------+------+----------------+-----------+-------------+-------------------------------------------------------------------+

| Log_name | Pos | Event_type | Server_id | End_log_pos | Info |

+------------------+------+----------------+-----------+-------------+-------------------------------------------------------------------+

| mysql-bin.000002 | 4 | Format_desc | 12 | 123 | Server ver: 5.7.28-log, Binlog ver: 4 |

| mysql-bin.000002 | 123 | Previous_gtids | 12 | 154 | |

| mysql-bin.000002 | 154 | Gtid | 12 | 219 | SET @@SESSION.GTID_NEXT= 'ed199600-7750-11ea-a19f-00163e322fa1:1' |

| mysql-bin.000002 | 219 | Query | 12 | 316 | create database mydb1 |

| mysql-bin.000002 | 316 | Gtid | 12 | 381 | SET @@SESSION.GTID_NEXT= 'ed199600-7750-11ea-a19f-00163e322fa1:2' |

| mysql-bin.000002 | 381 | Query | 12 | 509 | use `mydb1`; create table t1(id int)engine=innodb charset=utf8mb4 |

| mysql-bin.000002 | 509 | Gtid | 12 | 574 | SET @@SESSION.GTID_NEXT= 'ed199600-7750-11ea-a19f-00163e322fa1:3' |

| mysql-bin.000002 | 574 | Query | 12 | 647 | BEGIN |

| mysql-bin.000002 | 647 | Table_map | 12 | 693 | table_id: 108 (mydb1.t1) |

| mysql-bin.000002 | 693 | Write_rows | 12 | 733 | table_id: 108 flags: STMT_END_F |

| mysql-bin.000002 | 733 | Xid | 12 | 764 | COMMIT /* xid=7 */ |

| mysql-bin.000002 | 764 | Gtid | 12 | 829 | SET @@SESSION.GTID_NEXT= 'ed199600-7750-11ea-a19f-00163e322fa1:4' |

| mysql-bin.000002 | 829 | Query | 12 | 902 | BEGIN |

| mysql-bin.000002 | 902 | Table_map | 12 | 948 | table_id: 108 (mydb1.t1) |

| mysql-bin.000002 | 948 | Write_rows | 12 | 988 | table_id: 108 flags: STMT_END_F |

| mysql-bin.000002 | 988 | Xid | 12 | 1019 | COMMIT /* xid=8 */ |

| mysql-bin.000002 | 1019 | Gtid | 12 | 1084 | SET @@SESSION.GTID_NEXT= 'ed199600-7750-11ea-a19f-00163e322fa1:5' |

| mysql-bin.000002 | 1084 | Query | 12 | 1157 | BEGIN |

| mysql-bin.000002 | 1157 | Table_map | 12 | 1203 | table_id: 108 (mydb1.t1) |

| mysql-bin.000002 | 1203 | Write_rows | 12 | 1243 | table_id: 108 flags: STMT_END_F |

| mysql-bin.000002 | 1243 | Xid | 12 | 1274 | COMMIT /* xid=9 */ |

| mysql-bin.000002 | 1274 | Gtid | 12 | 1339 | SET @@SESSION.GTID_NEXT= 'ed199600-7750-11ea-a19f-00163e322fa1:6' |

| mysql-bin.000002 | 1339 | Query | 12 | 1412 | BEGIN |

| mysql-bin.000002 | 1412 | Table_map | 12 | 1458 | table_id: 108 (mydb1.t1) |

| mysql-bin.000002 | 1458 | Write_rows | 12 | 1498 | table_id: 108 flags: STMT_END_F |

| mysql-bin.000002 | 1498 | Xid | 12 | 1529 | COMMIT /* xid=10 */ |

| mysql-bin.000002 | 1529 | Gtid | 12 | 1594 | SET @@SESSION.GTID_NEXT= 'ed199600-7750-11ea-a19f-00163e322fa1:7' |

| mysql-bin.000002 | 1594 | Query | 12 | 1667 | BEGIN |

| mysql-bin.000002 | 1667 | Table_map | 12 | 1713 | table_id: 108 (mydb1.t1) |

| mysql-bin.000002 | 1713 | Write_rows | 12 | 1753 | table_id: 108 flags: STMT_END_F |

| mysql-bin.000002 | 1753 | Xid | 12 | 1784 | COMMIT /* xid=11 */ |

| mysql-bin.000002 | 1784 | Gtid | 12 | 1849 | SET @@SESSION.GTID_NEXT= 'ed199600-7750-11ea-a19f-00163e322fa1:8' |

| mysql-bin.000002 | 1849 | Query | 12 | 1944 | drop database mydb1 |

+------------------+------+----------------+-----------+-------------+-------------------------------------------------------------------+

33 rows in set (0.00 sec)

4.另存为二进制日志信息

#8号事务记录为删除数据库,因此只需恢复1-7号事务记录即可

mysqlbinlog --skip-gtids --include-gtids='ed199600-7750-11ea-a19f-00163e322fa1:1-7' /MysqlData/mysql-bin.000002 > /root/gtid.sql

参数说明:

- --include-gtids:包含事务

- --exclude-gtids:排除事务

- --skip-gtids:跳过事务

5.恢复数据

mysql> set sql_log_bin=0;

mysql> source /root/gtid.sql

mysql> set sql_log_bin=1;

6.查看数据恢复情况

mysql> show databases;

mysql> use mydb1;

mysql> select * from t1;

binlog相关设置

show master status; -- 输出结果为空?

原因:mysql没有开启日志。查看log_bin选项:

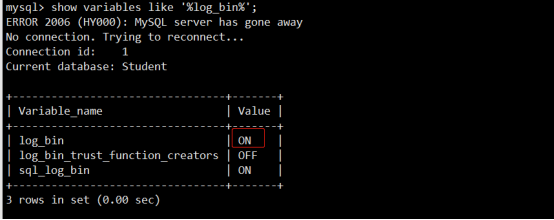

mysql> show variables like '%log_bin%';

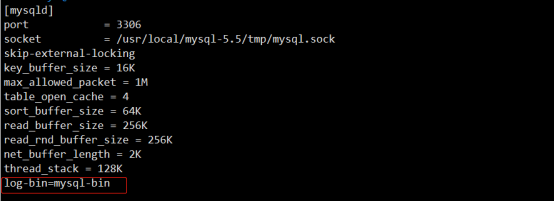

可以看到log_bin是OFF,解决方法:在mysql 配置文件/etc/my.cnf中

[mysqld]下添加:

log-bin=mysql-bin

log-bin配置项表示binlog的base name,产生的日志文件名称类似,mysql-bin.00001,mysql-bin.00002,mysql-bin.00003。

然后保存,重启mysql服务,进行查看log_bin的value是on。

注意:二进制日志文件不应该与数据文件放在同一磁盘

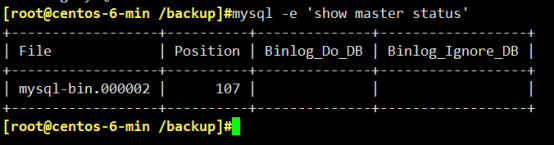

mysql> show master status\G

*************************** 1. row ***************************

File: mysql-bin.000002

Position: 107

Binlog_Do_DB:

Binlog_Ignore_DB:

1 row in set (0.00 sec)

show master status命令列出了日志位点信息,包括binlog file,binlog position等。如果使用了GTID(global transaction ID),Executed_Gtid_Set表示已经在这个master上执行的GTID集合,与这个server上的系统变量gtid_executed 含义相同。

如果该server是slave,则执行show slave status中是输出的对应列Executed_Gtid_Set,含义也相同。

在MySQL配置文件my.cnf文件中的mysqld节中添加下面的配置文件:

[mysqld]

#设置日志格式

binlog_format = row

#设置日志路径,注意路经需要mysql用户有权限写

log-bin = /data/mysql/logs/mysql-bin

#设置binlog清理时间

expire_logs_days = 7

#binlog每个日志文件大小

max_binlog_size = 100m

#binlog缓存大小

binlog_cache_size = 4m

#最大binlog缓存大小

max_binlog_cache_size = 512m

重启MySQL生效,如果不方便重启服务,也可以直接修改对应的变量即可。

在 MySQL 主从复制中,有多个选项用于控制对于哪些数据库和表进行数据同步或者忽略。下面是这些选项的简介:

1、 replicate_ignore_db

replicate_ignore_db 参数用于指定需要忽略的数据库名,这些数据库中的任何更改都不会被复制到从服务器。可以使用多个逗号分隔的数据库名指定多个数据库。

示例:replicate_ignore_db = mysql,test

2、 replicate_wild_ignore_table

replicate_wild_ignore_table 参数用于指定需要忽略的表名通配符,这些符合通配符模式的表中的任何更改都不会被复制到从服务器。可以使用多个逗号分隔的通配符指定多个表名。

示例:replicate_wild_ignore_table = db1.%,db2.foo,db3.bar%

3、 replicate_do_table

replicate_do_table 参数用于指定需要复制的表名,只有指定的表中的更改才会被复制到从服务器。可以使用多个逗号分隔的表名指定多个需要复制的表名。

示例:replicate_do_table = db1.table1,db2.%

4、binlog-ignore-db

binlog-ignore-db 参数用于指定需要忽略的数据库名,在主服务器上不会将这些数据库的更改写入二进制日志文件。可以使用多个逗号分隔的数据库名指定多个需要忽略的数据库。

示例:binlog-ignore-db = mysql,test

5、 replicate-do-db

replicate-do-db参数允许你指定主服务器上的数据库名称,只有在指定的数据库中发生更改时,这些更改才会被复制到从服务器上。

示例:replicate-do-db = mydatabase,test

这些选项可以通过在主服务器和从服务器的配置文件中设置来控制 MySQL 主从复制中哪些数据库和表需要同步,哪些需要忽略,使用这些选项可以帮助您更好地控制数据同步,提高 MySQL 的可用性和稳定性。

binlog的删除可以手工删除或自动删除:

a)自动删除binlog,通过binlog参数(expire_logs_days )来实现mysql自动删除binlog

mysql> show binary logs;

mysql> show variables like 'expire_logs_days'; -- 该参数表示binlog日志自动删除/过期的天数,默认值为0,表示不自动删除

mysql> set global expire_logs_days=3; -- 表示日志保留3天,3天后就自动过期。

b)手工删除binlog

mysql> reset master; -- 删除binlog,即手动删除所有的binlog日志

mysql> reset slave; -- 删除中继日志,包括还没有应用完的日志,创建一个新的relay log文件

mysql> purge master logs before '2012-03-30 17:20:00'; -- 删除指定日期以前的日志索引中binlog日志文件

mysql> purge master logs to 'binlog.000002'; -- 删除指定日志文件的日志索引中binlog日志文件

mysql> set sql_log_bin='1/0'; -- 如果用户有super权限,可以启用或禁用当前会话的binlog记录

mysql> show master logs; -- 查看master的binlog日志列表

mysql> show binary logs; -- 查看master的binlog日志文件大小

mysql> show master status; -- 用于提供master二进制日志文件的状态信息

mysql> show slave hosts; -- 显示当前注册的slave的列表。不以--report-host=slave_name选项为开头的slave不会显示在本列表中

mysql> flush logs; -- 产生一个新的binlog日志文件

mysql> SHOW RELAYLOG EVENTS; -- 将显示中继日志文件中的事件列表,包括每个事件的执行时间、事件类型、主服务器信息以及相关语句,如果你只想查看最近的几个事件,可以在命令后面加上 LIMIT 子句

mysql> SHOW RELAYLOG EVENTS LIMIT 10; -- 显示最近的 10 个中继日志事件

总结:

reset slave命令进行两个动作:

- 清除

master.info,relay-log.info文件(记录),就是清除master.info文件和relay-log.info文件,需要注意的是,新版本的mysql中,这两个文件已经不存在了,而是存储在mysql数据库的slave_master_info表和slave_relay_log_info表中 - 删除所有的relay log,包括还没有应用完的日志,创建一个新的relay log文件.

reset slave和reset slave all命令

reset slave命令和reset slave all命令会删除所有的relay log(包括还没有应用完的日志),创建一个新的relay log文件;- 使用

reset slave命令,那么所有的连接信息仍然保留在内存中,包括主库地址、端口、用户、密码等。这样可以直接运行start slave命令而不必重新输入change master to命令,而运行show slave status也仍和没有运行reset slave一样,有正常的输出。但如果使用reset slave all命令,那么这些内存中的数据也会被清除掉,运行show slave status就输出为空了。 reset slave和reset slave all命令会将系统mysql数据库的slave_master_info表和slave_relay_log_info表中对应的复制记录清除。

reset master命令

先来说说这个命令的结果:

- 清理所有的binlog文件,创建一个新的文件,起始值从1开始。并且之前的复制信息将被清除,这个命令通常在重新设置主从复制环境时使用,比如设置一个新的从服务器。

- GTID环境中,

reset master会清理掉gtid_executed的值,在搭建主从的时候可以使用,但是要慎用(如果你的二进制日志还有需要的话)

说明: show master status也就等于mysql -e 'show master status'

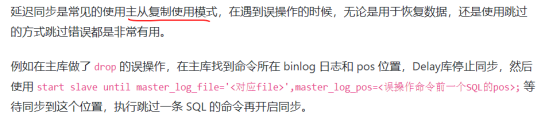

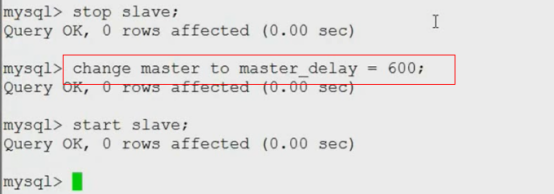

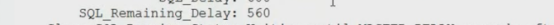

延迟同步

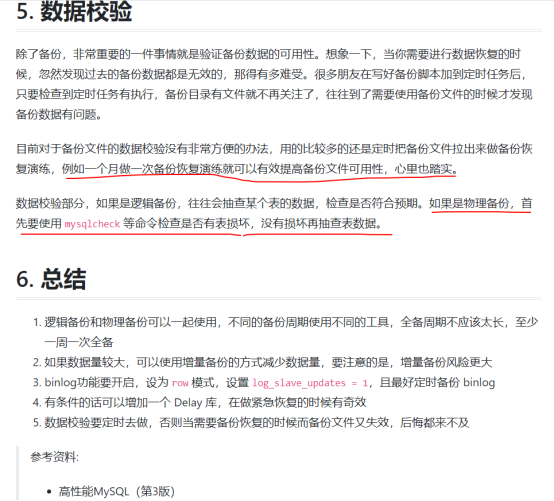

数据校验(重要)

分库分表备份脚本实现

脚本思路:

如果库较少,可以使用for in db1 db2 db3;do ;done来实例

如果库较多,则应该先用show databases取出库名,做为for循环变量的取值列表,然后再执行备份操作:

取库名:

mysql -uroot -p666666 -S /tmp/mysql.sock -e "show databases;" | egrep -vi "Database|information_schema|mysql|performance_schema|sys"

备份一个库:

mysqldump -uroot -p666666 -S /tmp/mysql.sock \

--compact -F --master-data=2 --single-transaction --events \

-B mimi | gzip >/opt/mysql_bak_db_mimi.sql.gz

说明:mimi就是数据库名

备份所有库:

mysqldump -uroot -p666666 -S /tmp/mysql.sock \

--compact -F --master-data=2 --single-transaction --events \

-A | gzip >/opt/mysql_bak_db_All.sql.gz

了解脚本思路了脚本就很好写了,下面自己编写的一个示例脚本:

#!/bin/bash

bin_Path="/usr/local/mysql/bin"

my_user="root"

my_pass="666666"

backup_Dir="/opt"

socket_file="/tmp/mysql.sock"

#取数据库名

dbList=`mysql -u${my_user} -p$my_pass -S ${socket_file} -e "show databases;" | \

egrep -vi "Database|information_schema|mysql|performance_schema|sys"`

echo "即将备份以下数据库"

sleep 6

echo "$dbList"

sleep 3

echo "----------------------"

#备份上面的库,并且刷新log_bin日志

for db in $dbList

do

${bin_Path}/mysqldump -u$my_user -p$my_pass -S ${socket_file} -B -F \

--master-data=2 --single-transaction --events --compact \

${db} | gzip >${backup_Dir}/mysql_backup_database_${db}_$(date +%Y%m%d-%H-%M-%S).sql.gz

if [ $? = 0 ];then

echo "${db}库备份成功"

sleep 6

else

echo "${db}库备份失败,即将退出备份"

exit 22

sleep 6

fi

done

分表备份实现脚本

脚本思路:大致思路是在库中再分表进行备份,那就会用到for循环嵌套,外层for循环是库,内层for循环是表,并将每个库中的表存放在各自库名命名的目录下面。

取到某库中的表名:注:没有表的库被自动过滤掉了。

mysql -uroot -p666666 -S /tmp/mysql.sock -e "show tables from mimi"|sed '1d'

示例脚本:

#!/bin/bash

Backup_Databases_tables(){

bin_Path="/usr/local/mysql/bin"

my_user="root"

my_pass='asdfghjkl@#$!123654$'

backup_Dir="/opt/backupmysql"

socket_file="/tmp/mysql.sock"

#取库名

dbList=`mysql -u$my_user -p$my_pass -S ${socket_file} -e "show databases;" \

| egrep -vi "Database|information_schema|mysql|performance_schema|sys"`

#|egrep -v "Database|information_schema|mysql|performance_schema|sys"`

echo "所需要的库"

echo "$dbList"

for db in $dbList

do

#取库中的表名

table=`mysql -u$my_user -p$my_pass -S ${socket_file} -e "show tables from $db"|sed '1d'`

echo "${db}库下的所有表"

echo "${table}"

for tb in $table

do

echo "创建以库命名的目录"

echo "创建${backup_Dir}/${db}"

[ -d ${backup_Dir}/${db} ] || mkdir -p ${backup_Dir}/${db}

echo "即将开始备份$db库下$tb表"

${bin_Path}/mysqldump -u$my_user -p$my_pass -S ${socket_file} --flush-logs --triggers --events --routines --opt \

--quick --master-data=2 --hex-blob --single-transaction $db $tb | \

gzip > $backup_Dir/${db}/$(date +%Y%m%d-%H-%M-%S)-${db}-${tb}.sql.gz

if [ $? = 0 ];then

echo "${db}库下${tb}表备份成功"

sleep 5

else

echo "${db}库下${tb}表备份失败,即将退出备份"

exit 22

sleep 5

fi

done

done

}

Backup_Databases_tables

Xtrabackup备份及恢复

官网:http://www.percona.com

官方手册:

https://www.percona.com/doc/percona-xtrabackup/2.3/index.html

更多XtraBackup相关教程见以下内容:

MySQL管理之使用XtraBackup进行热备 http://www.linuxidc.com/Linux/2014-04/99671.htm

使用Xtrabackup进行MySQL备份 http://www.linuxidc.com/Linux/2016-11/137734.htm

MySQL开源备份工具Xtrabackup备份部署 http://www.linuxidc.com/Linux/2013-06/85627.htm

MySQL Xtrabackup备份和恢复 http://www.linuxidc.com/Linux/2011-12/50275.htm

Percona Xtrabackup 安装 http://www.linuxidc.com/Linux/2016-11/137735.htm

使用XtraBackup 备份MySQL数据库 http://www.linuxidc.com/Linux/2016-12/138688.htm

使用Xtrabackup进行MySQL数据库全备和全备还原 http://www.linuxidc.com/Linux/2016-11/137736.htm

XtraBackup备份原理和实战详解 http://www.linuxidc.com/Linux/2017-04/142477.htm

Percona XtraBackup 实现全备&增量备份与恢复 http://www.linuxidc.com/Linux/2017-03/142380.htm

本文永久更新链接地址:http://www.linuxidc.com/Linux/2017-06/145040.htm

博客参考:

https://www.cnblogs.com/linuxk/p/9372990.html

https://segmentfault.com/a/1190000022293848

Xtrabackup介绍

MySQL冷备、mysqldump、MySQL热拷贝都无法实现对数据库进行增量备份。在实际生产环境中增量备份是非常实用的,如果数据大于50G或100G,存储空间足够的情况下,可以每天进行完整备份,如果每天产生的数据量较大,需要定制数据备份策略。例如每周实用完整备份,周一到周六实用增量备份。而Percona-Xtrabackup就是为了实现增量备份而出现的一款主流备份工具,xtrabakackup有2个工具,分别是xtrabakup、innobakupe。

Percona-xtrabackup是 Percona公司开发的一个用于MySQL数据库物理热备的备份工具,支持MySQL、Percona server和MariaDB,开源免费,是目前较为受欢迎的主流备份工具。xtrabackup只能备份innoDB和xtraDB两种数据引擎的表,而不能备份MyISAM数据表

Xtrabackup优点

(1)备份速度快,物理备份可靠

(2)备份过程不会打断正在执行的事务(无需锁表)

(3)能够基于压缩等功能节约磁盘空间和流量

(4)自动备份校验

(5)还原速度快

(6)可以流传将备份传输到另外一台机器上

(7)在不增加服务器负载的情况备份数据

Xtrabackup备份原理

https://www.cnblogs.com/f-ck-need-u/p/9018716.html#auto_id_2

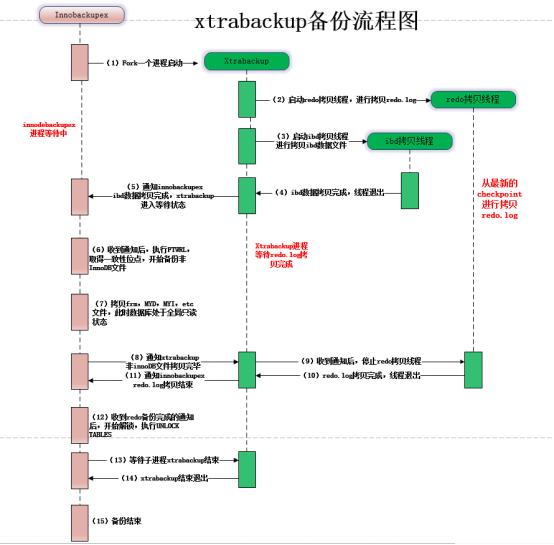

Xtrabackup备份流程图:

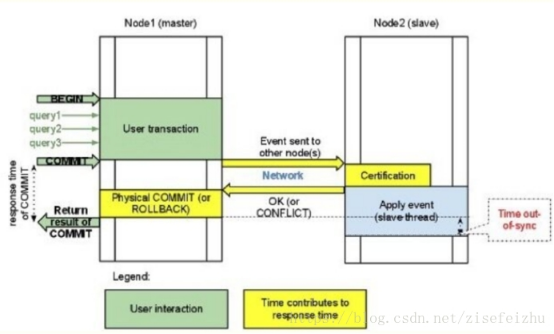

(1)innobackupex启动后,会先fork一个进程,用于启动xtrabackup,然后等待xtrabackup备份ibd数据文件;

(2)xtrabackup在备份innoDB数据是,有2种线程:redo拷贝线程和ibd数据拷贝线程。xtrabackup进程开始执行后,会启动一个redo拷贝的线程,用于从最新的checkpoint点开始顺序拷贝redo.log;再启动ibd数据拷贝线程,进行拷贝ibd数据。这里是先启动redo拷贝线程的。在此阶段,innobackupex进行处于等待状态(等待文件被创建)

(3)xtrabackup拷贝完成ibd数据文件后,会通知innobackupex(通过创建文件),同时xtrabackup进入等待状态(redo线程依旧在拷贝redo.log)

(4)innobackupex收到xtrabackup通知后哦,执行FLUSH TABLES WITH READ LOCK(FTWRL),取得一致性位点,然后开始备份非InnoDB文件(如frm、MYD、MYI、CSV、opt、par等格式的文件),在拷贝非InnoDB文件的过程当中,数据库处于全局只读状态。

(5)当innobackup拷贝完所有的非InnoDB文件后,会通知xtrabackup,通知完成后,进入等待状态;

(6)xtrabackup收到innobackupex备份完成的通知后,会停止redo拷贝线程,然后通知innobackupex,redo.log文件拷贝完成;

(7)innobackupex收到redo.log备份完成后,就进行解锁操作,执行:UNLOCK TABLES;

(8)最后innbackupex和xtrabackup进程各自释放资源,写备份元数据信息等,innobackupex等xtrabackup子进程结束后退出

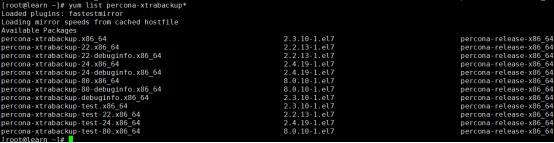

xtrabackup的安装部署

恢复前的准备工作包括如下几项:

安装数据恢复工具Percona XtraBackup 2.4

-

MySQL 5.6及之前的版本需要安装 Percona XtraBackup 2.3或2.2,安装指导请参见官方文档Percona XtraBackup 2.3。

-

MySQL 5.7版本需要安装 Percona XtraBackup 2.4,安装指导请参见官方文档Percona XtraBackup 2.4。

-

MySQL 8.0版本需要安装 Percona XtraBackup 8.0,安装指导请参见官方文档Percona XtraBackup 8.0。

安装超简单(只能在linux上用,不过但这就够了)

二进制下载:

https://www.percona.com/downloads/Percona-XtraBackup-2.4/LATEST/

源码包的安装,可以参考: https://www.linuxidc.com/Linux/2016-11/137735.htm

rpm仓库(实际上是percona的仓库):http://repo.percona.com/release/

清华大学percona源:https://mirrors.tuna.tsinghua.edu.cn/percona/

因为只是一个备份工具,所以没必要编译安装,直接下载它的rpm包即可

下载地址:https://www.percona.com/downloads/Percona-XtraBackup-2.4/LATEST/

可以选择rpm包方式安装,也可以下载源码包编译安装,这里直接采用rpm包的方式进行安装

https://repo.percona.com/yum/release/7/RPMS/x86_64/

[root@master tools]# wget https://repo.percona.com/yum/release/7/RPMS/x86_64/percona-xtrabackup-24-2.4.9-1.el7.x86_64.rpm

# xtrabackup 的使用需要安装相关的依赖包 否则使用过程中会报相关错误

[root@master tools]# yum install -y rsync perl perl-Digest-MD5 perl perl-devel libaio libaio-devel perl-Time-HiRes perl-DBD-MySQL

[root@master tools]# yum localinstall -y percona-xtrabackup-24-2.4.9-1.el7.x86_64.rpm

[root@master ~]# rpm -qa | grep percona-xtrabackup

percona-xtrabackup-24-2.4.9-1.el7.x86_64

或者安装yum源,然后在安装xtrabackup:

参考文档:https://www.percona.com/doc/percona-xtrabackup/2.4/installation/yum_repo.html

yum install https://repo.percona.com/yum/percona-release-latest.noarch.rpm

yum update percona-release

yum list | grep percona

# qpress 用作压缩解压

yum install percona-xtrabackup-24 qpress

如果yum无法安装qpress

下载qpress-11-linux-x64.tar,解压即可,这个很简单

wget http://www.quicklz.com/qpress-11-linux-x64.tar

tar xvf qpress-11-linux-x64.tar

cp qpress /usr/bin

# 源码安装

wget -c https://github.com/PierreLvx/qpress/archive/refs/tags/20230507.tar.gz

tar xf 20230507

cd 20230507

make

make install

或者在该站下载rpm包:

https://pkgs.org/download/qpress

wget https://repo.percona.com/yum/release/7/RPMS/x86_64/qpress-11-1.el7.x86_64.rpm

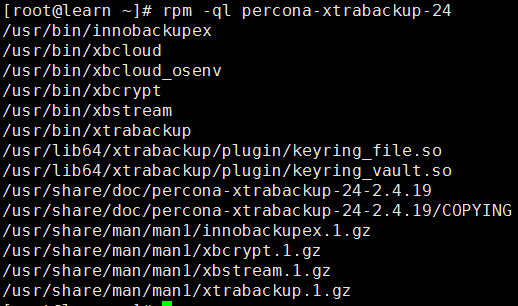

Xtrabackup中主要包含两个工具详解

https://www.cnblogs.com/FireLL/p/13042287.html

-

xbcloud和xbcloud_osenv是xtrabackup新的高级特性:云备份;

-

xbcrypt也是新的特性,加密备份集;

-

xbstream是xtrabackup的流数据功能,通过流数据功能,可将备份内容打包并传给管道后的压缩工具进行压缩;

-

xtrabackup是主程序;

-

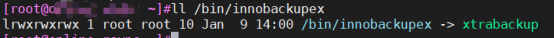

innobackupex在以前是一个perl脚本,会调用xtrabackup这个二进制工具,从xtrabackup 2.3开始,该工具使用C语言进行了重写,当前它是xtabackup二进制工具的一个软连接,但是实际的使用方法却不同,并且在以后的版本中会删除该工具

xtrabackup:是用于热备innodb,xtradb表中数据的工具,不能备份其他类型的表,也不能备份数据表结构;不能备份非 InnoDB 表,和 mysqld server 没有交互

innobackupex:是将xtrabackup进行封装的perl脚本,提供了备份myisam表的能力。

脚本用来备份非 InnoDB 表,同时会调用 xtrabackup 命令来备份 InnoDB 表,还会和 mysqld server 发送命令进行交互,如加读锁(FTWRL)、获取位点(SHOW SLAVE STATUS)等

在以前是一个perl脚本,会调用xtrabackup这个二进制工具,从xtrabackup 2.3开始,该工具使用C语言进行了重写,当前它是xtabackup二进制工具的一个软连接,但是实际的使用方法却不同,并且在以后的版本中会删除该工具

简单来说,innobackupex 在 xtrabackup 之上做了一层封装。

一般情况下,我们是希望能备份 MyISAM 表的,虽然我们可能自己不用 MyISAM 表,但是 mysql 库下的系统表是 MyISAM 的,因此备份基本都通过 innobackupex 命令进行

参数详解

https://www.cnblogs.com/zhoujinyi/p/5893333.html

备份阶段参数

-

--compress:该选项表示压缩innodb数据文件的备份。

-

--compress-threads:该选项表示并行压缩worker线程的数量。

-

--compress-chunk-size:该选项表示每个压缩线程worker buffer的大小,单位是字节,默认是64K。

-

--encrypt:该选项表示通过ENCRYPTION_ALGORITHM的算法加密innodb数据文件的备份,目前支持的算法有ASE128,AES192,AES256。

-

--encrypt-threads:该选项表示并行加密的worker线程数量。

-

--encrypt-chunk-size:该选项表示每个加密线程worker buffer的大小,单位是字节,默认是64K。

-

--encrypt-key:该选项使用合适长度加密key,因为会记录到命令行,所以不推荐使用。

-

--encryption-key-file:该选项表示文件必须是一个简单二进制或者文本文件,加密key可通过以下命令行命令生成:

openssl rand -base64 24。 -

--include:该选项表示使用正则表达式匹配表的名字[db.tb],要求为其指定匹配要备份的表的完整名称,即databasename.tablename。

-

--user:该选项表示备份账号。

-

--password:该选项表示备份的密码。

-

--port:该选项表示备份数据库的端口。

-

--host:该选项表示备份数据库的地址。

-

--databases:该选项接受的参数为数据名,如果要指定多个数据库,彼此间需要以空格隔开;如:

"xtra_test dba_test",同时,在指定某数据库时,也可以只指定其中的某张表。如:mydatabase.mytable。该选项对innodb引擎表无效,还是会备份所有innodb表。此外,此选项也可以接受一个文件为参数,文件中每一行为一个要备份的对象。 -

--tables-file:该选项表示指定含有表列表的文件,格式为database.table,该选项直接传给--tables-file。

-

--socket:该选项表示mysql.sock所在位置,以便备份进程登录mysql。

-

--no-timestamp:该选项可以表示不要创建一个时间戳目录来存储备份,指定到自己想要的备份文件夹。

-

--ibbackup:该选项指定了使用哪个xtrabackup二进制程序。IBBACKUP-BINARY是运行percona xtrabackup的命令。这个选项适用于xtrbackup二进制不在你是搜索和工作目录,如果指定了该选项,innoabackupex自动决定用的二进制程序。

-

--slave-info:该选项表示对slave进行备份的时候使用,打印出master的名字和binlog pos,同样将这些信息以change master的命令写入xtrabackup_slave_info文件。可以通过基于这份备份启动一个从库。

-

--safe-slave-backup:该选项表示为保证一致性复制状态,这个选项停止SQL线程并且等到show status中的slave_open_temp_tables为0的时候开始备份,如果没有打开临时表,bakcup会立刻开始,否则SQL线程启动或者关闭知道没有打开的临时表。如果slave_open_temp_tables在--safe-slave-backup-timeount(默认300秒)秒之后不为0,从库sql线程会在备份完成的时候重启。

-

--rsync:该选项表示通过rsync工具优化本地传输,当指定这个选项,innobackupex使用rsync拷贝非Innodb文件而替换cp,当有很多DB和表的时候会快很多,不能--stream一起使用。

-

--kill-long-queries-timeout:该选项表示从开始执行FLUSH TABLES WITH READ LOCK到kill掉阻塞它的这些查询之间等待的秒数。默认值为0,不会kill任何查询,使用这个选项xtrabackup需要有Process和super权限。

-

--kill-long-query-type:该选项表示kill的类型,默认是all,可选select。

-

--ftwrl-wait-threshold:该选项表示检测到长查询,单位是秒,表示长查询的阈值。

-

--ftwrl-wait-query-type:该选项表示获得全局锁之前允许那种查询完成,默认是ALL,可选update。

-

--galera-info:该选项表示生成了包含创建备份时候本地节点状态的文件xtrabackup_galera_info文件,该选项只适用于备份PXC。

-

--stream:该选项表示流式备份的格式,backup完成之后以指定格式到STDOUT,目前只支持tar和xbstream。

-

--defaults-file:该选项指定了从哪个文件读取MySQL配置,必须放在命令行第一个选项的位置。

-

--defaults-extra-file:该选项指定了在标准defaults-file之前从哪个额外的文件读取MySQL配置,必须在命令行的第一个选项的位置。一般用于存备份用户的用户名和密码的配置文件。

-

----defaults-group:该选项表示从配置文件读取的组,innobakcupex多个实例部署时使用。

-

--no-lock:该选项表示关闭FTWRL的表锁,只有在所有表都是Innodb表并且不关心backup的binlog pos点,如果有任何DDL语句正在执行或者非InnoDB正在更新时(包括mysql库下的表),都不应该使用这个选项,后果是导致备份数据不一致,如果考虑备份因为获得锁失败,可以考虑--safe-slave-backup立刻停止复制线程。

-

--tmpdir:该选项表示指定--stream的时候,指定临时文件存在哪里,在streaming和拷贝到远程server之前,事务日志首先存在临时文件里。在 使用参数stream=tar备份的时候,你的xtrabackup_logfile可能会临时放在/tmp目录下,如果你备份的时候并发写入较大的话 xtrabackup_logfile可能会很大(5G+),很可能会撑满你的/tmp目录,可以通过参数--tmpdir指定目录来解决这个问题。

-

--history:该选项表示percona server 的备份历史记录在percona_schema.xtrabackup_history表。

-

--incremental:该选项表示创建一个增量备份,需要指定--incremental-basedir。

-

--incremental-basedir:该选项表示接受了一个字符串参数指定含有full backup的目录为增量备份的base目录,与--incremental同时使用。

-

--incremental-dir:该选项表示增量备份的目录。

-

--incremental-force-scan:该选项表示创建一份增量备份时,强制扫描所有增量备份中的数据页。

-

--incremental-lsn:该选项表示指定增量备份的LSN,与--incremental选项一起使用。

-

--incremental-history-name:该选项表示存储在PERCONA_SCHEMA.xtrabackup_history基于增量备份的历史记录的名字。Percona Xtrabackup搜索历史表查找最近(innodb_to_lsn)成功备份并且将to_lsn值作为增量备份启动出事lsn.与innobackupex--incremental-history-uuid互斥。如果没有检测到有效的lsn,xtrabackup会返回error。

-

--incremental-history-uuid:该选项表示存储在percona_schema.xtrabackup_history基于增量备份的特定历史记录的UUID。

-

--close-files:该选项表示关闭不再访问的文件句柄,当xtrabackup打开表空间通常并不关闭文件句柄目的是正确的处理DDL操作。如果表空间数量巨大,这是一种可以关闭不再访问的文件句柄的方法。使用该选项有风险,会有产生不一致备份的可能。

-

--compact:该选项表示创建一份没有辅助索引的紧凑的备份。

-

--throttle:该选项表示每秒IO操作的次数,只作用于bakcup阶段有效。apply-log和--copy-back不生效不要一起用。

prepare阶段参数

- --apply-log:该选项表示同xtrabackup的--prepare参数,一般情况下,在备份完成后,数据尚且不能用于恢复操作,因为备份的数据中可能会包含尚未提交的事务或已经提交但尚未同步至数据文件中的事务。因此,此时数据 文件仍处理不一致状态。--apply-log的作用是通过回滚未提交的事务及同步已经提交的事务至数据文件使数据文件处于一致性状态。

-

--use-memory:该选项表示和--apply-log选项一起使用,prepare 备份的时候,xtrabackup做crash recovery分配的内存大小,单位字节。也可(1MB,1M,1G,1GB),推荐1G。

-

--defaults-file:该选项指定了从哪个文件读取MySQL配置,必须放在命令行第一个选项的位置。

-

--export:这个选项表示开启可导出单独的表之后再导入其他Mysql中。

-

--redo-only:这个选项在prepare base full backup,往其中merge增量备份(但不包括最后一个)时候使用

解压解密:

-

--decompress:该选项表示解压--compress选项压缩的文件。

-

--parallel:该选项表示允许多个文件同时解压。为了解压,qpress工具必须有安装并且访问这个文件的权限。这个进程将在同一个位置移除原来的压缩/加密文件。

-

--decrypt:该选项表示解密通过--encrypt选项加密的.xbcrypt文件

还原:

-

--copy-back:做数据恢复时将备份数据文件拷贝到MySQL服务器的datadir。

-

--move-back:这个选项与--copy-back相似,唯一的区别是它不拷贝文件,而是移动文件到目的地。这个选项移除backup文件,用时候必须小心。使用场景:没有足够的磁盘空间同事保留数据文件和Backup副本

注意:

1.datadir目录必须为空。除非指定innobackupex --force-non-empty-directorires选项指定,否则--copy-backup选项不会覆盖

2.在restore之前,必须shutdown MySQL实例,你不能将一个运行中的实例restore到datadir目录中

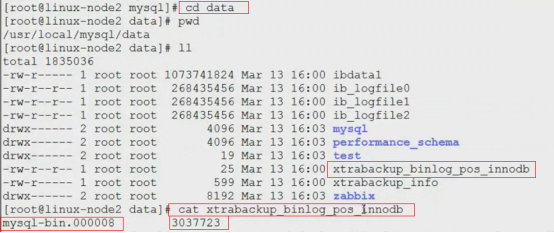

3.由于文件属性会被保留,大部分情况下你需要在启动实例之前将文件的属主改为mysql,这些文件将属于创建备份的用户

chown -R my5711:mysql /data1/dbrestore

以上需要在用户调用Innobackupex之前完成

- --force-non-empty-directories:指定该参数时候,使得innobackupex

--copy-back或--move-back选项转移文件到非空目录,已存在的文件不会被覆盖。如果--copy-back和--move-back文件需要从备份目录拷贝一个在datadir已经存在的文件,会报错失败。即原data目录下可以有其他文件,但是不能有与恢复文件中同名的文件,否则恢复失败

常用选项:

-

--host 指定主机

-

--user 指定用户名

-

--password 指定密码

-

--port 指定端口

-

--socket= #指定socket文件路径

-

--databases 备份指定数据库,多个空格隔开,如--databases=

"dbname1 dbname2",不加该参数是备份所有库,注意 --databases参数值要用引号括起来 -

--tables-file 将要备份的表名或库名都写在一个文本文件中

-

--defaults-file 从MySQL的选项文件中读取参数,使用选项--defaluts-file指定连接时的参数配置文件,但如果指定该选项,该选项只能放在第一个选项位置(这个参数默认就本机的my.cnf配置文件,就是你在那台服务器上备份就是这台服务器上的my.cnf文件)

-

--incremental 创建增量备份,后跟增量备份路径

-

--incremental-basedir 指定包含完全备份的目录

增备时使用--incremental选项表示增量备份,增量备份时需要通过--incremental-basedir=fullback_PATH指定基于哪个备份集备份,因为是第一次增备,所以要基于完全备份增量集

-

--incremental-dir 指定包含增量备份的目录

-

--apply-log 对备份进行预处理操作

一般情况下,在备份完成后,数据尚且不能用于恢复操作,因为备份的数据中可能会包含尚未提交的事务或已经提交但尚未同步至数据文件中的事务。因此,此时数据文件仍处理不一致状态。"准备"的主要作用正是通过回滚未提交的事务及同步已经提交的事务至数据文件也使得数据文件处于一致性状态。

-

--redo-only #合并全备和增量备份数据文件,不回滚未提交事务

-

--copy-back 恢复备份目录,数据库目录要为空

-

--no-timestamp #生成备份文件不以时间戳为目录名

-

--stream= #指定流的格式做备份,--stream=tar,将备份文件归档

-

--compress #压缩功能,配合-stream=xbstream

-

--compress-threads=4 #用于并行数据压缩的线程数。此选项的默认值为1。配合-stream=xbstream

-

--parallel= #指定线程数

-

--no-timestamp #生成备份文件不以时间戳为目录名

-

--remote-host=user@ip DST_DIR #备份到远程主机

-

--user-memory选项来指定其可以使用的内存的大小,默认为100M

-

--no-timestamp 在使用innobackupex进行备份时,还可以使用--no-timestamp选项来阻止命令自动创建一个以时间命名的目录:如此一来,innobackupex命令将会创建一个BACKUP-DIR目录来存储备份数据

-

--throttle=NUMBER #限制innobackupex读写InnoDB数据的速率

-

--slave-info, 备 份从库, 加上--slave-info备份目录下会多生成一个xtrabackup_slave_info 文件, 这里会保存主日志文件以及偏移, 文件内容类似于:CHANGE MASTER TO MASTER_LOG_FILE='', MASTER_LOG_POS=0

-

--rsync 加快本地文件传输,适用于non-InnoDB数据库引擎。不与--stream共用

备份时生成的文件详解

使用innobackupex备份时,其会调用xtrabackup备份所有的InnoDB表,复制所有关于表结构定义的相关文件(.frm)、以及MyISAM、MERGE、CSV和ARCHIVE表的相关文件,同时还会备份触发器和数据库配置信息相关的文件,这些文件会被保存到一个以时间命名的目录当中。在备份的同时,innobackupex还会在备份目录中创建如下文件:

- xtrabackup_checkpoints -- backup_type(备份类型(如完全(full-backuped)或增量))、备份状态(如是否已经为prepared状态)和LSN(备份的起始、终止LSN号,日志序列号)范围信息:

每个InnoDB页(通常为16k大小)都会包含一个日志序列号,即LSN,LSN是整个数据库系统的系统版本号,每个页面相关的LSN能够表明此页面最近是如何发生改变的。

-

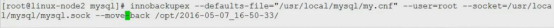

xtrabackup_binlog_info -- mysql服务器当前正在使用的二进制日志文件及备份这一刻位置二进制日志时间的位置。

-

xtrabackup_binlog_pos_innodb -- 二进制日志文件及用于InnoDB或XtraDB表的二进制日志文件的当前position。

-

xtrabackup_binary -- 备份中用到的xtrabackup的可执行文件;

-

backup-my.cnf -- 备份命令用到的配置选项信息。backup-my.cnf是拷贝过来的配置文件。里面只包含[mysqld]配置片段和备份有关的选项

-

xtrabackup_info -- 备份用到命令及相关配置选项信息。备份过程中的一些信息

-

xtrabackup_logfile -- 是复制和监控后写的redo日志。该日志是备份后下一个操作

准备的关键。只有通过它才能实现数据一致性

使用一个最小权限的用户进行备份

如果要使用一个最小权限的用户进行备份,则可基于如下命令创建此类用户:如果要使用一个最小权限的用户进行备份,则可基于如下命令创建此类用户:

mysql> CREATE USER 'bkpuser'@'localhost' IDENTIFIED BY '123456'; #创建用户

mysql> REVOKE ALL PRIVILEGES,GRANT OPTION FROM 'bkpuser'; #回收此用户所有权限

mysql> GRANT PROCESS,RELOAD,LOCK TABLES,RELICATION CLIENT ON *.* TO 'bkpuser'@'localhost'; #授权查看所有用户线程/连接的权限、刷新、锁定表、用户查看服务器状态

mysql> FLUSH PRIVILEGES; #刷新授权表

注意:备份时需启动MySQL,恢复时需关闭MySQL,清空mysql数据目录且不能重新初始化,恢复数据后应该立即进行一次完全备份

xtrabackup全量备份与恢复详解

备份:

不压缩:

innobackupex --defaults-file=/etc/my.cnf --user=DBUSER --password=DBUSERPASS --parallel=4 /path/to/BACKUP-DIR/

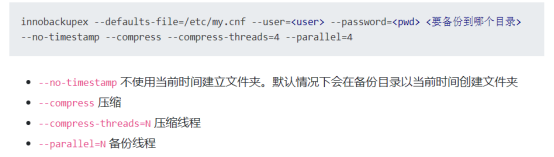

压缩:

innobackupex --defaults-file=/etc/my.cnf --user=DBUSER --password=DBUSERPASS --compress --compress-threads=4 --parallel=4 /path/to/BACKUP-DIR/

不使用当前时间创建目录:

- --no-timestamp

如果使用了压缩功能,某些备份的文件是以qp结尾的文件且是加密的。恢复时需要解压(解压需要安装qpress工具),否则备份的数据无法导入

恢复:(全备恢复数据时,数据库目录必须为空目录才能进行恢复成功)

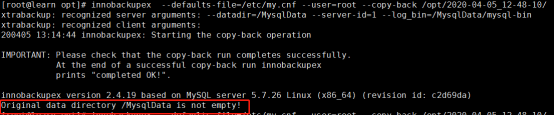

恢复的阶段就是向MySQL的datadir拷贝。全备份的恢复要求MySQL必须处于stop状态,并且datadir必须为空哪怕是和MySQL无关的文件也不能存在,它不会去覆盖datadir中已存在的内容。否则会提示如下错误:

innobackupex version 2.4.6 based on MySQL server 5.7.13 Linux (x86_64) (revision id: 8ec05b7)

Original data directory /mydata/data is not empty!

innobackupex --decompress ./2020-07-10_11-14-39/ --parallel=4

innobackupex --apply-log /backups/2018-07-30_11-04-55/

innobackupex --defaults-file=/etc/my.cnf --datadir=/MysqlData/ --copy-back /backups/2018-07-30_11-04-55/

(1)准备(prepare)一个完全备份

一般情况下,在备份完成后,数据尚且不能用于恢复操作,因为备份的数据中可能会包含尚未提交的事务或者已经提交但尚未同步至数据文件中的事务。因此,此时数据文件仍处于不一致状态。准备的主要作用正是通过回滚未提交的事务及同步已经提交的事务至数据文件也使用得数据文件处于一致性状态。

innobackupex命令的--apply-log选项可用于实现上述功能,如下面的命令:

innobackupex --apply-log /path/to/BACKUP-DIR # 如果执行正确,其最后输出的几行信息通常如下:

120407 09:01:04 innobackupex: completed OK!

在实现准备的过程中,innobackupex通常还可以使用--user-memory选项来指定其可以使用的内存的大小,默认为100M.如果有足够的内存空间可用,可以多划分一些内存给prepare的过程,以提高其完成备份的速度。

(2)从一个完全备份中恢复数据

注意:恢复不用启动MySQL

innobackupex命令的--copy-back选项用于恢复操作,其通过复制所有数据相关的文件至mysql服务器DATADIR目录中来执行恢复过程。innobackupex通过backup-my.cnf来获取DATADIR目录的相关信息。

# innobackupex --copy-back /path/to/BACKUP-DIR

当数据恢复至DATADIR目录以后,还需要确保所有的数据文件的属主和属组均为正确的用户,如mysql,否则,在启动mysqld之前还需要事先修改数据文件的属主和属组。如:

# chown -R mysql.mysql /mydata/data/

xtrabackup全量备份及恢复

(1)全量备份

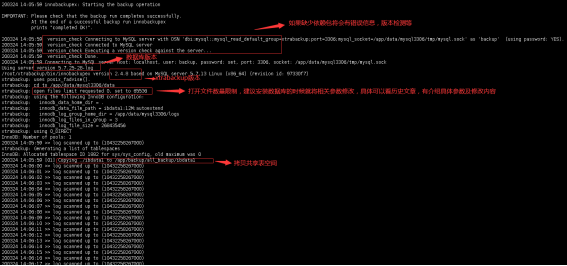

[root@learn ~]# innobackupex --user=root --password=666666 --host=127.0.0.1 /backups/

#在master上进行全库备份#语法解释说明:

#--user=root 指定备份用户

#--password=666666 指定备份用户密码

#--host 指定主机

#/backups 指定备份目录,没有该目录,会自动创建

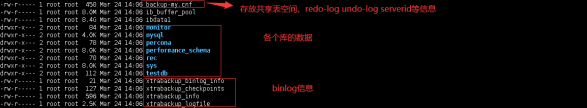

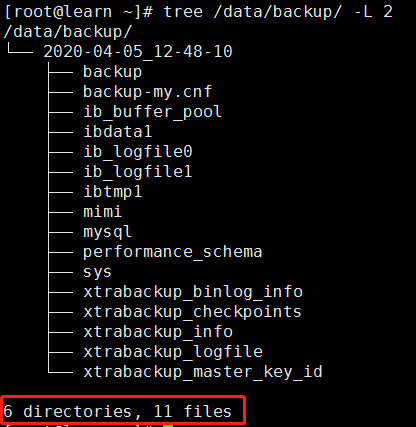

[root@learn ~]# tree /backups/ -L 2 #查看备份数据

/backups/

└── 2020-04-05_21-10-38

├── backup

├── backup-my.cnf #备份用到的配置选项信息文件

├── ib_buffer_pool

├── ibdata1 #数据文件

├── mimi

├── mysql

├── performance_schema

├── sys

├── xtrabackup_binlog_info #mysql服务器当前正在使用的二进制日志文件和此时二进制日志时间的位置信息文件

├── xtrabackup_checkpoints #备份的类型、状态和LSN状态信息文件

├── xtrabackup_info

└── xtrabackup_logfile #备份的日志文件

6 directories, 7 files

备份的结果存放在指定的目录里,内容如下:

注: 如果没有添加阻塞DDL操作的参数,备份过程中如有DDL操作,备份将终止。因此建议日常备份放在从库中进行

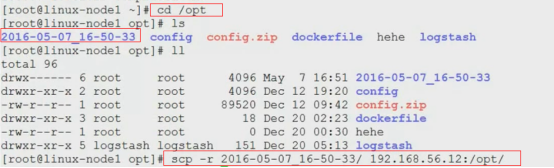

(2)基于全量备份的恢复

恢复的阶段就是向MySQL的datadir拷贝。全备份的恢复要求MySQL必须处于stop状态,并且datadir必须为空哪怕是和MySQL无关的文件也不能存在,它不会去覆盖datadir中已存在的内容。否则会提示如下错误:

innobackupex version 2.4.6 based on MySQL server 5.7.13 Linux (x86_64) (revision id: 8ec05b7)

Original data directory /mydata/data is not empty!

[root@learn ~]# /etc/init.d/mysql stop #停止slave上的mysql

Shutting down MySQL.. [ OK ]

#安装xtrabackup

[root@master tools]# wget https://www.percona.com/downloads/XtraBackup/Percona-XtraBackup-2.4.9/binary/redhat/7/x86_64/percona-xtrabackup-24-2.4.9-1.el7.x86_64.rpm

[root@master tools]# yum install -y percona-xtrabackup-24-2.4.9-1.el7.x86_64.rpm

[root@master ~]# rpm -qa |grep xtrabackup

percona-xtrabackup-24-2.4.9-1.el7.x86_64

#从master上拷贝备份数据

[root@learn ~]# cd /backups/

[root@learn backups]# ls

2020-04-05_21-10-38

[root@learn backups]# scp -r 2020-04-05_21-10-38/ root@172.17.135.42:/opt/

#合并数据,使数据文件处于一致性的状态

[root@learn backups]# innobackupex --apply-log --redo-only /opt/2020-04-05_21-10-38/

#在这个准备阶段,有一个内存使用量选项"--use-memory",该选项默认值为100M,值越大准备的过程越快。当然,将该值加大的前提是服务器内存够用

#在slave上删除原有的数据

[root@learn ~]# rm -rf /MysqlData/*

#配置my.cnf的数据目录路径,否则会报错,要和master一致

[root@learn ~]# grep "datadir" /etc/my.cnf

datadir=/MysqlData

#在slave上数据恢复

[root@learn ~]# innobackupex --copy-back /opt/2020-04-05_21-10-38/

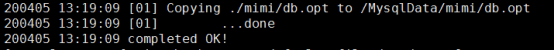

…………

200405 21:33:39 completed OK! #看到completed OK就是恢复正常了

#slave上查看数据目录,可以看到数据已经恢复,但是属主会有问题,需要进行修改,所以一般使用mysql的运行用户进行恢复,否则需要进行修改属主和属组信息

[root@learn ~]# ll /MysqlData

total 122920

drwxr-x--- 2 root root 4096 Apr 5 21:33 backup

-rw-r----- 1 root root 422 Apr 5 21:33 ib_buffer_pool

-rw-r----- 1 root root 12582912 Apr 5 21:33 ibdata1

-rw-r----- 1 root root 50331648 Apr 5 21:33 ib_logfile0

-rw-r----- 1 root root 50331648 Apr 5 21:33 ib_logfile1

-rw-r----- 1 root root 12582912 Apr 5 21:33 ibtmp1

drwxr-x--- 2 root root 4096 Apr 5 21:33 mimi

drwxr-x--- 2 root root 4096 Apr 5 21:33 mysql

drwxr-x--- 2 root root 4096 Apr 5 21:33 performance_schema

drwxr-x--- 2 root root 12288 Apr 5 21:33 sys

-rw-r----- 1 root root 484 Apr 5 21:33 xtrabackup_info

-rw-r----- 1 root root 1 Apr 5 21:33 xtrabackup_master_key_id

#修改属主属组

[root@learn ~]# chown -R mysql.mysql /MysqlData

#启动mysql

[root@learn ~]# /etc/init.d/mysql start

Starting MySQL.Logging to '/MysqlData/mysql-error.log'.

. [ OK ]

#查看数据,是否恢复

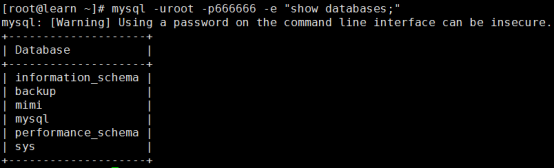

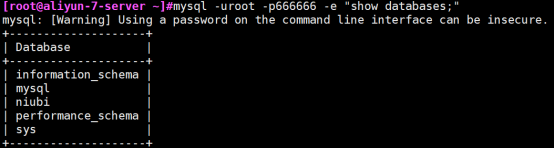

[root@learn ~]# mysql -uroot -p666666 -e "show databases;"

mysql: [Warning] Using a password on the command line interface can be insecure.

+--------------------+

| Database |

+--------------------+

| information_schema |

| backup |

| mimi |

| mysql |

| performance_schema |

| sys |

+--------------------+

总结全库备份与恢复三步曲:

a. innobackupex全量备份,并指定备份目录路径;

b. 在恢复前,需要使用--apply-log参数先进行合并数据文件,确保数据的一致性要求;

c. 恢复时,直接使用--copy-back参数进行恢复,需要注意的是,在my.cnf中要指定数据文件目录的路径

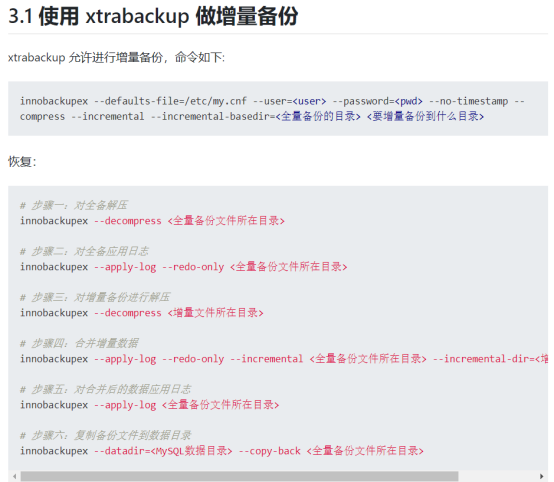

xtrabackup基于第一次全备后再增量备份与恢复

步骤四:

增量备份:

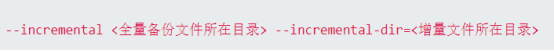

innobackupex --defaults-file=/etc/my.cnf --user=<user> --password=<pwd> --no-timestamp -compress --incremental --incremental-basedir=<全量备份的目录> <要增量备份到什么目录>

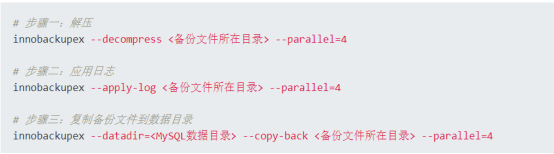

#步骤一:对全备解压

innobackupex --decompress <全量备份文件所在目录>

#步骤二:对全备应用日志

innobackupex --apply-log --redo-only <全量备份文件所在目录>

#步骤三:对增量备的进行解压

innobackupex --decompress <增量文件所在目录>

#步骤四:合并增量数据

innobackupex --apply-log --redo-only --incremental <全量备份文件所在目录> --incremental-dir=<增量文件所在目录>

#步骤五:对合并后的数据应用日志

innobackupex --apply-log <全量备份文件所在目录>

#步骤六:复制备份文件到数据目录

innobackupex --datadir=<MysQL数据目录> --copy-back <全量备份文件所在目录>

使用innobackupex进行增量备份,每个InnoDB的页面都会包含一个LSN信息,每当相关的数据发生改变,相关的页面的LSN就会自动增长。这正是InnoDB表可以进行增量备份的基础,即innobackupex通过备份上次完全备份之后发生改变的页面来实现。在进行增量备份时,首先要进行一次全量备份,第一次增量备份是基于全备的,之后的增量备份都是基于上一次的增量备份的,以此类推

要实现第一次增量备份,可以使用下面的命令进行:

基于全量备份的增量备份与恢复

做一次增量备份(基于当前最新的全量备份)

innobackupex --user=root --password=root --defaults-file=/etc/my.cnf --incremental /backups/ --incremental-basedir=/backups/2018-07-30_11-01-37

- 准备基于全量

innobackupex --user=root --password=root --defaults-file=/etc/my.cnf --apply-log --redo-only /backups/2018-07-30_11-01-37

- 准备基于增量

innobackupex --user=root --password=root --defaults-file=/etc/my.cnf --apply-log --redo-only /backups/2018-07-30_11-01-37 --incremental-dir=/backups/2018-07-30_13-51-47/

- 恢复

innobackupex --copy-back --defaults-file=/etc/my.cnf /opt/2017-01-05_11-04-55/

解释:

- 2018-07-30_11-01-37指的是完全备份所在的目录。

- 2018-07-30_13-51-47指定是第一次基于2018-07-30_11-01-37增量备份的目录,其他时有多次增量备份。每一次都要执行如上操作

需要注意的是:增量备份仅能应用于InnoDB或XtraDB表,对于MyISAM表而言,执行增量备份时其实进行的是完全备份。

"准备"(prepare)增量备份与整理完全备份有着一些不同,尤其要注意的是:

①需要在每个备份 (包括完全和各个增量备份)上,将已经提交的事务进行"重放"。"重放"之后,所有的备份数据将合并到完全备份上。

②基于所有的备份将未提交的事务进行回滚

(1)增量备份演示-->增量备份依赖于全备份

增量备份依赖于全备份。xtrabackup实现增量备份的原理是通过比较全备份的终点LSN和当前的LSN,增备时将从终点LSN开始一直备份到当前的LSN。在备份时也有redo log的监控线程,对于增备过程中导致LSN增长的操作也会写入到日志中。

增备的实现依赖于LSN,所以只对innodb有效,对myisam表使用增备时,背后进行的是全备

#全备数据

[root@learn ~]# innobackupex --user=root --password=666666 --host=127.0.0.1 /backups/

[root@learn ~]# tree /backups/ -L 2

/backups/

└── 2020-04-05_22-01-43

├── backup

├── backup-my.cnf

├── ib_buffer_pool

├── ibdata1

├── mimi

├── mysql

├── performance_schema

├── sys

├── xtrabackup_binlog_info

├── xtrabackup_checkpoints

├── xtrabackup_info

└── xtrabackup_logfile

6 directories, 7 files

查看xtrabackup_checkpoints可以得知相关的LSN

注意:要实现增备,这一次的全备一定不能进行"准备"操作(--apply-log操作),原因稍后给出。

#在master上创建student库并创建testtb表插入若干数据

[root@learn ~]# mysql -uroot -p

Enter password:

Welcome to the MySQL monitor. Commands end with ; or \g.

Your MySQL connection id is 5

Server version: 5.7.28-log MySQL Community Server (GPL)

Copyright (c) 2000, 2019, Oracle and/or its affiliates. All rights reserved.

Oracle is a registered trademark of Oracle Corporation and/or its

affiliates. Other names may be trademarks of their respective

owners.

Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.

mysql> show databases;

+--------------------+

| Database |

+--------------------+

| information_schema |

| backup |

| mimi |

| mysql |

| performance_schema |

| sys |

+--------------------+

6 rows in set (0.00 sec)

mysql> create database student;

Query OK, 1 row affected (0.01 sec)

mysql> use student;

Database changed

mysql> create table testtb(id int);

Query OK, 0 rows affected (0.03 sec)

mysql> insert into testtb values(1),(10),(99);

Query OK, 3 rows affected (0.01 sec)

Records: 3 Duplicates: 0 Warnings: 0

mysql> select * from testtb;

+------+

| id |

+------+

| 1 |

| 10 |

| 99 |

+------+

3 rows in set (0.00 sec)

mysql> quit;

Bye

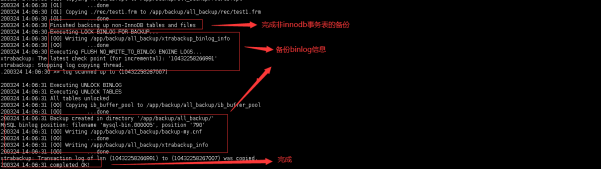

#使用innobackupex进行增量备份

[root@learn ~]# innobackupex --user=root --password=666666 --host=127.0.0.1 --incremental /backups/ --incremental-basedir=/backups/2020-04-05_22-01-43/

……………………

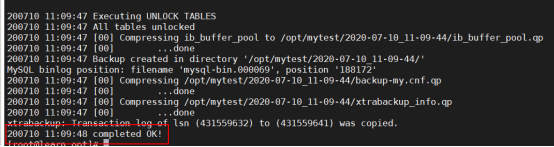

200405 22:09:25 Executing UNLOCK TABLES

200405 22:09:25 All tables unlocked

200405 22:09:25 [00] Copying ib_buffer_pool to /backups/2020-04-05_22-09-21/ib_buffer_pool

200405 22:09:25 [00] ...done

200405 22:09:25 Backup created in directory '/backups/2020-04-05_22-09-21/'

MySQL binlog position: filename 'mysql-bin.000001', position '767'

200405 22:09:25 [00] Writing /backups/2020-04-05_22-09-21/backup-my.cnf

200405 22:09:25 [00] ...done

200405 22:09:25 [00] Writing /backups/2020-04-05_22-09-21/xtrabackup_info

200405 22:09:25 [00] ...done

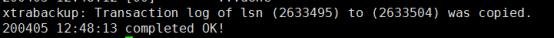

xtrabackup: Transaction log of lsn (2642063) to (2642072) was copied.

200405 22:09:25 completed OK!

[root@learn ~]# tree /backups/ -L 1

/backups/

├── 2020-04-05_22-01-43 #全备数据

└── 2020-04-05_22-09-21 #基于全备的第一次增量备份数据

2 directories, 0 files

#查看全量备份的xtrabackup_checkpoints

[root@learn ~]# cat /backups/2020-04-05_22-01-43/xtrabackup_checkpoints

backup_type = full-backuped #备份类型为全量备份

from_lsn = 0 #lsn从0开始

to_lsn = 2634299 #lsn到2634299结束

last_lsn = 2634308

compact = 0

recover_binlog_info = 0

flushed_lsn = 2634308

#查看增量备份的xtrabackup_checkpoints

[root@learn ~]# cat /backups/2020-04-05_22-09-21/xtrabackup_checkpoints

backup_type = incremental #备份类型为增量备份

from_lsn = 2634299 #lsn从2634299开始(与全备的结束位置一致的)

to_lsn = 2642069 #lsn到2642069结束

last_lsn = 2642072

compact = 0

recover_binlog_info = 0

flushed_lsn = 2642072

默认情况下,增备的起始LSN是自动获取的,但是在某些情况下无法获取,还有些情况下无法获取到将要增备的basedir。xtrabackup提供的选项--incremental-lsn=N可以显式指定增备的起始LSN,显式指定LSN时,可以无需提供增备的basedir。

例如,如果获取到了上次全备的终止LSN为7533367093,可以如下方式增备:

innobackupex --user=root --password=123456 --incremental /bakdir/ --incremental-lsn=7533367093

(2)增量备份后数据恢复演示

(1)模拟mysql故障,删除数据目录所有数据

#模拟mysql故障,停止mysql

[root@learn ~]# /etc/init.d/mysql stop

Shutting down MySQL.. [ OK ]

#模拟数据错误,删除数据目录中的所有数据

[root@learn ~]# rm -rf /MysqlData/*

(2)合并全备数据目录,确保数据的一致性

[root@learn ~]# innobackupex --apply-log --redo-only /backups/2020-04-05_22-01-43/

(3)将增量备份数据合并到全备数据目录当中

[root@learn ~]# innobackupex --apply-log --redo-only /backups/2020-04-05_22-01-43/ --incremental-dir=/backups/2020-04-05_22-09-21/

[root@learn ~]# cat /backups/2020-04-05_22-01-43/xtrabackup_checkpoints

backup_type = log-applied #查看到数据备份类型是增加

from_lsn = 0 #lsn从0开始

to_lsn = 2642063 #lsn结束号为最新的lsn

last_lsn = 2642072

compact = 0

recover_binlog_info = 0

flushed_lsn = 2642072

(4)对整合完成的全备集进行一次整体的准备

innobackupex --apply-log --redo-only /backups/2020-04-05_22-01-43/

(5)恢复数据

[root@learn ~]# innobackupex --copy-back /backups/2020-04-05_22-01-43/

再次查看数据目录就有数据了,但是权限未更改。

[root@learn ~]# ll /MysqlData

total 12336

drwxr-x--- 2 root root 4096 Apr 5 22:29 backup

-rw-r----- 1 root root 422 Apr 5 22:29 ib_buffer_pool

-rw-r----- 1 root root 12582912 Apr 5 22:29 ibdata1

drwxr-x--- 2 root root 4096 Apr 5 22:29 mimi

drwxr-x--- 2 root root 4096 Apr 5 22:29 mysql

drwxr-x--- 2 root root 4096 Apr 5 22:29 performance_schema

drwxr-x--- 2 root root 4096 Apr 5 22:29 student

drwxr-x--- 2 root root 12288 Apr 5 22:29 sys

-rw-r----- 1 root root 21 Apr 5 22:29 xtrabackup_binlog_pos_innodb

-rw-r----- 1 root root 556 Apr 5 22:29 xtrabackup_info

-rw-r----- 1 root root 1 Apr 5 22:29 xtrabackup_master_key_id

#更改数据的属主属组

[root@learn ~]# chown -R mysql.mysql /MysqlData

#启动mysql

[root@learn ~]# /etc/init.d/mysql start

Starting MySQL.Logging to '/MysqlData/mysql-error.log'.

.. [ OK ]

#查看数据是否恢复

[root@learn ~]# mysql -uroot -p -e "show databases;"

Enter password:

+--------------------+

| Database |

+--------------------+

| information_schema |

| backup |

| mimi |

| mysql |

| performance_schema |

| student |

| sys |

+--------------------+

从xtrabackup备份文件中恢复单表

https://www.cnblogs.com/f-ck-need-u/p/9018716.html#auto_id_10

https://www.cnblogs.com/xuanzhi201111/p/6609867.html

目前对MySQL比较流行的备份方式有两种,一种上是使用自带的mysqldump,另一种是xtrabackup,对于数据时大的环境,普遍使用了xtrabackup+binlog进行全量或者增量备份, 那么如何快速的从xtrabackup备份中恢复单张表呢?从mysql 5.6版本开始,支持可移动表空间(Transportable Tablespace),利用这个功能也可以实现单表的恢复,下面进行从备份中恢复单张innodb表进行演练

默认情况下,InnoDB表不能通过直接复制表文件的方式在mysql服务器之间进行移植,即便使用了innodb_file_per_table选项。而使用Xtrabackup工具可以实现此种功能,不过只能"导出"具有.ibd文件的表,也就是说导出表的mysql服务器启用了innodb_file_per_table选项,而且要导出的表还是在启用该选项之后才创建的。

导入表的是,要求导入表的服务器版本是MySQL 5.6+,且启用了innodb_file_per_table选项

安装工具

-

针对InnoDB表恢复

-

开启了参数:

innodb_file_per_table -

安装工具:mysql-utilities,其中mysqlfrm可以读取表结构

进行mysql-utilities安装:使用mysqlfrm从备份中读取表结构(或者在未丢失的情况下备份表结构,而且建议用这种方式。而不是用mysqlfrm 工具查看):

yum install mysql-utilities -y

# mysqlfrm --server=root:'Oez@L*K1&'@172.31.18.51:3306 ./local_full/2021-01-09_19-07-26/test/test.frm --diagnostic

# mysqlfrm --diagnostic local_full/2021-01-09_19-07-26/test/test.frm

2、mysqlfrm相关参数介绍

- --server : 远程连接到mysql,如--server=user:password@192.168.1.10:3306

- --diagnostic : 开启按字节模式来恢复frm结构

-

--user :启动MySQL用户,通常为mysql

-

--port :启动MySQL端口,通常为3306

- --basedir :如 --basedir=/usr/local/mysql

注意: 使用--basedir恢复出来的varchar竟然是--server模式的3倍;这应该是mysqlfrm在使用basedir模式时,无法进行字符编码校验所致引起的。

再次看了下--server的文件:(重点看标红加粗的文字),建议:能用--server模式时,尽量使用--server同时保证提供mysqld环境与原生产环境的一致。

--server=server

Connection information for a server. Use this option or --basedir for the default mode. If provided with the diagnostic mode, the storage engine and character set information are validated against this server.

(1). 导出表

导出表是在准备的过程中进行的,不是在备份的时候导出。对于一个已经备份好的备份集,使用"--apply-log"和"--export"选项即可导出备份集中的表。

假如以全备份集local_full/2021-01-09_19-07-26/为例,要导出其中的表。

在导出其中的表之前需要预处理

# innobackupex --apply-log --redo-only local_full/2021-01-09_19-07-26/

然后在导出

# innobackupex --apply-log --export local_full/2021-01-09_19-07-26/

在导出过程中,会看到如下关键信息:

xtrabackup: export metadata of table 'test/test' to file `./test/test.exp` (1 indexes)

xtrabackup: name=GEN_CLUST_INDEX, id.low=11782, page=3

它说明了创建了一个.exp文件。

查看备份集目录下的local_full/2021-01-09_19-07-26/test/目录,会发现多出了2个文件:.cfg和.exp,再加上.ibd文件,这3个文件是后续导入表时所需的文件

# ll local_full/2021-01-09_19-07-26/test/

total 132

-rw-r----- 1 root root 60 Jan 9 20:19 db.opt

-rw-r--r-- 1 root root 2755 Jan 9 20:22 test.cfg

-rw-r----- 1 root root 16384 Jan 9 20:22 test.exp

-rw-r----- 1 root root 11088 Jan 9 20:19 test.frm

-rw-r----- 1 root root 98304 Jan 9 20:19 test.ibd

(2). 导入表

要在mysql服务器上导入来自于其它服务器的某innodb表,需要先在当前服务器上创建一个跟原表表结构一致的表,而后才能实现将表导入:

利用 mysqlfrm工具查看表结构,或者在之前就备份表结构

# mysqlfrm --server=root:'Oez@L*K1&'@172.31.18.51:3306 ./local_full/2021-01-09_19-07-26/test/test.frm --diagnostic

根据上面的结构创建表结构

mysql> CREATE TABLE `test`.`test` ( `id` bigint(20) NOT NULL,……) ENGINE=InnoDB;

然后将此表的表空间删除(删除了就无法查看这个表的内容了,表空间就是这个特征):

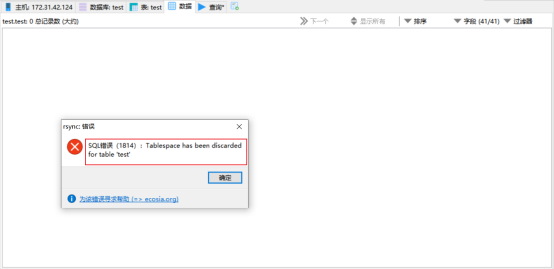

mysql> ALTER TABLE `test`.`test` DISCARD TABLESPACE;

接下来,将来自于"导出"表的的.ibd和.exp文件复制到当前服务器的数据目录(新数据库的数据目录这里是/MysqlData/test/),然后修改文件的权限。

cp local_full/2021-01-09_19-07-26/test/test.exp /MysqlData/test/

cp local_full/2021-01-09_19-07-26/test/test.ibd /MysqlData/test/

chown mysql.mysql /MysqlData/test/test.exp

chown mysql.mysql /MysqlData/test/test.ibd

如果导入目标服务器是MySQL 5.6+,也可以复制.cfg文件。然后使用如下命令将其"导":

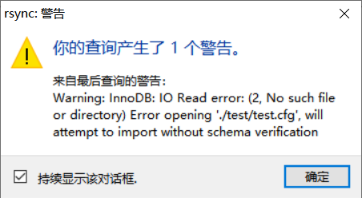

mysql> ALTER TABLE test.test IMPORT TABLESPACE;

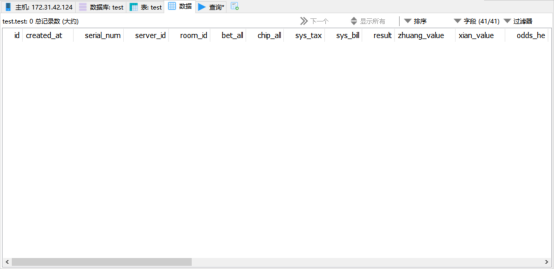

有报一个warning,但不影响恢复,详情可以看:https://yq.aliyun.com/articles/59271,我们查一下数据:

test表已经成功恢复

innobackupex实现部分备份和恢复的过程(Creating Partial Backups)

https://www.cnblogs.com/f-ck-need-u/p/9018716.html#auto_id_11

https://blog.csdn.net/zhu19774279/article/details/49681767

https://www.cnblogs.com/allenhu320/p/11311056.html

注意:部分备份(--include、--tables-file、--database)需要开启 innodb_file_per_table

xtrabackup支持部分备份,意味着可以指定备份哪个数据库或者哪个表。

部分备份只有一点需要注意:在恢复的时候不要通过"--copy-back"的方式拷贝回datadir,而是应该使用导入表的方式。尽管使用拷贝的方式有时候是可行的,但是很多情况下会出现数据库不一致的状态。

(1). 备份

部分备份共有三种方式,分别是:

- 用正则表达式表示要备份的库名及表名(参数为--include),这种方式要使用完整对象引用格式,即db_name.tab_name的方式

- 将要备份的表分行枚举到一个文件中,通过"--tables-file"指定该文件(参数为--tables-file)

- 或者使用"--databases"指定要备份的数据库或表,指定备份的表时要使用完整对象引用格式,多个元素使用空格分开(参数为:--databases)。

使用前两种部分备份方式,只能备份innodb表,不会备份任何myisam,即使指定了也不会备份。而且要备份的表必须有独立的表空间文件,也就是说必须开启了innodb_file_per_table,更精确的说,要备份的表是在开启了innodb_file_per_table选项之后才创建的。第三种备份方式可以备份myisam表

(译者注:不管你备份哪个库或是哪张表,强烈推荐把mysql库也一起备份,恢复的时候要用。)

这就是没有备份mysql库,会报错找不到该库

方式一:使用--include参数

使用正则模式匹配备份部分库表,需要使用参数--include

innobackupex --include='^back.*[.]num_*' /backupdir --user=root --password=msds007

将备份back字母开头的数据库中num开头的表,其中[.]的中括号不能少,因为正则中.有特殊意义,所以使用中括号来枚举以实现对象的完整引用。

方式二:使用表列表备份部分表,需要使用参数--tables-file,语句类似如下:

cat /tmp/tables.txt

test.t

test.testflashback2

innobackupex --tables-file=/tmp/tables.txt /backup --user=root --password=msds007

使用--include和--tables-file备份后,会生成一个时间戳目录,目录中只有和要备份的表有关的文件

如果使用的是--databases选项,则会生成一个时间戳目录,里面有备份的数据库代表的目录,如果只备份了某个表,则该数据库目录中只有该表相关的文件

方式三:使用--databases参数

innobackupex --user=root --password='123654$' --databases='mysql.user test' ./bakdir

上面只备份mysql.user表和test数据库,在生成的时间戳目录中将有两个mysql目录和test目录

# tree bakdir/

bakdir/

└── 2021-01-11_14-24-48

├── backup-my.cnf

├── ib_buffer_pool

├── ibdata1

├── mysql

│ ├── user.frm

│ ├── user.MYD

│ └── user.MYI

├── test

│ ├── db.opt

│ ├── test.frm

│ └── test.ibd

├── xtrabackup_binlog_info

├── xtrabackup_checkpoints

├── xtrabackup_info

└── xtrabackup_logfile

3 directories, 13 files

(2). 部分备份的准备和恢复过程

部分备份的准备和恢复过程分别是导出表和导入表的过程。见上文

准备部分备份(Preparing Partial Backups)

执行preparing partial backups,与恢复独立的表(Restoring Individual Tables)很类似:使用--apply-log和--export参数,并包含上一步生成的时间戳文件夹

innobackupex --apply-log --export bakdir/2021-01-11_14-24-48/

流备份和备份到远程

https://www.cnblogs.com/f-ck-need-u/p/9018716.html#auto_id_13

xtrabackup支持备份流,当前可用的流类型只有tar和xtrabackup自带的xbstream,通过流可以将它们传递给其他程序进行相关的操作,如压缩。但是不建议在备份的同时进行压缩,因为压缩会占用极大的cpu资源,使得备份时间延长很多,温备的过程也就延长了。

另外,MySQL的数据文件压缩比非常大,所以建议备份后在空闲的时候进行压缩。

xtrabackup还支持备份到远程,只需使用--remote-host指定远程的主机名即可,指定方式和ssh指定的方式一样。如--remote-host=root@192.168.100.18

使用流备份的方法如下:

#使用tar流

innobackupex --user=root --password=123456 --stream=tar /bakdir/ >/tmp/a.tar

# 使用tar流的同时交给gzip压缩

innobackupex --user=root --password=123456 --stream=tar /bakdir/ | gzip >/tmp/a.tar.gz

# 使用tar流备份到远程主机中并归档

innobackupex --user=root --password=123456 --stream=tar /bakdir/ | ssh root@192.168.100.10 "cat - > /tmp/`date +%F_%H-%M-%S`.tar"

# 使用tar流备份到原远程主机中并解包

innobackupex --user=root --password=123456 --stream=tar /bakdir/ | ssh root@192.168.100.10 "cat - | tar -x -C /tmp/"

# 使用xtrabackup自带的xbstream流

innobackupex --user=root --password=123456 --stream=xbstream /bakdir/ >/tmp/b.xbs

# 解压xbstream流

innobackupex --user=root --password=123456 --stream=xbstream /bakdir/ | ssh root@192.168.100.10 "cat - | xbstream -x -C /tmp/"

# 使用xbstream流的同时进行压缩,使用"--compress"选项

innobackupex --user=root --password=123456 --stream=xbstream --compress /bakdir/ > /bakdir/backup.xbs

注意:如果在解压备份的.tar.gz时出错,可能在解压的时候需要使用-i选项。如

tar -xif /tmp/b.tar/gz

加速备份

https://www.cnblogs.com/f-ck-need-u/p/9018716.html#auto_id_14

当备份到本地的时候,可以使用--rsync选项,该选项用于在flush tables with read lock后调用rsync替代cp进程复制非Innodb数据和.frm文件,加快复制速度。

但要注意,因为支持备份锁的版本在获取到backup locks的时候会自动复制非Innodb数据和.frm文件,所以--rsync选项是无效的。

另外,该选项不能和--stream选项和--remote-host选项同时使用

脚本

https://www.cnblogs.com/FireLL/p/13042287.html

总结:

(1)增量备份需要使用参数--incremental指定需要备份到哪个目录,使用incremental-basedir指定全备目录;

(2)进行数据备份时,需要使用参数--apply-log redo-only先合并全备数据目录数据,确保全备数据目录数据的一致性;

(3)再将增量备份数据使用参数--incremental-dir合并到全备数据当中;

(4)最后通过最后的全备数据进行恢复数据,注意,如果有多个增量备份,需要逐一合并到全备数据当中,再进行恢复

#1. --user=root 指定备份的用户

#2. --password=root指定备份用户的密码

#3. --defaults-file=/etc/my.cnf 指定的备份数据的配置文件

#4. /opt/ 指定备份后的数据保存路径

关于阿里云RDS物理备份数据使用xtrabackup工具恢复到本地mysql当中,请参考阿里云文档:https://help.aliyun.com/knowledge_detail/41817.html?spm=5176.11065259.1996646101.searchclickresult.53d420cclqekK3

Xtrabackup完全备份+两次增量备份

博客参考:https://blog.51cto.com/bigboss/2095153

https://blog.csdn.net/qq_36183569/article/details/83024114

环境:

CentOS Linux release 7.7.1908 (Core)

mysql Ver 14.14 Distrib 5.7.28, for linux-glibc2.12 (x86_64) using EditLine wrapper

EPEL源

Xtrabackup-24工具包

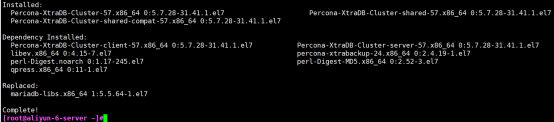

一、两台主机分别安装Xtrabackup

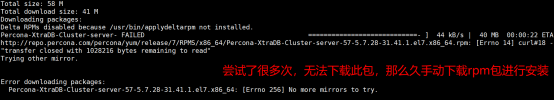

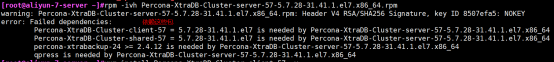

wget https://www.percona.com/downloads/XtraBackup/Percona-XtraBackup-2.4.9/binary/redhat/7/x86_64/percona-xtrabackup-24-2.4.9-1.el7.x86_64.rpm

yum install percona-xtrabackup-24-2.4.9-1.el7.x86_64.rpm -y

# Xtrabackup包依赖于epel源一些工具包,所以使用yum安装。

二、完全备份数据库

当前数据库状态:

[root@learn ~]# mysql -uroot -p666666 -e "show databases;"

mysql: [Warning] Using a password on the command line interface can be insecure.

+--------------------+

| Database |

+--------------------+

| information_schema |

| backup |

| mimi |

| mysql |

| performance_schema |

| student |

| sys |

+--------------------+

完全备份数据库:

[root@learn ~]# innobackupex --defaults-file=/etc/my.cnf --user=root --password=666666 /backup/

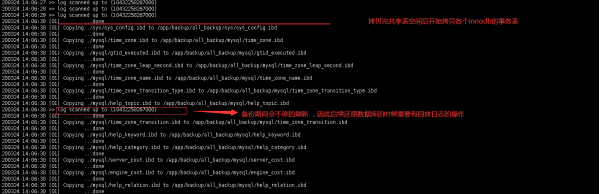

出现completed OK!表示备份完成

备份的数据:

[root@learn ~]# tree /backup -L 2

/backup

└── 2020-04-05_22-57-56

├── backup

├── backup-my.cnf

├── ib_buffer_pool

├── ibdata1

├── mimi

├── mysql

├── performance_schema

├── student

├── sys

├── xtrabackup_binlog_info

├── xtrabackup_checkpoints

├── xtrabackup_info

└── xtrabackup_logfile

7 directories, 7 files

三、修改数据,并执行第一次增量备份

mysql> create database 1st;

[root@learn ~]# mysql -uroot -p666666 -e "create database 1st"

mysql: [Warning] Using a password on the command line interface can be insecure.

修改后的数据:

[root@learn ~]# mysql -uroot -p666666 -e "show databases;"

mysql: [Warning] Using a password on the command line interface can be insecure.

+--------------------+

| Database |

+--------------------+

| information_schema |

| 1st |

| backup |

| mimi |

| mysql |

| performance_schema |

| student |

| sys |

+--------------------+

进行增量备份:

[root@learn ~]# mkdir /backup/up1

[root@learn ~]# innobackupex --defaults-file=/etc/my.cnf --user=root --password=666666 --incremental /backup/up1 --incremental-basedir=/backup/2020-04-05_22-57-56/

第一次增量备份的数据:

[root@learn ~]# tree /backup/up1/ -L 2

/backup/up1/

└── 2020-04-05_23-02-41

├── 1st

├── backup

├── backup-my.cnf

├── ib_buffer_pool

├── ibdata1.delta

├── ibdata1.meta

├── mimi

├── mysql

├── performance_schema

├── student

├── sys

├── xtrabackup_binlog_info

├── xtrabackup_checkpoints

├── xtrabackup_info

└── xtrabackup_logfile

8 directories, 8 files

四、再次修改数据,进行第二次增量备份

[root@learn ~]# mysql -uroot -p666666 -e "create database 2st;"

[root@learn ~]# mysql -uroot -p666666 -e "create database Xtrabackup_test;"

修改后的数据:

[root@learn ~]# mysql -uroot -p666666 -e "show databases;"

mysql: [Warning] Using a password on the command line interface can be insecure.

+--------------------+

| Database |

+--------------------+

| information_schema |

| 1st |

| 2st |

| Xtrabackup_test |

| backup |

| mimi |

| mysql |

| performance_schema |

| student |

| sys |

+--------------------+

进行第二次增量备份:

[root@learn ~]# innobackupex --defaults-file=/etc/my.cnf --user=root --password=666666 --incremental --incremental-basedir=/backup/up1/2020-04-05_23-02-41/ /backup/up2/

三次备份后的数据:

[root@learn ~]# tree /backup -L 2